Вештачка интелигенција

Проблемот на црната кутија во LLMs: Предизвици и нови решенија

Машинското учење, подмножество на вештачката интелигенција, вклучува три компоненти: алгоритми, податоци за обука и добиен модел. Алгоритам, во суштина збир на процедури, учи да идентификува шеми од голем сет на примери (податоци за обука). Кулминација на оваа обука е модел за машинско учење. На пример, алгоритам трениран со слики од кучиња ќе резултира со модел способен да идентификува кучиња во слики.

Црна кутија во машинското учење

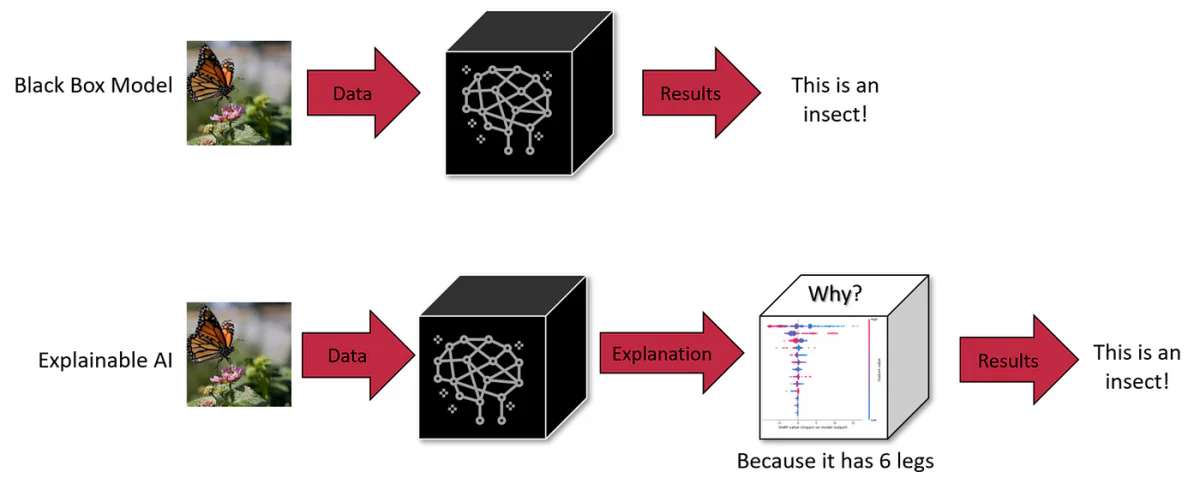

Во машинското учење, која било од трите компоненти - алгоритам, податоци за обука или модел - може да биде црна кутија. Додека алгоритмите честопати се јавно познати, програмерите може да изберат да го задржат моделот или податоците за обуката тајни за да ја заштитат интелектуалната сопственост. Оваа нејасност го прави предизвик да се разбере процесот на донесување одлуки на вештачката интелигенција.

Црните кутии со вештачка интелигенција се системи чии внатрешни работи остануваат непроѕирни или невидливи за корисниците. Корисниците можат да внесуваат податоци и да примаат излез, но логиката или кодот што го произведува излезот останува скриен. Ова е вообичаена карактеристика во многу системи за вештачка интелигенција, вклучително и напредни генеративни модели како ChatGPT и DALL-E 3.

LLM како што е GPT-4 претставуваат значителен предизвик: нивната внатрешна работа е во голема мера непроѕирна, што ги прави „црни кутии“. Таквата непроѕирност не е само техничка загатка; тоа претставува реалниот свет безбедност и етички грижи. На пример, ако не можеме да забележиме како овие системи доаѓаат до заклучоци, дали можеме да им веруваме во критичните области како медицинските дијагнози или финансиските проценки?

Скалата и сложеноста на LLMs

Обемот на овие модели ја зголемува нивната сложеност. Земете го GPT-3, на пример, со неговите 175 милијарди параметри и поновите модели со трилиони. Секој параметар е во интеракција на сложени начини во невронската мрежа, придонесувајќи за појавни способности кои не се предвидливи само со испитување на поединечни компоненти. Оваа скала и сложеност го прават речиси невозможно целосно да се сфати нивната внатрешна логика, што претставува пречка во дијагностицирањето на предрасудите или несаканите однесувања кај овие модели.

Размена: Скала наспроти интерпретабилност

Намалувањето на обемот на LLM може да ја подобри интерпретабилноста, но по цена на нивните напредни способности. Скалата е она што овозможува однесувања што помалите модели не можат да ги постигнат. Ова претставува вродена размена помеѓу обемот, способноста и интерпретабилноста.

Влијание на проблемот со црната кутија на LLM

1. Неправилно донесување одлуки

Непроѕирноста во процесот на донесување одлуки на LLM како GPT-3 или BERT може да доведе до неоткриени предрасуди и грешки. Во областите како што се здравството или кривичната правда, каде што одлуките имаат далекусежни последици, неможноста за ревизија на LLM за етичка и логична исправност е голема грижа. На пример, медицинската дијагноза LLM која се потпира на застарени или пристрасни податоци може да даде штетни препораки. Слично на тоа, LLM во процесите на вработување може ненамерно да ги овековечат родовите двојки. Така, природата на црната кутија не само што ги прикрива недостатоците, туку може потенцијално да ги засили, што бара проактивен пристап за подобрување на транспарентноста.

2. Ограничена приспособливост во различни контексти

Недостатокот на увид во внатрешното функционирање на LLM ја ограничува нивната приспособливост. На пример, вработувањето LLM може да биде неефикасно во оценувањето на кандидатите за улога што ги цени практичните вештини над академските квалификации, поради неговата неможност да ги прилагоди своите критериуми за оценување. Слично на тоа, медицинскиот LLM може да се бори со дијагнози на ретки болести поради нерамнотежа на податоците. Оваа нефлексибилност ја нагласува потребата за транспарентност за повторно калибрирање на LLM за специфични задачи и контексти.

3. Пристрасност и празнини во знаењето

Обработката на огромните податоци за обука од страна на LLM е предмет на ограничувањата наметнати од нивните алгоритми и архитектури на модели. На пример, медицинскиот LLM може да покаже демографски предрасуди ако е обучен за неурамнотежени сетови на податоци. Исто така, владеењето на LLM во нишаните теми може да биде погрешно, што доведува до прекумерно самоуверени, неточни резултати. Решавањето на овие предрасуди и празнини во знаењето бара повеќе од само дополнителни податоци; бара испитување на механиката за обработка на моделот.

4. Правна и етичка одговорност

Нејасната природа на LLM создава правна сива зона во врска со одговорноста за каква било штета предизвикана од нивните одлуки. Ако LLM во медицински амбиент дава погрешни совети што доведуваат до оштетување на пациентот, утврдувањето на одговорност станува тешко поради непроѕирноста на моделот. Оваа правна несигурност носи ризици за субјектите кои распоредуваат LLM во чувствителни области, нагласувајќи ја потребата за јасно управување и транспарентност.

5. Проблеми со доверба во чувствителни апликации

За LLM кои се користат во критични области како што се здравството и финансиите, недостатокот на транспарентност ја поткопува нивната доверливост. Корисниците и регулаторите треба да се погрижат овие модели да не содржат предрасуди или да не носат одлуки врз основа на нефер критериуми. Потврдувањето на отсуството на пристрасност кај LLM бара разбирање на нивните процеси на донесување одлуки, нагласувајќи ја важноста на објаснувањето за етичко распоредување.

6. Ризици со лични податоци

LLM бараат обемни податоци за обука, кои може да вклучуваат чувствителни лични информации. Природата на црната кутија на овие модели предизвикува загриженост за тоа како овие податоци се обработуваат и користат. На пример, медицинскиот LLM обучен за евиденција на пациенти покренува прашања за приватноста и користењето на податоците. Обезбедувањето дека личните податоци не се злоупотребуваат или експлоатираат бара транспарентни процеси за ракување со податоците во рамките на овие модели.

Нови решенија за интерпретабилност

За да се одговори на овие предизвици, се развиваат нови техники. Тие вклучуваат контрафактални (CF) методи на приближување. Првиот метод вклучува поттикнување на LLM да промени специфичен концепт на текст додека другите концепти ги одржува константни. Овој пристап, иако ефективен, е интензивен за ресурси во време на заклучување.

Вториот пристап вклучува создавање на посветен простор за вградување воден од LLM за време на обуката. Овој простор се усогласува со причински график и помага да се идентификуваат совпаѓањата што ги приближуваат CFs. Овој метод бара помалку ресурси за време на тестирањето и се покажа дека ефикасно ги објаснува предвидувањата на моделите, дури и во LLM со милијарди параметри.

Овие пристапи ја истакнуваат важноста на каузалните објаснувања во системите на НЛП за да се обезбеди безбедност и да се воспостави доверба. Контрафакталните приближувања обезбедуваат начин да се замисли како даден текст би се променил доколку одреден концепт во неговиот генеративен процес би бил различен, помагајќи во практична проценка на причинско-последичниот ефект на концептите на високо ниво на НЛП моделите.

Длабоко нуркање: методи за објаснување и каузалност во LLMs

Алатки за сондирање и важност на карактеристиките

Сондирањето е техника што се користи за да се дешифрира што кодираат внатрешните претстави во моделите. Може да биде надгледуван или без надзор и има за цел да утврди дали одредени концепти се кодирани на одредени места во мрежата. Иако до одреден степен се ефикасни, сондите не даваат каузални објаснувања, како што е нагласено од Гајгер и сор. (2021).

Алатките за важноста на карактеристиките, друга форма на метод за објаснување, често се фокусираат на влезните карактеристики, иако некои методи базирани на градиент го прошируваат ова на скриени состојби. Пример е методот Интегрирани градиенти, кој нуди каузална интерпретација со истражување на основните (контрафактуални, CF) влезови. И покрај нивната корисност, овие методи сè уште се борат да ги поврзат нивните анализи со концепти од реалниот свет надвор од едноставните влезни својства.

Методи засновани на интервенција

Методите засновани на интервенција вклучуваат менување на влезовите или внатрешните претстави за проучување на ефектите врз однесувањето на моделот. Овие методи можат да создадат состојби на CF за да ги проценат причинските ефекти, но тие често генерираат неверојатни влезови или мрежни состојби, освен ако внимателно не се контролираат. Причинскиот модел на прокси (CPM), инспириран од концептот S-learner, е нов пристап во оваа област, имитирајќи го однесувањето на објаснетиот модел под влезовите на CF. Сепак, потребата од посебен објаснувач за секој модел е големо ограничување.

Приближни контрафакти

Контрафактуалите се широко користени во машинското учење за зголемување на податоците, што вклучува пертурбации на различни фактори или ознаки. Тие можат да се генерираат преку рачно уредување, хеуристичка замена на клучни зборови или автоматско препишување текст. Иако рачното уредување е точно, исто така бара ресурси. Методите базирани на клучни зборови имаат свои ограничувања, а генеративните пристапи нудат рамнотежа помеѓу флуентноста и покриеноста.

Верни објаснувања

Верноста во објаснувањата се однесува на прецизно прикажување на основното расудување на моделот. Не постои универзално прифатена дефиниција за верност, што доведува до нејзино карактеризирање преку различни метрики како што се чувствителност, конзистентност, договор за важност на карактеристиките, робусност и симулација. Повеќето од овие методи се фокусираат на објаснувања на ниво на карактеристика и често ја мешаат корелацијата со каузалноста. Нашата работа има за цел да обезбеди објаснувања за концептот на високо ниво, користејќи ја литературата за каузалноста за да предложи интуитивен критериум: Ред-верност.

Навлезевме во вродените сложености на LLM, разбирајќи ја нивната природа на „црната кутија“ и значајните предизвици што ги поставува. Од ризиците од погрешно одлучување во чувствителните области како што се здравството и финансиите до етичките дилеми околу пристрасноста и правичноста, потребата за транспарентност во LLM никогаш не била поочигледна.

Иднината на LLM и нивната интеграција во нашиот секојдневен живот и критичните процеси на одлучување зависи од нашата способност да ги направиме овие модели не само понапредни, туку и поразбирливи и поодговорни. Стремежот за објаснување и интерпретабилност не е само технички потфат, туку основен аспект на градење доверба во системите за вештачка интелигенција. Како што LLM стануваат се повеќе интегрирани во општеството, побарувачката за транспарентност ќе расте, не само од практичарите на вештачка интелигенција, туку и од секој корисник кој комуницира со овие системи.