Вештачка интелигенција

Графичките процесори може да бидат подобри, не само побрзи, при обука на длабоки невронски мрежи

Истражувачите од Полска и Јапонија, работејќи со Sony, пронајдоа докази дека системите за машинско учење обучени на графички процесори наместо на процесори може да содржат помалку грешки за време на процесот на обука и да произведат супериорни резултати, што е во спротивност со општо сфаќањето дека графичките процесори едноставно ги извршуваат таквите операции побрзо, наместо од било кој подобар.

на истражување, со наслов Влијанието на несигурноста на графичкиот процесор врз обуката на предвидливи длабоки невронски мрежи, доаѓа од Факултетот за психологија и когнитивни науки на Универзитетот Адам Мицкевич и два јапонски универзитети, заедно со лабораториите за компјутерски науки SONY.

Студијата сугерира дека „неизвесности“ кои длабоките невронски мрежи ги покажуваат наспроти различните хардверски и софтверски конфигурации ги фаворизираат поскапите (и сè поретко) графички процесорски единици и во тестовите беше откриено дека длабока невронска мрежа обучена исклучиво на процесорот произведува повисоки стапки на грешки во текот на ист број епохи (колку пати системот повторно ги обработува податоците за обука во текот на сесијата).

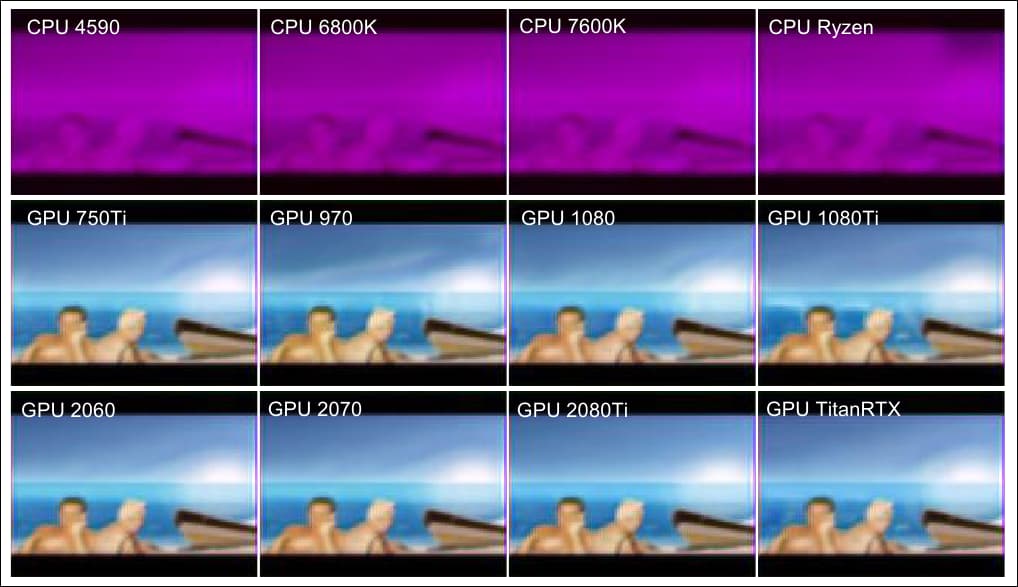

Во овој дополнителен пример од трудот, гледаме (долни два реда), сличен квалитет на резултатот добиен од различни графички процесори и (прв ред), инфериорни резултати добиени од низа инаку многу способни процесори. Извор: https://arxiv.org/pdf/2109.01451.pdf

Чудни појави

Овие прелиминарни наоди не се применуваат подеднакво кај популарните алгоритми за машинско учење, а во случај на едноставни архитектури на автоенкодер, феноменот не се појавува.

Сепак, работата навестува можна „брзина на бегство“ за ефикасноста на обуката во сложени невронски мрежи, каде што покривањето на истите операции со помала брзина и поголеми времиња на обука не го добива паритетот на перформансите што би се очекувало од рутините за математичко повторување.

Истражувачите сугерираат дека оваа разлика во перформансите би можела да биде одредена за одредени типови на невронски мрежи и дека неодредените аспекти на процесирањето специфично за графичкиот процесор, кои често се гледаат како пречка што евентуално треба да се надмине, не само што може да обезбеди забележителни придобивки, туку на крајот може да биде намерно инкорпорирани во подоцнежните системи. Трудот, исто така, сугерира дека наодите би можеле да понудат подлабок увид во пресметковната обработка поврзана со мозокот.

Идентификувањето на особеностите што ја зголемуваат ефикасноста и квалитетот на резултатите на овој начин на графичките процесори има потенцијал за добивање подлабок увид во архитектурите на вештачката интелигенција на „црната кутија“, па дури и за подобрување на перформансите на процесорот - иако во моментов, основните причини се неостварливи.

Автокодер vs. PredNet

Во проучувањето на аномалиите, истражувачите користеа основен автоенкодер, а исто така и Предиктивна невронска мрежа на Универзитетот Харвард PredNet, истражување од 2016 година, кое беше дизајнирано да го истражи и да се обиде да го повтори однесувањето на човечкиот церебрален кортекс.

Двата системи се длабоки невронски мрежи дизајнирани да синтетизираат соодветни слики преку учење без надзор (со податоци од кои етикетите беа испуштени), иако автоенкодерот се занимава линеарно со една слика по серија, што потоа ќе произведе излез како следна слика во повторливиот цевковод. Авто-кодерот беше обучен на МНИСТ база на податоци за ракопис.

Авто-кодерот во тестовите на истражувачите беше обучен на базата на податоци MNIST, која содржи 60,000 слики за обука со 28×28 пиксели, антиалиасирани за индукција во сива скала, како и 10,000 тест слики.

Спротивно на тоа, PredNet го оценува сложениот видео влез и во случајот на ова истражување, беше обучен за FPSI база на податоци, која содржи обемна видео снимка од еден ден во Дизни Ворлд во Орландо, Флорида (Дизни беше еден од истражувачите соработници на трудот од 2012 година).

Секвенци на слики од FPSI, кои прикажуваат погледи од прво лице на еден ден во Disney World.

Двете архитектури се многу различни во однос на сложеноста. Авто-кодерот е дизајниран да ги реконструира сликите наместо да ги предвидува целните вредности. Спротивно на тоа, PredNet има четири слоеви, од кои секој се состои од репрезентативни неврони кои користат конволутивна долга краткорочна меморија (LSTM).

Слоевите даваат контекстуални предвидувања кои потоа се споредуваат со целта со цел да се произведе термин за грешка што се шири низ мрежата. Секој од двата модели користи учење без надзор.

Едноставната, линеарна архитектура на автоенкодерот и полавиринтската и рекурзивна мрежа на PredNet.

Двата системи беа тестирани на низа хардверски и софтверски конфигурации, вклучувајќи процесори без графички процесори (Intel i5-4590, i7-6800K, i5-7600K или AMD Ryzen-5-3600) и процесори со графички процесори (Intel i5-7600K + NVIDIA GTX-750Ti, i5-7600K + GTX-970, i7-6700K + GTX-1080, i7-7700K + GTX-1080Ti, i7-9700 + RTX-2080Ti, i5-7600K + 2060y RTX- 5 + RTX-3600 супер, или i2070-5 + Titan-RTX).

Прегледувач на интерактивниот процес htop беше искористена за да се осигура дека целата обука се одвива или на една нишка (на Intel i7-6800K), на четири нишки (на Intel i5-4590 и i5-7600K) или шест нишки (на AMD Ryzen-5-3600 ).

Седло поени

На автоенкодерот, средната разлика меѓу сите конфигурации, со и без cuDNN, не беше значајна. За PredNet, резултатите беа позачудувачки, со забележителни разлики во проценката на загубите и квалитетот помеѓу обуката на процесорот и графичкиот процесор.

Просечните резултати за загуби за обуката на PredNet на четири процесори и осум графички процесори, при што мрежата е обучена на 5000 видео рамки во 250 серии, со прикажана просечна загуба за последните 1000 фрејмови (50 серии). cuDNN беше исклучен.

Истражувачите заклучуваат дека „Иако механизмот е нејасен, хардверот на графичкиот процесор се чини дека има способност да ја унапреди обуката на DNNs.

Резултатите покажуваат дека графичките процесори може да бидат подобри во избегнувањето на точките на седлото - областите во спуштање на градиент што го опишуваат дното на наклонот.

Надирот на падините во спуштање на градиент е „седловата точка“, именувана од очигледни причини. Извор: https://www.pinterest.com.au/pin/436849232581124086/

Точките на седлото, иако претставуваат пречка, во голема мера се отфрлени како лесно обработени во неодамнешната мисла за оптимизација на стохастичко спуштање на градиент (SGD), но новиот труд сугерира не само дека графичките процесори може да бидат уникатно опремени за да ги избегнуваат, туку и дека влијанието на можеби треба повторно да се разгледаат точките на седлото.