Artificial Intelligence

当AI角色扩大时,氛围编码效果受损

一项新研究发现,当人类给出指令时,氛围编码会改善,但当AI给出指令时则会下降,最佳混合设置是保持人类主导,AI作为仲裁者或评判者。

美国的一项新研究考察了当AI系统被允许引导氛围编码,而不仅仅是执行人类指令时会发生什么。研究发现,当大型语言模型(LLMs)承担更大的方向性角色时,结果几乎总是更差。

尽管研究人员使用OpenAI的GPT-5作为他们人/AI协作实验的框架,但他们后来证实,Anthropic的Claude Opus 4.5和Google Gemini 3 Pro也随着责任增加而出现相同的性能下降曲线,并指出“即使是有限的人类参与也能稳步提高性能”:

“(人类)在迭代过程中提供了独特有效的高层指导,(而)AI指导常常导致性能崩溃。此外,我们发现,一种让人类负责方向、将评估工作交给AI的谨慎角色分配,可以提高混合系统的性能。”

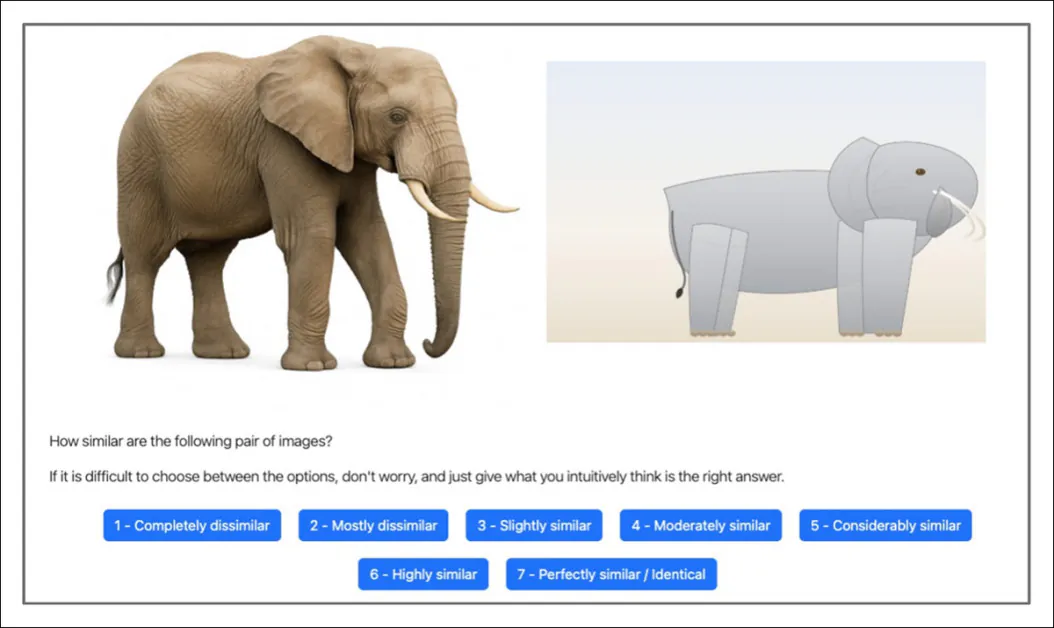

为了提供一个可由人类和AI平等评估的一致性测试,研究围绕一项迭代编码任务构建了一个受控实验框架。该任务要求使用可缩放矢量图形(SVG)重现一张参考图像——图像包含猫、狗、老虎、鸟、大象、企鹅、鲨鱼、斑马、长颈鹿或熊猫的照片——并将重现结果与其来源照片进行比对评分:

人类和AI参与者都会看到一张照片参考图像和一张AI生成的SVG重建图,并被要求按照七点量表对两者的相似度进行评分。 来源

在每一轮中,一个智能体提供高层自然语言指令来指导代码生成器,另一个则决定是保留新版本还是恢复到前一个版本——这是一个模拟真实协作工作流程的结构化循环。

在涉及604名参与者和数千次API调用的16项实验中,在完全相同的条件下,将完全由人类主导的测试轮次与完全由AI主导的轮次进行了直接比较。

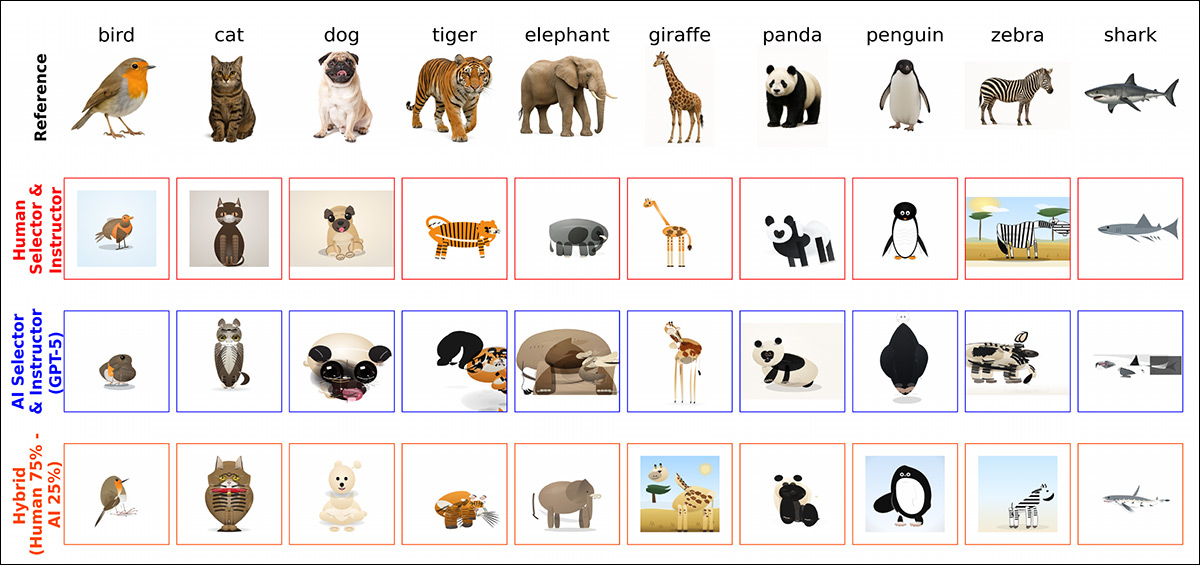

通过不同人/AI协作百分比和类型组合得出的各种解决方案(取自源论文中的更大插图,我们建议读者参阅该论文)。

尽管在测试基线开始时,人类和AI的表现水平相似,但随着时间的推移,他们的轨迹出现了分歧:当人类提供指令并做出选择决定时,相似度分数随着迭代而增加,呈现稳定的累积改进;但当AI系统同时承担这两个角色时,性能没有显示出一致的提升,并且经常在轮次中下降——尽管使用了相同的基础模型进行代码生成,并且AI可以访问与人类参与者相同的信息。

冗长效应

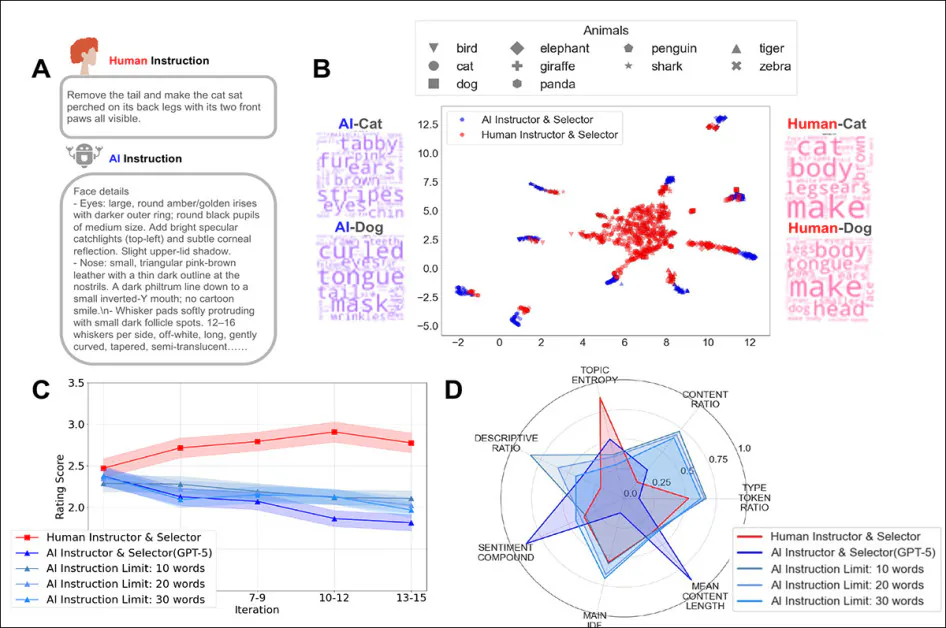

结果还显示,人类的指令通常简短且以行动为导向,侧重于当前图像中下一步要更改什么;相反,AI的指令要长得多且描述性很强(这一因素已针对GPT-5进行了参数化),详细描述视觉属性,而不是优先考虑增量修正。

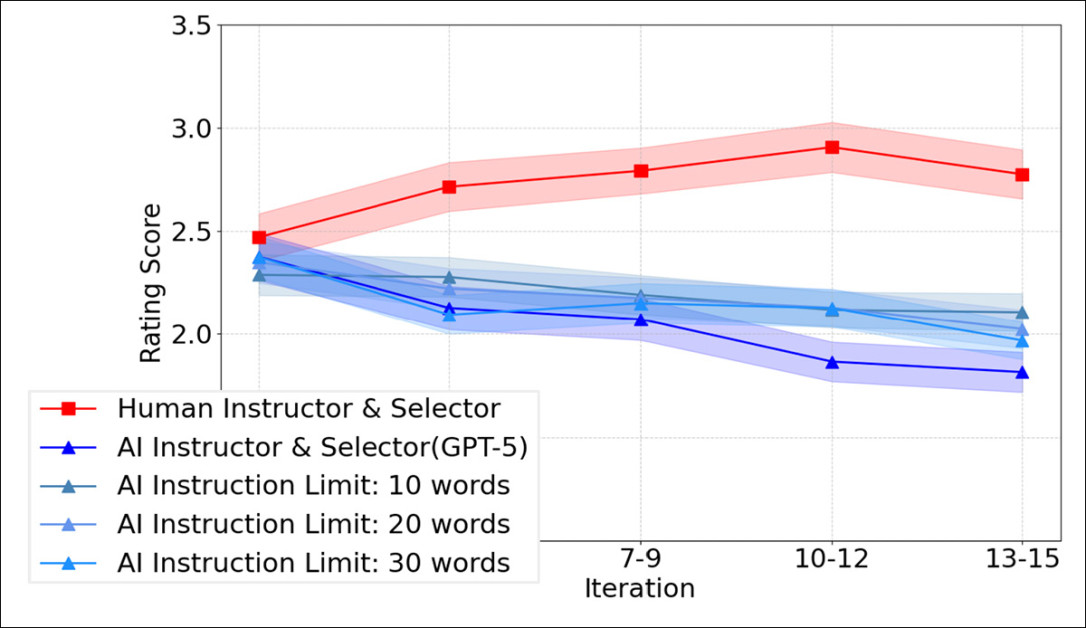

但是,如下图所示,对AI指令施加严格的字数限制并没有逆转这种模式;即使被限制在10、20或30个词,AI主导的链条仍然无法随着时间的推移而改进:

人类主导轮次与限制在10、20或30词指令的完全AI主导轮次在各轮迭代中的相似度评分。显然,缩短AI提示并不能防止当AI同时指导指令和选择时观察到的迭代性能下降。

混合实验使模式更加清晰,表明与完全由AI主导的设置相比,即使加入少量人类参与也能改善结果;然而,随着AI指导份额的增加,性能通常会下降。

当角色分离时,评估和选择可以交给AI,质量损失相对较小;但用AI指导取代人类的高层指令会导致性能明显下降,这表明最重要的不是谁生成了代码,而是谁在迭代过程中设定并维持了方向。

作者总结道:

“在多项实验中,人类主导的编码在迭代中持续改进,而AI主导的编码尽管拥有相同的信息和相似的执行能力,却常常崩溃。

“这指出了当今AI系统在维持跨重复交互的连贯高层方向方面的关键困难,而这种方向对于成功的氛围编码是必要的。”

这篇新论文题为Why Human Guidance Matters in Collaborative Vibe Coding,来自康奈尔大学、普林斯顿大学、麻省理工学院和纽约大学的七位研究人员。

方法

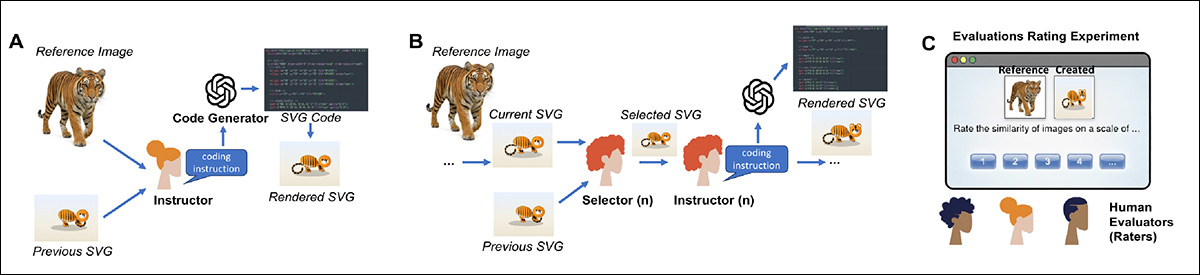

在实验中,一名人类指导者查看一张GPT-5生成的动物参考照片,以及最新的相关SVG模仿尝试。然后,他/她编写自然语言指令来指导代码生成器实现更接近的匹配。

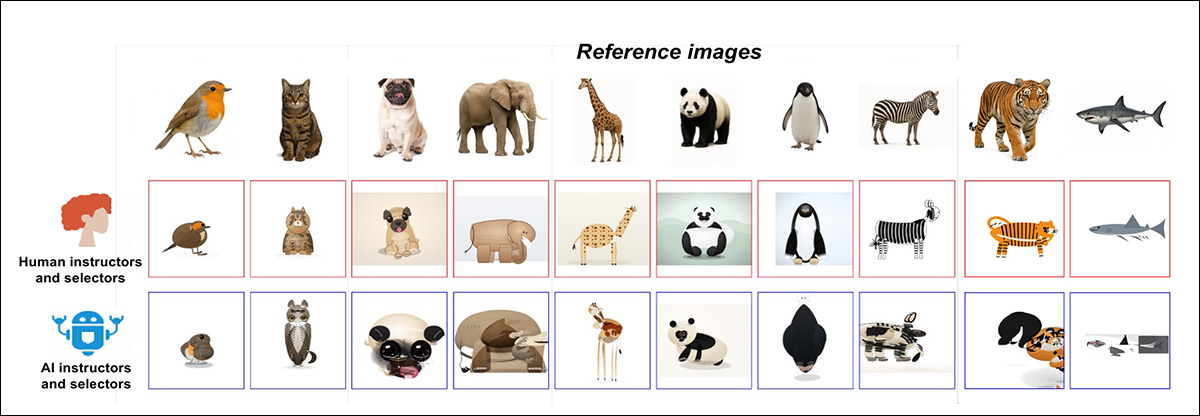

因此,生成器每轮都会生成一个新的SVG,为测试指导效果如何随时间累积提供了一个迭代循环。目标是十张GPT-5生成的动物图像,涵盖了各种形状和纹理,以便轻松检测改进或错误:

研究中使用的氛围编码工作流程示意图。在A)中,一名人类指导者查看一张照片参考图像以及迄今为止生成的最佳SVG,并为代码生成器编写自然语言指令以生成下一个SVG;在B)中,一名人类选择者将新的SVG与之前的SVG进行比较,并选择哪个版本与参考图像更匹配,然后将选定的SVG传递到下一轮指令;在C)中,独立的人类评估者对每个生成的SVG与其参考图像的相似度进行评分,提供用于评估整体性能的分数。

一名人类选择者将每个新生成的SVG与前一个进行比较,并接受或拒绝它,这使得整个过程在各轮中与参考图像保持一致。在这个基线设置中,同一个人承担了这两个角色。

为了衡量质量,独立的人类评估者对每个生成的SVG与其参考图像的相似度进行评分。在十六项实验中,120人提供了4,800个评分。所有实验均在PsyNet框架上运行,这是一个旨在容纳人类与AI系统之间结构化交互的门户。

该研究招募了604名以英语为母语的人进行测试,这些测试将消耗4,800次API调用用于代码生成,以及5,327次API调用用于指令生成。虽然GPT-5是使用的主要模型,但也用Claude Opus 4.5和Gemini 3 Pro进行了较小的比较批次,每个模型处理了280次查询。

结果

进行了三十轮氛围编码,每轮包括对核心十张参考图像的十五次编辑。为此,选择了45名人类参与者,在“人类主导”的轮次中,每人在十次迭代中同时担任选择者和指导者。

在每一回合中,同一参与者首先在当前SVG和上一个SVG之间做出选择,然后编写下一轮指令。测试的第二个版本用GPT-5的API调用取代了这些人类决策,同时保持设置的其余部分不变。在所有情况下,指导者和选择者角色都用通俗语言提示代码生成器。

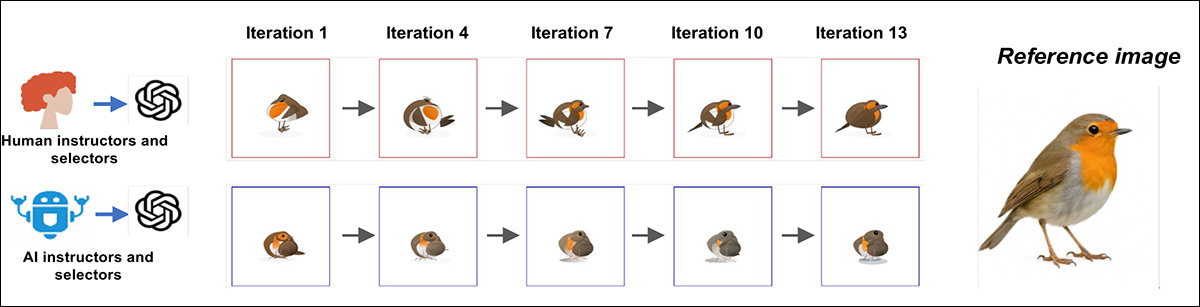

一个多轮氛围编码的代表性例子显示了该过程如何随时间推移而分化;当人类同时担任选择者和指导者时,SVG输出在迭代中稳步改进,每轮都更接近参考图像:

一张参考图像在人类主导(上)和AI主导(下)的氛围编码下的示例进展,显示当人类担任两个角色时,迭代中稳步改进,而当两个角色都由AI处理时,则出现停滞或漂移。

相反,在AI主导的版本中,早期轮次有时能捕捉到关键的视觉特征,但后来的尝试未能在此基础上取得进展,并且在某些情况下偏离了目标:

最终迭代的输出结果,比较了人类主导回合(上行)与AI主导链条(下行)在同一组参考图像上的表现。人类主导的结果更接近原始动物,而AI主导的结果显示出明显的变形或关键特征的丢失。

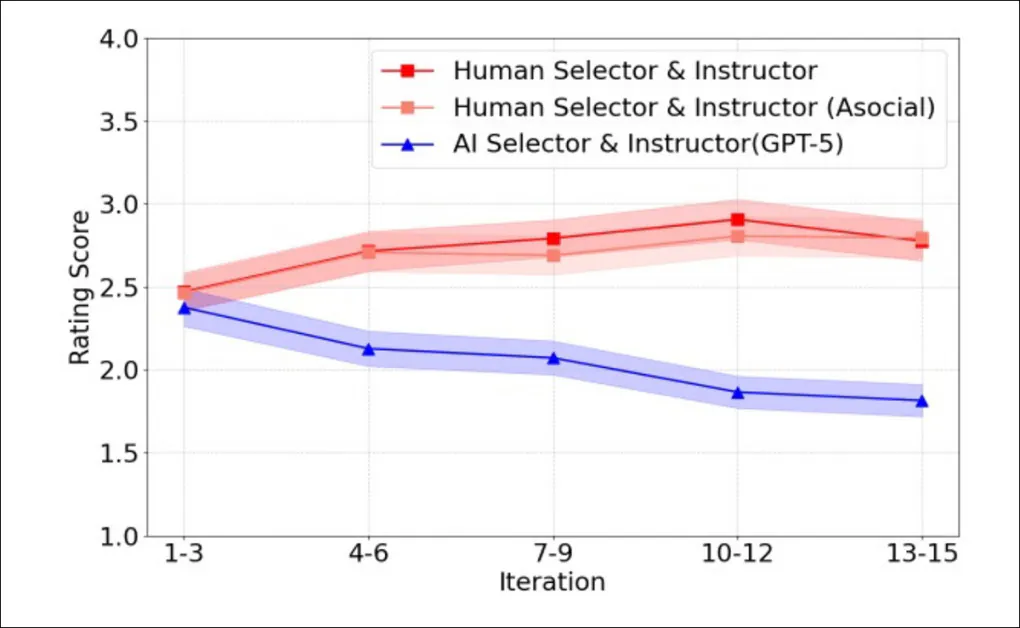

为了定量测量出现的趋势,最终图像被展示给独立的评分者,并根据与参考图片的相似度进行评分。在早期轮次中,人类主导和AI主导的运行得分大致相同;但到了第十五轮,差异变得明显,人类选择的图像被评为更接近目标。随着时间的推移,人类得分稳步上升,相对于AI的最大相对增益达到了27.1%。

人类主导和AI主导的氛围编码在各轮迭代中的平均相似度分数,显示当人类同时担任选择者和指导者时稳步提升,而当两个角色都由GPT-5处理时则逐渐下降。

为了确保出现的趋势不是由于多个同时参与的人类参与者的集体力量所致,研究人员招募了十名额外人员单独工作,每人自己运行三轮——结果以同样稳定的方式得到改善,证明这些收益并非集体努力的偶然现象。

大局观

然而,如果GPT-5自己评判输出,它会承认人类的结果更好吗?人类和AI的评分通常朝着相同的方向变化,因此模型能够区分好坏,但它始终给AI生成的图像评分高于人类给出的评分。

“具体来说,我们询问AI智能体是否会认识到它们自己的输出不如人类产生的输出,或者反而表现出对自己作品的偏好,这将表明一个潜在的校准问题。”

事实证明,确实存在一个校准问题*:

“AI评估者给AI生成的(输出)分配了更高的评分。这些发现表明,观察到的性能差异可能源于人类和AI之间表征的错位。”

在检查人类和AI各自如何表达其指导时,测试中的差异变得明显。如下图所示,焦点和长度都是AI/人类分歧的主题:

人类和AI在编码任务中如何给出指令的比较。’A’显示人类编写简短、直接的指令,而AI编写冗长、详细的描述。’B’映射了指令,显示人类提示聚集在一起,而AI提示按动物分开。’C’追踪限制AI指令长度并不能随着时间的推移改善其糟糕的结果;’D’说明即使施加字数限制,人类给出的指导也比AI更多样化和平衡。

人类的指令往往简短扼要,提供可以普遍应用于各个目标的明确编辑建议。另一方面,AI的指令则充满了描述性细节,常常充斥着关于阴影、纹理、光照或解剖细节的具体描述——这些描述孤立来看可能有意义,但未能为模型提供有用的下一步指导(对于那些了解LLMs在上下文长度方面问题的人来说,这很熟悉,即随着项目的发展和增长,能够保留“大局观”)。

为了查看减少冗长是否会提高性能,GPT-5被限制为每条指令10、20或30个词;但即使这些压缩的指令也未能显示出任何改进(见上图右下角)。

联合努力

为了测试当人类和AI共享控制权时会发生什么,研究人员运行了具有不同人类和AI输入比例的编码任务,范围从主要由人类到主要由AI。

每种混合组合的表现都优于完全由AI控制,因此即使是少量的人类指导也能改善结果:

具有不同人/AI混合比例的氛围编码设置。(A) 显示人类和AI在每个编码步骤中轮流担任指导者和选择者;(B) 显示更多人类参与带来更高质量的结果,而更多AI输入则降低分数;(C) 描绘了随着人类参与份额的减少,最终输出质量稳步下降,证实了更一致的人类方向能产生更好的结果。

随着AI接管更多过程,性能下降,当人类主导大多数轮次时看到最佳结果,而当AI主导大多数轮次时结果最弱。这些混合设置中没有一个能够随着每一新轮次而持续改进,这表明人类指导在稳定和一致时效果最佳,而不是偶尔为之。

角色互换

该研究还探讨了在这类任务中谁做什么是否重要,并对此进行了测试。修订后的练习涉及两个任务:一个参与者将指示如何更改图像,另一个将选择更优的版本。

当两项工作都由人完成时,质量得以保持;但当人类给出指令而没有人在版本之间进行选择时,质量变得更差:

[caption