Anderson's Angle

Vibe Coding Menderita Saat Peran AI Meluas

Sebuah studi baru menemukan bahwa vibe coding meningkat ketika manusia yang memberikan instruksi, tetapi menurun ketika AI yang melakukannya, dengan pengaturan hibrida terbaik menjaga manusia sebagai yang utama, dengan AI sebagai arbiter atau penilai.

Penelitian baru dari Amerika Serikat, yang meneliti apa yang terjadi ketika sistem AI diizinkan untuk mengarahkan vibe coding, daripada sekadar menjalankan instruksi manusia, menemukan bahwa ketika Large Language Models (LLMs) mengambil peran pengarahan yang lebih besar, hasilnya hampir selalu lebih buruk.

Meskipun para peneliti menggunakan GPT-5 OpenAI sebagai kerangka kerja untuk eksperimen kolaborasi manusia/AI mereka, mereka kemudian mengonfirmasi bahwa Claude Opus 4.5 milik Anthropic dan Google Gemini 3 Pro mengalami kurva penurunan yang sama seiring bertambahnya tanggung jawab, dengan menyatakan bahwa ‘bahkan keterlibatan manusia yang terbatas secara konsisten meningkatkan kinerja’:

‘[Manusia] memberikan panduan tingkat tinggi yang secara unik efektif di seluruh iterasi, [sedangkan] panduan AI sering kali menyebabkan kolaps kinerja. Selain itu, kami menemukan bahwa alokasi peran yang hati-hati yang menjaga manusia tetap memegang kendali atas arah sambil mendelegasikan evaluasi kepada AI dapat meningkatkan kinerja hibrida.’

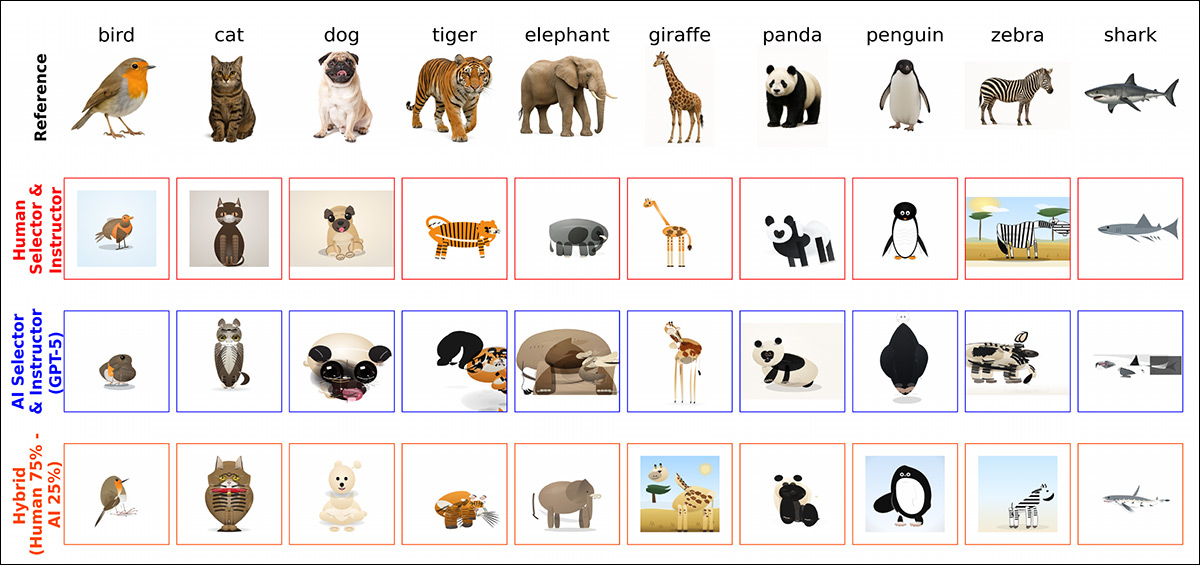

Untuk menyediakan tes yang konsisten yang dapat dievaluasi secara setara oleh manusia maupun AI, sebuah kerangka kerja eksperimental terkontrol dibangun di sekitar tugas coding iteratif di mana gambar referensi – menampilkan foto kucing, anjing, harimau, burung, gajah, penguin, hiu, zebra, jerapah, atau panda – harus dibuat ulang menggunakan scalable vector graphics (SVG), dan rekreasi itu dinilai terhadap foto sumber darimana ia berasal:

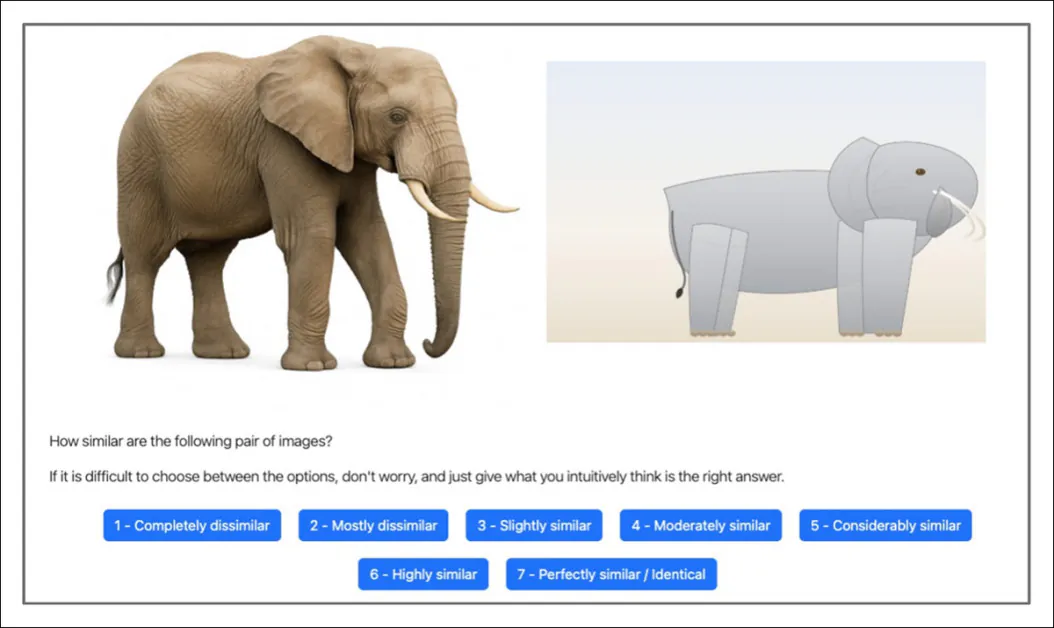

Baik peserta manusia maupun AI diperlihatkan gambar referensi fotografi bersamaan dengan rekonstruksi SVG yang dihasilkan AI, dan diminta untuk menilai seberapa mirip keduanya pada skala tujuh poin. Sumber

Di setiap putaran, satu agen memberikan instruksi bahasa alami tingkat tinggi untuk memandu generator kode, dan agen lainnya memutuskan apakah akan mempertahankan versi baru atau kembali ke versi sebelumnya – sebuah loop terstruktur yang mencerminkan alur kerja kolaboratif nyata.

Di 16 eksperimen yang melibatkan 604 peserta dan ribuan panggilan API, putaran pengujian yang sepenuhnya dipimpin manusia dibandingkan langsung dengan putaran yang sepenuhnya dipimpin AI, dalam kondisi yang identik.

Beberapa solusi beragam yang dicapai oleh kombinasi persentase dan jenis kolaborasi manusia/AI yang berbeda (diambil dari ilustrasi yang lebih besar di makalah sumber, yang kami rujuk kepada pembaca).

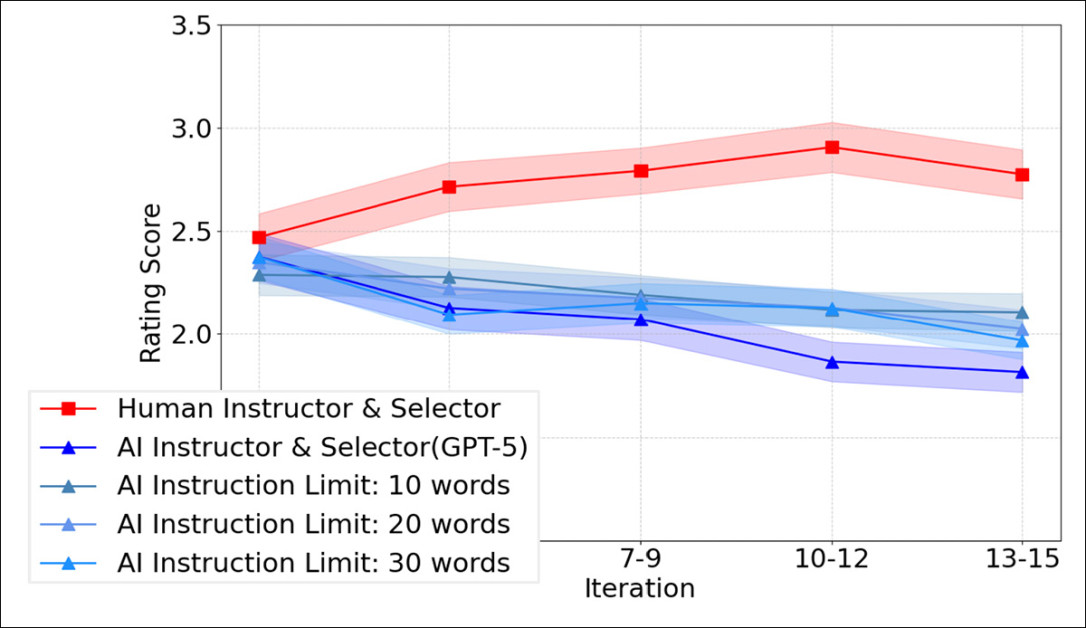

Meskipun manusia dan AI berkinerja pada tingkat yang serupa di awal baseline pengujian, seiring waktu, lintasan mereka menyimpang: ketika manusia memberikan instruksi dan membuat keputusan seleksi, skor kemiripan meningkat di seluruh iterasi, dengan peningkatan kumulatif yang stabil; tetapi ketika sistem AI mengisi kedua peran, kinerja tidak menunjukkan peningkatan yang konsisten, dan sering menurun dari putaran ke putaran – meskipun model dasar yang sama digunakan untuk generasi kode, dan AI memiliki akses ke informasi yang sama dengan peserta manusia.

Efek Prolixity

Hasilnya juga menunjukkan bahwa instruksi manusia biasanya pendek dan berorientasi pada tindakan, berfokus pada apa yang harus diubah selanjutnya pada gambar saat ini; sebaliknya, instruksi AI jauh lebih panjang dan sangat deskriptif (faktor yang diparametrik untuk GPT-5), merinci atribut visual daripada memprioritaskan koreksi inkremental.

Namun, seperti terlihat pada grafik di bawah, memberlakukan batasan kata yang ketat pada instruksi AI tidak membalikkan pola; bahkan ketika dibatasi hingga 10, 20, atau 30 kata, rantai yang dipimpin AI masih gagal untuk membaik seiring waktu:

Peringkat kemiripan di seluruh iterasi untuk putaran yang dipimpin manusia dibandingkan dengan putaran yang sepenuhnya dipimpin AI yang dibatasi pada instruksi 10, 20, atau 30 kata. Jelas, mempersingkat prompt AI tidak mencegah penurunan kinerja iteratif yang diamati ketika AI mengarahkan baik instruksi maupun seleksi.

Eksperimen hibrida membuat pola lebih jelas, menunjukkan bahwa menambahkan sedikit saja keterlibatan manusia meningkatkan hasil, dibandingkan dengan pengaturan yang sepenuhnya dipimpin AI; namun kinerja biasanya menurun seiring meningkatnya porsi panduan AI.

Ketika peran dipisahkan, evaluasi dan seleksi dapat diserahkan kepada AI dengan kehilangan kualitas yang relatif sedikit; tetapi mengganti instruksi tingkat tinggi manusia dengan panduan AI menyebabkan penurunan kinerja yang nyata, menunjukkan bahwa yang paling penting bukanlah siapa yang menghasilkan kode, tetapi siapa yang menetapkan dan mempertahankan arah di seluruh iterasi.