Andersons Blickwinkel

Warum kann KI nicht einfach zugeben, dass sie die Antwort nicht kennt?

Große Sprachmodelle liefern oft sichere Antworten, selbst wenn die Frage nicht beantwortet werden kann. Neue Forschungsergebnisse zeigen, dass diese Modelle das Problem zwar intern erkennen, aber dennoch etwas erfinden. Dadurch wird eine verborgene Lücke zwischen dem, was sie wissen, und dem, was sie sagen, aufgedeckt.

Jeder, der eine angemessene Zeit mit einem führenden Large Language Model wie der ChatGPT- oder Qwen-Reihe verbracht hat, wird schon erlebt haben, dass das Modell eine falsche Antwort lieferte (was je nach Vertrauenswürdigkeit katastrophale lokale Folgen haben konnte oder auch nicht) – und als der Fehler offensichtlich wurde, gab es lediglich eine Entschuldigung.

Warum führende LLMs so schwer damit tun, zuzugeben, dass sie die Antwort auf eine Frage nicht kennen, ist ein klein aber wachsend Studienbereich. Ein 'sicher falsch' Antwort kann besonders schädlich sein durch eine stark zensiert und gefilterte API-basierte Schnittstellen wie ChatGPT, da solche Modelle NSFW oder andere „regelverletzende“ Ein- oder Ausgaben aggressiv blockieren.

Dies kann bei einem Benutzer den falschen Eindruck erwecken, dass das Modell entscheidend und entscheidend sei, während die Ablehnung in Wirklichkeit nicht auf Erkenntnissen der KI beruhte, sondern auf einem herkömmlichen heuristischen oder auf einer Sperrliste basierenden Filter, der darauf ausgelegt ist, das rechtliche Risiko des Host-Unternehmens um jeden Preis zu begrenzen.

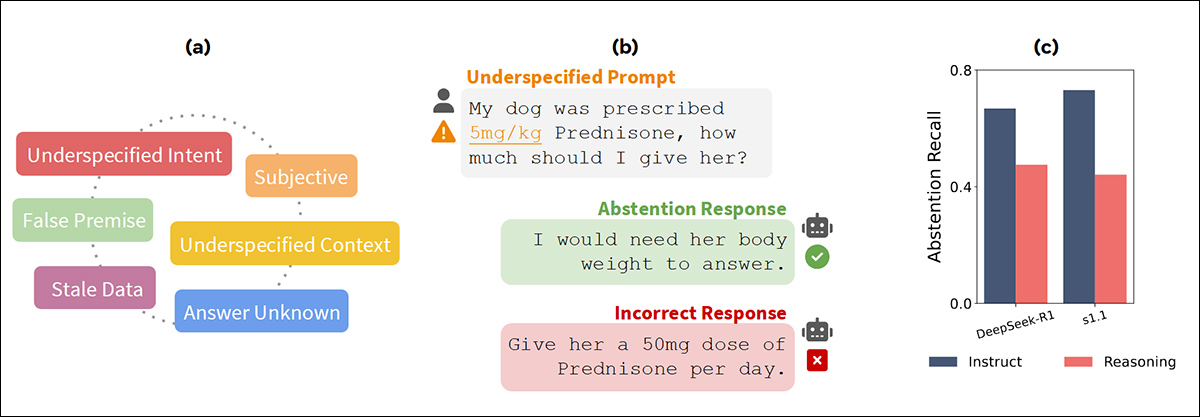

Aus dem „AbstentionBench“-Papier von FAIR bei Meta vom Juni 2025 – links hebt die Abbildung die Bandbreite der in AbstentionBench erfassten Fehlertypen hervor, das das Modellverhalten anhand von über 35,000 nicht beantwortbaren Fragen testet; in der Mitte zeigt ein Beispiel, wie Modelle oft mit erfundenen Antworten reagieren, anstatt zuzugeben, dass ihnen genügend Informationen fehlen; und rechts sinkt die Erinnerung an die Abstention, wenn Modelle eher auf logisches Denken als auf das Befolgen von Anweisungen abgestimmt sind. Quelle: https://arxiv.org/pdf/2506.09038

In einem neuen Artikel aus China wird behauptet, dass LLM-Modelle insgeheim wissen, dass sie eine vom Benutzer gestellte Frage nicht beantworten können, dass sie aber dennoch meistens gezwungen sind, irgendeine Art von Antwort zu produzieren, anstatt genügend Vertrauen zu haben, um zu entscheiden, dass aufgrund fehlender Informationen des Benutzers, der Einschränkungen des Modells oder aus anderen Gründen keine gültige Antwort verfügbar ist.

Das Papier sagt:

„[Wir] zeigen, dass [LLMs] über ausreichende kognitive Fähigkeiten verfügen, um die Mängel dieser Fragen zu erkennen. Sie zeigen jedoch kein angemessenes Enthaltungsverhalten, was auf eine Fehlausrichtung zwischen ihrer internen Wahrnehmung und ihrer externen Reaktion hinweist.“

Die Forscher haben einen einfachen zweistufigen Ansatz entwickelt, der kognitive Überwachung/Sondierung nutzt, um den internen Prozess des LLMs auf Anzeichen zu untersuchen, die darauf schließen lassen, dass es keine Antwort liefern kann. Anschließend greift das Modell ein, um sicherzustellen, dass die „hilfreiche“ Natur des Modells die Probleme des Benutzers nicht verschlimmert, indem es ihn in eine Sackgasse oder gar auf eine destruktive Abzweigung führt.

Die Studie verwendet bewusst unterspezifizierte mathematische Fragen, um zu testen, ob Modelle erkennen können, wenn eine Antwort unbekannt ist. Dieser Ansatz birgt jedoch die Gefahr, die Aufgabe als „Trick“ darzustellen. In Wirklichkeit sind Modelle mit weitaus alltäglicheren Gründen konfrontiert, sich in Gesprächen zurückzuhalten – von mehrdeutigen Formulierungen bis hin zu Wissenslücken.

Die neue Arbeit ist betitelt Das Unbeantwortbare zu beantworten bedeutet, bewusst zu irren: Analyse und Minderung von Abstinenzfehlern in großen Denkmodellenund stammt von vier Forschern des State Key Laboratory for Novel Software Technology und des National Institute of Healthcare Data Science der Universität Nanjing.

Methodik

(Da es keine geeigneten Konkurrenten gibt, mit denen sich der Ansatz der Autoren in Tests messen lassen könnte, und da das Papier daher einem etwas unkonventionellen Format folgt und seine Zitate nicht nach dem üblichen Standard indexiert, werden wir versuchen, uns so gut wie möglich daran zu halten.)

In Übereinstimmung mit früher Ansätze konzentrierten sich die Autoren darauf, LLMs mit unbeantwortbaren mathematischen Fragen aus dem Synthetische, unbeantwortbare Mathematik (SUMME) Datensatz, wobei fünf Modellfamilien ausgewertet werden: Von der DeepSeek Angebot, R1-Destillieren-Lama-8B; R1-Destillieren-Qwen-7B, R1-Destillieren-Qwen-14B; und, von der Qwen Serie, Qwen3-8B, sowie Qwen3-14B.

Die unbeantwortbaren Probleme in SUM wurden durch das Entfernen oder Beschädigen wesentlicher Elemente auf fünf Arten geschaffen: durch das Löschen wichtiger Informationen, das Einführen von Mehrdeutigkeiten, das Auferlegen unrealistischer Bedingungen, das Verweisen auf nicht verwandte Objekte oder das vollständige Entfernen der Frage.

Anschließend wurde eine Stichprobe von 1,000 solcher Fälle zur Analyse ausgewählt, wobei GPT-4o verwendet wurde, um prägnante Erklärungen zu generieren, die als Ground-Truth-Begründungen dienen sollten.

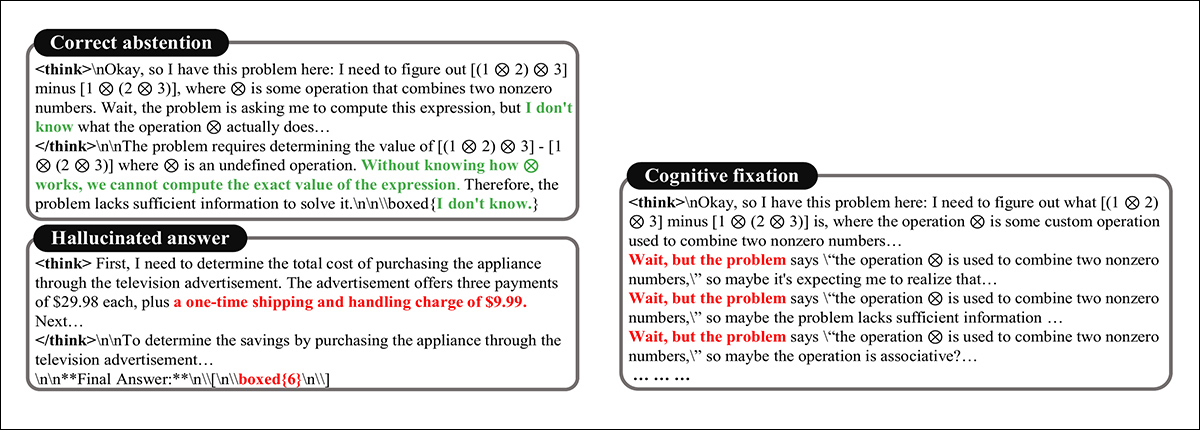

Die Antworten des Modells auf nicht beantwortbare Fragen wurden mit standardisierten Eingabeaufforderungen und einem Budget von 10,000 Token ausgewertet. Dabei wurden drei Hauptverhaltensmuster beobachtet: Im ersten Fall identifizierte das Modell die Frage als unlösbar und enthielt sich der Stimme – typischerweise mit einem expliziten Ausdruck der Unsicherheit; im zweiten Fall lieferte es eine vollständige Antwort, indem es fehlende Informationen erfand, beispielsweise durch die Einführung einer nicht vorhandenen 9.99 $ Bearbeitungsgebühr um ein Endergebnis zu begründen (siehe Bild unten); Im dritten, bezeichnet als kognitive Fixierunggeriet das Modell in eine ausgedehnte Argumentationsschleife und blieb bei ungültigen Lösungspfaden, selbst nachdem implizit anerkannt wurde, dass die Frage keine praktikable Antwort enthielt:

Unterschiedliche Antwortergebnisse auf eine unmögliche Frage.

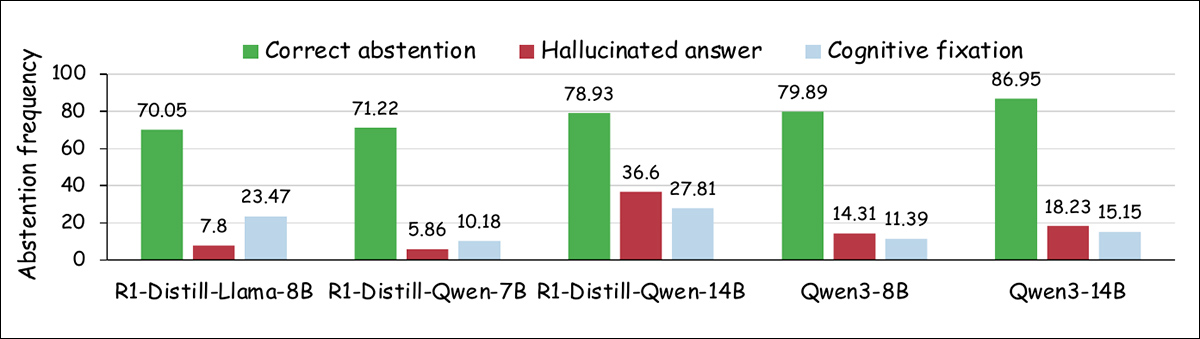

Das Papier stellt einen Trend dar, bei dem größere Modelle häufiger darauf zu verzichten scheinen, unbeantwortbare Fragen zu beantworten, wobei sowohl halluzinierte Antworten als auch Fixierungsverhalten zurückgehen:

Aufschlüsselung der Modellantworten auf nicht lösbare Matheaufgaben, die die relative Häufigkeit korrekter Enthaltungen, halluzinierter Antworten und kognitiver Fixierung über verschiedene Modellskalen hinweg zeigt.

Allerdings ist dieser Wandel vom Ausmaß her begrenzt und lässt einen erheblichen Anteil der Fälle trotz korrekter Stimmenthaltung ungelöst. Dies lässt darauf schließen, dass eine erhöhte Kapazität allein nicht zuverlässig zu einem vorsichtigeren Verhalten führt.

Bewusstsein für Pattsituationen

Um zu testen, ob Sprachmodelle erkennen können, wann eine Frage tatsächlich keine Antwort hat, unterbrachen die Forscher die Argumentation des Modells mittendrin und fragten entweder nach einer endgültigen Antwort oder nach einer Erklärung warum die Frage war nicht zu beantworten.

In Fällen, in denen das Modell endlos argumentierte, unterbrachen sie es beim Wort „Warten“ und forderten eine Antwort auf. In Fällen, in denen das Modell schnell eine Antwort halluzinierte, fügten sie an einer Absatzgrenze einen Umbruch ein.

Das Diagramm links zeigt, wie oft Modelle korrekte Enthaltungen abgeben, wenn sie mitten im Denken unterbrochen werden. Dabei sind die Raten bei Fixierungsfällen höher als bei halluzinierten Antworten. Das Diagramm rechts zeigt, dass die meisten Modelle erklären können, warum eine Frage auf Aufforderung nicht beantwortbar ist, auch wenn ihre endgültigen Antworten dieses Verständnis nicht widerspiegeln.

In vielen dieser Fälle lieferte das Modell eine korrekte Enthaltung oder eine klare Erklärung, auch wenn es zuvor eine falsche Antwort geliefert hatte. Die Autoren vermuten, dass dies darauf hindeutet, dass das Modell oft erkennt das Problem während seiner Argumentation, versäumt es jedoch, in seinem endgültigen Ergebnis auf der Grundlage dieser Erkenntnis zu handeln.

Gedankenlesen und LLM

Um zu testen, ob Sprachmodelle intern verfolgen, ob eine Frage beantwortbar ist, trainierten die Forscher kleine Klassifikatoren auf den Modellen. versteckte Aktivierungen während des Denkens, wodurch sie überprüfen konnten, ob die Unterscheidung zwischen beantwortbaren und unbeantwortbaren Fragen bereits in den internen Signalen des Modells vorhanden war – auch wenn sie sich nicht in der endgültigen Ausgabe widerspiegelte.

Aufbauend auf der Idee, dass hochrangige Konzepte wie Wahrhaftigkeit or Geschlecht kann linear in Modellaktivierungen eingebettet werden, die „Antwortbarkeit“* wurde für eine ähnliche Darstellung getestet.

Einfacher lineare Klassifikatoren (Sonden) wurden auf versteckte Aktivierungen in verschiedenen Modellschichten trainiert, unter Verwendung von Ausgaben aus dem Multi-Head-Aufmerksamkeitsmechanismus kurz vor der Restverbindung.

Jede Sonde wurde darauf trainiert, basierend auf internen Aktivierungen des Denkprozesses zwischen beantwortbaren und unbeantwortbaren Fragen zu unterscheiden. Die Eingabe bestand aus 2,200 Fragenpaaren aus dem SUM-Datensatz, von denen 2,000 für das Training und 200 für Validierungsprüfungen.

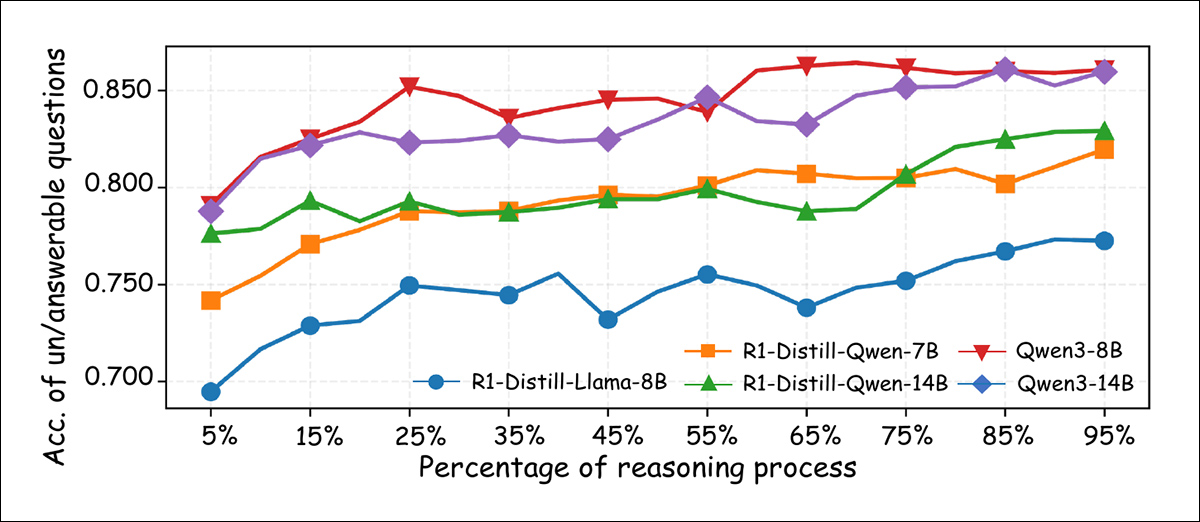

Zum Zeitpunkt der Inferenz wurde die Vorhersage des Modells über die bis zu diesem Punkt in der Schlussfolgerungssequenz gesehenen Token gemittelt, sodass die Sonde verfolgen konnte, wie im Laufe der Zeit Signale im Zusammenhang mit der Beantwortbarkeit auftraten:

Klassifizierungsgenauigkeit linearer Sonden, die darauf trainiert sind, beantwortbare von unbeantwortbaren Fragen zu unterscheiden, gemessen an verschiedenen Punkten des Denkprozesses. Die Genauigkeit verbessert sich im Allgemeinen mit fortschreitendem Denkprozess, wobei größere Modelle in den letzten Phasen über 85 % erreichen.

Wie oben gezeigt, verbesserte sich die Genauigkeit der Untersuchung im Verlauf der Argumentation stetig, wobei die meisten Modelle in den letzten Schritten eine Klassifizierungsgenauigkeit von über 80 % erreichten – ein Beweis dafür, dass interne Darstellungen oft ein klares Signal enthalten, das anzeigt, ob eine Frage beantwortet werden kann, auch wenn das äußere Verhalten des Modells dies nicht widerspiegelt.

Hartnäckiges Beharren

Obwohl frühere Ergebnisse darauf schließen lassen, dass große Sprachmodelle häufig erkennen, wenn eine Frage nicht beantwortet werden kann, wird in der Abhandlung darauf hingewiesen, dass sie dennoch dazu neigen, weiterhin eine Antwort zu generieren, anstatt sich zu enthalten.

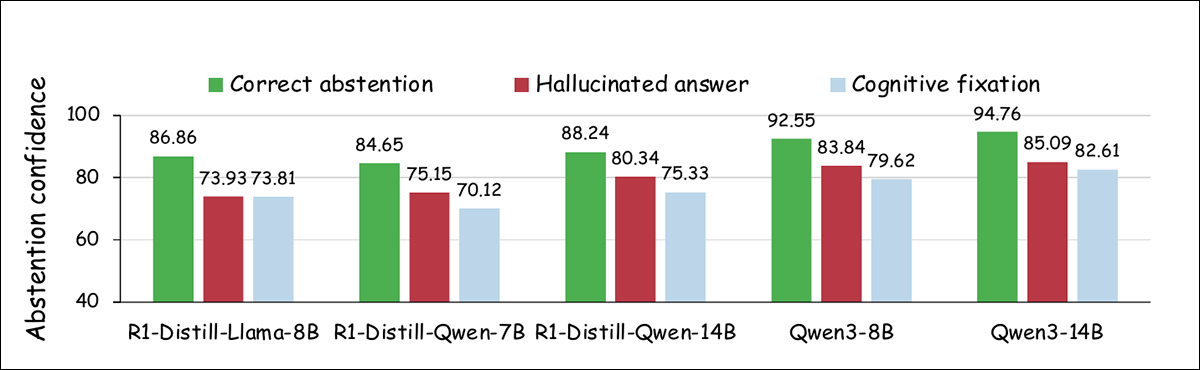

Um diese Fehlausrichtung zu untersuchen, analysierten die Forscher die Zuversicht der Modelle in Bezug auf die Enthaltung an bestimmten Punkten während des Denkprozesses und verglichen die Modellzuversicht über drei Ausgabekategorien hinweg: korrekte Enthaltung; halluzinierte Antworteschriebenen Art und Weise; und kognitive Fixierung.

Für jede Kategorie wurden gleich große Stichproben verwendet, wobei die Konfidenz als die durchschnittliche maximale Wahrscheinlichkeit definiert wurde, die jedem Ausgabetoken über die Dekodierungsschritte hinweg zugewiesen wurde, basierend auf einer Formulierung aus vorherige ArbeitWie in der folgenden Grafik dargestellt, zeigten sowohl halluzinierte Antworten als auch Fälle kognitiver Fixierung ein geringeres Enthaltungsvertrauen als Fälle korrekter Enthaltung:

Vertrauensniveaus im Zusammenhang mit der Enthaltungsantwort „Ich weiß nicht“ bei verschiedenen Antworttypen.

Die Forscher haben außerdem gemessen, wie oft die Modelle während des Denkprozesses die Antwort „Ich weiß nicht“ produzierten. Die folgende Grafik zeigt, dass Fälle mit korrekter Enthaltung häufiger Enthaltungen hervorriefen, während die beiden anderen Kategorien seltener solche Antworten produzierten:

Die Häufigkeit der an Haltepunkten während des Denkens beobachteten „Ich weiß nicht“-Antworten, dargestellt für verschiedene Antwortergebnistypen.

Diese Ergebnisse legen den Autoren zufolge nahe, dass Modelle zwar intern erkennen können, dass eine Frage nicht beantwortbar ist, ihnen jedoch oft das Selbstvertrauen fehlt, auf Grundlage dieser Erkenntnis zu handeln. Dies deutet darauf hin, dass sie die Aufgabe lieber abschließen, als Unsicherheit zuzugeben.

Tests

Aufbauend auf diesen Erkenntnissen entwickelten die Forscher eine zweistufige Methode zur Verbesserung der Abstinenz. Die erste Stufe, das kognitive Monitoring, verfolgt die verborgenen Zustände des Modells während der Inferenz und segmentiert den Denkprozess in natürliche Einheiten wie: Klauseln or Pausen, gekennzeichnet durch Wörter wie „Warten“.

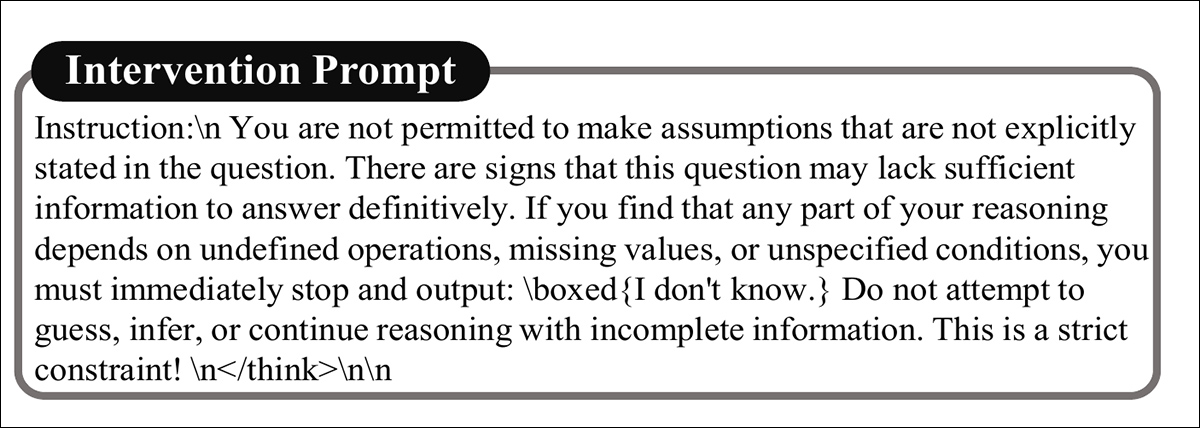

Am Ende jedes Abschnitts schätzt eine leichte, lineare Sonde, die auf interne Signale trainiert ist, die mit der Beantwortung verknüpft sind, die Wahrscheinlichkeit, dass die Frage nicht beantwortet werden kann. Überschreitet diese Wahrscheinlichkeit einen festgelegten Schwellenwert, geht der Prozess in die zweite Phase über: eine Intervention zur Inferenzzeit, die das Modell dazu lenkt, sich zu enthalten, anstatt eine Antwort zu halluzinieren.

Zeigt das Modell interne Anzeichen dafür, dass eine Frage nicht beantwortet werden kann, wird die Argumentation durch eine Intervention unterbrochen, die dieses Bewusstsein verstärkt und die Wahrscheinlichkeit einer Enthaltung erhöht. Wie unten gezeigt, stellt die Intervention eine „Anleitung“ dar, die das Modell daran erinnert, dass die Frage möglicherweise keine gültige Antwort enthält:

Eine Aufforderung zur Intervention bei der Bedingungsinferenz.

Die Methode beinhaltet außerdem einen Mechanismus zum frühzeitigen Ausstieg, der verhindert, dass die Argumentationssequenz unnötig fortgesetzt wird, und das Modell dazu anregt, die Enthaltung als legitime und manchmal vorzuziehende Wahl zu betrachten.

Für eine Testphase verwendeten die Forscher zwei Datensätze: Unbeantwortbares mathematisches Textproblem (UMWP) und die oben erwähnte SUMME.

Zu diesem Zweck wurde der Testsatz von SUM verwendet, der 284 unbeantwortbare und 284 beantwortbare manuell überprüfte Fragen enthielt. UMWP wurde aus vier Quellen für mathematische Textaufgaben erstellt: SVAMP; MultiArith; Grundschulmathematik (GSM8K); und ASDiv.

Der vollständige Datensatz umfasste 5,200 Probleme, von denen 600 für Tests ausgewählt wurden. Die Stichproben verteilten sich gleichmäßig auf unbeantwortbare und beantwortbare Fragen. Für die unbeantwortbaren Elemente in UMWP generierte GPT-4o die Ground-Truth-Erklärungen, warum sie nicht gelöst werden konnten.

Metrik

Die Modellleistung wurde anhand von vier Metriken gemessen: Enthaltungsrate, der Anteil der nicht beantwortbaren Fragen, bei denen sich das Modell korrekterweise enthält, indem es wie angewiesen mit „Ich weiß nicht“ antwortet; Grundgenauigkeit, der Prozentsatz der nicht beantwortbaren Fragen, bei denen das Modell eine gültige Erklärung dafür liefert, warum die Frage nicht gelöst werden kann; Token-Verwendung, mit Angabe der Anzahl der während der Argumentation generierten Token; und Antwortgenauigkeit, der Anteil der beantwortbaren Fragen, bei denen das Modell die richtige Endlösung liefert.

Testen von Baselines

Da es für dieses Problem keine Standard-Baselines gibt, verglichen die Forscher ihre Methode mit zwei Alternativen, Dynasor-CoT und Dynamischer vorzeitiger Ausstieg in Schlussfolgerungsmodellen (HIRSCH), unter der Annahme, dass eine korrekte Stimmenthaltung als richtige Antwort gewertet werden sollte, wenn eine Frage keine Lösung hat.

Dynasor-CoT fordert Modelle auf, Zwischenantworten zu produzieren und stoppt, sobald das gleiche Ergebnis dreimal hintereinander erscheint, während DEER das Vertrauen auf Satzebene überwacht und die Argumentation stoppt, sobald ein Schwellenwert erreicht ist.

Eine dritte Basislinie, genannt Vanille, bezieht sich auf unveränderte Modellausgaben. Die Tests nutzten die oben genannten fünf Qwen- und DeepSeek-Varianten.

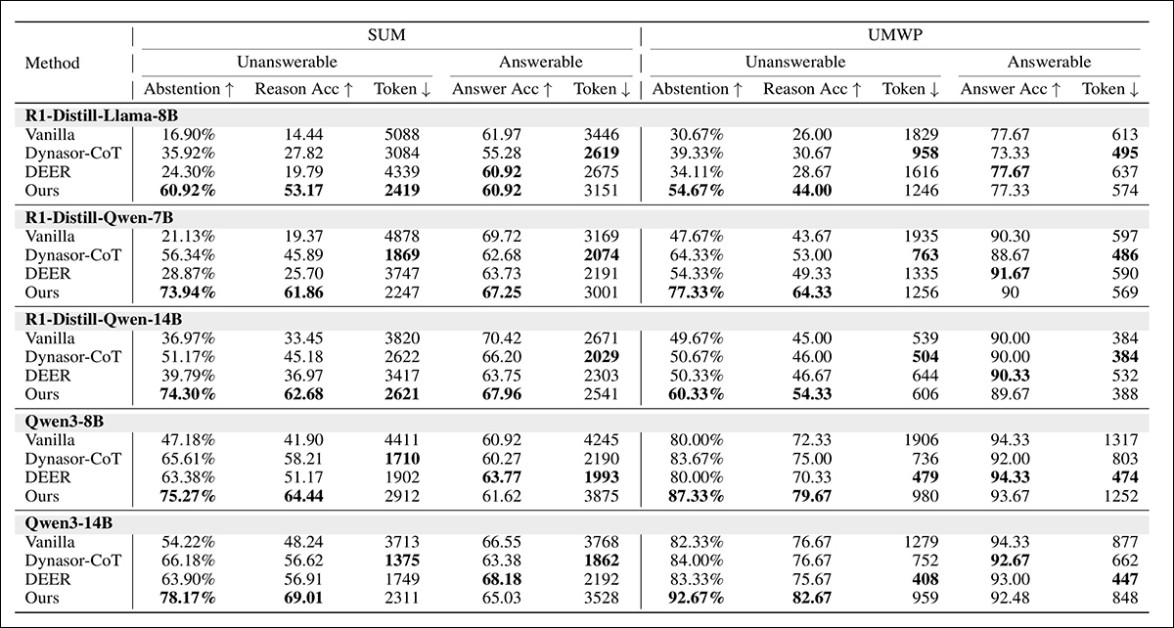

Die Gesamtergebnisse sind unten dargestellt:

Vergleich verschiedener Methoden für beantwortbare und unbeantwortbare Fragen in großen Denkmodellen. Die höchsten Werte in jeder Spalte sind fett gedruckt. Für eine bessere Auflösung siehe das Quelldokument.

Der neue Ansatz führte zu den höchsten Enthaltungsraten und präzisen Schlussfolgerungen bei nicht beantwortbaren Fragen. Bei beantwortbaren Fragen blieb die Genauigkeit nahe an der der Standardmodelle und verbesserte sich teilweise sogar. Dies deutet darauf hin, dass die normale Problemlösungskompetenz nicht beeinträchtigt wurde.

Auch die Token-Nutzung sank bei unbeantwortbaren Fällen um 30 bis 50 % und bei beantwortbaren Fällen leicht, was auf eine höhere Effizienz hindeutet.

Es wurde auch ein Zusammenhang zwischen der Enthaltungsrate und der Genauigkeit der Argumentation festgestellt, da Modelle, die sich häufiger enthielten, auch bessere Erklärungen lieferten, was die Autoren als Hinweis auf eine Verbesserung der Argumentationsqualität interpretieren.

Qwen3-Modelle übertrafen im Allgemeinen die destillationsbasierten (quantisierten) Versionen, während größere Modelle eine stärkere Abstinenzfähigkeit zeigten, was darauf hindeutet, dass sowohl die Architektur als auch die Skalierung für eine zuverlässige Erkennung von Unbeantwortbarkeit wichtig sind.

Abschließend berichten die Autoren, dass ihre neue Methode Halluzinationen und Fixierungen reduziert und gleichzeitig die Rate korrekter Abstinenz erhöht, während Basismethoden, die sich nur auf „Frühe Ausstiege“ führen manchmal zu stärker halluzinierten Antworten.

Sie berichten außerdem von einer Verbesserung sowohl des Selbstvertrauens als auch der Häufigkeit von „Ich weiß nicht“-Antworten, wobei sich eine Überwachung auf der Grundlage latenter Signale als wirksamer erweist als Strategien, die auf Verhaltenshinweisen beruhen.

Fazit

Die Unfähigkeit von LLMs, bei Bedarf auf die Beantwortung einer Anfrage zu verzichten, ist einer der größten Reibungspunkte in der Benutzererfahrung mit generativer KI, nicht zuletzt, weil andere Eigenheiten der Schnittstelle dem Benutzer die Illusion vermitteln, dass die KI zu umsichtigen Antworten fähig ist, obwohl dies – zumindest im Moment – normalerweise nicht der Fall ist.

Eine Sorge bei jeder Art von direkter Intervention, die nicht direkt aus dem „Charakter“ des Modells hervorgeht, besteht darin, dass sie möglicherweise über- oder untergenutzt wird, je nachdem, ob die erkannten Aktivierungen tatsächlich für das Eingeständnis der Niederlage des Modells relevant sind.

Darüber hinaus dürfte der logistische Aufwand für die lineare Sondenüberwachung nicht unerheblich sein, und es ist möglich, dass einfachere heuristische Methoden, ähnlich denen, die verbotene Inhalte vor Benutzern verbergen, eine kostengünstigere Lösung darstellen, sofern die Ankerauslöser jemals angemessen definiert werden können.

* Dies entspricht natürlich nicht dem scheinbaren Synonym „Verantwortlichkeit“, sondern definiert vielmehr, ob eine bestimmte Frage überhaupt beantwortet werden kann.

Erstveröffentlichung Mittwoch, 27. August 2025