Andersons Blickwinkel

Hinzufügen von Dialogen zu realen Videos mithilfe von KI

Ein neues KI-Framework kann die Worte einer Person in einem Video umschreiben, entfernen oder hinzufügen, ohne dass eine Neuaufnahme nötig ist – und zwar in einem einzigen durchgängigen System.

Vor drei Jahren hätte man im Internet sicherlich für Aufsehen gesorgt, wenn man eines der 20 bis 30 KI-basierten Videobearbeitungs-Frameworks gesehen hätte, die wöchentlich in akademischen Portalen veröffentlicht werden; mittlerweile ist dieser populäre Forschungszweig so ergiebig geworden, dass er fast schon einen eigenen Zweig des „KI-Schrotts“ darstellt, und ich behandle weit weniger solcher Veröffentlichungen als noch vor zwei oder drei Jahren.

Eine aktuelle Veröffentlichung in diesem Bereich hat jedoch meine Aufmerksamkeit erregt: ein integriertes System, das in reale Videoclips eingreifen und neue Sprache in das bestehende Video einfügen kann (anstatt einen kompletten generativen Clip aus einem Gesicht oder Bild zu erstellen, was viel üblicher ist).

In den folgenden Beispielen, die ich aus einer Vielzahl von Beispielvideos zusammengestellt habe, die auf der Veröffentlichungsseite verfügbar sind, Projekt-WebsiteZuerst sehen wir den eigentlichen Quellclip und dann, darunter, die in der Mitte des Clips eingefügte KI-Sprache, einschließlich Sprachsynthese und Lippensynchronisation:

Anklicken um abzuspielen. Lokale Bildbearbeitung mit Stitching – eine von mehreren von FacEDiT angebotenen Modalitäten. Eine bessere Auflösung finden Sie auf der Quellwebsite. Quelle – https://facedit.github.io/

Dieser Ansatz ist einer von dreien, die für die neue Methode entwickelt wurden. Er trägt den Titel „Lokale Bearbeitung mit Stitching“ und ist für die Autoren (und mich) von besonderem Interesse. Im Wesentlichen wird der Clip erweitert, indem eines der mittleren Bilder als Ausgangspunkt für eine neuartige KI-Interpretation verwendet wird und das darauffolgende (reale) Bild als Zielwert dient, an den sich der generativ eingefügte Clip anpassen soll. In den oben gezeigten Clips werden diese „Start-“ und „Zielbilder“ durch das Pausieren des obersten Videos dargestellt, während das darunterliegende, bearbeitete Video die generative Ergänzung liefert.

Die Autoren bezeichnen diesen Ansatz zur Gesichts- und Stimmsynthese als die erste vollständig integrierte End-to-End-Methode für KI-Videobearbeitungen dieser Art und weisen auf das Potenzial eines so ausgereiften Frameworks für die Fernseh- und Filmproduktion hin:

Filmemacher und Medienproduzenten müssen oft bestimmte Teile von aufgezeichneten Videos überarbeiten – vielleicht wurde ein Wort versprochen oder das Drehbuch nach den Dreharbeiten geändert. Zum Beispiel in der ikonischen Szene aus Titanisch (1997) wo Rose sagt: „Ich werde dich niemals loslassen, Jack.“ Der Regisseur könnte später entscheiden, dass es so sein sollte. „Ich werde dich nie vergessen, Jack.“.

„Normalerweise erfordern solche Änderungen das erneute Drehen der gesamten Szene, was kostspielig und zeitaufwändig ist. Die Sprachsynthese bietet eine praktische Alternative, indem sie die Gesichtsbewegungen automatisch an die geänderte Sprache anpasst und so das erneute Drehen überflüssig macht.“

Obwohl KI-Eingriffe dieser Art möglicherweise vor Herausforderungen stehen Kultur- Aufgrund von Widerstand seitens der Branche könnten sie auch eine neue Art von Funktionalität in von Menschen gesteuerten VFX-Systemen und Werkzeugsammlungen darstellen. In jedem Fall sind die Herausforderungen derzeit rein technischer Natur.

Neben der Erweiterung eines Clips durch zusätzliche KI-generierte Dialoge kann das neue System auch bereits vorhandene Sprache verändern:

Anklicken um abzuspielen. Ein Beispiel für die Änderung eines bestehenden Dialogs anstatt für das Einfügen zusätzlicher Dialoge. Eine bessere Auflösung finden Sie auf der Quellwebsite.

Der letzte Stand der Technik

Derzeit gibt es keine durchgängigen Systeme, die diese Art von Synthesefähigkeit bieten; allerdings gibt es eine wachsende Anzahl generativer KI-Plattformen wie beispielsweise Googles Veo-Serie, kann Audio erzeugen, und diverse andere Frameworks können erstellen Deepfake-AudioDerzeit muss man eine recht komplexe Pipeline aus verschiedenen Architekturen und Tricks erstellen, um in reales Filmmaterial so einzugreifen, wie es das neue System – mit dem Titel – vorsieht. FaceEdit – kann erreichen.

Das System verwendet Diffusionstransformatoren (DiT) in Kombination mit Flussanpassung Das System erzeugt Gesichtsbewegungen, die von den umgebenden (kontextuellen) Bewegungen und dem gesprochenen Audioinhalt abhängen. Es nutzt gängige Softwarepakete zur Gesichtsrekonstruktion, darunter LivePortrait (kürzlich von Kling übernommen).

Zusätzlich zu dieser Methode haben die Autoren, da ihr Ansatz als erster diese Herausforderungen in einer einzigen Lösung integriert, einen neuartigen Benchmark entwickelt namens FaceDiTBench, zusammen mit mehreren völlig neuen Bewertungsmetriken, die für diese sehr spezifische Aufgabe geeignet sind.

Die neue Arbeit ist betitelt FacEDiT: Einheitliche Bearbeitung und Generierung sprechender Gesichter durch Gesichtsbewegungsauffüllungund stammt von vier Forschern der Pohang University of Science and Technology (POSTECH), des Korea Advanced Institute of Science & Technology (KAIST) und der University of Texas at Austin.

Methodik

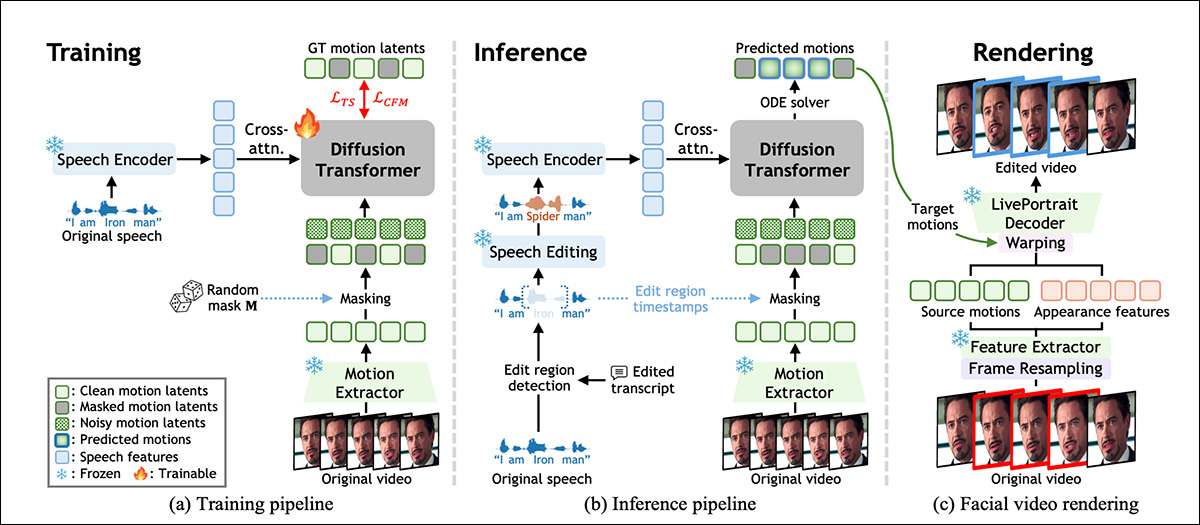

FacEDiT wird darauf trainiert, Gesichtsbewegungen zu rekonstruieren, indem es lernt, fehlende Teile der ursprünglichen Performance eines Schauspielers anhand der umgebenden Bewegungen und des Sprachsignals zu ergänzen. Wie im folgenden Schema dargestellt, ermöglicht dieser Prozess dem Modell, während des Trainings als Lückenfüller zu fungieren und Gesichtsbewegungen vorherzusagen, die zur Stimme passen und gleichzeitig mit dem Originalvideo konsistent bleiben.

Überblick über das FacEDiT-System, der zeigt, wie Gesichtsbewegungen durch selbstüberwachtes Ausfüllen während des Trainings erlernt, durch bearbeitete Sprache bei der Inferenz gesteuert und schließlich wieder in Video umgewandelt werden, indem das Erscheinungsbild des Originalmaterials wiederverwendet und nur die Zielbewegung ersetzt wird. Quelle

Zum Zeitpunkt der Inferenz unterstützt die gleiche Architektur zwei verschiedene Ausgaben, je nachdem, wie viel vom Video maskiert wird: Teilbearbeitungen, bei denen nur ein Satz geändert wird und der Rest unberührt bleibt; oder die Generierung ganzer Sätze, bei der neue Bewegungen komplett neu synthetisiert werden.

Das Modell wird trainiert über Durchflussanpassung, das Videobearbeitungen als eine Art Pfad zwischen zwei Versionen der Gesichtsbewegung betrachtet.

Anstatt von Grund auf zu erraten, wie ein bearbeitetes Gesicht aussehen sollte, lernt Flow Matching, fließend und stufenlos zwischen einem verrauschten Platzhalter und der korrekten Bewegung zu wechseln. Um dies zu ermöglichen, stellt das System die Gesichtsbewegung als kompakte Zahlenmenge dar, die mithilfe einer Version des oben erwähnten LivePortrait-Systems aus jedem Einzelbild extrahiert wird (siehe Schema oben).

Diese Bewegungsvektoren sind dazu gedacht, Gesichtsausdrücke und Kopfhaltung zu beschreiben, ohne Verstrickung Identität, so dass Sprachveränderungen lokalisiert werden können, ohne das Gesamtbild der Person zu beeinträchtigen.

FaceEDiT-Schulung

Für das Training von FacEDiT wurde jeder Videoclip in eine Reihe von Momentaufnahmen der Gesichtsbewegungen zerlegt und jedes Bild mit dem entsprechenden Audioabschnitt verknüpft. Anschließend wurden zufällige Teile der Bewegungsdaten ausgeblendet, und das Modell sollte anhand der Sprache und der umgebenden, nicht ausgeblendeten Bewegungen erraten, wie diese fehlenden Bewegungen aussehen sollten.

Da die maskierten Abschnitte und ihre Positionen von einem Trainingsbeispiel zum nächsten variieren, lernt das Modell nach und nach, wie es sowohl mit kleinen internen Änderungen als auch mit längeren Lücken für die Generierung vollständiger Sequenzen umgeht, je nachdem, wie viele Informationen ihm zur Verfügung gestellt werden.

Der erwähnte Diffusionstransformator des Systems lernt, maskierte Bewegungen zu rekonstruieren, indem er verrauschte Eingangsdaten im Laufe der Zeit verfeinert. Anstatt Sprache und Bewegung gleichzeitig in das Modell einzuspeisen, wird das Audiosignal in jeden Verarbeitungsblock einzeln eingeleitet. QueraufmerksamkeitDadurch kann das System die Lippenbewegungen präziser mit der gesprochenen Sprache abstimmen.

Um den Realismus über verschiedene Bearbeitungsschritte hinweg zu erhalten, wird der Fokus auf benachbarte Einzelbilder anstatt auf die gesamte Zeitleiste gelegt. Dadurch wird das Modell gezwungen, sich auf die lokale Kontinuität zu konzentrieren und Flimmern oder Bewegungssprünge an den Rändern veränderter Bereiche zu vermeiden. Positionsangaben (die dem Modell die Position jedes Einzelbildes in der Sequenz mitteilen) tragen zusätzlich dazu bei, den natürlichen zeitlichen Ablauf und Kontext beizubehalten.

Während des Trainings lernt das System, fehlende Gesichtsbewegungen vorherzusagen, indem es maskierte Bereiche anhand der Sprache und nahegelegener, unmaskierter Bewegungen rekonstruiert. Bei der Inferenz wird dieselbe Konfiguration wiederverwendet, wobei die Masken nun durch Änderungen in der Sprache gesteuert werden.

Wird ein Wort oder eine Phrase eingefügt, entfernt oder geändert, lokalisiert das System den betroffenen Bereich, maskiert ihn und generiert eine Bewegung, die zum neuen Audioinhalt passt. Die Generierung einer kompletten Sequenz wird als Sonderfall behandelt; hierbei wird der gesamte Bereich maskiert und von Grund auf neu synthetisiert.

Daten und Tests

Das Rückgrat des Systems besteht aus 22 Schichten für den Diffusionstransformator, jede mit 16 Aufmerksamkeitsköpfe und Feedforward-Dimensionen von 1024 und 2024px. Bewegungs- und Erscheinungsmerkmale werden extrahiert mithilfe von eingefroren LivePortrait-Komponenten und Sprache, die über WavLM und modifiziert mit VoiceCraft.

Eine spezielle Projektionsschicht bildet die 786-dimensionalen Sprachmerkmale auf den latenten Raum des DiT ab, wobei nur das DiT- und das Projektionsmodul von Grund auf trainiert werden.

Das Training wurde unter der AdamW Optimierer mit einer Ziellernrate von 1e‐4, für eine Million Schritte, auf zwei A6000-GPUs (jeweils mit 48 GB VRAM), bei insgesamt Losgröße von acht.

FaceDiTBench

Der FacEDiTBench-Datensatz enthält 250 Beispiele, jeweils mit einem Videoclip der Original- und der bearbeiteten Sprachaufnahme sowie den zugehörigen Transkripten. Die Videos stammen aus drei Quellen, wobei 100 Clips aus … stammen. HDTF, 100 aus Hallo3und 50 von CelebV-DubJedes einzelne Bild wurde manuell überprüft, um sicherzustellen, dass sowohl Audio als auch Video für die Auswertung ausreichend klar waren.

GPT‑4o Zur Überarbeitung jedes Transkripts wurden grammatikalisch korrekte Änderungen vorgenommen. Diese überarbeiteten Transkripte wurden zusammen mit dem Originaltext an VoiceCraft weitergeleitet, um neue Audiodateien zu erzeugen. In jedem Schritt wurden sowohl das Transkript als auch die generierte Sprachdatei manuell auf Qualität geprüft.

Jede Probe wurde mit der Art der Bearbeitung, dem Zeitpunkt der Änderung und der Länge des geänderten Abschnitts gekennzeichnet, und Bearbeitungen wurden wie folgt klassifiziert: Insertionen, Löschungen oder SubstitutionenDie Anzahl der geänderten Wörter reichte von kurzen Änderungen von 1 bis 3 Wörtern über mittlere Änderungen von 4 bis 6 Wörtern bis hin zu längeren Änderungen von 7 bis 10 Wörtern.

Zur Bewertung der Bearbeitungsqualität wurden drei benutzerdefinierte Metriken definiert. Photometrische KontinuitätUm zu messen, wie gut die Beleuchtung und die Farbe eines bearbeiteten Segments mit dem umgebenden Video verschmelzen, werden die Unterschiede auf Pixelebene an den Grenzen verglichen; Kontinuität der Bewegungum die Konsistenz der Gesichtsbewegungen zu beurteilen, indem die Veränderungen des optischen Flusses zwischen bearbeiteten und unbearbeiteten Einzelbildern gemessen werden; und Identitätserhaltungum abzuschätzen, ob das Erscheinungsbild der Person nach der Bearbeitung konsistent bleibt, indem Gesichtseinbettungen aus den Originalsequenzen und den generierten Sequenzen mithilfe der ArcFace Gesichtserkennungsmodell.

Tests

Das Testmodell wurde mit Material aus den drei oben genannten Datensätzen trainiert, das insgesamt rund 200 Stunden Videomaterial umfasst, darunter Vlogs und Filme sowie hochauflösende YouTube-Videos.

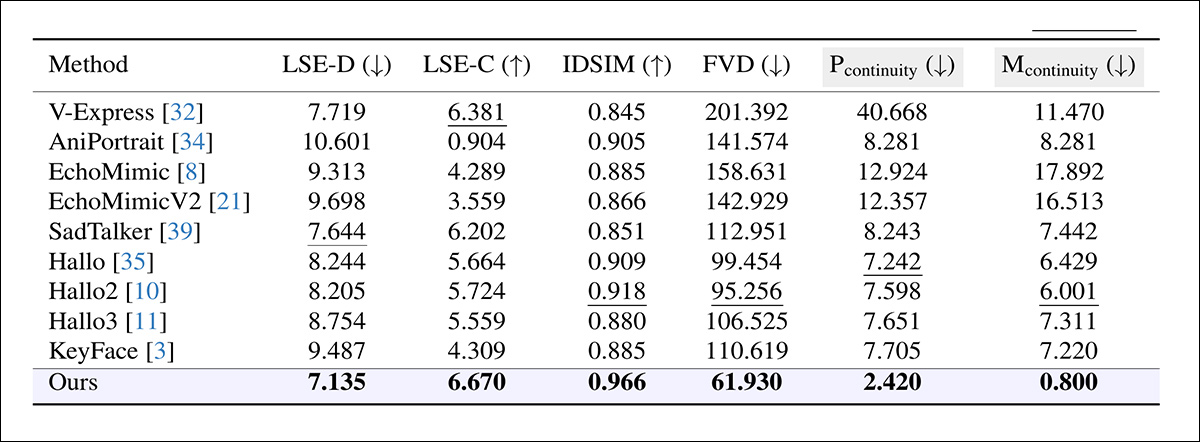

Zur Bewertung der Bearbeitung sprechender Gesichter wurde FacEDiTBench verwendet, zusätzlich zum HDTF-Testaufteilungsmodell, das sich zu einem Benchmarking-Standard für diese Aufgabenreihe entwickelt hat.

Da es keine direkt vergleichbaren Systeme gab, die in der Lage waren, diese Art von End-to-End-Funktionalität abzubilden, wählten die Autoren eine Vielzahl von Frameworks, die zumindest einen Teil der Zielfunktionalität reproduzierten und als Basismodelle dienen konnten; nämlich KeyFace; EchoMimic; EchoMimicV2; hallo; Hallo2; Hallo3; V-Express; AniPortraiteschriebenen Art und Weise; und SadTalker.

Zur Beurteilung der Produktions- und Bearbeitungsqualität wurden außerdem mehrere etablierte Kennzahlen herangezogen, wobei die Lippensynchronisationsgenauigkeit bewertet wurde durch SyncNet, wobei sowohl der absolute Fehler zwischen Lippenbewegungen und Audio (LSE-D) als auch ein Konfidenzwert (LSE-C) angegeben werden; Fréchet Video Entfernung (FVD) Quantifizierung der Gesamtrealismusrate des Videos; und Erlernte Wahrnehmungsähnlichkeitsmetriken (LPIPS), Messung der perzeptuellen Ähnlichkeit zwischen generierten und originalen Frames.

Bei der Bearbeitung wurden alle Metriken außer LPIPS nur auf das geänderte Segment angewendet; bei der Generierung wurde das gesamte Video ausgewertet, wobei die Kontinuität der Grenzen ausgeschlossen wurde.

Für jedes Modell wurde ein passendes Videosegment synthetisiert, das anschließend in den Originalclip eingefügt wurde (die Forscher weisen darauf hin, dass diese Methode häufig sichtbare Diskontinuitäten an den Übergängen zwischen dem bearbeiteten Abschnitt und dem umgebenden Material verursachte). Ein zweiter Ansatz wurde ebenfalls getestet, bei dem das gesamte Video aus dem veränderten Ton neu generiert wurde – dies überschrieb jedoch zwangsläufig ungeschnittene Bereiche und konnte die ursprüngliche Performance nicht erhalten.

Vergleich der Bearbeitungsleistung verschiedener Systeme, die ursprünglich für die Generierung sprechender Gesichter entwickelt wurden. FacEDiT übertrifft alle Vergleichssysteme in jeder Hinsicht und erzielt geringere Lippensynchronisationsfehler (LSE-D), höhere Synchronisationssicherheit (LSE-C), stärkere Identitätserhaltung (IDSIM), höhere Wahrnehmungsrealität (FVD) und sanftere Übergänge an den Bearbeitungsgrenzen (Pcontinuity, Mcontinuity). Grau hinterlegte Spalten heben die wichtigsten Kriterien zur Bewertung der Grenzqualität hervor; fett und unterstrichene Werte kennzeichnen die besten bzw. zweitbesten Ergebnisse.

Zu diesen Ergebnissen äußern sich die Autoren wie folgt:

„Unser Modell übertrifft bestehende Methoden bei der Bearbeitungsaufgabe deutlich. Es erzielt eine hohe Kontinuität der Übergänge und eine starke Identitätserhaltung und beweist damit seine Fähigkeit, die zeitliche und visuelle Konsistenz während der Bearbeitung aufrechtzuerhalten. Darüber hinaus spiegeln die überlegene Lippensynchronisationsgenauigkeit und der niedrige FVD den Realismus des synthetisierten Videos wider.“

Anklicken um abzuspielen. Die Ergebnisse wurden vom Autor anhand der auf der Projektwebsite veröffentlichten Videos zusammengestellt. Für eine höhere Auflösung besuchen Sie bitte die Originalwebsite.

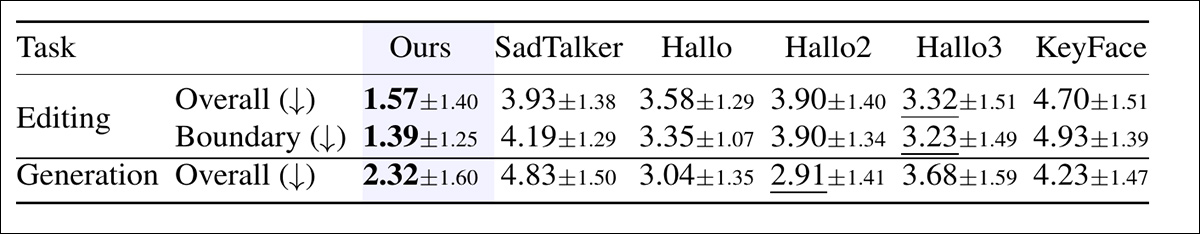

Darüber hinaus wurde eine Studie mit Probanden durchgeführt, um die wahrgenommene Qualität sowohl im Bearbeitungs- als auch im Erstellungsprozess zu bewerten.

Für jeden Vergleich sahen die Teilnehmer sechs Videos und bewerteten diese nach ihrer Gesamtqualität, wobei sie die Genauigkeit der Lippensynchronisation, die Natürlichkeit und den Realismus der Kopfbewegungen berücksichtigten. In den Bearbeitungsversuchen bewerteten die Teilnehmer außerdem die Flüssigkeit der Übergänge zwischen bearbeiteten und unbearbeiteten Abschnitten:

Die durchschnittlichen Bewertungen wurden von menschlichen Gutachtern vergeben, wobei niedrigere Werte eine bessere Bewertung bedeuten. Sowohl beim Bearbeiten als auch beim Erstellen der Videos beurteilten die Teilnehmenden, wie natürlich und synchronisiert die einzelnen Videos wirkten. Beim Bearbeiten bewerteten sie außerdem, wie flüssig der Übergang zwischen bearbeiteter und unbearbeiteter Sprache war. Fett und unterstrichen sind die beiden höchsten Bewertungen.

In der Studie wurde FacEDiT sowohl hinsichtlich der Bearbeitungsqualität als auch der nahtlosen Übergänge durchgehend mit deutlichem Abstand als Spitzenreiter eingestuft und erzielte auch im Generierungsmodus starke Ergebnisse, was darauf schließen lässt, dass sich die gemessenen Vorteile in wahrnehmungsmäßig bevorzugten Ausgaben niederschlagen.

Aus Platzgründen verweisen wir für weitere Details zu den Ablationsstudien und den zusätzlichen, in der neuen Arbeit durchgeführten und beschriebenen Tests auf die Originalpublikation. Tatsächlich fällt es solchen Forschungsarbeiten oft schwer, aussagekräftige Abschnitte mit Testergebnissen zu erstellen, da die eigentliche Forschungsarbeit selbst zwangsläufig eine potenzielle Grundlage für spätere Untersuchungen bildet.

Fazit

Selbst für die Inferenzberechnung benötigen solche Systeme unter Umständen erhebliche Rechenressourcen, was es nachgelagerten Nutzern – hier vermutlich VFX-Studios – erschwert, die Arbeit lokal durchzuführen. Daher werden Anbieter, die rechtlich verpflichtet sind, das Filmmaterial und das geistige Eigentum ihrer Kunden zu schützen, stets Ansätze bevorzugen, die sich an realistische lokale Ressourcen anpassen lassen.

Das soll keine Kritik an dem neuen Angebot sein, das unter quantisierten Gewichten oder anderen Optimierungen durchaus perfekt funktionieren mag und das das erste Angebot seiner Art ist, das mich seit geraumer Zeit wieder zu diesem Forschungsgebiet zurückgeführt hat.

Erstveröffentlichung Mittwoch, 17. Dezember 202. Überarbeitet am selben Tag um 20:10 Uhr EET, um im ersten Absatz mehr Platz zu schaffen.