Überwachung

„Degradierte“ synthetische Gesichter könnten dazu beitragen, die Erkennung von Gesichtsbildern zu verbessern

Forscher der Michigan State University haben eine Möglichkeit entwickelt, wie synthetische Gesichter eine Pause von der Deepfakes-Szene einlegen und etwas Gutes in der Welt tun können – indem sie Bilderkennungssystemen dabei helfen, genauer zu werden.

Das neue steuerbare Gesichtssynthesemodul (CFSM), das sie entwickelt haben, kann Gesichter im Stil von realen Videoüberwachungsaufnahmen regenerieren, anstatt sich auf die durchweg höherwertigen Bilder zu verlassen, die in beliebten Open-Source-Datensätzen von Prominenten verwendet werden und die nicht alle Fehler und Mängel echter CCTV-Systeme widerspiegeln, wie z. B. Gesichtsunschärfe, niedrige Auflösung und Sensorrauschen – Faktoren, die die Erkennungsgenauigkeit beeinträchtigen können.

Konzeptionelle Architektur für das Controllable Face Synthesis Module (CFSM). Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022.pdf

CFSM ist nicht speziell dazu gedacht, Kopfhaltungen, Gesichtsausdrücke oder alle anderen üblichen Merkmale, die das Ziel von Deepfake-Systemen sind, authentisch zu simulieren, sondern vielmehr eine Reihe alternativer Ansichten im Stil des Zielerkennungssystems zu generieren Stilübertragung.

Das System ist so konzipiert, dass es den Stilbereich des Zielsystems nachahmt und seine Ausgabe entsprechend der Auflösung und dem darin enthaltenen Bereich der „Exzentrizitäten“ anpasst. Der Anwendungsfall umfasst Altsysteme, die aus Kostengründen wahrscheinlich nicht aktualisiert werden, die aber aufgrund der schlechten Qualität der Ausgabe, die einst möglicherweise führend war, derzeit wenig zur neuen Generation von Gesichtserkennungstechnologien beitragen können.

Beim Testen des Systems stellten die Forscher fest, dass es gegenüber dem Stand der Technik bei Bilderkennungssystemen, die mit dieser Art von verrauschten und minderwertigen Daten umgehen müssen, deutliche Fortschritte erzielt hat.

Trainieren Sie die Gesichtserkennungsmodelle, um sie an die Einschränkungen der Zielsysteme anzupassen. Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022_supp.pdf

Darüber hinaus fanden sie ein nützliches Nebenprodukt des Prozesses: Die Zieldatensätze konnten nun charakterisiert und miteinander verglichen werden, was den Vergleich, das Benchmarking und die Generierung maßgeschneiderter Datensätze für verschiedene CCTV-Systeme in Zukunft einfacher macht.

Darüber hinaus kann die Methode auf vorhandene Datensätze angewendet werden de facto Domänenanpassung und sie besser für Gesichtserkennungssysteme geeignet zu machen.

Die neues Papier ist betitelt Kontrollierbare und gesteuerte Gesichtssynthese für uneingeschränkte Gesichtserkennung, wird teilweise vom US Office of the Director of National Intelligence (ODNI, at.) unterstützt IARPA) und stammt von vier Forschern der Abteilung Computer Science & Engineering der MSU.

Empfohlene Inhalte

Gesichtserkennung mit geringer Qualität (LQFR) ist zu einem geworden bemerkenswertes Studiengebiet in den letzten Jahren. Da die Behörden ihre Videoüberwachungssysteme so konzipiert haben, dass sie robust und langlebig sind (da sie nicht regelmäßig Ressourcen für das Problem neu verteilen wollen), sind viele „alte“ Überwachungsnetzwerke in Bezug auf ihre Anpassungsfähigkeit als Datenquellen für maschinelles Lernen Opfer technischer Schulden geworden.

Unterschiedliche Gesichtsauflösungsgrade in einer Reihe historischer und neuerer Videoüberwachungssysteme. Quelle: https://arxiv.org/pdf/1805.11519.pdf

Glücklicherweise ist dies eine Aufgabe, für deren Lösung Diffusionsmodelle und andere rauschbasierte Modelle ungewöhnlich gut geeignet sind. Viele der beliebtesten und effektivsten Bildsynthesesysteme der letzten Jahre funktionieren Upscaling von Bildern mit niedriger Auflösung als Teil ihrer Pipeline, während dies auch für neuronale Komprimierungstechniken (Methoden zum Speichern von Bildern und Filmen als neuronale Daten anstelle von Bitmap-Daten) unbedingt erforderlich ist.

Ein Teil der Herausforderung der Gesichtserkennung besteht darin, mit einer minimalen Anzahl von Gesichtserkennungen die größtmögliche Genauigkeit zu erzielen Funktionen die aus den kleinsten und am wenigsten vielversprechenden Bildern mit niedriger Auflösung extrahiert werden können. Diese Einschränkung besteht nicht nur, weil es nützlich ist, ein Gesicht bei niedriger Auflösung identifizieren (oder erstellen) zu können, sondern auch aufgrund technischer Beschränkungen hinsichtlich der Größe von Bildern, die den entstehenden latenten Raum eines Modells durchlaufen können, das im verfügbaren VRAM einer lokalen GPU trainiert wird.

In diesem Sinne ist der Begriff „Features“ verwirrend, da solche Features auch aus einem Datensatz von Parkbänken gewonnen werden können. Im Computer Vision-Bereich bezieht sich „Features“ auf die Unterscheidungsmerkmale aus Bildern gewonnen – für Bilder, seien es die Umrisse einer Kirche, eines Berges oder die Anordnung von Gesichts- Merkmale in einem Gesichtsdatensatz.

Da Computer Vision-Algorithmen mittlerweile in der Lage sind, Bilder und Videoaufnahmen hochzuskalieren, wurden verschiedene Methoden vorgeschlagen, um niedrig aufgelöstes oder anderweitig beeinträchtigtes altes Überwachungsmaterial zu „verbessern“, bis zu dem Punkt, dass es möglich sein könnte, Verwenden Sie solche Erweiterungen nicht für rechtliche Zwecke, beispielsweise die Platzierung einer bestimmten Person am Tatort im Zusammenhang mit einer Kriminalermittlung.

Abgesehen von der Möglichkeit einer Fehlidentifikation, die besteht sorgte gelegentlich für SchlagzeilenTheoretisch sollte es nicht notwendig sein, niedrigaufgelöstes Filmmaterial zu überhochauflösen oder anderweitig zu transformieren, um eine eindeutige Identifizierung einer Person vorzunehmen, da ein Gesichtserkennungssystem, das Merkmale auf niedriger Ebene eingibt, diese Auflösungsstufe nicht benötigen sollte Klarheit. Darüber hinaus sind solche Transformationen in der Praxis teuer und verursachen zusätzliche, wiederkehrende Fragen um ihre potenzielle Gültigkeit und Rechtmäßigkeit.

Der Bedarf an mehr heruntergekommenen Prominenten

Es wäre nützlicher, wenn ein Gesichtserkennungssystem Merkmale (d. h. maschinelle Lernmerkmale) ableiten könnte human Funktionen) von der Ausgabe bestehender Altsysteme unterscheiden, indem wir die Beziehung zwischen der „hochauflösenden“ Identität und den verschlechterten Bildern, die in unerbittlichen (und oft unersetzlichen) bestehenden Videoüberwachungssystemen verfügbar sind, besser verstehen.

Das Problem hier liegt in einem der Standards: gängige, im Internet gesammelte Datensätze wie z MS-Celeb-1M mit einem WebFace260M (neben mehreren anderen) gewesen eingeklinkt von der Forschungsgemeinschaft geschätzt, weil sie konsistente Benchmarks bieten, anhand derer Forscher ihre inkrementellen oder größeren Fortschritte im Vergleich zum aktuellen Stand der Technik messen können.

Beispiele aus dem beliebten MS-Celeb1m-Datensatz von Microsoft. Quelle: https://www.microsoft.com/en-us/research/project/ms-celeb-1m-challenge-recognizing-one-million-celebrities-real-world/

Die Autoren argumentieren jedoch, dass mit diesen Datensätzen trainierte Gesichtserkennungsalgorithmen (FR) für die visuellen „Domänen“ der Ausgabe vieler älterer Überwachungssysteme ungeeignet seien.

In dem Papier heißt es*:

„[State-of-the-art] (SoTA) FR-Modelle funktionieren aufgrund des Domänenverschiebungsproblems, d. h. der erhaltenen umfangreichen Trainingsdatensätze (halbbeschränkt), nicht gut auf realen Überwachungsbildern (uneingeschränkt). Über das Internet gecrawlte Gesichter von Prominenten weisen keine Variationen in freier Wildbahn auf, wie z. B. inhärentes Sensorrauschen, niedrige Auflösung, Bewegungsunschärfe, Turbulenzeffekte usw.

„Zum Beispiel die 1:1-Verifizierungsgenauigkeit, berichtet von eines der SoTA-Modelle auf uneingeschränkt IJB-S Der Datensatz ist etwa 30 % niedriger als bei halbbeschränkten Daten LFW.

„Eine mögliche Lösung für diese Leistungslücke besteht darin, einen umfangreichen, uneingeschränkten Gesichtsdatensatz zusammenzustellen. Allerdings ist die Erstellung eines solchen Trainingsdatensatzes mit Zehntausenden von Personen unerschwinglich schwierig und mit hohen manuellen Kennzeichnungskosten verbunden.“

Der Artikel beschreibt verschiedene frühere Methoden, mit denen versucht wurde, die vielfältigen Ausgabetypen historischer oder kostengünstiger Überwachungssysteme zu „erreichen“. Dabei handelte es sich jedoch um „blinde“ Erweiterungen. CFSM hingegen erhält während des Trainings direktes Feedback von der realen Ausgabe des Zielsystems und passt sich durch Stilübertragung an, um diesen Bereich nachzuahmen.

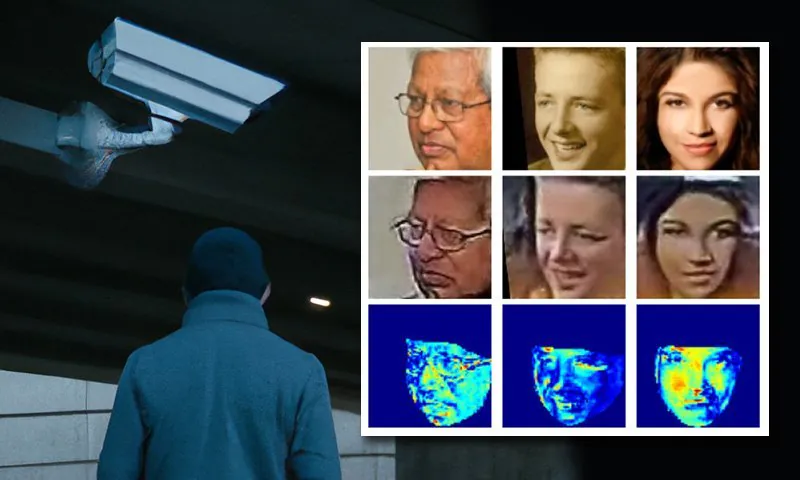

Die Schauspielerin Natalie Portman, der die Handvoll Datensätze, die die Computer-Vision-Community dominieren, nicht fremd ist, gehört zu den Identitäten in diesem Beispiel von CFSM, das eine stilangepasste Domänenanpassung basierend auf Feedback aus der Domäne des tatsächlichen Zielmodells durchführt.

Die von den Autoren entworfene Architektur nutzt die Fast Gradient Sign-Methode (FGSM), um die erhaltenen Stile und Merkmale aus der tatsächlichen Ausgabe des Zielsystems zu individualisieren und zu „importieren“. Der Teil der Pipeline, der der Bildgenerierung gewidmet ist, wird durch Training verbessert und dem Zielsystem immer ähnlicher. Dieses Feedback aus dem niedrigdimensionalen Stilraum des Zielsystems ist von Natur aus niedrigstufig und entspricht den umfassendsten abgeleiteten visuellen Deskriptoren.

Die Autoren kommentieren:

„Mit dem Feedback des FR-Modells wirken sich die synthetisierten Bilder positiv auf die FR-Leistung aus, was zu deutlich verbesserten Generalisierungsfähigkeiten der damit trainierten FR-Modelle führt.“

Tests

Die Forscher verwendeten MSUs eigene vorherige Arbeit als Vorlage zum Testen ihres Systems. Basierend auf denselben experimentellen Protokollen verwendeten sie MS-Celeb-1m, das ausschließlich aus im Internet erfassten Fotos von Prominenten besteht, als gekennzeichneten Trainingsdatensatz. Der Fairness halber wurde auch MS1M-V2 einbezogen, das 3.9 Millionen Bilder mit 85,700 Klassen enthält.

Die Zieldaten waren die WiderFace-Datensatz, von der Chinesischen Universität Hongkong. Hierbei handelt es sich um einen besonders vielfältigen Bildsatz, der für Gesichtserkennungsaufgaben in schwierigen Situationen konzipiert ist. 70,000 Bilder aus diesem Set wurden verwendet.

Zur Bewertung wurde das System anhand von vier Gesichtserkennungs-Benchmarks getestet: IJB-B, IJB-C, IJB-S und TinyFace.

CFSM wurde mit ∼10 % der Trainingsdaten von MS-Celeb-1m, etwa 0.4 Millionen Bildern, für 125,000 Iterationen bei 32 Batch-Größen unter dem Adam-Optimierer bei einer (sehr niedrigen) Lernrate von 1e-4 trainiert.

Das Zielgesichtserkennungsmodell verwendet a Modifikation von ResNet-50 für das Backbone, mit aktivierter ArcFace-Verlustfunktion während des Trainings. Zusätzlich wurde ein Modell mit CFSM als Ablations- und Vergleichsübung trainiert (in der Ergebnistabelle unten als „ArcFace“ bezeichnet).

Die Autoren kommentieren die primären Ergebnisse:

„Das ArcFace-Modell übertrifft alle Basismodelle sowohl bei der Gesichtserkennung als auch bei der Gesichtsverifizierung und erreicht eine neue SoTA-Leistung.“

Die Fähigkeit, Domänen aus den verschiedenen Merkmalen veralteter oder unzureichend spezifizierter Überwachungssysteme zu extrahieren, ermöglicht es den Autoren auch, die Verteilungsähnlichkeit zwischen diesen Frameworks zu vergleichen und zu bewerten und jedes System in einem visuellen Stil darzustellen, der in späteren Arbeiten genutzt werden könnte .

Die Autoren weisen außerdem darauf hin, dass ihr System einige Technologien sinnvoll nutzen könnte, die bisher lediglich als Probleme angesehen wurden, die von der Forschungs- und Visionsgemeinschaft gelöst werden müssen:

„[CFSM] zeigt, dass gegnerische Manipulation über die Rolle eines Angreifers hinausgehen und dazu dienen kann, die Erkennungsgenauigkeit bei Sehaufgaben zu erhöhen.“ In der Zwischenzeit definieren wir eine Datensatz-Ähnlichkeitsmetrik basierend auf den erlernten Stilgrundlagen, die die Stilunterschiede auf label- oder prädiktorunabhängige Weise erfasst.

„Wir glauben, dass unsere Forschung die Leistungsfähigkeit eines kontrollierbaren und geführten Gesichtssynthesemodells für uneingeschränkte FR demonstriert und ein Verständnis der Unterschiede zwischen Datensätzen ermöglicht.“

* Meine Konvertierung der Inline-Zitate der Autoren in Hyperlinks.

Erstveröffentlichung am 1. August 2022.