Künstliche Intelligenz

Durch Nutzung menschlicher Aufmerksamkeit lassen sich KI-generierte Bilder verbessern

Neue Forschungsergebnisse aus China haben eine Methode zur Verbesserung der Bildqualität vorgeschlagen, die durch Latente Diffusionsmodelle (LDMs)-Modelle wie stabile Diffusion.

Die Methode konzentriert sich auf die Optimierung der hervorstechende Regionen eines Bildes – Bereiche, die am wahrscheinlichsten die Aufmerksamkeit des Menschen auf sich ziehen.

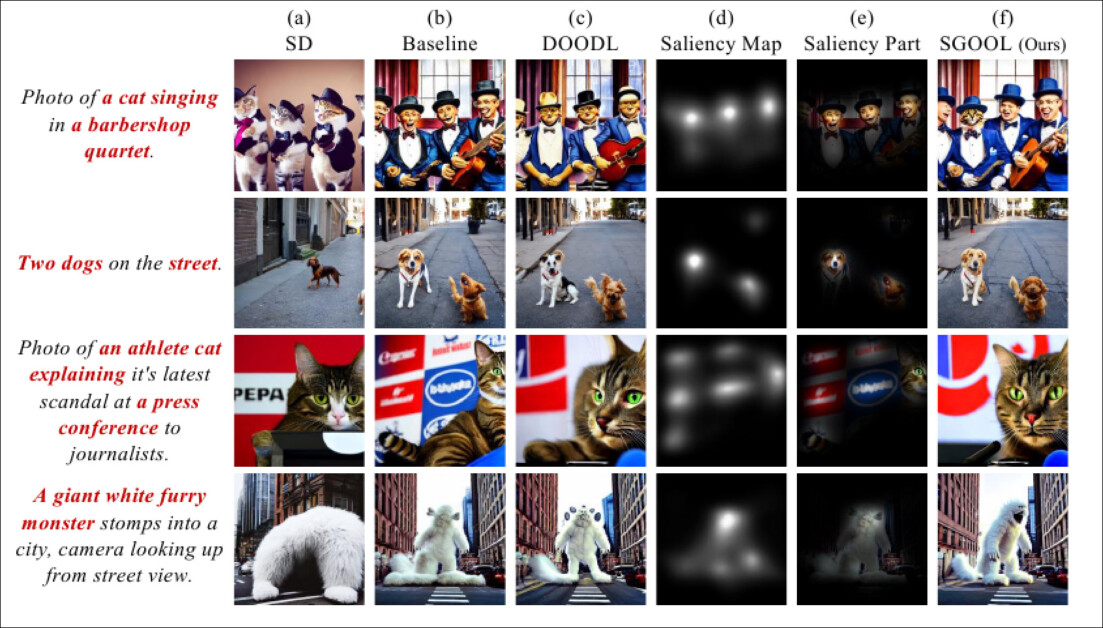

Die neue Forschung hat ergeben, dass Salienzkarten (vierte Spalte von links) als Filter oder „Maske“ verwendet werden können, um den Aufmerksamkeitsschwerpunkt bei Rauschunterdrückungsprozessen auf die Bereiche des Bildes zu lenken, denen der Mensch am ehesten Aufmerksamkeit schenkt. Quelle: https://arxiv.org/pdf/2410.10257

Traditionelle Methoden optimieren die ganzes Bild gleichmäßig, während der neue Ansatz einen Salienzdetektor nutzt, um „wichtigere“ Regionen zu identifizieren und zu priorisieren, wie es Menschen tun.

In quantitativen und qualitativen Tests konnte die Methode der Forscher frühere diffusionsbasierte Modelle sowohl hinsichtlich der Bildqualität als auch der Genauigkeit der Textanweisungen übertreffen.

Auch in einem Wahrnehmungstest mit 100 Teilnehmern schnitt der neue Ansatz am besten ab.

Natürliche Auslese

Salienz, die Fähigkeit, Informationen in der realen Welt und in Bildern zu priorisieren, ist eine wesentlicher Bestandteil des menschlichen Sehens.

Ein einfaches Beispiel hierfür ist die erhöhte Aufmerksamkeit, die die klassische Kunst wichtigen Bereichen eines Gemäldes widmet, wie etwa dem Gesicht bei einem Porträt oder den Masten eines Schiffes bei einem maritimen Motiv. In solchen Beispielen konzentriert sich die Aufmerksamkeit des Künstlers auf das zentrale Thema, was bedeutet, dass allgemeine Details wie der Hintergrund eines Porträts oder die fernen Wellen eines Sturms eher skizzenhaft und allgemeiner dargestellt werden als detailliert.

Auf Grundlage von Studien an Menschen sind im letzten Jahrzehnt Methoden des maschinellen Lernens entstanden, die diesen menschlichen Interessenschwerpunkt in jedem Bild nachbilden oder zumindest annähernd darstellen können.

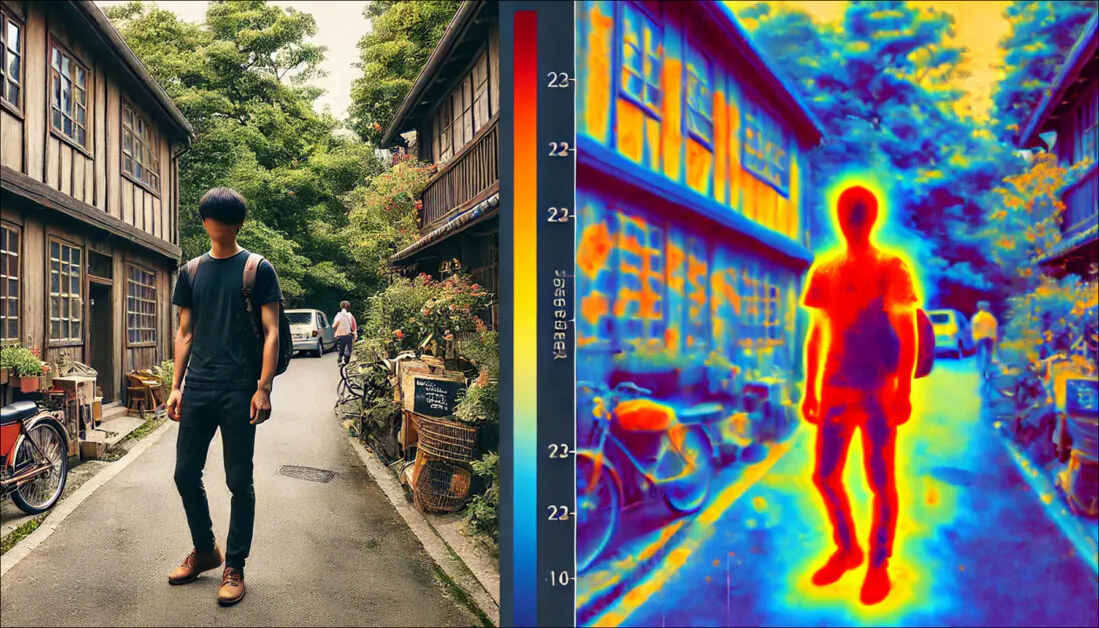

Die Objektsegmentierung (semantische Segmentierung) kann dabei helfen, Facetten eines Bildes zu individualisieren und entsprechende Salienzkarten zu entwickeln. Quelle: https://arxiv.org/pdf/1312.6034

In der Forschungsliteratur ist der beliebteste Salienzkartendetektor der letzten fünf Jahre der 2016 Gradientengewichtete Klassenaktivierungszuordnung (Grad-CAM) Initiative, die später zur verbesserten Grad-CAM++ System, neben anderen Varianten und Verfeinerungen.

Grad-CAM verwendet die Gradientenaktivierung eines semantischen Tokens (wie etwa „Hund“ oder „Katze“), um eine visuelle Karte zu erstellen, die zeigt, wo das Konzept oder die Anmerkung wahrscheinlich im Bild dargestellt wird.

Beispiele aus dem ursprünglichen Grad-CAM-Artikel. In der zweiten Spalte individualisiert die geführte Backpropagation alle beitragenden Merkmale. In der dritten Spalte werden die semantischen Karten für die beiden Konzepte „Hund“ und „Katze“ gezeichnet. Die vierte Spalte stellt die Verkettung der beiden vorherigen Schlussfolgerungen dar. Die fünfte Spalte stellt die Okklusionskarte (Maskierungskarte) dar, die der Schlussfolgerung entspricht; und schließlich visualisiert Grad-CAM in der sechsten Spalte eine ResNet-18-Schicht. Quelle: https://arxiv.org/pdf/1610.02391

Untersuchungen an Menschen zu den mit diesen Methoden erzielten Ergebnissen haben eine Übereinstimmung zwischen dieser mathematischen Individuation wichtiger Punkte in einem Bild und der menschlichen Aufmerksamkeit (beim Scannen des Bildes) ergeben.

SGOOL

Die neues Papier überlegt, welchen Nutzen Salienz für Text-zu-Bild-Systeme (und möglicherweise auch Text-zu-Video-Systeme) wie Stable Diffusion und Flux haben kann.

Bei der Interpretation der Texteingabe eines Benutzers untersuchen Latent Diffusion Models ihre trainierten latenter Raum für erlernte visuelle Konzepte, die den verwendeten Wörtern oder Phrasen entsprechen. Anschließend analysieren sie diese gefundenen Datenpunkte durch ein Entrauschen Prozess, bei dem zufälliges Rauschen schrittweise zu einer kreativen Interpretation der Textaufforderung des Benutzers weiterentwickelt wird.

An diesem Punkt gibt das Modell jedoch gleiche Aufmerksamkeit für jeden einzelnen Teil des Bildes. Seit der Popularisierung von Diffusionsmodellen im Jahr 2022, mit der Einführung von OpenAIs verfügbarem Platte Bildgeneratoren und der anschließenden Open-Source-Veröffentlichung des Stable Diffusion-Frameworks von Stability.ai haben Benutzer festgestellt, dass „wesentliche“ Abschnitte eines Bildes oft nicht ausreichend abgedeckt sind.

Wenn man bedenkt, dass in einer typischen Darstellung eines Menschen das Gesicht der Person (das von größte Bedeutung Obwohl das Objekt (für den Betrachter) wahrscheinlich nicht mehr als 10 bis 35 % des gesamten Bildes einnimmt, widerspricht diese demokratische Methode der Aufmerksamkeitsstreuung sowohl der Natur der menschlichen Wahrnehmung als auch der Geschichte der Kunst und Fotografie.

Wenn die Knöpfe einer Jeans einer Person die gleiche Rechenlast tragen wie ihre Augen, könnte man sagen, dass die Ressourcenverteilung nicht optimal ist.

Daher wurde von den Autoren eine neue Methode vorgeschlagen, die den Titel trägt: Salienzgesteuerte Optimierung latenter Diffusionsstoffe (SGOOL) verwendet einen Salienz-Mapper, um die Aufmerksamkeit auf vernachlässigte Bereiche eines Bildes zu lenken und weniger Ressourcen auf Abschnitte zu verwenden, die wahrscheinlich am Rand der Aufmerksamkeit des Betrachters bleiben.

Methodik

Die SGOOL-Pipeline umfasst die Bilderzeugung, die Salienzzuordnung und die Optimierung, wobei das Gesamtbild und das hinsichtlich der Salienz verfeinerte Bild gemeinsam verarbeitet werden.

Konzeptionelles Schema für SGOOL.

Die latenten Einbettungen des Diffusionsmodells werden direkt optimiert mit Feintuning, wodurch die Notwendigkeit entfällt, ein bestimmtes Modell zu trainieren. Die Stanford University Rauschunterdrückung durch implizites Diffusionsmodell (DDIM)-Sampling-Methode, die Benutzern von Stable Diffusion vertraut ist, wird angepasst, um die sekundären Informationen zu integrieren, die von Salienzkarten bereitgestellt werden.

Das Papier sagt:

„Wir verwenden zunächst einen Salienzdetektor, um das menschliche visuelle Aufmerksamkeitssystem nachzuahmen und die auffälligen Bereiche zu markieren. Um das erneute Trainieren eines zusätzlichen Modells zu vermeiden, optimiert unsere Methode die Diffusionslatenzen direkt.

„SGOOL nutzt außerdem einen invertierbaren Diffusionsprozess und bietet die Vorteile einer konstanten Speicherimplementierung. Dadurch wird unsere Methode zu einer parametereffizienten und sofort einsatzbereiten Feinabstimmungsmethode. Es wurden umfangreiche Experimente mit verschiedenen Metriken und menschlicher Bewertung durchgeführt.“

Da diese Methode mehrere Iterationen des Entrauschungsprozesses erfordert, haben die Autoren die Direkte Optimierung von Diffusionslatenzen (DOODL) Framework, das eine invertierbare Diffusion Prozess – lenkt die Aufmerksamkeit jedoch immer noch auf das Gesamtbild.

Um Bereiche von menschlichem Interesse zu definieren, nutzten die Forscher die 2022 TransalNet-Framework.

Beispiele für Salienzerkennung aus dem TransalNet-Projekt 2022. Quelle: https://discovery.dundee.ac.uk/ws/portalfiles/portal/89737376/1_s2.0_S0925231222004714_main.pdf

Die von TransalNet verarbeiteten markanten Bereiche wurden dann zugeschnitten, um schlüssige Salienzabschnitte zu erzeugen, die für tatsächliche Menschen wahrscheinlich am interessantesten sind.

Der Unterschied zwischen dem Benutzertext und dem Bild muss bei der Definition eines verlustfunktion die feststellen kann, ob der Prozess funktioniert. Dazu wird eine Version von OpenAIs Kontrastive Sprache - Bildvorbereitung (CLIP) – mittlerweile eine tragende Säule der Bildsyntheseforschung – wurde verwendet, zusammen mit der Berücksichtigung der geschätzten semantische Distanz zwischen der Textaufforderung und der globalen (nicht auffälligen) Bildausgabe.

Die Autoren behaupten:

„[Die] endgültige Verlust[funktion] berücksichtigt gleichzeitig die Beziehungen zwischen auffälligen Teilen und dem Gesamtbild, was dabei hilft, lokale Details und globale Konsistenz im Generierungsprozess auszugleichen.“

„Dieser Salienz-bewusste Verlust wird genutzt, um die Bildlatenz zu optimieren. Die Gradienten werden auf der Grundlage des verrauschten [Latents] berechnet und genutzt, um den Konditionierungseffekt der Eingabeaufforderung sowohl auf markante als auch auf globale Aspekte des ursprünglich generierten Bildes zu verbessern.“

Daten und Tests

Zum Testen von SGOOL verwendeten die Autoren eine „Vanilla“-Verteilung von Stable Diffusion V1.4 (in den Testergebnissen als „SD“ bezeichnet) und Stable Diffusion mit CLIP-Anleitung (in den Ergebnissen als „Baseline“ bezeichnet).

Das System wurde anhand von drei öffentlichen Datensätzen evaluiert: Gemeinsame syntaktische Prozesse (CPS), DrawBank, und DailyDallE*.

Letzteres enthält 99 ausführliche Eingabeaufforderungen eines Künstlers, der in einem der Blogbeiträge von OpenAI vorgestellt wurde, während DrawBench 200 Eingabeaufforderungen in 11 Kategorien bietet. CSP besteht aus 52 Eingabeaufforderungen, die auf acht verschiedenen grammatikalischen Fällen basieren.

Für SD, Baseline und SGOOL wurde in den Tests das CLIP-Modell verwendet ViT/B-32 um die Bild- und Texteinbettungen zu generieren. Die gleiche Eingabeaufforderung und zufälliger Samen wurde verwendet. Die Ausgabegröße betrug 256×256 und es wurden die Standardgewichte und -einstellungen von TransalNet verwendet.

Neben dem CLIP-Score-Wert wird eine geschätzte Menschlicher Präferenzwert (HPS) wurde zusätzlich zu einer Realweltstudie mit 100 Teilnehmern verwendet.

Quantitative Ergebnisse durch Vergleich von SGOOL mit früheren Konfigurationen.

In Bezug auf die in der obigen Tabelle dargestellten quantitativen Ergebnisse heißt es in dem Dokument:

„[Unser] Modell übertrifft SD und Baseline in allen Datensätzen sowohl beim CLIP-Score als auch bei den HPS-Metriken deutlich. Die durchschnittlichen Ergebnisse unseres Modells beim CLIP-Score und HPS liegen 3.05 bzw. 0.0029 über dem Zweitplatzierten.“

Die Autoren schätzten außerdem die Boxplots der HPS- und CLIP-Werte im Hinblick auf die vorherigen Ansätze:

Boxplots für die in den Tests erzielten HPS- und CLIP-Werte.

Sie kommentieren:

„Man kann erkennen, dass unser Modell die anderen Modelle übertrifft, was darauf hindeutet, dass unser Modell besser in der Lage ist, Bilder zu erzeugen, die mit den Eingabeaufforderungen übereinstimmen.

„Im Boxplot ist es jedoch aufgrund der Größe dieser Bewertungsmetrik bei [0, 1] nicht einfach, den Vergleich aus dem Boxplot zu visualisieren. Daher zeichnen wir die entsprechenden Balkendiagramme.

„Es ist ersichtlich, dass SGOOL SD und Baseline bei allen Datensätzen sowohl beim CLIP-Score als auch bei den HPS-Metriken übertrifft. Die quantitativen Ergebnisse zeigen, dass unser Modell semantisch konsistentere und vom Menschen bevorzugte Bilder generieren kann.“

Die Forscher weisen darauf hin, dass das Basismodell zwar die Qualität der Bildausgabe verbessern kann, aber die hervorstechenden Bereiche des Bildes nicht berücksichtigt. Sie behaupten, dass SGOOL, indem es einen Kompromiss zwischen globaler und hervorstechender Bildauswertung erreicht, bessere Bilder erzielt.

Bei qualitativen (automatisierten) Vergleichen wurde die Anzahl der Optimierungen für SGOOL und DOODL auf 50 festgelegt.

Qualitative Ergebnisse für die Tests. Für eine bessere Definition siehe das Quelldokument.

Hier stellen die Autoren fest:

„In der [ersten Reihe] sind die Themen der Aufforderung „eine singende Katze“ und „ein Barbershop-Quartett“. In dem von SD generierten Bild sind vier Katzen zu sehen, und der Inhalt des Bildes ist schlecht auf die Aufforderung abgestimmt.

„Die Katze wird im von Baseline generierten Bild ignoriert und es mangelt an Details in der Darstellung des Gesichts und den Details im Bild. DOODL versucht, ein Bild zu generieren, das mit der Eingabeaufforderung übereinstimmt.

„Da DOODL jedoch das Gesamtbild direkt optimiert, werden die Personen im Bild auf die Katze hin optimiert.“

Sie weisen außerdem darauf hin, dass SGOOL im Gegensatz dazu Bilder generiert, die eher mit der ursprünglichen Eingabeaufforderung übereinstimmen.

Im menschlichen Wahrnehmungstest beurteilten 100 Freiwillige Testbilder auf Qualität und semantische Konsistenz (also wie genau sie den Vorgaben des Ausgangstextes entsprachen). Die Teilnehmer hatten unbegrenzt Zeit, ihre Auswahl zu treffen.

Ergebnisse des menschlichen Wahrnehmungstests.

Wie in dem Artikel hervorgehoben wird, ist die Methode der Autoren den früheren Ansätzen deutlich vorzuziehen.

Fazit

Nicht lange nachdem die in diesem Papier angesprochenen Mängel bei lokalen Installationen der stabilen Diffusion offensichtlich wurden, wurden verschiedene maßgeschneiderte Methoden (wie Nach dem Detailer) wurde entwickelt, um das System zu zwingen, den Bereichen, die für den Menschen von größerem Interesse sind, besondere Aufmerksamkeit zu widmen.

Bei einem solchen Ansatz muss das Diffusionssystem jedoch zunächst seinen normalen Prozess durchlaufen, bei dem jedem Teil des Bildes die gleiche Aufmerksamkeit gewidmet wird, wobei der zusätzliche Aufwand in einem zusätzlichen Schritt erfolgt.

Die Erkenntnisse von SGOOL deuten darauf hin, dass die Anwendung grundlegender menschlicher Psychologie auf die Priorisierung von Bildabschnitten die anfängliche Schlussfolgerung ohne Nachbearbeitungsschritte erheblich verbessern könnte.

* Das Dokument bietet hierfür denselben Link wie für CommonSyntacticProcesses.

Erstveröffentlichung Mittwoch, 16. Oktober 2024