Artificial Intelligence

AI聊天模型可能因无休止的漫谈而推高成本

流行的AI聊天模型会秘密地在无意义的冗词上浪费大量付费令牌。受影响的模型实际上知道自己在这样做,但却无法停止。

大型推理模型(LRMs),如ChatGPT-5和Google Gemini,对推理——即逐步解决问题——收取更高费用,因为这比仅仅快速预测下一个词需要显著更多的计算能力。模拟推理过程耗时更长,运行成本更高;因此,用户最终需要为那“额外的思考时间”付费。

然而,如果您最近使用过最先进的大型语言模型,您可能已经注意到,您的令牌配额常常花费在冗词和废话上,而不是专注于解决您向模型提出的问题。这可能表现为过度的奉承、冗长和/或冗余的回答——甚至是一种“漫谈”,就好像AI被当场抓住,正试图用喋喋不休来摆脱尴尬的处境。

当然,我们更希望我们的大型语言模型能够承认失败、遵循或提供替代路径,或者请求澄清。但即使让这类AI承认自己不知道答案,本身就是一个相当大的挑战。

与此同时,使用较低或免费层级的用户可能会发现自己的令牌消耗得很快,无论他们的查询和互动多么有针对性或经济,因为AI本身喜欢说话;而在这里,说话并不便宜。

词语沙拉

关于上述的“漫谈”,一项新的学术合作提出了一个理由和解决方案,认为具有推理能力的大型语言模型容易在陷入“词语沙拉”循环时耗尽您的令牌——这是一种困惑状态,推理过程迷失在递归的死胡同中——而费用由您承担*。

这项新论文的研究人员发现,典型大型语言模型处理的令牌中有很大一部分是重复和冗余内容——而且模型本身似乎明白自己遇到了麻烦,尽管它无法停止这个昂贵的循环。

论文指出:

“我们证明,这些令牌中有很大一部分是无用的自我重复——我们称之为‘词语沙拉’——它们耗尽了解码预算却没有增加价值。有趣的是,我们观察到,当LRMs陷入这些循环时,它们具有自我意识:每个推理块后面的<nn>令牌的隐藏状态表现出某种模式,使我们能够通过单层线性分类器实时检测词语沙拉行为。

“一旦检测到,一个简单的截断加上直接的重新生成提示,就能在质量损失最小的情况下实现显著的长度节省。”

这项新工作提供的解决方案是一种干预措施,可以实时切断出错推理大型语言模型的螺旋式过程,无需包含在训练数据中,也避免了微调可能带来的任何损害。该框架名为WordSaladChopper,已在GitHub上公开发布。

尽管最初的工作集中于DeepSeek变体,如Qwen和Llama系列中的模型,但论文断言,这种不受欢迎的行为很可能适用于更广泛采用类似架构的推理模型(包括流行的仅API产品,如ChatGPT和Google Gemini)。

正如论文所指出的,之前的成果,如Demystifying Long Chain-of-Thought Reasoning in LLMs和Small Models Struggle to Learn from Strong Reasoners 同样利用少数公开可用的思维链(CoT)推理模型来确立这类模型中更广泛的问题†:

“[LRMs]倾向于浪费大量的解码预算,仅仅是通过逐字重复自己、略有变化,或者进行无休止的案例枚举,直到所有预算都被[消耗]——我们将这种行为称为词语沙拉,这个术语常用来嘲笑公共发言人的冗长、充满行话的回答,这些回答最终缺乏实质内容或清晰含义。

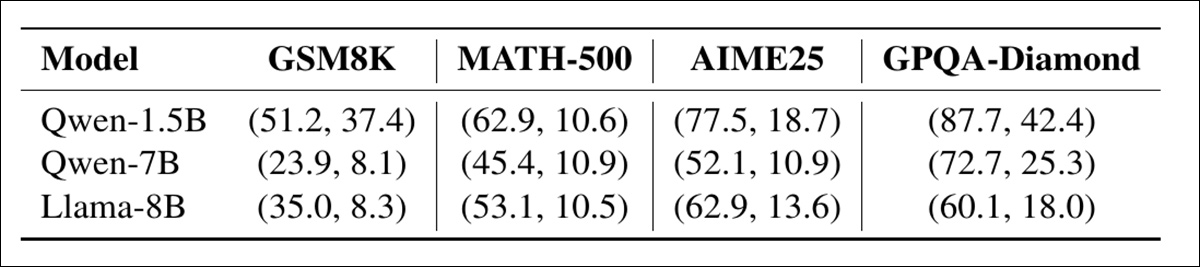

“[下表]中的‘原始’列显示,在回答GPQA-Diamond时,我们观察到DeepSeek-R1-Distill模型生成的令牌中有55%以上被标记为‘词语沙拉’。” 在回答GPQA-Diamond问题时被识别为语义冗余的输出令牌比例。作者证实,WordSaladChopper将所有测试的DeepSeek-R1-Distill模型的这种开销从超过55%降低到不足6%。 来源![The share of output tokens identified as semantically redundant when answering GPQA-Diamond. WordSaladChopper reduces this overhead from over 55% to under 6% across all tested DeepSeek-R1-Distill models, the authors attest. [ Source ] https://arxiv.org/pdf/2511.00536](https://www.unite.ai/wp-content/uploads/2025/11/table-1.jpg)

‘鉴于其开销低、节省显著,以及词语沙拉令牌缺乏语义价值,我们认为,[Word Salad Chopper]——或类似的组件——是所有注重用户体验的LRM应用程序的必备项,这一论点并非牵强 ‘

这篇新论文题为Word Salad Chopper: Reasoning Models Waste A Ton Of Decoding Budget On Useless Repetitions, Self-Knowingly,作者是来自明尼苏达大学、莱斯大学、史蒂文斯理工学院和Lambda公司的六位研究人员。

先前考量

为了追踪推理LLM自我重复的倾向,作者在模型输出中出现双换行符的地方将其分割成块,然后检查每个块与先前块的相似程度:

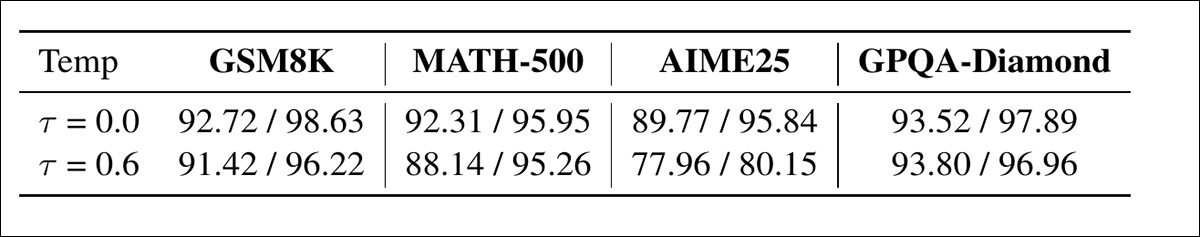

在两种解码温度(τ = 0.0, 0.6)下被标记为词语沙拉的推理块估计比例。当某个块与模型输出的早期部分高度相似时,分类器会将其标记为“词语沙拉”,这表明是重复而非进展。结果显示,这种行为在数据集和模型规模中普遍存在。

如果一个块过于相似,它就会被标记为“词语沙拉”(本质上是无用的重复)。

研究人员指出,一旦模型进入“词语沙拉”模式,如果没有外部帮助,它几乎不可能自行摆脱,而是会停留在这种昂贵的循环中,直到用户的解码预算耗尽††:

‘不用说,这对用户来说是一个灾难性的问题,因为原本理想中应该短得多的思考部分现在被无用的重复填满了最大值。因此,用户实质上是在为(很可能)错误的答案支付最高成本,同时忍受最长的端到端延迟。’

在切分点(即重复输出开始占主导的时刻)前后出现的词语沙拉块的比例。大多数重复发生在此点之后,表明一旦模型进入词语沙拉循环,若无干预,很少能恢复。

作者叙述了他们的惊讶,当他们发现推理LLM†††表现出意识到自身处于词语沙拉状态的迹象。然而,正是这种意识,以及它进入模型可能推理状态的方式,为干预系统提供了可能:

‘这种线性分类器的轻量性为实时检测打开了大门,我们可以通过不同的操作有效干预陷入词语沙拉循环的模型。

方法

为了在推理过程中检测词沙拉的存在,作者训练了一个简单的线性分类器,该分类器在每个双换行符标记的隐藏状态上运行。

模型进入重复循环后产生的任何文本块都被视为词沙拉,并使用这个截止点(称为截断点)来标记训练数据。使用S1基准生成了一千条推理轨迹,每条轨迹被分割成以换行符分隔的文本块。

WordSaladChopper的概念示意图。在生成过程中,分析每个双换行符标记处的隐藏状态以检测重复片段。一旦连续标记出两个’词沙拉’文本块,生成即被停止。随后附加一个固定的重新生成提示,使模型能够继续并完成其答案,而不会超出预算。

如果一个文本块被发现与之前的某个文本块高度相似,它就被标记为词沙拉。一旦识别出最早持续出现的重复,所有后续文本块也被标记为词沙拉,以反映这些循环的持续性。

该分类器被实现为一个单一的全连接层,并在最终Transformer块的尾部标记的隐藏状态上进行训练。为每个模型使用这些数据训练了一个单独的分类器,在评估期间没有进行微调。

数据与测试

训练和推理使用了四块NVIDIA A100(80G显存)GPU,采用Adam优化器,学习率为1×10-2,训练了50个周期。

评估数据集包括’Grade School Math’ 8000,即GSM8K;MATH-500;GPQA-DIAMOND;以及AIME25 (2025)。

测试的模型包括DeepSeek-R1-Distill-Qwen-1.5B;DeepSeek-R1-Distill-Qwen-7B;以及DeepSeek-R1-Distill-Llama-8B,均采用MIT许可证。

词沙拉分类器在Qwen‑7B模型上,在四个基准测试和两种解码温度下的准确率和AUROC。高分证实了可以从尾部换行符标记的隐藏状态可靠地检测到重复的开始。

对于此处展示的结果,作者评论道:

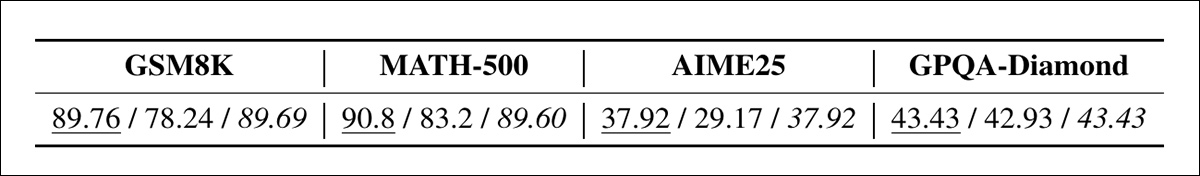

‘[上方的结果表]显示线性分类器在检测词沙拉文本块方面极其准确;然而[下方的结果表]表明,重新生成提示有助于恢复因暴力截断而损失的任务准确率。’

Qwen-7B在τ = 0.6时,在每个基准测试上的准确率,比较了出现词沙拉之前(原始)、截断后(截断)以及应用重新生成后(重新生成)的性能。重新生成带来的提升虽然不大但保持一致,在大多数情况下恢复了循环前的性能。

在下面的结果表中,我们可以看到WordSaladChopper提高或保持了准确率,同时大幅减少了模型输出的长度,降幅高达57%:

当WordSaladChopper在贪婪解码(τ = 0)下使用时,它减少了模型输出的长度,有时减少超过一半,同时保持准确率不变或略有提高,这一表现