Künstliche Intelligenz

Trennung „verschmelzter“ Menschen in der Computer Vision

Ein neues Dokument des Hyundai Motor Group Innovation Center in Singapur bietet eine Methode zur Trennung „verschmolzener“ Menschen in der Computervision – also in Fällen, in denen das Objekterkennungsframework einen Menschen gefunden hat, der einem anderen Menschen in irgendeiner Weise „zu nahe“ steht (etwa durch „Umarmungs“-Aktionen oder „Hinterherstehen“-Posen) und nicht in der Lage ist, die beiden dargestellten Personen zu trennen, sodass sie für eine einzelne Person oder Entität gehalten werden.

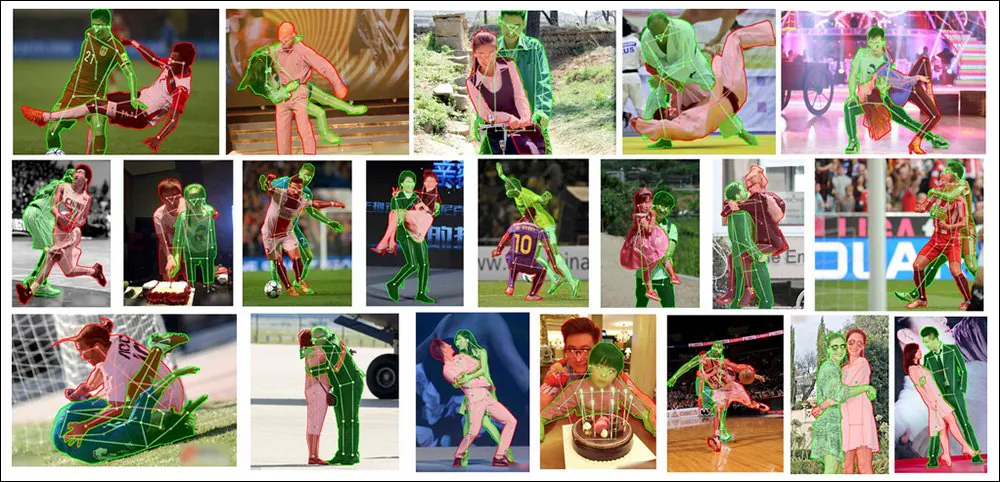

Aus zwei mach eins, aber das ist bei der semantischen Segmentierung nicht gut. Hier sehen wir, wie das neue System der Zeitung hochmoderne Ergebnisse bei der Individualisierung miteinander verflochtener Personen in komplexen und anspruchsvollen Bildern erzielt. Quelle: https://arxiv.org/pdf/2210.03686.pdf

Dies ist ein bemerkenswertes Problem, das in den letzten Jahren in der Forschungsgemeinschaft große Aufmerksamkeit erregt hat. Die Lösung dieses Problems ohne die offensichtlichen, aber normalerweise unerschwinglichen Kosten einer hyperskalierten, vom Menschen gesteuerten benutzerdefinierten Etikettierung könnte letztendlich Verbesserungen bei der menschlichen Individualisierung in Text-zu-Bild-Systemen ermöglichen, z Stable Diffusion , die Menschen häufig miteinander „verschmelzen“, wenn eine vorgegebene Pose erfordert, dass sich mehrere Personen in unmittelbarer Nähe zueinander befinden.

Umarmen Sie den Horror – Text-zu-Bild-Modelle wie DALL-E 2 und Stable Diffusion (beide oben vorgestellt) haben Schwierigkeiten, Menschen in unmittelbarer Nähe zueinander darzustellen.

Obwohl generative Modelle wie DALL-E 2 und Stable Diffusion (soweit bekannt, im Fall des Closed-Source-Modells DALL-E 2) derzeit ohnehin keine semantische Segmentierung oder Objekterkennung verwenden, könnten diese grotesken menschlichen Kofferwörter derzeit nicht durch die Anwendung solcher vorgelagerten Methoden geheilt werden – denn die modernen Objekterkennungsbibliotheken und -ressourcen sind nicht viel besser darin, Menschen zu entwirren als die CLIP-basierte Arbeitsabläufe latenter Diffusionsmodelle.

Um dieses Problem zu lösen, die neues Papier – betitelt Menschen müssen nicht noch mehr Menschen kennzeichnen: Occlusion Copy & Paste für die Segmentierung okkludierter menschlicher Instanzen– passt einen aktuellen „Copy-and-Paste“-Ansatz für semisynthetische Daten an und verbessert ihn, um selbst bei anspruchsvollstem Quellmaterial einen neuen SOTA-Vorsprung bei dieser Aufgabe zu erzielen:

Die neue Occlusion Copy & Paste-Methodik ist derzeit führend, selbst im Vergleich zu früheren Frameworks und Ansätzen, die die Herausforderung auf aufwändigere und gezieltere Weise angehen, wie beispielsweise die spezifische Modellierung für Okklusion.

Hören Sie damit auf!

Die geänderte Methode – betitelt Okklusion kopieren und einfügen – ist aus dem Jahr 2021 abgeleitet Einfaches Kopieren und Einfügen Von Google Research geleitetes Papier, in dem darauf hingewiesen wurde, dass die Überlagerung extrahierter Objekte und Personen zwischen Trainingsbildern verschiedener Quellen die Fähigkeit eines Bilderkennungssystems verbessern könnte, jede in einem Bild gefundene Instanz zu diskretisieren:

Aus dem von Google Research geleiteten Artikel „Simple Copy-Paste is a Strong Data Augmentation Method for Instance Segmentation“ aus dem Jahr 2021 geht hervor, dass Elemente von einem Foto in andere Fotos „migrieren“, mit dem Ziel, ein besseres Bilderkennungsmodell zu trainieren. Quelle: https://arxiv.org/pdf/2012.07177.pdf

Die neue Version fügt diesem automatisierten und algorithmischen „Neueinfügen“ Einschränkungen und Parameter hinzu und vergleicht den Prozess mit einem „Korb“ von Bildern voller potenzieller Kandidaten für die „Übertragung“ auf andere Bilder, basierend auf mehreren Schlüsselfaktoren.

Der konzeptionelle Workflow für OC&P.

Beherrschung der Elemente

Zu diesen begrenzenden Faktoren gehören: Wahrscheinlichkeit eines Ausschneidens und Einfügens, wodurch sichergestellt wird, dass der Prozess nicht ständig stattfindet, was zu einem Sättigungseffekt führen würde, der die Datenerweiterung untergraben würde; die Anzahl der Bilder die ein Korb zu einem bestimmten Zeitpunkt haben wird, wobei eine größere Anzahl von „Segmenten“ die Vielfalt der Instanzen verbessern kann, aber die Vorverarbeitungszeit verlängert; und Angebot, wodurch die Anzahl der Bilder bestimmt wird, die in ein „Host“-Bild eingefügt werden.

Zu Letzterem wird im Papier vermerkt „Es muss genügend Okklusion geben, aber nicht zu viel, da das Bild sonst überladen werden könnte, was sich nachteilig auf das Lernen auswirken könnte.“

Die anderen beiden Neuerungen für OC&P sind gezieltes Einfügen und Erweitertes Einfügen von Instanzen.

Durch gezieltes Einfügen wird sichergestellt, dass ein passendes Bild in der Nähe einer vorhandenen Instanz im Zielbild landet. Beim vorherigen Ansatz aus der vorherigen Arbeit war das neue Element nur auf die Grenzen des Bildes beschränkt, ohne jegliche Berücksichtigung des Kontexts.

Obwohl dieses gezielte Einfügen für das menschliche Auge offensichtlich ist, haben sowohl OC&P als auch sein Vorgänger festgestellt, dass eine erhöhte visuelle Authentizität nicht unbedingt wichtig ist und sogar ein Nachteil sein kann (siehe „Reality Bites“ weiter unten).

Das erweiterte Einfügen von Instanzen stellt hingegen sicher, dass die eingefügten Instanzen kein „unverwechselbares Aussehen“ aufweisen, das vom System klassifiziert werden könnte, was zu Ausschluss oder „Sonderbehandlung“ führen könnte, was die Generalisierung und Anwendbarkeit behindern könnte. Das erweiterte Einfügen moduliert visuelle Faktoren wie Helligkeit und Schärfe, Skalierung und Drehung sowie Sättigung – unter anderem.

Aus den ergänzenden Materialien für das neue Papier: Das Hinzufügen von OC&P zu bestehenden Erkennungsrahmen ist ziemlich trivial und führt zu einer besseren Individualisierung von Menschen auf engstem Raum. Quelle: https://arxiv.org/src/2210.03686v1/anc/OcclusionCopyPaste_Supplementary.pdf

Darüber hinaus regelt OC&P a Mindestgröße für jede eingefügte Instanz. Beispielsweise könnte es möglich sein, ein Bild einer Person aus einer riesigen Menschenmenge zu extrahieren, das in ein anderes Bild eingefügt werden könnte – aber in einem solchen Fall würde die geringe Anzahl der beteiligten Pixel die Erkennung wahrscheinlich nicht erleichtern. Daher wendet das System einen Mindestmaßstab an, der auf dem Verhältnis der ausgeglichenen Seitenlänge für das Zielbild basiert.

Darüber hinaus führt OC&P das maßstabsbezogene Einfügen ein, bei dem nicht nur nach ähnlichen Motiven wie beim Einfügemotiv gesucht wird, sondern auch die Größe der Begrenzungsrahmen im Zielbild berücksichtigt wird. Dies führt jedoch nicht zu zusammengesetzten Bildern, die Menschen für plausibel oder realistisch halten würden (siehe Bild unten), sondern vielmehr dazu, semantisch passende Elemente nahe beieinander auf eine Weise zusammenzustellen, die beim Training hilfreich ist.

Reality Bites

Sowohl die bisherige Arbeit, auf der OC&P basiert, als auch die aktuelle Umsetzung legen keinen Wert auf Authentizität oder die „Fotorealität“ eines endgültigen „montierten“ Bildes. Es ist jedoch wichtig, dass die Endmontage nicht völlig in Dadaismus (sonst könnten die trainierten Systeme bei ihren Einsätzen in der realen Welt nie auf Elemente in solchen Szenen stoßen, auf die sie trainiert wurden), haben beide Initiativen herausgefunden, dass eine deutliche Steigerung der „visuellen Glaubwürdigkeit“ nicht nur die Vorverarbeitungszeit verlängert, sondern dass solche „Verbesserungen des Realismus“ wahrscheinlich sogar kontraproduktiv sind.

Aus dem ergänzenden Material des neuen Artikels: Beispiele für erweiterte Bilder mit „zufälliger Überblendung“. Obwohl diese Szenen für den Betrachter halluzinogen wirken, sind sie dennoch mit ähnlichen Motiven vermischt; obwohl die Verdeckungen für das menschliche Auge fantastisch wirken, lässt sich die Natur einer möglichen Verdeckung nicht im Voraus erkennen und kann nicht trainiert werden. Daher reichen solche bizarren „Abschnitte“ der Form aus, um das trainierte System zu zwingen, partielle Zielmotive zu suchen und zu erkennen, ohne dass aufwendige Photoshop-Methoden entwickelt werden müssen, um die Szenen plausibler zu gestalten.

Daten und Tests

Für die Testphase wurde das System darauf trainiert person Klasse der MS COCO Datensatz mit 262,465 Beispielen von Menschen in 64,115 Bildern. Um jedoch Masken von besserer Qualität als MS COCO zu erhalten, wurden auch Bilder empfangen LVIS Maskenanmerkungen.

LVIS wurde 2019 aus Facebook-Forschung veröffentlicht und ist ein umfangreicher Datensatz für die Segmentierung großer Vokabelinstanzen. Quelle: https://arxiv.org/pdf/1908.03195.pdf

Um zu bewerten, wie gut das erweiterte System mit einer großen Anzahl verdeckter menschlicher Bilder mithalten kann, stellten die Forscher OC&P dem gegenüber OCHuman (Occluded Human) Benchmark.

Beispiele aus dem OCHuman-Datensatz, der 2 zur Unterstützung des Pose2018Seg-Erkennungsprojekts eingeführt wurde. Diese Initiative zielte darauf ab, eine verbesserte semantische Segmentierung von Menschen abzuleiten, indem ihre Haltung und Pose als semantisches Trennzeichen für die Pixel verwendet wurden, die ihre Körper darstellen. Quelle: https://github.com/liruilong940607/OCHumanApi

Da der OCHuman-Benchmark nicht vollständig kommentiert ist, erstellten die Forscher des neuen Papiers eine Teilmenge nur der Beispiele, die vollständig beschriftet waren, mit dem Titel OCHumanFL. Dadurch verringerte sich die Anzahl person Instanzen auf 2,240 in 1,113 Bildern zur Validierung und 1,923 Instanzen in 951 tatsächlich zum Testen verwendeten Bildern. Sowohl die ursprünglichen als auch die neu kuratierten Sätze wurden getestet, wobei die mittlere durchschnittliche Präzision (mAP) als Kernmetrik verwendet wurde.

Aus Gründen der Konsistenz wurde die Architektur geformt Maske R-CNN mit einem ResNet-50-Backbone und einem Feature-Pyramide Netzwerk, wobei letzteres einen akzeptablen Kompromiss zwischen Genauigkeit und Trainingsgeschwindigkeit darstellt.

Die Forscher haben die schädliche Wirkung von Upstream festgestellt IMAGEnet Einfluss in ähnlichen Situationen, das gesamte System wurde von Grund auf auf 4 NVIDIA V100 GPUs trainiert, für 75 Epochen, nach den Initialisierungsparametern der Facebook-Version 2021 Detectron 2.

Ergebnisse

Zusätzlich zu den oben genannten Ergebnissen sind die Basisergebnisse dagegen MMDetection (und die drei zugehörigen Modelle) für die Tests zeigten einen klaren Vorsprung für OC&P in seiner Fähigkeit, Menschen aus verworrenen Posen herauszufiltern.

Abgesehen davon, dass wir überdurchschnittlich gut abschneiden PoSeg und Pose2SegEine der vielleicht herausragendsten Errungenschaften des Artikels besteht darin, dass das System ganz allgemein auf bestehende Frameworks angewendet werden kann, einschließlich derer, die in den Tests damit verglichen wurden (siehe die Mit/Ohne-Vergleiche im ersten Ergebnisfeld am Anfang des Artikels).

Das Papier kommt zu dem Schluss:

Ein wesentlicher Vorteil unseres Ansatzes ist die einfache Anwendung auf beliebige Modelle und andere modellzentrierte Verbesserungen. Angesichts der rasanten Entwicklung im Deep-Learning-Bereich ist es für alle von Vorteil, Ansätze zu haben, die mit allen anderen Trainingsaspekten kompatibel sind. Wir planen, dies mit modellzentrierten Verbesserungen zu integrieren, um die Segmentierung verdeckter Personeninstanzen effektiv zu lösen.

Potenzial zur Verbesserung der Text-zu-Bild-Synthese

Der Hauptautor Evan Ling bemerkte in einer E-Mail an uns*, dass der Hauptvorteil von OC&P darin besteht, dass es die ursprünglichen Maskenbeschriftungen beibehalten und in einem neuen Kontext „kostenlos“ neuen Wert daraus gewinnen kann – d. h. aus den Bildern, in die sie eingefügt wurden.

Obwohl die semantische Segmentierung von Menschen eng mit den Schwierigkeiten zusammenhängt, die Modelle wie die stabile Diffusion bei der Individualisierung von Menschen haben (anstatt sie „zusammenzumischen“, wie es so oft geschieht), ist jeder Einfluss, den die semantische Etikettierungskultur auf die alptraumhaften menschlichen Darstellungen haben könnte, die SD und DALL-E 2 oft ausgeben, sehr, sehr weit oben angesiedelt.

Die Milliarden von LAION 5B Teilmengenbilder, die die generative Kraft von Stable Diffusion ausfüllen, enthalten keine Beschriftungen auf Objektebene wie Begrenzungsrahmen und Instanzmasken, auch wenn die CLIP-Architektur, die die Renderings aus Bildern und Datenbankinhalten zusammensetzt, irgendwann von einer solchen Instanziierung profitiert haben könnte; vielmehr sind die LAION-Bilder „kostenlos“ beschriftet, da ihre Beschriftungen aus Metadaten und Umgebungsbeschriftungen usw. abgeleitet wurden, die den Bildern zugeordnet wurden, als sie aus dem Internet in den Datensatz kopiert wurden.

„Aber davon abgesehen“, sagte uns Ling, „kann beim Training des generativen Text-zu-Bild-Modells eine Art Erweiterung ähnlich unserer OC&P genutzt werden. Ich denke jedoch, dass der Realismus des erweiterten Trainingsbildes möglicherweise zum Problem werden könnte.“

„In unserer Arbeit zeigen wir, dass für die überwachte Instanzsegmentierung im Allgemeinen kein ‚perfekter‘ Realismus erforderlich ist. Ich bin mir jedoch nicht sicher, ob sich die gleiche Schlussfolgerung für das Training von generativen Text-zu-Bild-Modellen ziehen lässt (insbesondere wenn deren Ergebnisse sehr realistisch sein sollen). In diesem Fall muss möglicherweise noch mehr Arbeit in die ‚Perfektionierung‘ des Realismus der erweiterten Bilder gesteckt werden.“

CLIP ist wird bereits verwendet als mögliches multimodales Werkzeug zur semantischen Segmentierung, was nahelegt, dass verbesserte Personenerkennungs- und Individuationssysteme wie OC&P letztlich zu systeminternen Filtern oder Klassifikatoren weiterentwickelt werden könnten, die „fusionierte“ und verzerrte menschliche Darstellungen willkürlich ablehnen würden – eine Aufgabe, die mit Stable Diffusion derzeit nur schwer zu bewältigen ist, da das System nur begrenzt in der Lage ist, zu erkennen, wo es einen Fehler gemacht hat (wenn es über eine solche Fähigkeit verfügen würde, wäre der Fehler wahrscheinlich gar nicht erst passiert).

Nur eines von mehreren Projekten, die derzeit das CLIP-Framework von OpenAI – das Herzstück von DALL-E 2 und Stable Diffusion – zur semantischen Segmentierung nutzen. Quelle: https://openaccess.thecvf.com/content/CVPR2022/papers/Wang_CRIS_CLIP-Driven_Referring_Image_Segmentation_CVPR_2022_paper.pdf

„Eine weitere Frage wäre“, schlägt Ling vor, „ob es funktioniert, diese generativen Modelle während des Trainings einfach mit Bildern verdeckter Menschen zu füttern, ohne eine ergänzende Modellarchitektur zu entwickeln, die das Problem der „Menschenverschmelzung“ mildert? Diese Frage lässt sich wahrscheinlich nicht so einfach beantworten. Es wird auf jeden Fall interessant sein zu sehen, wie wir während des Trainings des generativen Text-zu-Bild-Modells eine Art Anleitung auf Instanzebene (über Instanzebenenbezeichnungen wie die Instanzmaske) einbringen können.“

* 10. Oktober 2022

Erstveröffentlichung am 10. Oktober 2022.