Künstliche Intelligenz

Eine persönliche Sicht auf die Literaturtrends zum Thema Computer Vision im Jahr 2024

Ich verfolge die Forschungsszene im Bereich Computer Vision (CV) und Bildsynthese bei Arxiv und anderswo seit etwa fünf Jahren kontinuierlich. Trends werden also mit der Zeit deutlich und entwickeln sich jedes Jahr in neue Richtungen.

Da sich das Jahr 2024 dem Ende zuneigt, hielt ich es daher für angebracht, einen Blick auf einige neue oder sich entwickelnde Merkmale in Arxiv-Einreichungen im Bereich Computer Vision und Mustererkennung zu werfen. Abschnitt. Diese Beobachtungen basieren zwar auf Hunderten von Stunden des Studiums des Schauplatzes, sind jedoch rein anekdotischer Natur.

Der anhaltende Aufstieg Ostasiens

Ende 2023 fiel mir auf, dass der Großteil der Literatur zur Kategorie „Stimmsynthese“ aus China und anderen Regionen Ostasiens stammte. Ende 2024 muss ich (anekdotisch) feststellen, dass dies nun auch für die Forschungsszene zur Bild- und Videosynthese gilt.

Dies bedeutet nicht, dass China und die angrenzenden Länder unbedingt immer die beste Arbeit leisten (es gibt tatsächlich einige Beweise für das Gegenteil); ebenso wenig wird berücksichtigt, dass es in China (wie auch im Westen) sehr wahrscheinlich ist, dass einige der interessantesten und leistungsfähigsten neuen Entwicklungssysteme proprietär sind und nicht in der Forschungsliteratur vorkommen.

Aber es deutet darauf hin, dass Ostasien den Westen in dieser Hinsicht volumenmäßig übertrifft. Was das wert ist, hängt davon ab, inwieweit man an die Durchführbarkeit von Beständigkeit im Edison-Stil, was sich in der Regel als unwirksam erweist angesichts unüberwindlicher Hindernisse.

Es gibt viele solcher Straßensperren in der generativen KI, und es ist nicht einfach zu sagen, welche durch die Berücksichtigung vorhandener Architekturen gelöst werden können und welche von Grund auf neu überdacht werden müssen.

Obwohl Forscher aus Ostasien offenbar mehr Arbeiten zum Thema Computer Vision verfassen, ist mir eine zunehmende Häufigkeit von Projekten im „Frankenstein“-Stil aufgefallen – Initiativen, die eine Verschmelzung früherer Arbeiten darstellen und gleichzeitig begrenzte architektonische Neuerungen (oder möglicherweise nur eine andere Art von Daten) hinzufügen.

Dieses Jahr schien eine weitaus höhere Zahl von Einsendungen aus Ostasien (vorwiegend aus China oder von Kooperationen mit chinesischer Beteiligung) eher quoten- als leistungsorientiert zu sein, was das Signal-Rausch-Verhältnis in einem bereits überfüllten Feld deutlich verbesserte.

Gleichzeitig hat im Jahr 2024 auch eine größere Zahl ostasiatischer Zeitungen meine Aufmerksamkeit und Bewunderung erregt. Wenn es sich also um ein Zahlenspiel handelt, ist es kein Misserfolg – aber es ist auch nicht billig.

Steigendes Einreichungsvolumen

Die Anzahl der Veröffentlichungen ist im Jahr 2024 in allen Herkunftsländern deutlich gestiegen.

Der beliebteste Veröffentlichungstag schwankt im Laufe des Jahres; derzeit ist es Dienstag, an dem die Zahl der Einreichungen im Bereich Computer Vision und Mustererkennung in den Spitzenzeiten (Mai-August und Oktober-Dezember, also während der Konferenzsaison bzw. der Saison der „jährlichen Quotenfrist“) oft bei 300-350 an einem einzigen Tag liegt.

Über meine eigene Erfahrung hinaus berichtet Arxiv selbst über eine Rekordzahl an Einreichungen im Oktober 2024, mit insgesamt 6000 neuen Einsendungen, und der Bereich „Computer Vision“ ist nach „Machine Learning“ der Bereich mit den zweitmeisten Einsendungen.

Da der Abschnitt „Maschinelles Lernen“ bei Arxiv jedoch häufig als „zusätzliche“ oder aggregierte Superkategorie verwendet wird, spricht dies dafür, dass „Computer Vision und Mustererkennung“ tatsächlich die am häufigsten eingereichte Arxiv-Kategorie ist.

Arxivs eigene Statistiken Die Informatik ist zweifellos der klare Spitzenreiter bei den Einreichungen:

Die Informatik (CS) dominiert in den letzten fünf Jahren die Einreichungsstatistik bei Arxiv. Quelle: https://info.arxiv.org/about/reports/submission_category_by_year.html

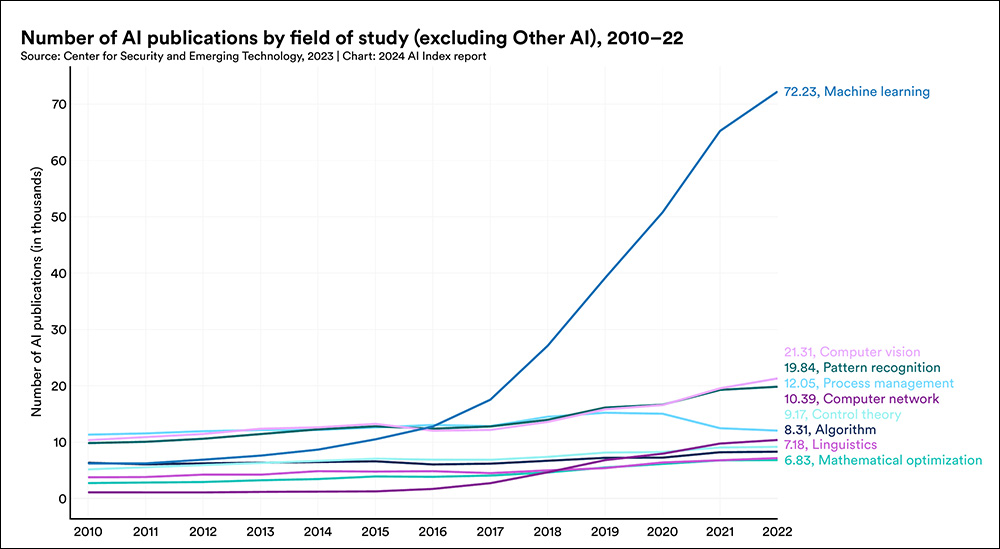

Stanford Universität KI-Index 2024, kann zwar noch keine aktuellen Statistiken vorlegen, betont aber auch den deutlichen Anstieg der Einreichungen akademischer Arbeiten zum Thema maschinelles Lernen in den letzten Jahren:

Obwohl für 2024 noch keine Zahlen vorliegen, zeigt der Bericht von Stanford dennoch einen dramatischen Anstieg der Einreichungszahlen für Arbeiten zum Thema maschinelles Lernen. Quelle: https://aiindex.stanford.edu/wp-content/uploads/2024/04/HAI_AI-Index-Report-2024_Chapter1.pdf

Diffusion>Mesh-Frameworks breiten sich aus

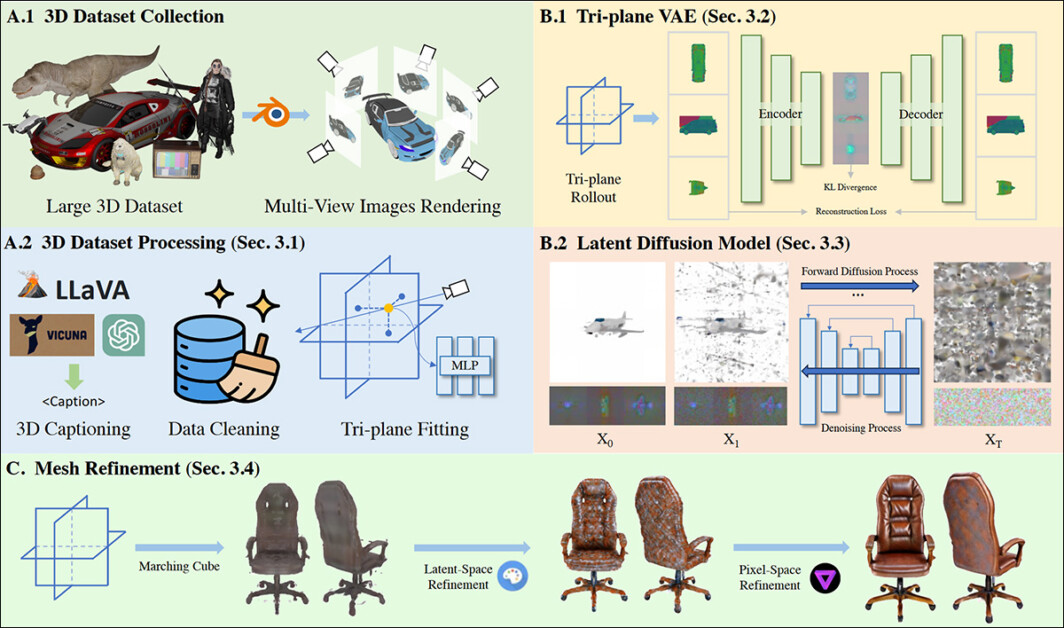

Ein weiterer klarer Trend, der sich für mich abzeichnete, war ein großer Anstieg an Artikeln, die sich mit der Hebelwirkung beschäftigen Latente Diffusionsmodelle (LDMs) als Generatoren von meshbasierten, „traditionellen“ CGI-Modellen.

Zu den Projekten dieser Art gehören Tencents InstantMesh3D, 3Dtopia, Rundfunk2, V3D, MV [ Bearbeiten ] und GIMDiffusion, neben einer Fülle ähnlicher Angebote.

Netzgenerierung und -verfeinerung über einen diffusionsbasierten Prozess in 3Dtopia. Quelle: https://arxiv.org/pdf/2403.02234

Dieser aufkommende Forschungsstrang könnte als stillschweigendes Zugeständnis an die anhaltende Unlösbarkeit generativer Systeme wie Diffusionsmodelle verstanden werden, die noch vor zwei Jahren als potenzieller Ersatz für all die Systeme angepriesen wurden, die heute mit Diffusionsnetzmodellen bevölkert werden sollen. Damit wird die Diffusion auf die Rolle eines Werkzeugs in Technologien und Arbeitsabläufen reduziert, die dreißig oder mehr Jahre alt sind.

Stability.ai, Urheber der Open Source Stable Diffusion Modell, haben gerade veröffentlicht Stabiler Zero123, die unter anderem eine Neuronale Strahlungsfelder (NeRF) Interpretation eines KI-generierten Bildes als Brücke zur Erstellung eines expliziten, mesh-basierten CGI-Modells, das in CGI-Bereichen wie Unity, in Videospielen, Augmented Reality und auf anderen Plattformen verwendet werden kann, die explizite 3D-Koordinaten erfordern, im Gegensatz zu den impliziten (versteckten) Koordinaten von stetige Funktionen.

Anklicken um abzuspielen. Mit Stable Diffusion erstellte Bilder können in rationale CGI-Netze umgewandelt werden. Hier sehen wir das Ergebnis eines Bild>CGI-Workflows mit Stable Zero 123. Quelle: https://www.youtube.com/watch?v=RxsssDD48Xc

3D-Semantik

Im Bereich der generativen KI wird zwischen 2D- und 3D-Systemimplementierungen von Vision und generativen Systemen unterschieden. Zum Beispiel Gesichts-Landmarking-Frameworks, obwohl Darstellen 3D-Objekte (Gesichter) berechnen nicht unbedingt in allen Fällen adressierbare 3D-Koordinaten.

Der beliebte FANAlign-System, das unter anderem in Deepfake-Architekturen aus dem Jahr 2017 weit verbreitet ist, kann beide dieser Ansätze berücksichtigen:

Oben werden 2D-Orientierungspunkte ausschließlich auf Grundlage erkannter Gesichtszüge und -merkmale generiert. Unten werden sie in den 3D-X/Y/Z-Raum rationalisiert. Quelle: https://github.com/1adrianb/face-alignment

So wie „Deepfake“ zu einem mehrdeutiger und missbrauchter Begriff, „3D“ ist auch in der Computer-Vision-Forschung zu einem verwirrenden Begriff geworden.

Für Verbraucher bedeutet es typischerweise stereofähige Medien (wie etwa Filme, bei denen der Zuschauer eine spezielle Brille tragen muss); für Visual-Effects-Praktiker und Modellierer ermöglicht es die Unterscheidung zwischen 2D-Kunstwerken (wie etwa konzeptionellen Skizzen) und netzbasierten Modellen, die in einem „3D-Programm“ wie Maya oder Cinema4D bearbeitet werden können.

Aber in der Computervision bedeutet es einfach, dass ein Kartesisches Koordinatensystem existiert irgendwo in der latenter Raum des Modells – nicht dass es notwendigerweise von einem Benutzer angesprochen oder direkt manipuliert werden kann; zumindest nicht ohne interpretierende CGI-basierte Systeme von Drittanbietern wie 3DMM or FLAMME.

Daher ist der Begriff Diffusion>3D ist ungenau; nicht nur kann für Als Eingabe zur Erstellung eines generativen CGI-Modells kann jede Art von Bild (einschließlich eines echten Fotos) verwendet werden, der weniger mehrdeutige Begriff „Netz“ ist jedoch angemessener.

Um die Unklarheit noch zu verstärken, is in den meisten neuen Projekten muss das Quellfoto in ein Mesh interpretiert werden. Eine bessere Beschreibung wäre also Bild-zu-Netz, während Bild>Diffusion>Netz ist eine noch genauere Beschreibung.

Doch das lässt sich bei einer Vorstandssitzung oder in einer Pressemitteilung, die Investoren ansprechen soll, nur schwer verkaufen.

Beweise für architektonische Pattsituationen

Selbst im Vergleich zu 2023 zeigt die Papiermenge der letzten 12 Monate eine wachsende Verzweiflung hinsichtlich der Beseitigung der harte praktische Grenzen auf diffusionsbasierter Erzeugung.

Das größte Hindernis bleibt die Generierung von erzählerisch und zeitlich konsistenten Videos und die Beibehaltung eines konsistenten Erscheinungsbilds von Charakteren und Objekten – nicht nur über verschiedene Videoclips hinweg, sondern sogar über die kurze Laufzeit eines einzelnen generierten Videoclips hinweg.

Die letzte epochale Innovation in der diffusionsbasierten Synthese war die Einführung von LoRA im Jahr 2022. Während neuere Systeme wie Flux einige der Ausreißerprobleme behoben haben, wie etwa die frühere Unfähigkeit von Stable Diffusion, Textinhalte innerhalb eines generierten Bildes wiederzugeben, und die allgemeine Bildqualität sich verbessert hat, ging es bei den meisten Arbeiten, die ich im Jahr 2024 untersucht habe, im Wesentlichen nur darum, das Essen auf dem Teller herumzuschieben.

Solche Pattsituationen gab es schon früher, bei Generative Adversarial Networks (GANs) und Neural Radiance Fields (NeRF), die beide ihr anfängliches Potenzial nicht ausschöpfen konnten – und beide werden zunehmend in konventionelleren Systemen genutzt (wie etwa bei der Verwendung von NeRF in Stable Zero 123, siehe oben). Dies scheint auch bei Diffusionsmodellen der Fall zu sein.

Gaussian Splatting Forschungs-Pivots

Ende 2023 schien die Rasterisierungsmethode 3D-Gaußsches Splatting (3DGS), das Anfang der 1990er Jahre als medizinische Bildgebungstechnik eingeführt wurde, sollte plötzlich Autoencoder-basiert Herausforderungen im Bereich der menschlichen Bildsynthese (wie Gesichtssimulation und -wiederherstellung sowie Identitätsübertragung).

Das ASH-Papier von 2023 versprach Ganzkörper-3DGS-Menschen, während Gaussian Avatare bot massiv verbesserte Details (im Vergleich zu Autoencoder und anderen Konkurrenzmethoden) sowie beeindruckendes Cross-Reenactment.

In diesem Jahr gab es allerdings relativ wenige derartige Durchbrüche bei der 3DGS-Synthese von Menschen; die meisten Arbeiten, die sich mit diesem Problem befassten, waren entweder Ableitungen der oben genannten Arbeiten oder blieben hinter deren Möglichkeiten zurück.

Stattdessen lag der Schwerpunkt bei 3DGS auf der Verbesserung seiner grundsätzlichen architektonischen Machbarkeit, was zu einer Flut von Dokumenten führte, die verbesserte 3DGS-Außenumgebungen anbieten. Besondere Aufmerksamkeit wurde an Simultaneous Localization and Mapping (SLAM) 3DGS-Ansätze in Projekten wie Gaussian Splatting SLAM, Splat-SLAM, Gaussian-SLAM, DROID-Splat, unter vielen anderen.

Zu den Projekten, die versuchten, die auf Splats basierende menschliche Synthese fortzusetzen oder zu erweitern, gehörten MIGS, GEM, EVA, OccFusion, FAG-Kopf, MenschSplat, GGKopf, HGM und Topo4D. Obwohl es noch andere gibt, konnte keiner dieser Ausflüge mit der anfänglichen Wirkung der Papiere mithalten, die Ende 2023 auftauchten.

Die „Weinstein-Ära“ der Testproben befindet sich im (langsamen) Niedergang

Forschungsarbeiten aus Südostasien im Allgemeinen (und China im Besonderen) enthalten häufig Testbeispiele, deren erneute Veröffentlichung in einem Übersichtsartikel problematisch ist, da sie ein wenig „pikantes“ Material enthalten.

Ob dies daran liegt, dass die Forscher in diesem Teil der Welt mit ihren Ergebnissen Aufmerksamkeit erregen wollen, ist umstritten; in den letzten 18 Monaten wurden in einer zunehmenden Zahl von Arbeiten über generative KI (Bild und/oder Video) standardmäßig junge und leicht bekleidete Frauen und Mädchen in Projektbeispielen verwendet. Beispiele, die an der Grenze zur NSFW liegen, sind UniAnimate, SteuerungWeiterund sogar sehr „trockene“ Papiere wie Auswerten der Bewegungskonsistenz anhand der Fréchet Video Motion Distance (FVMD).

Dies folgt den allgemeinen Trends von Subreddits und anderen Communities, die sich um Latent Diffusion Models (LDMs) versammelt haben, bei denen Regel 34 nach wie vor sehr deutlich präsent ist.

Promi-Duell

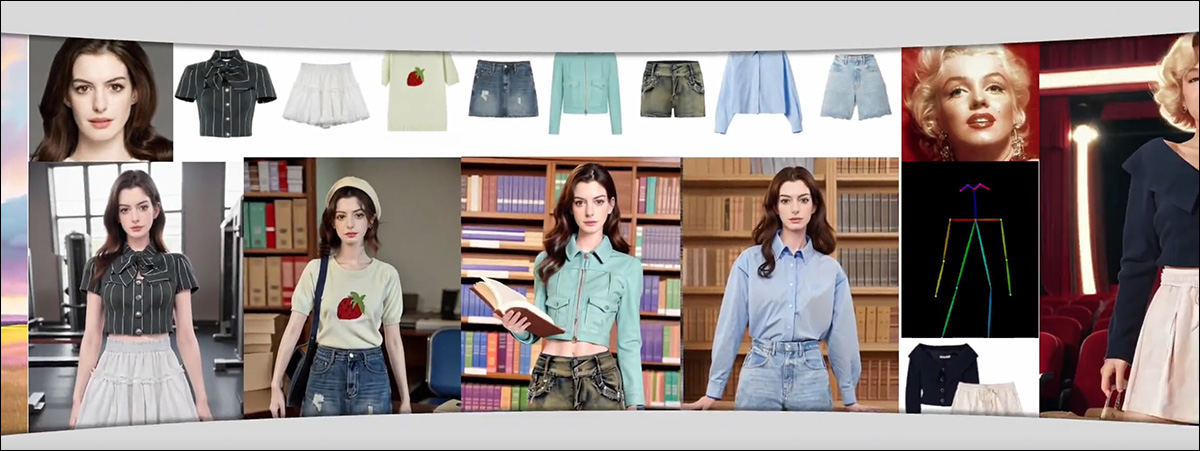

Diese Art unangemessener Beispiele überschneidet sich mit der wachsenden Erkenntnis, dass KI-Prozesse die Ähnlichkeit von Prominenten nicht willkürlich ausnutzen sollten – insbesondere in Studien, die Beispiele unkritisch verwenden mit attraktive Prominente, oft Frauen, und stellen sie in fragwürdige Kontexte.

Ein Beispiel ist Abonnieren, das neben sehr jungen weiblichen Charakteren im Anime-Stil auch großzügig die Identitäten klassischer Berühmtheiten wie Marilyn Monroe und aktueller Berühmtheiten wie Ann Hathaway verwendet (die diese Art der Verwendung angeprangert hat ziemlich laut).

Die willkürliche Verwendung aktueller und „klassischer“ Berühmtheiten ist in Zeitungen aus Südostasien noch immer recht verbreitet, auch wenn diese Praxis leicht rückläufig ist. Quelle: https://crayon-shinchan.github.io/AnyDressing/

In Western In den Artikeln ist diese besondere Praxis im Laufe des Jahres 2024 deutlich zurückgegangen, angeführt von den größeren Veröffentlichungen von FAANG und anderen hochrangigen Forschungseinrichtungen wie OpenAI. Diese großen Unternehmensakteure sind sich des Potenzials für künftige Rechtsstreitigkeiten kritisch bewusst und scheinen zunehmend nicht bereit zu sein, selbst fiktiv fotorealistische Menschen.

Obwohl die Systeme, die sie schaffen (wie Imagen, sowie Veo2) sind eindeutig zu solchen Ergebnissen fähig, Beispiele aus westlichen Projekten zur generativen KI tendieren mittlerweile zu „süßen“, disneyfizierten und extrem „sicheren“ Bildern und Videos.

Obwohl Imagen mit der Fähigkeit gepriesen wird, „fotorealistische“ Ergebnisse zu erzeugen, sind die von Google Research beworbenen Beispiele in der Regel fantastischer, „familiärer“ Kost – fotorealistische Menschen werden sorgfältig vermieden oder es werden nur minimale Beispiele bereitgestellt. Quelle: https://imagen.research.google/

Gesichtswaschen

In der westlichen CV-Literatur ist dieser unaufrichtige Ansatz besonders deutlich bei Anpassung Systeme – Methoden, die in der Lage sind, konsistente Ähnlichkeiten einer bestimmten Person über mehrere Beispiele hinweg zu erstellen (z. B. LoRA und die älteren Traumkabine).

Beispiele umfassen orthogonale visuelle Einbettung, LoRA-Komponist, Googles InstructBooth, und vieles mehr.

Googles InstructBooth dreht den Niedlichkeitsfaktor auf 11, obwohl die Vergangenheit darauf schließen lässt, dass Benutzer eher daran interessiert sind, fotorealistische Menschen zu erschaffen als pelzige oder flauschige Figuren. Quelle: https://sites.google.com/view/instructbooth

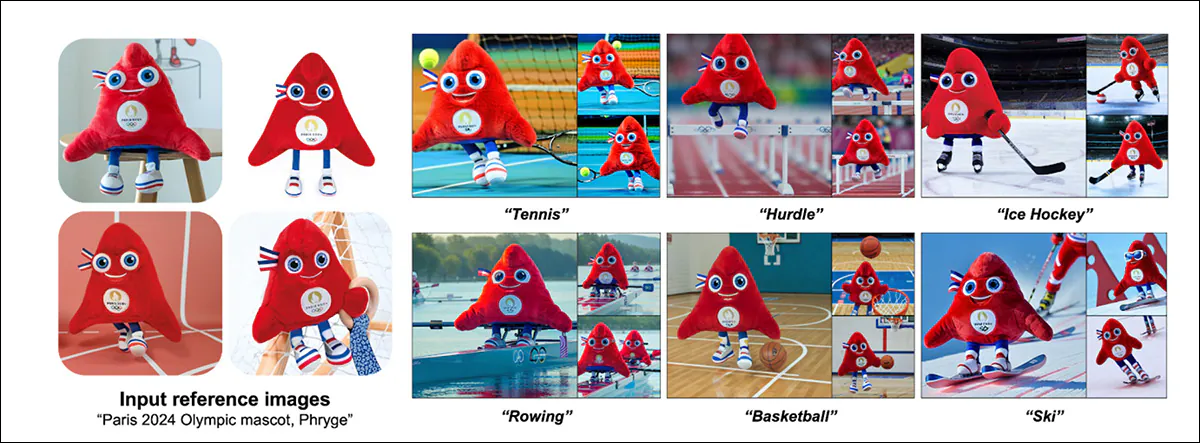

Der Aufstieg des „niedlichen Beispiels“ ist jedoch auch in anderen CV- und Synthese-Forschungssträngen zu beobachten, beispielsweise in Projekten wie Comp4D, V3D, EntwurfBearbeiten, Uni, FaceChain (was realistischere Nutzererwartungen auf seiner GitHub Seite), Und DPG-T2I, unter vielen anderen.

Die Leichtigkeit, mit der solche Systeme (wie LoRAs) können von Heimanwendern mit relativ bescheidener Hardware erstellt werden, was zu einer Explosion von frei herunterladbaren Promi-Modellen geführt hat in der Domäne civit.ai und Gemeinschaft. Eine solche illegale Nutzung bleibt möglich durch die Open-Source-Nutzung von Architekturen wie Stable Diffusion sowie Fluss.

Obwohl es oft möglich ist, die Sicherheitsfunktionen von generativen Text-to-Image (T2I)- und Text-to-Video (T2V)-Systemen zu umgehen und Material zu produzieren, das durch die Nutzungsbedingungen einer Plattform verboten ist, besteht eine große Lücke zwischen den eingeschränkten Möglichkeiten der besten Systeme (wie RunwayML und Sora) und den unbegrenzten Möglichkeiten der lediglich leistungsfähigen Systeme (wie Stabile Videoverbreitung, CogVideo und lokale Bereitstellungen von Hunyuan), wird nicht wirklich geschlossen, wie viele glauben.

Vielmehr drohen diese proprietären und Open-Source-Systeme gleichermaßen nutzlos zu werden: Teure und hyperskalige T2V-Systeme könnten durch die Angst vor Rechtsstreitigkeiten übermäßig behindert werden, während die fehlende Lizenzierungsinfrastruktur und Datensatzkontrolle bei Open-Source-Systemen diese im Zuge strengerer Regulierungen vollständig vom Markt ausschließen könnte.

Erstveröffentlichung Dienstag, 24. Dezember 2024