Inteligencia Artificial

NeRF se acerca un paso más a la sustitución de CGI

Investigadores del MIT y Google han dado un gran paso para resolver uno de los obstáculos más fundamentales para una tecnología emergente impulsada por IA que eventualmente puede reemplazar CGI: separar las imágenes del campo de radiación neuronal (NeRF) en sus componentes visuales constituyentes, de modo que las imágenes puedan ser re-texturizado y re-iluminado.

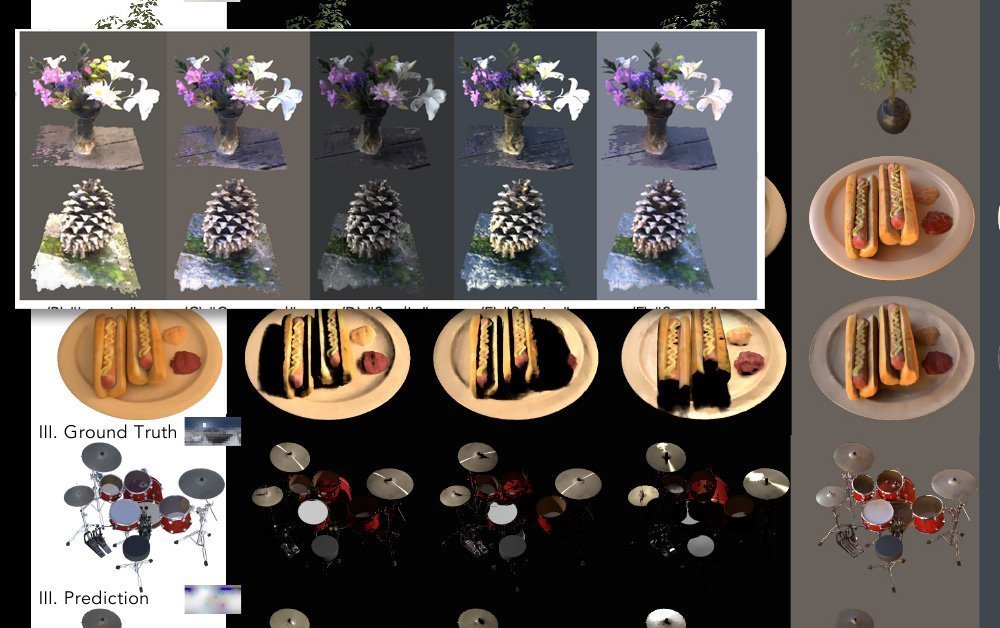

El nuevo enfoque, llamado NeRFactor, divide efectivamente las imágenes capturadas en normales por objeto (sobre las cuales se pueden asignar texturas), visibilidad de luz, albedo (la proporción de luz incidental que se refleja desde una superficie) y funciones de distribución de reflectancia bidireccional (BRDF).

Con estas facetas aisladas, es posible no solo cambiar texturas para objetos individuales o grupos de objetos, sino también agregar fuentes de iluminación y sombras novedosas y únicas, descartando cualquiera que haya sido capturada por los conjuntos de múltiples cámaras que generan información para las imágenes NeRF.

Normales, visibilidad, albedo y BRDF separados bajo NeRFactor. Fuente: https://www.youtube.com/watch?v=UUVSPJlwhPg

El modelo admite sombras suaves o duras de fuentes de iluminación arbitrarias definidas por el usuario, y separa los cuatro aspectos del video capturado mediante programación, usando una pérdida de reconstrucción, datos de cálculos previos de BRDF y regularización de suavidad simple básica.

Flujo de trabajo de NeRFactor, que extrae facetas procesables por separado de imágenes derivadas de conjuntos de múltiples cámaras. Fuente: https://arxiv.org/pdf/2106.01970.pdf

NeRFactor utiliza una sonda de luz HDR, un enfoque bien establecido que ha impregnado la escena de las artes y la industria visual desde su creación. introducción en 1998, para evaluar posibles rutas de rayos, lo que permite una iluminación arbitraria. Dado que esto genera una cantidad ingobernable de posibles parámetros, la sonda de luz se filtra a través de un perceptrón multicapa (MLP), que asigna la geometría percibida a la sonda sin intentar calcular un mapa de volumen de iluminación completo para el espacio modelo.

Se utilizan dos modelos de campo de radiación neuronal para demostrar cinco modelos de iluminación posibles con NeRFactor. Haga clic en la imagen para una resolución más alta.

Motivo de reflexión

La nueva investigación es quizás más significativa en la separación de las capas de imágenes capturadas que controlan la reflexión. Este sigue siendo uno de los mayores desafíos para las imágenes de campo de radiación neuronal, ya que un sistema NeRF verdaderamente novedoso y flexible necesitará no solo poder sustituir texturas, sino que, de manera crucial, necesitará alguna forma de reflejar objetos en movimiento (además del entorno fijo general) que normalmente se contabilizaría en un flujo de trabajo CGI.

Este problema se observó recientemente en relación con Intel impresionante nueva investigación En la transformación de secuencias de videojuegos en vídeo fotorrealista mediante redes neuronales convolucionales. En estos flujos de trabajo, muchos aspectos "horneados" del material original tendrían que volverse discretos e intercambiables, y esto es posiblemente más fácil de resolver para la reiluminación (que depende de la geometría renderizada en NeRF) que para los reflejos (que utilizan geometría "fuera de pantalla", totalmente fuera del alcance del modelo).

Por lo tanto, aislar las capas en el video de NeRF que facilitan la reflexión acerca a NeRF un paso más a la solución de su "desafío de reflexión".

El uso de un entorno HDR ya resuelve el problema de generar reflejos del entorno mundial (es decir, cielos, paisajes y otros factores ambientales "fijos"), pero se necesitarán nuevos enfoques para introducir reflejos dinámicos y en movimiento.

Fotogrametría con NeRF

Las imágenes de Neural Radiance Field utilizan análisis de aprendizaje automático para desarrollar un espacio completamente volumétrico a partir de una escena u objeto que ha sido capturado desde varios ángulos.

Diversos esquemas basados en NeRF surgidos el último año han utilizado diversos dispositivos de cámara; algunos emplean 16 o más cámaras, otros tan solo una o dos. En todos los casos, los puntos de vista intermedios se rellenan (es decir, se interpretan) para que la escena u objeto se pueda explorar con fluidez.

La entidad resultante es un espacio completamente volumétrico, con una comprensión 3D intrínseca que se puede explotar de muchas maneras, incluida la capacidad de generar mallas CG tradicionales a partir de la suma analizada en 3D de las imágenes de entrada.

NeRF en el contexto de un 'nuevo CGI'

Las imágenes del campo de radiación neural son drawn Directamente a partir de imágenes del mundo real, incluyendo imágenes en movimiento de personas, objetos y escenas. En cambio, una metodología CGI "estudia" e interpreta el mundo, lo que requiere que trabajadores cualificados creen mallas, estructuras y texturas que utilicen imágenes del mundo real (es decir, capturas faciales y ambientales). Sigue siendo un enfoque esencialmente interpretativo y artesanal, costoso y laborioso.

Además, CGI ha tenido problemas constantes con el efecto "valle inquietante" en sus esfuerzos por recrear imágenes humanas, lo que no presenta ninguna restricción para un enfoque impulsado por NeRF, que simplemente captura videos o imágenes de personas reales y los manipula.

Además, NeRF puede generar geometría de malla de estilo CGI tradicional directamente a partir de fotografías según sea necesario y, de hecho, suplanta muchos de los procedimientos manuales que siempre han sido necesarios en las imágenes generadas por computadora.

Desafíos para NeRF

Esta última investigación del MIT y Google se produce en el contexto de una verdadera avalancha de documentos NeRF durante el último año, muchos de los cuales han ofrecido soluciones a los diversos desafíos planteados por el documento inicial de 2020.

En abril, la innovación de un consorcio de investigación chino proporcionó una manera de aislar discretamente las líneas de tiempo individuales de las facetas en una escena NeRF, incluidas las personas.

La investigación china permite a los usuarios finales copiar, pegar y cambiar el tamaño de los elementos capturados, desenredándolos de la línea de tiempo lineal del video fuente original. Fuente: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Este enfoque no solo permite volver a imaginar la escena desde cualquier ángulo capturado por el conjunto de cámaras (y no solo la vista única representada en una captura de video típica), sino que también permite una composición versátil, e incluso la capacidad de representar dos facetas del mismo metraje que se ejecuta en sus propios marcos de tiempo individuales (o incluso se ejecuta hacia atrás, según sea necesario).

La investigación china permite a los usuarios finales copiar, pegar y cambiar el tamaño de los elementos capturados, desenredándolos de la línea de tiempo lineal del video fuente original. Fuente: https://www.youtube.com/watch?v=Wp4HfOwFGP4

Uno de los mayores desafíos para NeRF es reducir los considerables recursos necesarios para entrenar una escena, y esto se ha abordado en varios documentos recientes. Por ejemplo, el Instituto Max Planck para Sistemas Inteligentes introdujo recientemente KiloNeRF, que no solo acelera los tiempos de renderizado en un factor de 1000, sino que incluso permite que NeRF funcione de forma interactiva.

KiloNeRF ejecutando un entorno interactivo a 50 fps en una GTX 1080ti. Fuente: https://github.com/creiser/kilonerf

Sin embargo, la innovación de velocidad NeRF que realmente capturó la imaginación de los investigadores y el público en 2021 ha sido el plenoctrees colaboración, dirigida por UC Berkeley, que ofrece representación en tiempo real de Neural Radiance Fields:

El efecto de las capacidades interactivas de PlenOctrees se ha reproducido en un interfaz en vivo basada en la web.

Movimiento interactivo en vivo de un objeto PlenOctrees en Firefox (el movimiento es más fluido y dinámico que lo que representa este GIF). Fuente: http://alexyu.net/plenoctrees/demo/

Además en NeRF recursivo (de un artículo de mayo de 2021 de investigadores de la Universidad de Tsinghua) ofrece renderizado recursivo de alta calidad bajo demanda. En lugar de obligar al usuario a renderizar escenas completas, incluyendo partes que podrían no verse, Recursive-NeRF proporciona algo similar a la compresión con pérdida de JPEG y puede generar sub-NeRF discretos para gestionar imágenes adicionales bajo demanda, lo que supone un gran ahorro de recursos computacionales.

Retención de detalles mientras se descargan cálculos de renderizado innecesarios con Recursive-NeRF. Haga clic en la imagen para una resolución más alta. Fuente: https://arxiv.org/pdf/2105.09103.pdf

Otros enfoques incluyen FastNeRF, que afirma lograr una representación neuronal de alta fidelidad a 200 fps.

Se ha observado que muchas de las técnicas de optimización para NeRF implican 'horneando' la escena, comprometiéndose con aspectos que se desea renderizar y descartando otras facetas, lo que limita la exploración pero agiliza mucho la interactividad.

La desventaja de esto es que la tensión pasa de la GPU al almacenamiento, porque las escenas horneadas ocupan una cantidad excesiva de espacio en disco; hasta cierto punto, esto se puede mitigar reduciendo la muestra de los datos horneados, aunque esto también implica un cierto compromiso, en términos de cerrar vías de exploración o interactividad.

Con respecto a la captura de movimiento y el rigging, un nuevo enfoque de las universidades de Zheijang y Cornell, revelado en mayo, ofreció un método para recrear humanos animables utilizando campos de peso combinados y estructuras esqueléticas interpretadas a partir del video de entrada:

Estructura esquelética derivada en Animatable NeRF. Fuente: https://www.youtube.com/watch?v=eWOSWbmfJo4

¿Cuándo tendrá NeRF su momento ‘Jurassic Park’?

A pesar del rápido progreso en la síntesis de imágenes mediante campos de radiancia neuronal, solo en este período se establecerá una especie de "ley de la termodinámica" que determine la viabilidad de la NeRF. En términos de una cronología análoga a la historia de la CGI, la NeRF se sitúa actualmente en torno a 1973, justo antes de... primer uso de CGI en Westworld.

Eso no significa que NeRF necesariamente tendrá que esperar nueve años por su equivalente. Ira de Khan hito, o décadas para los avances similares que CGI logró bajo el patrocinio entusiasta de James Cameron en 1989. The Abyss o de 1991 Terminator 2 – y luego, la tecnología es verdaderamente revolucionaria momento de ruptura en 1993 Jurassic Park.

El panorama de la imagen ha cambiado mucho desde el largo periodo de estancamiento de los efectos visuales fotoquímicos, que dominaron la producción cinematográfica y televisiva desde el nacimiento del cine hasta principios de la década de 1990. La llegada de la revolución de la PC y la aceleración de la Ley de Moore condujeron a la revolución de la CGI, que de otro modo podría haber tenido lugar ya en la década de 1960.

Queda por ver si existe alguna barrera tan implacable que pueda detener el progreso de NeRF durante tanto tiempo, y si las innovaciones posteriores en visión por computadora no podrían, mientras tanto, superar por completo a NeRF como el principal contendiente para la corona de la CGI, caracterizando a los campos de radiancia neuronal como la "máquina de fax" de corta duración de la síntesis de imágenes neuronales.

Hasta el momento, NeRF no se ha utilizado en ningún contexto fuera de la investigación académica; pero es notable que actores importantes como Google Research y muchos de los laboratorios de investigación de visión por computadora más destacados estén compitiendo por el último avance de NeRF.

Muchos de los mayores obstáculos de NeRF han comenzado a abordarse directamente este año; si las investigaciones posteriores ofrecen una solución al "problema de la reflexión", y las muchas líneas de investigación para optimizar NeRF se unen en una solución decisiva a las considerables demandas de procesamiento y/o almacenamiento de la tecnología, NeRF realmente tiene una oportunidad de convertirse en "la nueva CGI" en los próximos cinco años.