Inteligencia artificial

UniTune: la técnica alternativa de edición de imágenes neuronales de Google

Google Research, al parecer, está atacando la edición de imágenes basada en texto desde varios frentes y, presumiblemente, esperando a ver qué 'toma'. Siguiendo la pista del lanzamiento de esta semana de su papel mágico, el gigante de las búsquedas ha propuesto un método adicional basado en la difusión latente para realizar ediciones de imágenes basadas en IA que de otro modo serían imposibles a través de comandos de texto, esta vez llamado UniTune.

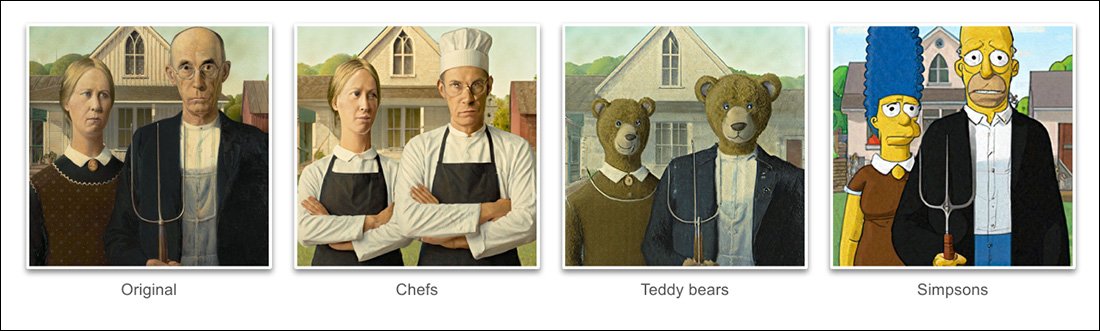

Basado en los ejemplos dados en el proyecto nuevo documento, UniTune ha logrado un grado extraordinario de desenredo de la pose semántica y la idea del contenido real de la imagen:

El dominio de la composición semántica de UniTune es sobresaliente. Observe cómo en la fila superior de imágenes, los rostros de las dos personas no han sido distorsionados por la extraordinaria transformación del resto de la imagen de origen (derecha). Fuente: https://arxiv.org/pdf/2210.09477.pdf

Como los fanáticos de Stable Diffusion ya habrán aprendido, aplicar ediciones a secciones parciales de una imagen sin alterar negativamente el resto de la imagen puede ser una operación complicada, a veces imposible. Aunque distribuciones populares como AUTOMÁTICO1111 puede crear máscaras para ediciones locales y restringidas, el proceso es tortuoso y con frecuencia impredecible.

La respuesta obvia, al menos para un practicante de visión por computadora, es interponer una capa de segmentación semántica que es capaz de reconocer y aislar objetos en una imagen sin la intervención del usuario y, de hecho, ha habido varias iniciativas nuevas últimamente en esta línea de pensamiento.

Otra posibilidad para bloquear las operaciones de edición de imágenes neuronales desordenadas y enredadas es aprovechar el influyente Pre-entrenamiento de imágenes de lenguaje contrastivo de OpenAI (CLIP), que está en el corazón de los modelos de difusión latente como DALL-E 2 y Stable Diffusion, para actuar como un filtro en el punto en el que un modelo de texto a imagen está listo para enviar una representación interpretada al usuario. . En este contexto, CLIP debería actuar como un módulo centinela y de control de calidad, rechazando los renderizados mal formados o inadecuados. Esto es a punto de ser instituido (enlace Discord) en el portal impulsado por la API DreamStudio de Stability.ai.

Sin embargo, dado que CLIP es posiblemente tanto el culpable como la solución en tal escenario (porque esencialmente también informó la forma en que evolucionó la imagen), y dado que los requisitos de hardware pueden exceder lo que probablemente esté disponible localmente para un usuario final, este enfoque puede no ser ideal.

lenguaje comprimido

El UniTune propuesto, en cambio, "afina" un modelo de difusión existente, en este caso, el propio Imagen de Google, aunque los investigadores afirman que el método es compatible con otras arquitecturas de difusión latente, de modo que se inyecta un token único que se puede invocar. incluyéndolo en un mensaje de texto.

A primera vista, esto suena como Google cabina de ensueño, actualmente una obsesión entre los fanáticos y desarrolladores de Stable Diffusion, que pueden inyectar nuevos personajes u objetos en un punto de control existente, a menudo en menos de una hora, en función de un simple puñado de imágenes de origen; o bien como inversión textual, que crea archivos 'sidecar' para un punto de control, que luego se tratan como si estuvieran entrenados originalmente en el modelo, y pueden aprovechar los vastos recursos propios del modelo modificando su clasificador de texto, lo que da como resultado un archivo pequeño (en comparación con el mínimo 2 GB de puntos de control eliminados de DreamBooth).

De hecho, afirman los investigadores, UniTune rechazó ambos enfoques. Descubrieron que Textual Inversion omitió demasiados detalles importantes, mientras que DreamBooth 'se desempeñó peor y tomó más tiempo' que la solución por la que finalmente se decidieron.

No obstante, UniTune utiliza el mismo enfoque de 'metaprompt' semántico encapsulado que DreamBooth, con cambios entrenados invocados por palabras únicas elegidas por el entrenador, que no chocarán con ningún término que exista actualmente en un modelo de publicación pública laboriosamente entrenado.

'Para realizar la operación de edición, probamos los modelos ajustados con el indicador "[rare_tokens] edit_prompt" (por ejemplo, "beikkpic two dogs in a restaurant" o "beikkpic a minion").

El Proceso

Aunque es desconcertante por qué dos documentos casi idénticos, en términos de su funcionalidad final, deben llegar de Google en la misma semana, existe, a pesar de la gran cantidad de similitudes entre las dos iniciativas, al menos una diferencia clara entre UniTune e Imagic: este último utiliza indicaciones de lenguaje natural 'sin comprimir' para guiar las operaciones de edición de imágenes, mientras que UniTune se entrena en tokens únicos de estilo DreamBooth.

Por lo tanto, si estuvieras editando con Imagic y quisieras realizar una transformación de esta naturaleza…

Del artículo de UniTune: UniTune se enfrenta al marco de edición neuronal rival favorito de Google, SDEdit. Los resultados de UniTune están en el extremo derecho, mientras que la máscara estimada se ve en la segunda imagen desde la izquierda.

.. en Imagic, ingresaría 'la tercera persona, sentada en el fondo, como un lindo monstruo peludo'.

El comando UniTune equivalente sería 'Chico en la parte de atrás como [x]', Donde x es cualquier palabra extraña y única vinculada al concepto bien entrenado asociado con el personaje del monstruo peludo.

Mientras que una cantidad de imágenes se introducen en DreamBooth o Textual Inversion con la intención de crear una abstracción de estilo deepfake que se puede ordenar en muchas poses, UniTune e Imagic en su lugar alimentan una sola imagen en el sistema: la imagen original y prístina.

Esto es similar a la forma en que han funcionado muchas de las herramientas de edición basadas en GAN de los últimos años: al convertir una imagen de entrada en códigos latentes en el espacio latente de GAN y luego abordar esos códigos y enviarlos a otras partes del latente. espacio para la modificación (es decir, ingresar una imagen de una persona joven de cabello oscuro y proyectarla a través de códigos latentes asociados con 'viejo' o 'rubio', etc.).

Sin embargo, los resultados, en un modelo de difusión y por este método, son sorprendentemente precisos en comparación y mucho menos ambiguos:

El proceso de ajuste fino

Básicamente, el método UniTune envía la imagen original a través de un modelo de difusión con un conjunto de instrucciones sobre cómo debe modificarse, utilizando los vastos depósitos de datos disponibles entrenados en el modelo. En efecto, puedes hacer esto ahora mismo con Stable Diffusion's img2img funcionalidad, pero no sin deformar o cambiar de alguna manera las partes de la imagen que preferiría conservar.

Durante el proceso de UniTune, el sistema se afinard, lo que quiere decir que UniTune obliga al modelo a reanudar el entrenamiento, con la mayoría de sus capas descongeladas (ver más abajo). En la mayoría de los casos, el ajuste fino hundirá el total general pérdida de valores de un modelo de alto rendimiento ganado con esfuerzo a favor de inyectar o refinar algún otro aspecto que se desea crear o mejorar.

Sin embargo, con UniTune parece que la copia del modelo sobre la que se actúa, aunque puede pesar varios gigabytes o más, se tratará como una 'cáscara' colateral desechable y se descartará al final del proceso, habiendo servido a un único objetivo. Este tipo de tonelaje de datos casual se está convirtiendo en una crisis de almacenamiento diaria para los fanáticos de DreamBooth, cuyos propios modelos, incluso cuando se recortan, no tienen menos de 2 GB por sujeto.

Al igual que con Imagic, el ajuste principal en UniTune ocurre en las dos capas inferiores de las tres en Imagen (base 64px, 64px>256px y 256px>1024px). A diferencia de Imagic, los investigadores ven algún valor potencial en la optimización del ajuste también para esta última y más grande capa de superresolución (aunque aún no lo han intentado).

Para la capa más baja de 64 px, el modelo está sesgado hacia la imagen base durante el entrenamiento, con múltiples pares duplicados de imagen/texto alimentados al sistema para 128 iteraciones en un tamaño de lote de 4, y con adafactor como la función de pérdida, operando a una tasa de aprendizaje de 0.0001. Aunque el codificador T5 solo se congela durante este ajuste fino, también se congela durante la formación primaria de Imagen

La operación anterior se repite luego para la capa 64>256px, utilizando el mismo procedimiento de aumento de ruido empleado en el entrenamiento original de Imagen.

Muestreo

Existen muchos métodos de muestreo posibles mediante los cuales se pueden obtener los cambios realizados a partir del modelo ajustado, incluida la guía libre del clasificador (CFG), un pilar también de Stable Diffusion. CFG básicamente define la medida en que el modelo es libre de 'seguir su imaginación' y explorar las posibilidades de renderizado, o bien, en configuraciones más bajas, la medida en que debe adherirse a los datos de origen de entrada y realizar cambios menos radicales o dramáticos. .

Al igual que Textual Inversion (un poco menos con DreamBooth), UniTune es capaz de aplicar distintos estilos gráficos a las imágenes originales, así como ediciones más fotorrealistas.

Los investigadores también experimentaron con SDEditarLa técnica de 'inicio tardío', en la que se anima al sistema a preservar los detalles originales siendo solo parcialmente 'ruidoso' desde el principio, pero manteniendo sus características esenciales. Aunque los investigadores solo usaron esto en la capa más baja (64 px), creen que podría ser una técnica de muestreo complementaria útil en el futuro.

Los investigadores también aprovecharon aviso a aviso como una técnica adicional basada en texto para condicionar el modelo:

'En la configuración de "mensaje a mensaje", descubrimos que una técnica que llamamos guía rápida es particularmente útil para afinar la fidelidad y la expresividad.

'La guía de solicitud es similar a la guía libre del clasificador, excepto que la línea de base es una solicitud diferente en lugar del modelo no condicionado. Esto guía al modelo hacia el delta entre las dos indicaciones.'

Sin embargo, la orientación rápida, afirman los autores, solo fue necesaria ocasionalmente en los casos en que CFG no pudo obtener el resultado deseado.

Otro nuevo enfoque de muestreo encontrado durante el desarrollo de UniTune fue interpolación, donde las áreas de la imagen son lo suficientemente distintas como para que tanto la imagen original como la alterada tengan una composición muy similar, lo que permite utilizar una interpolación más "ingenua".

La interpolación puede hacer que los procesos de mayor esfuerzo de UniTune sean redundantes en los casos en que las áreas que se van a transformar son discretas y están bien delimitadas.

Los autores sugieren que la interpolación podría funcionar potencialmente tan bien, para una gran cantidad de imágenes de origen de destino, que podría usarse como una configuración predeterminada, y observan también que tiene el poder de efectuar transformaciones extraordinarias en casos donde las oclusiones complejas no lo hacen. deben negociarse mediante métodos más intensivos.

UniTune puede realizar ediciones locales con o sin máscaras de edición, pero también puede decidir unilateralmente dónde colocar las ediciones, con una combinación inusual de poder interpretativo y esencialización robusta de los datos de entrada de origen:

En la imagen superior de la segunda columna, UniTune, encargado de insertar un 'tren rojo en el fondo', lo colocó en una posición apropiada y auténtica. Observe en los otros ejemplos cómo se mantiene la integridad semántica de la imagen de origen incluso en medio de cambios extraordinarios en el contenido de píxeles y los estilos centrales de las imágenes.

Estado latente

Aunque la primera iteración de cualquier sistema nuevo será lenta, y aunque es posible que la participación de la comunidad o el compromiso corporativo (normalmente no son ambos) con el tiempo aceleren y optimicen una rutina que requiere muchos recursos, tanto UniTune como Imagic están realizando algunas maniobras de aprendizaje automático bastante importantes para crear estas sorprendentes ediciones, y es cuestionable hasta qué punto un proceso que consume tantos recursos podría alguna vez reducirse al uso doméstico, en lugar del acceso impulsado por API (aunque este último puede ser más deseable para Google). ).

Por el momento, el viaje de ida y vuelta desde la entrada hasta el resultado es de unos 3 minutos en una GPU T4, con unos 30 segundos adicionales para la inferencia (como en cualquier rutina de inferencia). Los autores admiten que se trata de una latencia alta y difícilmente califica como "interactivo", pero también señalan que el modelo permanece disponible para ediciones posteriores una vez ajustado inicialmente, hasta que el usuario finaliza el proceso, lo que reduce el tiempo de edición. .

Publicado por primera vez el 21 de octubre de 2022.