Vordenker

Warum Ihre KI-Bilder Fehler enthalten – und wie Sie sie verbessern können

KI-gesteuerte Modelle zur Text-zu-Bild-Generierung haben die digitale Kunst und Inhaltserstellung revolutioniert und ermöglichen es jedem Benutzer, unabhängig von seinem Hintergrund, mit nur wenigen Wörtern hochwertige, anpassbare Bilder in einem Bruchteil der Zeit zu erstellen, die ein menschlicher Profi mit klassischen Design- oder Fototools benötigen würde.

Dank des technologischen Fortschritts wird KI-gestützte Kreativität zunehmend zu einem integralen Bestandteil der Arbeitsabläufe in verschiedenen Branchen. Die Erstellung eines werbefähigen Werks mithilfe von KI ist jedoch kein Zaubertrick, da der „Voilà“-Effekt nicht immer brauchbare Ergebnisse liefert, insbesondere für diejenigen, die sich darauf verlassen, professionelle künstlerische und gestalterische Standards zu erfüllen.

Obwohl die Beherrschung des Prompt-Writings – der Sprache, die KI versteht – die Grundvoraussetzung für ein Ergebnis ist, das der eigenen kreativen Vision entspricht, weisen KI-generierte Bilder dennoch einige häufige, frustrierende Mängel auf, die nicht nur Anfänger, sondern auch erfahrene Kreative betreffen. Die Lösung dieser Probleme erfordert oft zusätzliches Wissen und Können von Nutzern und Entwicklern.

Im Folgenden beschreibe ich die häufigsten Herausforderungen bei der KI-Bilderzeugung und zeige praktische Lösungen zu deren Umgehung.

Schnelle technische Komplexität

Der Kernanreiz von KI-Bilderzeugung ist die Umwandlung von Ideen in Bilder in nahezu einem Augenblick nur mit Worten. Die Komplexität von schnelles Engineering ist dennoch eines der größten Hindernisse für die Erstellung aussagekräftiger Bilder. Schon geringfügige Abweichungen in der Formulierung können zu drastisch unterschiedlichen Ergebnissen führen. Auch die Struktur der Eingabeaufforderungen kann je nach Modell variieren. Was in einem Modell gut funktioniert, kann in einem anderen Modell zu schlechten Ergebnissen führen. Dieser Mangel an Standardisierung in der Eingabeaufforderungssprache zwingt Benutzer oft zum Ausprobieren.

Prompt-Bibliotheken und -Datenbanken reduzieren Rätselraten durch vorab getestete Prompts, die Nutzer bei Bedarf abrufen oder anpassen können. Visuelle Prompt-Generatoren ermöglichen die strukturierte Eingabe von Schlüsselwörtern, die Auswahl von Attributen, die Anpassung von Schiebereglern und vieles mehr. So wird die Erstellung effektiver Prompts intuitiver. Auch das Lernen von erfolgreichen Prompts aus der Community ist wertvoll, da diese Beispiele aus der Praxis zeigen, was funktioniert.

Um die Konsistenz zu verbessern, empfehlen standardisierte Anleitungen zur Eingabeaufforderungssyntax bewährte Methoden zur Strukturierung von Schlüsselworteingaben über verschiedene Modelle hinweg. Die Verwendung von Eingabeaufforderungsvorlagen fördert vorhersehbarere Ergebnisse und hilft Nutzern, mehrere Bilder mit einem konsistenten Stil zu erstellen. Neue Modelle wie FLUX sind insgesamt benutzerfreundlicher, da sie weniger empfindlich auf die Komplexität der Eingabeaufforderungen reagieren und es Nutzern ermöglichen, aus einfacheren Anweisungen zusammenhängende, komplexe Szenen zu erstellen.

Anatomische Ungenauigkeit

Aufgrund der Art und Weise, wie neuronale Netze aus Datensätzen lernen, verstehen Diffusionsmodelle die Anatomie nicht wirklich – sie generieren Bilder auf Grundlage von Mustererkennung statt eines strukturierten biologischen Rahmens. Beispielsweise betrachtet KI eine Hand nicht als eine Zusammensetzung aus fünf verschiedenen Fingern, die sich unterschiedlich artikulieren können. Stattdessen kombiniert sie statistische Durchschnittswerte aus Trainingsbildern. Abweichungen von erwarteten Posen oder Winkeln können daher zu Verzerrungen führen. Obwohl sich moderne Modelle deutlich verbessert haben, sind Anomalien wie zusätzliche Finger, unnatürliche Gesichts- und Körperproportionen, unrealistische Gliedmaßenverbindungen und Gelenkpositionen oder asymmetrische und falsch ausgerichtete Augen nach wie vor weit verbreitet.

Feinabstimmung von Modellen mit LoRas (Low-Rank-Adaption-Technologie) Die explizite Konzentration auf anatomische Datensätze hilft ihnen, ein umfassenderes Verständnis der menschlichen Struktur zu entwickeln. Kontrollnetze, insbesondere solche, die Posenschätzung oder Kantenerkennung (wie Canny-Filter) nutzen, ermöglichen es der KI, anatomische Richtlinien einzuhalten.

Eingabeaufforderungen, die sich speziell auf realistische Körperdetails beziehen, können die anatomische Genauigkeit der generierten Figuren verbessern. Die Nachbearbeitung mit anatomiebezogenen Korrekturwerkzeugen ermöglicht es Benutzern, fehlerhafte Bereiche zu korrigieren, ohne das gesamte Bild neu generieren zu müssen.

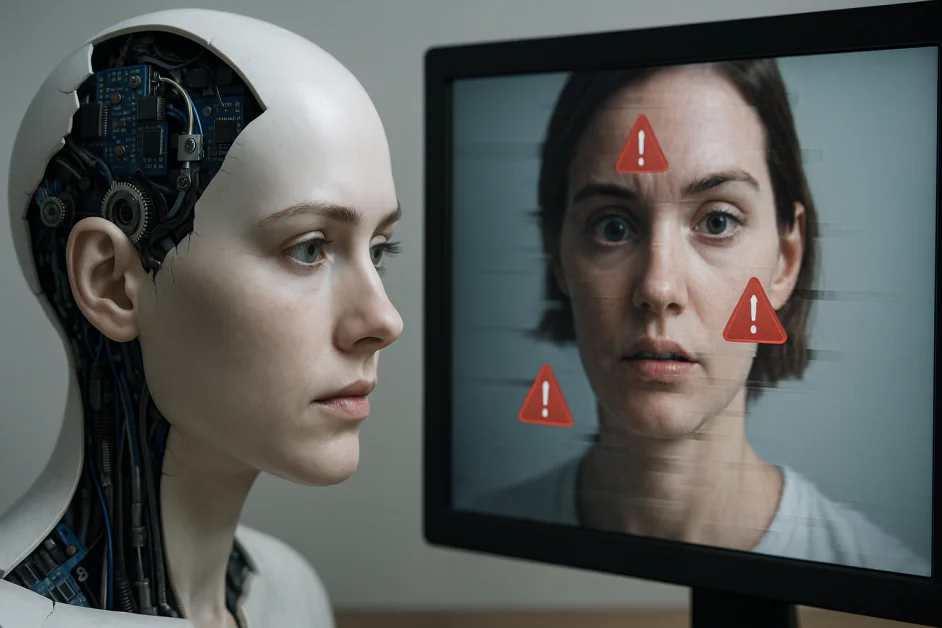

Identitätsinkonsistenz über mehrere Generationen hinweg

Da KI jede Generierung als unabhängigen Prozess behandelt, bleibt die Beibehaltung eines konsistenten Charakterbildes über mehrere Bilder hinweg eine Herausforderung. Dies ist insbesondere beim Geschichtenerzählen oder bei serienbasierten Kunstwerken problematisch, bei denen die Kontinuität der Charaktere entscheidend ist. Selbst bei Verwendung derselben Eingabeaufforderung können zwischen den Renderings subtile Änderungen in Gesichtszügen, Kleidung oder Stil auftreten. Dieses Problem kann bei Batch-Generierungen, bei denen Qualität und visuelle Merkmale unvorhersehbar schwanken, noch ausgeprägter sein.

Das Training eines LoRA anhand von Bildern einer bestimmten Person oder eines bestimmten Objekts und die Verwendung eines Referenzbilds als Eingabe kann die Identitätskonditionierung, -konsistenz und -einheitlichkeit verbessern. Einbettungstechniken und Adapter (wie PuLID, IPAdapter, InstantID und EcomID) tragen dazu bei, Charaktereigenschaften über Generationen hinweg zu bewahren. Wenn Gesichtsgenauigkeit entscheidend ist, bieten Face-Swap-Modelle oder Nachbearbeitung eine individuellere Verfeinerung und stellen sicher, dass die wichtigsten Merkmale von Generation zu Generation identisch bleiben.

Hintergrund-Inkohärenz

KI-generierte Hintergründe neigen zu unrealistischem, strukturell und kontextuell inkohärentem Design, wodurch die Bilder weniger glaubwürdig wirken. Beispielsweise kann die Perspektive unpassend wirken oder Licht und Schatten nicht zum Motiv passen. Dies liegt daran, dass Diffusionsmodelle den Hintergrund als sekundäres Element und nicht als integralen Bestandteil der Szene wahrnehmen. Dies führt zu Problemen mit der Tiefenwahrnehmung, der Objektkorrelation und dem Umgebungskontext.

Tiefenkartierung Hilft Modellen, räumliche Beziehungen genauer zu interpretieren und ermöglicht eine realistischere Integration von Vorder- und Hintergrund. Perspektivische Hilfslinien sorgen für die geometrische Ausrichtung und tragen zur Konsistenz architektonischer Strukturen und Fluchtpunkte bei. Durch gezieltes Relighting kann LoRas lernen, Licht und Schatten zusammen mit dem Hintergrund zu erzeugen und so sicherzustellen, dass sich die Reflexionen in der gesamten Szene natürlich verhalten.

Die Feinabstimmung von Modellen anhand von Datensätzen mit spezifischen Einstellungen (wie Stadtlandschaften, Naturszenen oder Innenräumen) kann den Gesamtrealismus des Hintergrunds verbessern. Referenz-Hintergrundbilder tragen außerdem dazu bei, die Generierung an realen Kompositionen zu verankern.

Probleme bei der Textwiedergabe

KI ist primär auf visuelle Daten und nicht auf strukturierte Sprache trainiert und hat daher Schwierigkeiten, lesbare Wörter und Sätze im Bild zu generieren. Der Text kann unvollständig, unverständlich, durcheinander oder unsinnig erscheinen, mit unregelmäßiger Schriftart oder falscher Platzierung. Selbst wenn er lesbar ist, kann er stilistisch unpassend wirken oder ungünstig mit dem Hintergrund verschmelzen.

Anders als Menschen erkennen die meisten KI-Modelle Text nicht als von umgebenden Elementen getrennt und verarbeiten ihn daher nicht als separate Einheit. Stattdessen behandeln sie Zeichenfolgen als ein weiteres visuelles Muster mit abstrakten Formen statt aussagekräftiger semantischer Symbole.

Um die Qualität der Textwiedergabe zu verbessern, trainieren Forscher Modelle anhand spezieller Textdatensätze mit korrekt beschrifteten Typografiebeispielen. Diese helfen der KI, Buchstabenbildung, -ausrichtung und -abstände besser zu verstehen. Textsensitive Maskierung ist eine weitere effektive Technik. Bei der Bildgenerierung werden leere Bereiche für Text reserviert, was eine sauberere Integration in der Nachbearbeitung ermöglicht.

Mangelnde Kontrolle über die Ausgabe

Obwohl die Ergebnisse optisch beeindruckend sein können, liegt eine wesentliche Einschränkung der KI-Bildgenerierung in der fehlenden präzisen Kontrolle über das Endergebnis. Benutzer haben möglicherweise Schwierigkeiten, das Modell auf bestimmte Stile auszurichten, Realismus sicherzustellen oder feine Details zu optimieren. Weitere häufige Fehler sind unerwartete Elemente in der Szene, die Atmosphäre störende Farben und inkonsistentes Layout. Im Gegensatz zu menschlichen Künstlern, die gezielt anpassen, arbeitet KI probabilistisch und führt manchmal zu überraschenden oder unerwünschten Ergebnissen.

Steuerungsmechanismen wie ControlNets und LoRas ermöglichen es Nutzern, Strukturen durch Pose, Tiefe oder Kantenführung zu präzisieren. Für eine präzisere ästhetische Steuerung können benutzerdefinierte, auf bestimmte Stile trainierte Modelle die Kohärenz der künstlerischen Ausrichtung deutlich verbessern. Darüber hinaus trägt die Referenzierung eines bestimmten Bildes durch Bild-zu-Bild-Generierung dazu bei, die Relevanz der Ausgabe zu erhalten.

Mithilfe von Maskierungs- und Inpainting-Tools können Sie bestimmte Teile eines Bildes bearbeiten, ohne den Rest zu beeinträchtigen. Nachbearbeitungstools wie Upscaler und Enhancer können KI-Ausgaben den letzten Schliff verleihen, indem sie Auflösung und Klarheit verbessern.

Insgesamt muss die KI noch eine ausgefeiltere und differenziertere Interpretation von Eingabeaufforderungen entwickeln – eine Herausforderung, die weiterhin eine der zentralen für die Aufrechterhaltung der Kontrolle darstellt. Viele Modelle neigen dazu, Anweisungen zu überinterpretieren und versuchen, tiefe oder vielschichtige Bedeutungen zu extrahieren, wo diese nicht beabsichtigt sind. Das klingt zwar intelligent, doch selbst eine detaillierte Eingabeaufforderung kann zu unvorhersehbaren Ergebnissen führen. Beispielsweise kann KI basierend auf den erlernten Assoziationen unerwartete Elemente hervorheben oder erfinden. Dies erhöht die Komplexität der Eingabeaufforderungserstellung, da sich Nutzer an die (nicht immer intuitive) Denkweise des Modells anpassen und mehr Zeit mit Formulierungsexperimenten verbringen müssen, um das gewünschte Ergebnis zu erzielen.

Fazit

Das Verständnis, wie KI visuelle Daten interpretiert – und die Erkennung ihrer Schwächen – ermöglicht es, beim Schreiben von Texten intelligentere Entscheidungen zu treffen, effektive Problemlösungsstrategien anzuwenden und die richtigen Tools zur Umgehung auftretender Generierungsfehler auszuwählen. Letztendlich ermöglicht es Nutzern, KI als kreativen Partner zu nutzen, anstatt sich auf Glück zu verlassen oder technische Einschränkungen als Hindernis bei der Erstellung nutzbarer Inhalte zu betrachten, die die Vision des Erstellers genau widerspiegeln.