Andersons Blickwinkel

Wiederherstellen und Bearbeiten menschlicher Bilder mit KI

Eine neue Zusammenarbeit zwischen der University of California Merced und Adobe bietet einen Fortschritt auf dem neuesten Stand der Technik in Vervollständigung des menschlichen Bildes – die vielfach untersuchte Aufgabe, verdeckte oder verborgene Teile von Personenbildern zu enthüllen, beispielsweise für virtuelles Anprobieren, Animation und Fotobearbeitung.

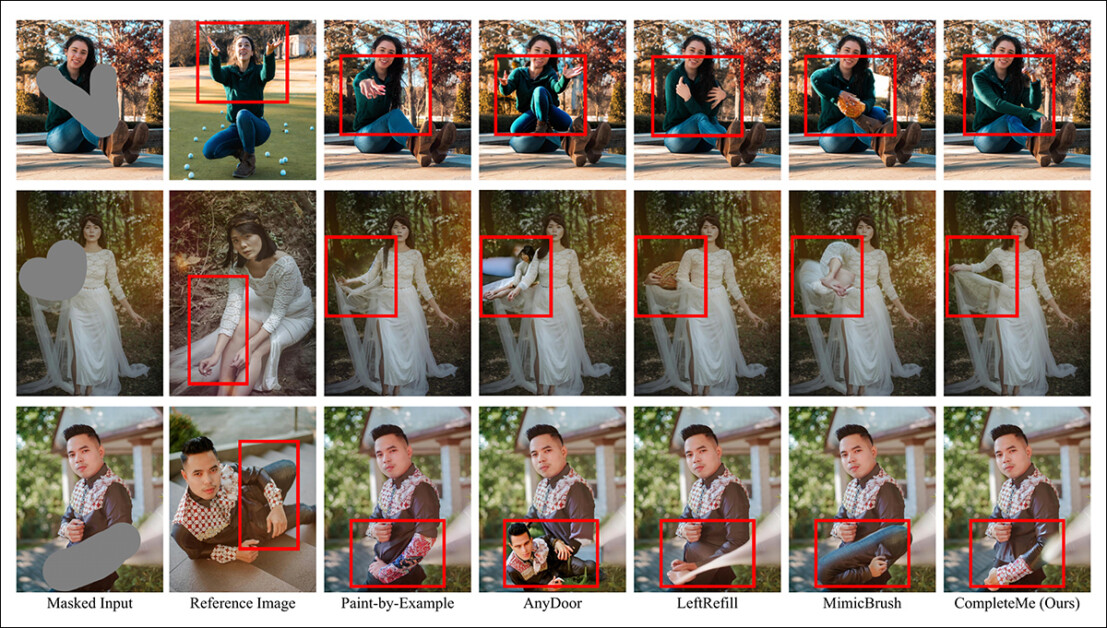

Neben der Reparatur beschädigter Bilder oder deren Änderung nach Belieben des Benutzers können menschliche Bildvervollständigungssysteme wie CompleteMe bestehende Bilder mit neuer Kleidung versehen (über ein zusätzliches Referenzbild, wie in der mittleren Spalte dieser beiden Beispiele). Diese Beispiele stammen aus dem umfangreichen ergänzenden PDF zum neuen Artikel. Quelle: https://liagm.github.io/CompleteMe/pdf/supp.pdf

Die neuer Ansatz, Betitelt CompleteMe: Referenzbasierte menschliche Bildvervollständigung, verwendet ergänzende Eingabebilder, um dem System „vorzuschlagen“, welcher Inhalt den verborgenen oder fehlenden Abschnitt der menschlichen Darstellung ersetzen soll (daher die Anwendbarkeit auf modebasierte Anprobe-Frameworks):

Das CompleteMe-System kann Referenzinhalte an den verdeckten oder verborgenen Teil eines Menschenbildes anpassen.

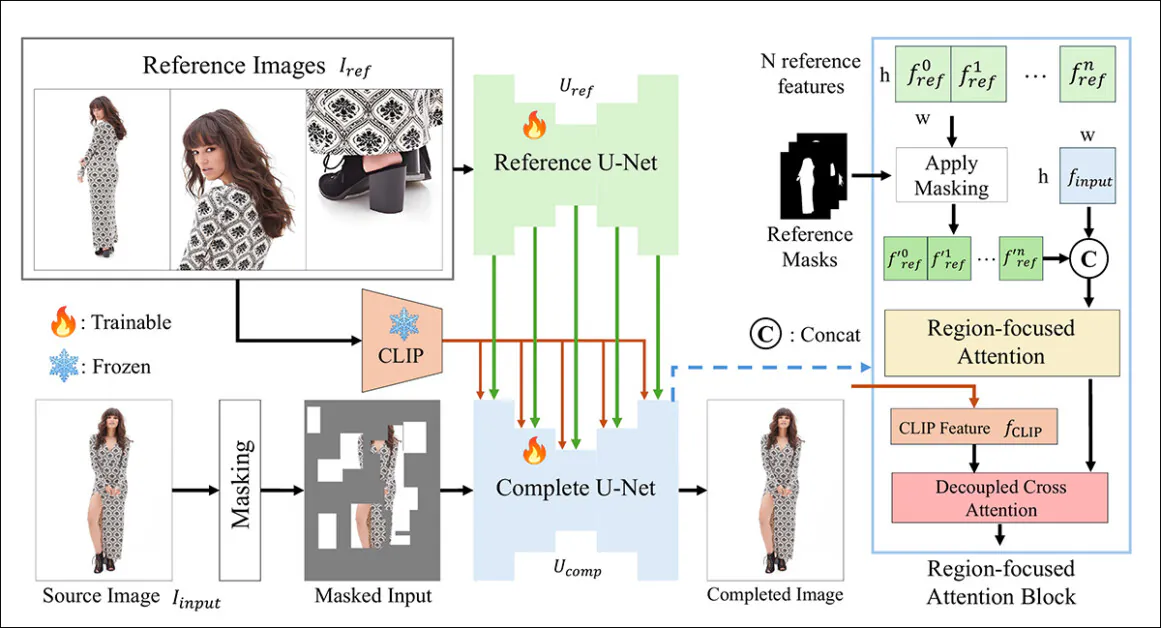

Das neue System nutzt eine duale U-Netz Architektur und eine Regionale Aufmerksamkeit (RFA)-Block, der Ressourcen in den entsprechenden Bereich der Image-Wiederherstellungsinstanz schickt.

Die Forscher bieten außerdem ein neues und anspruchsvolles Benchmark-System zur Bewertung referenzbasierter Vervollständigungsaufgaben an (da CompleteMe Teil eines bestehenden und laufenden Forschungsstrangs im Bereich Computer Vision ist, der allerdings bisher über kein Benchmark-Schema verfügte).

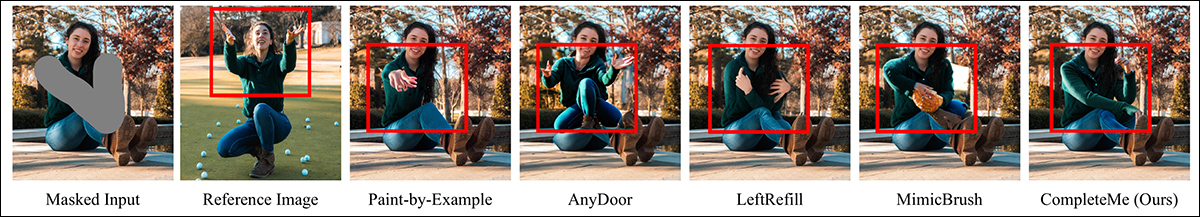

In Tests und einer gut angelegten Nutzerstudie schnitt die neue Methode in den meisten Messgrößen und insgesamt besser ab. In einigen Fällen wurden konkurrierende Methoden durch den referenzbasierten Ansatz völlig übertroffen:

Aus dem ergänzenden Material: Die AnyDoor-Methode hat besondere Schwierigkeiten bei der Entscheidung, wie ein Referenzbild zu interpretieren ist.

Das Papier sagt:

„Umfangreiche Experimente mit unserem Benchmark zeigen, dass CompleteMe im Hinblick auf quantitative Kennzahlen, qualitative Ergebnisse und Benutzerstudien den modernsten Methoden – sowohl referenzbasierten als auch nicht referenzbasierten – überlegen ist.

„Insbesondere in anspruchsvollen Szenarien mit komplexen Posen, komplizierten Kleidungsmustern und markanten Accessoires erreicht unser Modell durchweg eine überragende visuelle Wiedergabetreue und semantische Kohärenz.“

Leider ist das Projekt GitHub-Präsenz enthält keinen Code und verspricht auch keinen, und die Initiative, die auch eine bescheidene Projekt-Seite, scheint als proprietäre Architektur konzipiert zu sein.

Weiteres Beispiel für die subjektive Leistung des neuen Systems im Vergleich zu früheren Methoden. Weitere Details später im Artikel.

Methodik

Das CompleteMe-Framework basiert auf einem Referenz-U-Net, das die Integration des Zusatzmaterials in den Prozess übernimmt, und einem kohäsiven U-Net, das eine größere Bandbreite an Prozessen zur Erzielung des Endergebnisses umfasst, wie im folgenden konzeptionellen Schema dargestellt:

Das konzeptionelle Schema für CompleteMe. Quelle: https://arxiv.org/pdf/2504.20042

Das System kodiert zunächst das maskierte Eingangsbild in eine latente Repräsentation. Gleichzeitig verarbeitet das Reference U-Net mehrere Referenzbilder – jedes zeigt unterschiedliche Körperregionen –, um detaillierte räumliche Funktionen.

Diese Funktionen durchlaufen einen auf Regionen fokussierten Aufmerksamkeitsblock, der in das „komplette“ U-Net eingebettet ist, wo sie selektiv maskiert Durch die Verwendung entsprechender Bereichsmasken wird sichergestellt, dass das Modell nur auf relevante Bereiche in den Referenzbildern achtet.

Die maskierten Merkmale werden dann mit globalen CLIP-abgeleitete semantische Merkmale durch entkoppelte Queraufmerksamkeit, wodurch das Modell fehlende Inhalte sowohl detailliert als auch semantisch kohärent rekonstruieren kann.

Um den Realismus und die Robustheit zu verbessern, kombiniert der Eingabemaskierungsprozess zufällige gitterbasierte Okklusionen mit Masken der menschlichen Körperform, die jeweils mit gleicher Wahrscheinlichkeit angewendet werden, wodurch die Komplexität der fehlenden Bereiche, die das Modell vervollständigen muss, erhöht wird.

Nur als Referenz

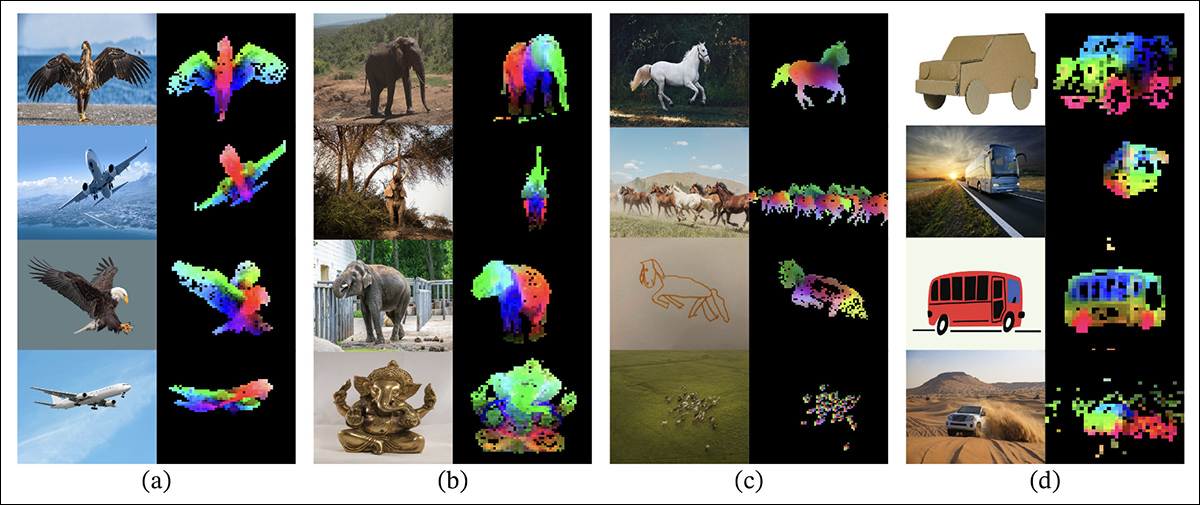

Bisherige Methoden für referenzbasiertes Bild-Inpainting beruhten typischerweise auf semantische Ebene Zu diesen Projekten gehören CLIP selbst und DINOv2, die beide globale Merkmale aus Referenzbildern extrahieren, dabei aber oft die feinen räumlichen Details verlieren, die für eine genaue Identitätserhaltung erforderlich sind.

Aus dem Release-Papier zum älteren DINOV2-Ansatz, der in den Vergleichstests der neuen Studie enthalten ist: Die farbigen Überlagerungen zeigen die ersten drei Hauptkomponenten der Hauptkomponentenanalyse (PCA), angewendet auf Bildausschnitte innerhalb jeder Spalte. Dies verdeutlicht, wie DINOv2 ähnliche Objektteile über verschiedene Bilder hinweg gruppiert. Trotz Unterschieden in Pose, Stil oder Rendering werden entsprechende Bereiche (wie Flügel, Gliedmaßen oder Räder) konsistent zugeordnet. Dies verdeutlicht die Fähigkeit des Modells, teilebasierte Strukturen ohne Aufsicht zu erlernen. Quelle: https://arxiv.org/pdf/2304.07193

CompleteMe adressiert diesen Aspekt durch ein spezialisiertes Referenz-U-Net, initialisiert von Stalldiffusion 1.5, aber ohne die Diffusionsrauschen-Schritt*.

Jedes Referenzbild, das verschiedene Körperregionen abdeckt, wird über dieses U-Net in detaillierte latente Merkmale kodiert. Globale semantische Merkmale werden ebenfalls separat mithilfe von CLIP extrahiert, und beide Merkmalssätze werden für eine effiziente Nutzung während der aufmerksamkeitsbasierten Integration zwischengespeichert. So kann das System flexibel mehrere Referenzeingaben verarbeiten und gleichzeitig feinkörnige Erscheinungsinformationen erhalten.

Orchestrierung

Das kohärente U-Net verwaltet die letzten Phasen des Fertigstellungsprozesses. Angepasst an die Inpainting-Variante von Stable Diffusion 1.5 verwendet es als Eingabe das maskierte Quellbild in latenter Form, zusammen mit detaillierten räumlichen Merkmalen aus den Referenzbildern und globalen semantischen Merkmalen, die vom CLIP-Encoder extrahiert wurden.

Diese verschiedenen Eingaben werden durch den RFA-Block zusammengeführt, der eine entscheidende Rolle dabei spielt, den Fokus des Modells auf die relevantesten Bereiche des Referenzmaterials zu lenken.

Vor dem Eintritt in den Aufmerksamkeitsmechanismus werden die Referenzmerkmale explizit maskiert, um nicht verwandte Bereiche zu entfernen, und dann mit der latenten Darstellung des Quellbilds verknüpft, um sicherzustellen, dass die Aufmerksamkeit so präzise wie möglich gelenkt wird.

Um diese Integration zu verbessern, enthält CompleteMe einen entkoppelten Cross-Attention-Mechanismus, der an die IP-Adapter Rahmen:

IP-Adapter, das teilweise in CompleteMe integriert ist, ist eines der erfolgreichsten und am häufigsten genutzten Projekte der letzten drei turbulenten Entwicklungsjahre im Bereich der Architekturen latenter Diffusionsmodelle. Quelle: https://ip-adapter.github.io/

Dadurch kann das Modell räumlich detaillierte visuelle Merkmale und einen breiteren semantischen Kontext durch separate Aufmerksamkeitsströme verarbeiten, die später kombiniert werden, was zu einer kohärenten Rekonstruktion führt, die nach Ansicht der Autoren sowohl die Identität als auch die feinkörnigen Details bewahrt.

Benchmarking

Da es keinen geeigneten Datensatz für die referenzbasierte menschliche Vervollständigung gibt, haben die Forscher einen eigenen vorgeschlagen. Der (unbenannte) Benchmark wurde durch die Kuratierung ausgewählter Bildpaare aus dem WPose-Datensatz erstellt, der für Adobe Researchs 2023 entwickelt wurde. UniHuman Projekt.

Beispiele für Posen aus dem UniHuman-Projekt von Adobe Research 2023. Quelle: https://github.com/adobe-research/UniHuman?tab=readme-ov-file#data-prep

Die Forscher zeichneten manuell Quellmasken, um die Inpainting-Bereiche anzuzeigen, und erhielten schließlich 417 dreiteilige Bildgruppen, die aus einem Quellbild, einer Maske und einem Referenzbild bestehen.

Zwei Beispiele für Gruppen, die ursprünglich aus dem Referenzdatensatz WPose abgeleitet und von den Forschern des neuen Artikels umfassend kuratiert wurden.

Die Autoren verwendeten die LLaVA Large Language Model (LLM) zum Generieren von Textaufforderungen zur Beschreibung der Quellbilder.

Die verwendeten Metriken waren umfangreicher als üblich; neben den üblichen Spitzensignal-Rausch-Verhältnis (PSNR), Struktureller Ähnlichkeitsindex (SSIM) und Erlernte perzeptuelle Bildfeldähnlichkeit (LPIPS, in diesem Fall zur Auswertung maskierter Regionen) verwendeten die Forscher DINO für Ähnlichkeitswerte; DreamSim zur Auswertung der Generierungsergebnisse und CLIP.

Daten und Tests

Um die Arbeit zu testen, verwendeten die Autoren sowohl das Standardmodell Stable Diffusion V1.5 als auch das 1.5-Inpainting-Modell. Der Bildencoder des Systems verwendete den CLIP Vision Modell, zusammen mit Projektionsebenen – einfache neuronale Netzwerke, die die CLIP-Ausgaben neu formen oder ausrichten, damit sie den vom Modell verwendeten internen Merkmalsdimensionen entsprechen.

Das Training erfolgte über 30,000 Iterationen auf acht NVIDIA A100† GPUs, betreut von Mittlere quadratische Fehler (MSE) Verlust, bei einem Losgröße von 64 und a Lernrate von 2 × 10-5. Verschiedene Elemente wurden während des Trainings zufällig weggelassen, um zu verhindern, dass das System Überanpassung auf die Daten.

Der Datensatz wurde geändert von Teile zum Ganzen Datensatz, der wiederum auf der DeepFashion-MultiModal Datensatz.

Beispiele aus dem Parts to Whole-Datensatz, der bei der Entwicklung der kuratierten Daten für CompleteMe verwendet wurde. Quelle: https://huanngzh.github.io/Parts2Whole/

Die Autoren geben an:

„Um unsere Anforderungen zu erfüllen, haben wir die Trainingspaare [neu erstellt], indem wir verdeckte Bilder mit mehreren Referenzbildern verwendet haben, die verschiedene Aspekte des menschlichen Erscheinungsbilds zusammen mit ihren kurzen Textbeschriftungen erfassen.“

„Jede Probe in unseren Trainingsdaten umfasst sechs Erscheinungstypen: Oberkörperbekleidung, Unterkörperbekleidung, Ganzkörperbekleidung, Haare oder Kopfbedeckung, Gesicht und Schuhe. Für die Maskierungsstrategie wenden wir 50 % zufällige Rastermaskierung zwischen 1 und 30 Mal an, während wir für die anderen 50 % eine Maske der menschlichen Körperform verwenden, um die Maskierungskomplexität zu erhöhen.“

„Nach der Konstruktionspipeline haben wir 40,000 Bildpaare für das Training erhalten.“

Rivale vor Nichtreferenz Die getesteten Methoden waren Vervollständigung großer verdeckter menschlicher Bilder (LOHC) und das Plug-and-Play-Bild-Inpainting-Modell BrushNet; die getesteten referenzbasierten Modelle waren Malen nach Beispiel; AnyDoor; LeftRefilleschriebenen Art und Weise; und MimicBrush.

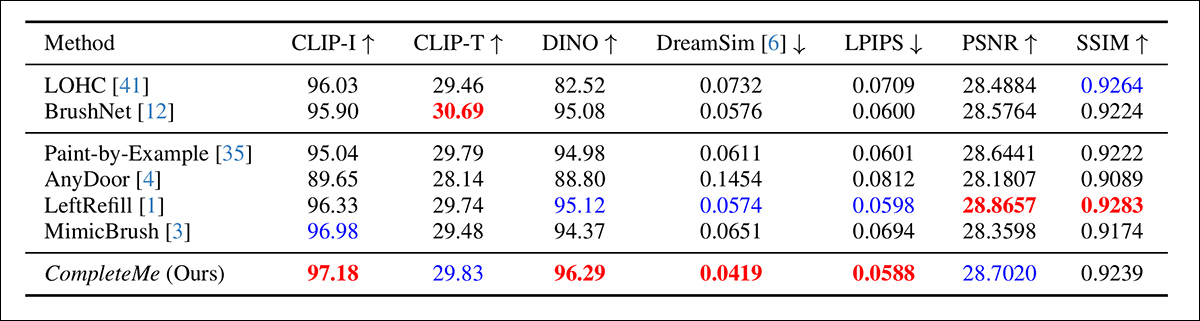

Die Autoren begannen mit einem quantitativen Vergleich der zuvor genannten Kennzahlen:

Ergebnisse des ersten quantitativen Vergleichs.

In Bezug auf die quantitative Bewertung weisen die Autoren darauf hin, dass CompleteMe bei den meisten Wahrnehmungsmetriken die höchsten Punktzahlen erzielt, darunter CLIP-I, DINO, DreamSim und LPIPS, die die semantische Ausrichtung und die Wiedergabetreue zwischen der Ausgabe und dem Referenzbild erfassen sollen.

Das Modell übertrifft jedoch nicht alle Basiswerte durchgängig. Insbesondere schneidet BrushNet bei CLIP-T am besten ab, LeftRefill führt bei SSIM und PSNR und MimicBrush schneidet bei CLIP-I leicht besser ab.

Obwohl CompleteMe insgesamt durchweg gute Ergebnisse liefert, sind die Leistungsunterschiede in einigen Fällen gering, und bestimmte Messgrößen werden weiterhin von konkurrierenden Vorgängermethoden übertroffen. Die Autoren interpretieren diese Ergebnisse als Beleg für die ausgewogene Stärke von CompleteMe sowohl in struktureller als auch in perzeptueller Hinsicht, was vielleicht nicht ganz unberechtigt ist.

Die Abbildungen der qualitativen Tests, die für die Studie durchgeführt wurden, sind viel zu zahlreich, um sie hier wiederzugeben. Wir verweisen den Leser daher nicht nur auf das Originalpapier, sondern auch auf die ausführliche ergänzendes PDF, das viele weitere qualitative Beispiele enthält.

Wir heben die wichtigsten qualitativen Beispiele hervor, die im Hauptpapier vorgestellt wurden, zusammen mit einer Auswahl zusätzlicher Fälle aus dem ergänzenden Bildpool, der zuvor in diesem Artikel vorgestellt wurde:

Erste qualitative Ergebnisse werden im Hauptartikel vorgestellt. Für eine bessere Auflösung verweisen wir auf den Originalartikel.

Zu den oben dargestellten qualitativen Ergebnissen kommentieren die Autoren:

„Bei maskierten Eingaben generieren diese nicht-referenziellen Methoden unter Verwendung von Bildvorbildern oder Textaufforderungen plausible Inhalte für die maskierten Bereiche.“

„Wie im roten Kasten angegeben, können sie jedoch keine spezifischen Details wie Tätowierungen oder einzigartige Kleidungsmuster reproduzieren, da ihnen Referenzbilder fehlen, die die Rekonstruktion identischer Informationen ermöglichen.“

Ein zweiter Vergleich, von dem unten ein Teil gezeigt wird, konzentriert sich auf die vier referenzbasierten Methoden Paint-by-Example, AnyDoor, LeftRefill und MimicBrush. Hier wurden lediglich ein Referenzbild und eine Texteingabe bereitgestellt.

Qualitativer Vergleich mit referenzbasierten Methoden. CompleteMe erzeugt realistischere Vervollständigungen und bewahrt spezifische Details des Referenzbildes besser. Die roten Kästchen markieren Bereiche von besonderem Interesse.

Die Autoren geben an:

„Mithilfe eines maskierten menschlichen Bildes und eines Referenzbildes können andere Methoden zwar plausible Inhalte erzeugen, können aber die Kontextinformationen der Referenz oft nicht genau bewahren.“

„In einigen Fällen generieren sie irrelevante Inhalte oder bilden entsprechende Teile des Referenzbilds falsch ab. CompleteMe hingegen vervollständigt den maskierten Bereich effektiv, indem es identische Informationen präzise beibehält und entsprechende Teile des menschlichen Körpers aus dem Referenzbild korrekt abbildet.“

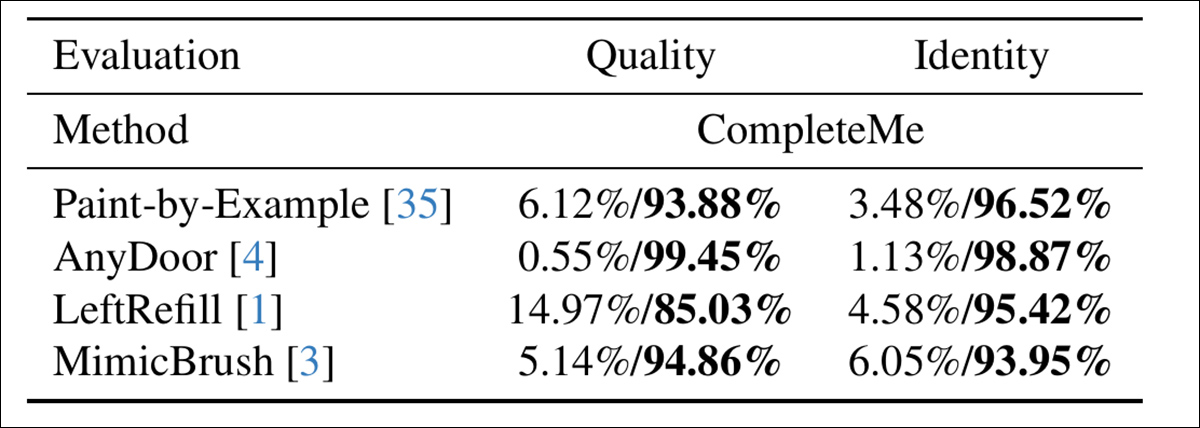

Um zu beurteilen, wie gut die Modelle mit der menschlichen Wahrnehmung übereinstimmen, führten die Autoren eine Benutzerstudie mit 15 Kommentatoren und 2,895 Beispielpaaren durch. Jedes Paar verglich die Ausgabe von CompleteMe mit einer von vier referenzbasierten Basislinien: Paint-by-Example, AnyDoor, LeftRefill oder MimicBrush.

Die Kommentatoren bewerteten jedes Ergebnis anhand der visuellen Qualität der vervollständigten Region und des Ausmaßes, in dem die Identitätsmerkmale der Referenz erhalten blieben. Bei der Bewertung der Gesamtqualität und Identität gelangte CompleteMe zu einem eindeutigeren Ergebnis:

Ergebnisse der Nutzerstudie.

Fazit

Wenn überhaupt, werden die qualitativen Ergebnisse dieser Studie durch ihren schieren Umfang untergraben, denn eine genaue Untersuchung zeigt, dass das neue System einen äußerst effektiven Einstieg in diesen relativ nischenhaften, aber heiß umkämpften Bereich der neuronalen Bildbearbeitung darstellt.

Allerdings sind etwas mehr Sorgfalt und ein Heranzoomen in die Original-PDF-Datei erforderlich, um zu erkennen, wie gut das System das Referenzmaterial im Vergleich (in fast allen Fällen) zu früheren Methoden an den verdeckten Bereich anpasst.

Wir empfehlen dem Leser dringend, die zunächst verwirrende, wenn nicht gar überwältigende Flut an Ergebnissen im ergänzenden Material sorgfältig zu prüfen.

* Es ist interessant festzustellen, dass die mittlerweile stark veraltete Version V1.5 weiterhin ein Favorit der Forscher ist – teilweise aufgrund der veralteten Like-on-Like-Tests, aber auch, weil sie von allen Stable Diffusion-Iterationen am wenigsten zensiert und möglicherweise am einfachsten zu trainieren ist und nicht die kritisches Humpeln der FOSS Flux-Versionen.

† VRAM-Spezifikation nicht angegeben – es wären entweder 40 GB oder 80 GB pro Karte.

Erstveröffentlichung: Dienstag, 29. April 2025