Künstliche Intelligenz

Mobile-Agents: Autonomer multimodaler Agent für mobile Geräte mit visueller Wahrnehmung

Das Aufkommen multimodaler großer Sprachmodelle (MLLM) hat eine neue Ära mobiler Geräteagenten eingeläutet, die in der Lage sind, die Welt über Text, Bilder und Sprache zu verstehen und mit ihr zu interagieren. Diese Agenten stellen einen erheblichen Fortschritt gegenüber herkömmlicher KI dar und bieten Benutzern eine umfassendere und intuitivere Möglichkeit, mit ihren Geräten zu interagieren. Durch die Nutzung von MLLM können diese Agenten große Mengen an Informationen aus verschiedenen Modalitäten verarbeiten und synthetisieren und so personalisierte Unterstützung anbieten und die Benutzererfahrung auf bisher unvorstellbare Weise verbessern.

Diese Agenten basieren auf modernsten maschinellen Lerntechniken und fortschrittlichen Funktionen zur Verarbeitung natürlicher Sprache, sodass sie menschenähnliche Texte verstehen und generieren sowie visuelle und akustische Daten mit bemerkenswerter Genauigkeit interpretieren können. Von der Erkennung von Objekten und Szenen in Bildern über das Verstehen gesprochener Befehle bis hin zur Analyse der Textstimmung sind diese multimodalen Agenten in der Lage, ein breites Spektrum an Eingaben nahtlos zu verarbeiten. Das Potenzial dieser Technologie ist enorm und bietet anspruchsvollere und kontextbewusstere Dienste, wie zum Beispiel virtuelle Assistenten, die auf menschliche Emotionen abgestimmt sind, und pädagogische Tools, die sich an individuelle Lernstile anpassen. Sie haben auch das Potenzial, die Zugänglichkeit zu revolutionieren und Technologie über Sprach- und Sinnesbarrieren hinweg zugänglicher zu machen.

In diesem Artikel sprechen wir über Mobile-Agents, einen autonomen multimodalen Geräteagenten, der zunächst die Fähigkeit visueller Wahrnehmungstools nutzt, um die visuellen und textlichen Elemente mit der Front-End-Schnittstelle einer mobilen Anwendung genau zu identifizieren und zu lokalisieren. Unter Verwendung dieses wahrgenommenen Visionskontexts plant und zerlegt das Mobile-Agent-Framework die komplexe Betriebsaufgabe autonom und navigiert Schritt für Schritt durch die mobilen Apps. Das Mobile-Agent-Framework unterscheidet sich von bestehenden Lösungen, da es nicht auf Metadaten mobiler Systeme oder XML-Dateien der mobilen Anwendungen angewiesen ist, was Raum für eine verbesserte Anpassungsfähigkeit an verschiedene mobile Betriebsumgebungen auf visionsorientierte Weise bietet. Der vom Mobile-Agent-Framework verfolgte Ansatz macht systemspezifische Anpassungen überflüssig, was zu einer verbesserten Leistung und geringeren Rechenanforderungen führt.

Mobile-Agents: Autonomer multimodaler Agent für mobile Geräte

In der schnelllebigen Welt der mobilen Technologie sticht ein bahnbrechendes Konzept hervor: Große Sprachmodelle, insbesondere multimodale große Sprachmodelle oder MLLMs, die in der Lage sind, eine breite Palette von Texten, Bildern, Videos und Sprache in verschiedenen Sprachen zu generieren. Die rasante Entwicklung von MLLM-Frameworks in den letzten Jahren hat zu einer neuen und leistungsstarken Anwendung von MLLMs geführt: autonome mobile Agenten. Autonome mobile Agenten sind Softwareeinheiten, die unabhängig agieren, sich bewegen und funktionieren, ohne dass direkte menschliche Befehle erforderlich sind, und die dazu konzipiert sind, Netzwerke oder Geräte zu durchqueren, um Aufgaben zu erledigen, Informationen zu sammeln oder Probleme zu lösen.

Mobile Agents dienen dazu, das mobile Gerät des Benutzers auf der Grundlage der Benutzeranweisungen und der Bildschirmvisualisierungen zu bedienen. Diese Aufgabe erfordert, dass die Agenten sowohl über semantisches Verständnis als auch über visuelle Wahrnehmungsfähigkeiten verfügen. Bestehende mobile Agenten sind jedoch alles andere als perfekt, da sie auf multimodalen großen Sprachmodellen basieren, und selbst den aktuellen hochmodernen MLLM-Frameworks, einschließlich GPT-4V, fehlen die visuellen Wahrnehmungsfähigkeiten, die für eine effiziente Funktion erforderlich sind mobiler Agent. Darüber hinaus können bestehende Frameworks zwar effektive Vorgänge generieren, haben jedoch Schwierigkeiten, die Position dieser Vorgänge genau auf dem Bildschirm zu lokalisieren, was die Anwendungen und die Fähigkeit mobiler Agenten, auf mobilen Geräten zu arbeiten, einschränkt.

Um dieses Problem zu lösen, haben sich einige Frameworks dafür entschieden, die Layoutdateien der Benutzeroberfläche zu nutzen, um GPT-4V oder andere MLLMs mit Lokalisierungsfunktionen zu unterstützen, wobei einige Frameworks es schaffen, umsetzbare Positionen auf dem Bildschirm zu extrahieren, indem sie auf die XML-Dateien der Anwendung zugreifen, während andere Frameworks es schaffen entschied sich für die Verwendung des HTML-Codes aus den Webanwendungen. Wie man sieht, sind die meisten dieser Frameworks auf den Zugriff auf zugrunde liegende und lokale Anwendungsdateien angewiesen, was die Methode nahezu wirkungslos macht, wenn das Framework nicht auf diese Dateien zugreifen kann. Um dieses Problem anzugehen und die Abhängigkeit lokaler Agenten von den zugrunde liegenden Dateien der Lokalisierungsmethoden zu beseitigen, haben Entwickler an Mobile-Agent gearbeitet, einem autonomen mobilen Agenten mit beeindruckenden visuellen Wahrnehmungsfähigkeiten. Mithilfe seines visuellen Wahrnehmungsmoduls verwendet das Mobile-Agent-Framework Screenshots vom Mobilgerät, um Vorgänge genau zu lokalisieren. Das visuelle Wahrnehmungsmodul enthält OCR- und Erkennungsmodelle, die für die Identifizierung von Text auf dem Bildschirm und die Beschreibung des Inhalts in einem bestimmten Bereich des mobilen Bildschirms verantwortlich sind. Das Mobile-Agent-Framework verwendet sorgfältig gestaltete Eingabeaufforderungen und ermöglicht eine effiziente Interaktion zwischen den Tools und den Agenten, wodurch der Betrieb mobiler Geräte automatisiert wird.

Darüber hinaus zielt das Mobile-Agents-Framework darauf ab, die kontextbezogenen Fähigkeiten moderner MLLM-Frameworks wie GPT-4V zu nutzen, um Selbstplanungsfunktionen zu erreichen, die es dem Modell ermöglichen, Aufgaben auf der Grundlage des Betriebsverlaufs, Benutzeranweisungen und Screenshots ganzheitlich zu planen. Um die Fähigkeit des Agenten, unvollständige Anweisungen und falsche Vorgänge zu erkennen, weiter zu verbessern, führt das Mobile-Agent-Framework eine Selbstreflexionsmethode ein. Unter Anleitung sorgfältig ausgearbeiteter Eingabeaufforderungen denkt der Agent kontinuierlich über fehlerhafte und ungültige Vorgänge nach und stoppt die Vorgänge, sobald die Aufgabe oder Anweisung abgeschlossen ist.

Insgesamt lassen sich die Beiträge des Mobile-Agent-Frameworks wie folgt zusammenfassen:

- Mobile-Agent fungiert als autonomer Agent für Mobilgeräte und nutzt visuelle Wahrnehmungstools zur Lokalisierung von Vorgängen. Er plant jeden Schritt methodisch und führt Selbstbeobachtung durch. Mobile-Agent nutzt ausschließlich Geräte-Screenshots und verzichtet auf den Einsatz von Systemcode. Damit präsentiert er eine Lösung, die rein auf visuellen Techniken basiert.

- Mobile-Agent stellt Mobile-Eval vor, einen Benchmark zur Bewertung von Agenten für mobile Geräte. Dieser Benchmark umfasst eine Auswahl der zehn am häufigsten verwendeten mobilen Apps sowie intelligente Anleitungen für diese Apps, kategorisiert in drei Schwierigkeitsstufen.

Mobile-Agent: Architektur und Methodik

Im Kern entspricht das Mobile-Agent-Framework dem neuesten Stand der Technik Multimodales großes Sprachmodell, das GPT-4V, ein Texterkennungsmodul, das für Textlokalisierungsaufgaben verwendet wird. Neben GPT-4V verwendet Mobile-Agent auch ein Icon-Erkennungsmodul zur Icon-Lokalisierung.

Visuelle Wahrnehmung

Wie bereits erwähnt, liefert das GPT-4V MLLM zufriedenstellende Ergebnisse für Anweisungen und Screenshots, es gelingt ihm jedoch nicht, den Ort, an dem die Vorgänge stattfinden, effektiv auszugeben. Aufgrund dieser Einschränkung muss das Mobile-Agent-Framework, das das GPT-4V-Modell implementiert, auf externe Tools zurückgreifen, um die Lokalisierung von Vorgängen zu unterstützen und so die Ausgabe von Vorgängen auf dem mobilen Bildschirm zu erleichtern.

Textlokalisierung

Das Mobile-Agent-Framework implementiert ein OCR-Tool, um die Position des entsprechenden Textes auf dem Bildschirm zu erkennen, wann immer der Agent auf einen bestimmten Text tippen muss, der auf dem mobilen Bildschirm angezeigt wird. Es gibt drei einzigartige Textlokalisierungsszenarien.

Szenario 1: Kein angegebener Text erkannt

Problem: Die OCR erkennt den angegebenen Text nicht, was bei komplexen Bildern oder aufgrund von OCR-Einschränkungen der Fall sein kann.

Antwort: Weisen Sie den Agenten an, entweder:

- Wählen Sie den Text erneut aus, um ihn zu antippen und eine manuelle Korrektur des OCR-Fehlers zu ermöglichen, oder

- Wählen Sie einen alternativen Vorgang, z. B. die Verwendung einer anderen Eingabemethode oder das Ausführen einer anderen Aktion, die für die jeweilige Aufgabe relevant ist.

Argumentation: Diese Flexibilität ist notwendig, um gelegentliche Ungenauigkeiten oder Halluzinationen von GPT-4V zu bewältigen und sicherzustellen, dass der Agent weiterhin effektiv vorgehen kann.

Szenario 2: Einzelne Instanz des angegebenen Texts erkannt

Bedienung: Generieren Sie automatisch eine Aktion zum Klicken auf die Mittelkoordinaten des erkannten Textfelds.

Rechtfertigung: Da nur eine Instanz erkannt wird, ist die Wahrscheinlichkeit einer korrekten Identifizierung hoch, sodass es effizient ist, mit einer direkten Aktion fortzufahren.

Szenario 3: Mehrere Instanzen des angegebenen Texts erkannt

Bewertung: Bewerten Sie zunächst die Anzahl der erkannten Instanzen:

Viele Instanzen: Zeigt an, dass der Bildschirm mit ähnlichen Inhalten überfüllt ist, was den Auswahlprozess erschwert.

Aktion: Bitten Sie den Agenten, den Text erneut auszuwählen, um die Auswahl zu verfeinern oder die Suchparameter anzupassen.

Einige Fälle: Eine überschaubare Anzahl von Erkennungen ermöglicht eine differenziertere Vorgehensweise.

Aktion: Schneiden Sie die Bereiche um diese Instanzen zu und erweitern Sie die Texterkennungsfelder nach außen, um zusätzlichen Kontext zu erfassen. Durch diese Erweiterung wird sichergestellt, dass mehr Informationen erhalten bleiben, was die Entscheidungsfindung erleichtert.

Nächster Schritt: Zeichnen Sie Erkennungsfelder auf die zugeschnittenen Bilder und präsentieren Sie sie dem Agenten. Diese visuelle Unterstützung hilft dem Agenten bei der Entscheidung, mit welcher Instanz er interagieren möchte, basierend auf kontextuellen Hinweisen oder Aufgabenanforderungen.

Dieser strukturierte Ansatz optimiert die Interaktion zwischen OCR-Ergebnissen und Agentenoperationen und verbessert die Zuverlässigkeit und Anpassungsfähigkeit des Systems bei der Bearbeitung textbasierter Aufgaben in verschiedenen Szenarien. Der gesamte Prozess wird in der folgenden Abbildung veranschaulicht.

Symbollokalisierung

Das Mobile-Agent-Framework implementiert ein Symbolerkennungstool, um die Position eines Symbols zu lokalisieren, wenn der Agent auf dem mobilen Bildschirm darauf klicken muss. Genauer gesagt fordert das Framework den Agenten zunächst auf, bestimmte Attribute des Bildes bereitzustellen, einschließlich Form und Farbe, und implementiert dann die Grounding DINO-Methode mit dem Eingabeaufforderungssymbol, um alle im Screenshot enthaltenen Symbole zu identifizieren. Endlich, Mobile-Agent verwendet das CLIP-Framework, um die Ähnlichkeit zwischen der Beschreibung des Klickbereichs zu berechnen, berechnet die Ähnlichkeit zwischen den gelöschten Symbolen und wählt den Bereich mit der höchsten Ähnlichkeit für einen Klick aus.

Befehlsausführung

Um die Aktionen der Agenten in Operationen auf dem Bildschirm umzusetzen, definiert das Mobile-Agent-Framework 8 verschiedene Operationen.

- Anwendung starten (App-Name): Starten Sie die gewünschte Anwendung über die Desktop-Oberfläche.

- Tippen Sie auf Text (Textbeschriftung): Interagieren Sie mit dem Bildschirmbereich, in dem die Beschriftung „Textbeschriftung“ angezeigt wird.

- Mit dem Symbol interagieren (Symbolbeschreibung, Position): Zielen Sie auf den angegebenen Symbolbereich und tippen Sie darauf, wo unter „Symbolbeschreibung“ Attribute wie Farbe und Form des Symbols aufgeführt sind. Wählen Sie „Standort“ aus Optionen wie „Oben“, „Unten“, „Links“, „Rechts“ oder „Mitte“ und kombinieren Sie möglicherweise zwei für eine präzise Navigation und um Fehler zu reduzieren.

- Text eingeben (Eingabetext): Geben Sie den angegebenen „Eingabetext“ in das aktive Textfeld ein.

- Nach oben und unten scrollen: Navigieren Sie nach oben oder unten durch den Inhalt der aktuellen Seite.

- Geh zurück: Kehren Sie zur zuvor angezeigten Seite zurück.

- Close: Navigieren Sie direkt vom aktuellen Bildschirm zurück zum Desktop.

- Lahm: Schließen Sie den Vorgang ab, sobald die Aufgabe erledigt ist.

Selbstplanung

Jeder Schritt der Operation wird vom Framework iterativ ausgeführt, und vor Beginn jeder Iteration muss der Benutzer eine Eingabeanweisung bereitstellen, und das Mobile-Agent-Modell verwendet die Anweisung, um eine Systemaufforderung für den gesamten Prozess zu generieren. Darüber hinaus erfasst das Framework vor Beginn jeder Iteration einen Screenshot und leitet ihn an den Agenten weiter. Der Agent beobachtet dann den Screenshot, den Vorgangsverlauf und die Systemaufforderungen, um den nächsten Schritt der Vorgänge auszugeben.

Selbstreflexion

Während seiner Operationen kann der Agent auf Fehler stoßen, die ihn an der erfolgreichen Ausführung eines Befehls hindern. Um die Anweisungserfüllungsrate zu verbessern, wurde ein Selbstevaluierungsansatz implementiert, der unter zwei bestimmten Umständen aktiviert wird. Führt der Agent eine fehlerhafte oder ungültige Aktion aus, die den Fortschritt stoppt (z. B. wenn er erkennt, dass der Screenshot nach der Operation unverändert bleibt oder eine falsche Seite anzeigt), wird er angewiesen, alternative Aktionen in Betracht zu ziehen oder die Parameter der bestehenden Operation anzupassen. Zweitens kann es vorkommen, dass der Agent einige Elemente einer komplexen Anweisung übersieht. Nachdem der Agent eine Reihe von Aktionen basierend auf seinem ursprünglichen Plan ausgeführt hat, wird er aufgefordert, seine Aktionssequenz, den letzten Screenshot und die Anweisung des Benutzers zu überprüfen, um festzustellen, ob die Aufgabe abgeschlossen wurde. Werden Unstimmigkeiten festgestellt, wird der Agent beauftragt, selbstständig neue Aktionen zu generieren, um die Anweisung zu erfüllen.

Mobile-Agent: Experimente und Ergebnisse

Um seine Fähigkeiten umfassend zu bewerten, führt das Mobile-Agent-Framework den Mobile-Eval-Benchmark ein, der aus 10 häufig verwendeten Anwendungen besteht, und entwirft drei Anweisungen für jede Anwendung. Der erste Vorgang ist unkompliziert und deckt nur grundlegende Anwendungsvorgänge ab, während der zweite Vorgang etwas komplexer als der erste ist, da er einige zusätzliche Anforderungen mit sich bringt. Schließlich ist die dritte Operation die komplexeste von allen, da sie abstrakte Benutzeranweisungen enthält, bei denen der Benutzer nicht explizit angibt, welche App verwendet oder welche Operation ausgeführt werden soll.

Um die Leistung aus verschiedenen Perspektiven zu bewerten, entwirft und implementiert das Mobile-Agent-Framework vier verschiedene Metriken.

- Su oder Erfolg: Wenn der mobile Agent die Anweisungen ausführt, gilt dies als Erfolg.

- Prozessbewertung oder PS: Die Prozessbewertung misst die Genauigkeit jedes Schritts während der Ausführung der Benutzeranweisungen und wird berechnet, indem die Anzahl der korrekten Schritte durch die Gesamtzahl der Schritte dividiert wird.

- Relative Effizienz oder RE: Der relative Effizienzwert ist ein Verhältnis oder Vergleich zwischen der Anzahl der Schritte, die ein Mensch benötigt, um die Anweisung manuell auszuführen, und der Anzahl der Schritte, die der Agent benötigt, um dieselbe Anweisung auszuführen.

- Abschlussrate oder CR: Die Abschlussratenmetrik dividiert die Anzahl der vom Menschen ausgeführten Schritte, die das Framework erfolgreich abschließt, durch die Gesamtzahl der Schritte, die ein Mensch zum Abschließen der Anweisung unternimmt. Der Wert von CR ist 1, wenn der Agent die Anweisung erfolgreich abschließt.

Die Ergebnisse sind in der folgenden Abbildung dargestellt.

Zunächst erreichte der Mobile-Agent für die drei gestellten Aufgaben Abschlussquoten von 91 %, 82 % bzw. 82 %. Obwohl nicht alle Aufgaben fehlerfrei ausgeführt wurden, lag die Erfolgsquote für jede Aufgabenkategorie bei über 90 %. Darüber hinaus zeigt die PS-Metrik, dass der Mobile-Agent für die drei Aufgaben stets eine hohe Wahrscheinlichkeit aufweist, präzise Aktionen auszuführen, mit Erfolgsquoten von etwa 80 %. Laut der RE-Metrik weist der Mobile-Agent zudem eine Effizienz von 80 % bei der Ausführung von Vorgängen auf einem Niveau auf, das mit der menschlichen Optimalität vergleichbar ist. Diese Ergebnisse unterstreichen insgesamt die Kompetenz des Mobile-Agent als mobiler Geräteassistent.

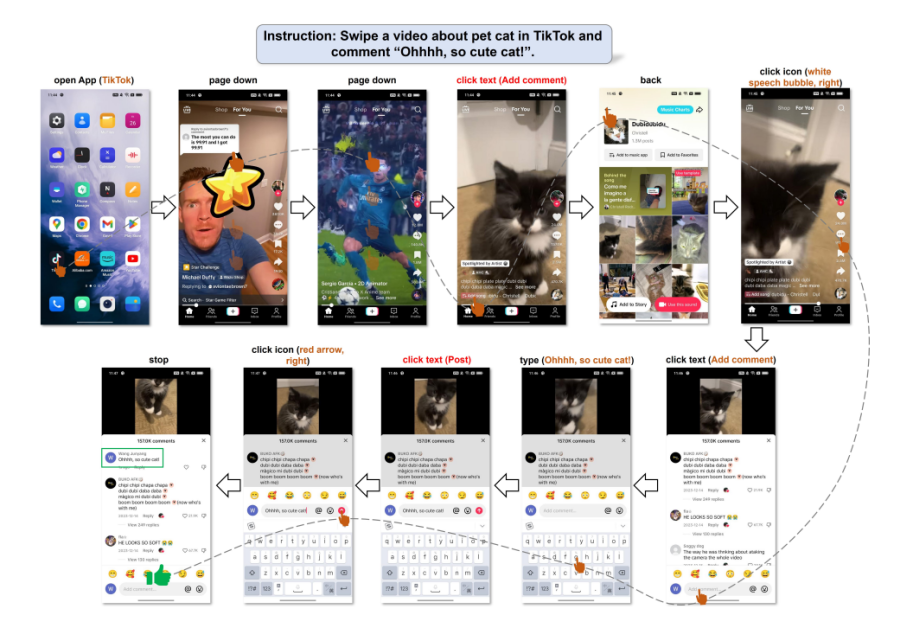

Die folgende Abbildung veranschaulicht die Fähigkeit des Mobile-Agenten, Benutzerbefehle zu erfassen und seine Aktionen selbstständig zu orchestrieren. Auch ohne explizite Details in den Anweisungen interpretierte der Mobile-Agent die Benutzeranforderungen geschickt und setzte sie in umsetzbare Aufgaben um. Auf dieser Grundlage führte der Agent die Anweisungen mithilfe eines systematischen Planungsprozesses aus.

Fazit

In diesem Artikel haben wir über Mobile-Agents gesprochen, einen multimodalen autonomen Geräteagenten, der zunächst visuelle Wahrnehmungstechnologien nutzt, um sowohl visuelle als auch textuelle Komponenten innerhalb der Benutzeroberfläche einer mobilen Anwendung präzise zu erkennen und zu lokalisieren. Mit diesem visuellen Kontext im Hinterkopf skizziert und zerlegt das Mobile-Agent-Framework die komplexen Aufgaben selbstständig in überschaubare Aktionen und ermöglicht so eine reibungslose Schritt-für-Schritt-Navigation durch mobile Anwendungen. Dieses Framework hebt sich von bestehenden Methoden ab, da es nicht von den Metadaten des mobilen Systems oder den XML-Dateien der mobilen Apps abhängt. Dadurch ermöglicht es eine größere Flexibilität über verschiedene mobile Betriebssysteme hinweg und konzentriert sich auf die visuell zentrierte Verarbeitung. Die vom Mobile-Agent-Framework verwendete Strategie macht systemspezifische Anpassungen überflüssig, was zu verbesserter Effizienz und geringerem Rechenaufwand führt.