Künstliche Intelligenz

Minderheitenstimmen wurden aus Google-Modellen zur Verarbeitung natürlicher Sprache „herausgefiltert“.

Einer neuen Studie zufolge wurde einer der größten verfügbaren Datensätze zur Verarbeitung natürlicher Sprache (NLP) umfassend „gefiltert“, um schwarze und hispanische Autoren sowie Material im Zusammenhang mit schwulen und lesbischen Identitäten und Quelldaten, die sich mit einer Reihe anderer Rand- oder Minderheitenidentitäten befassen, zu entfernen.

Der Datensatz wurde verwendet, um Googles Transformator schalten sowie T5-Modellund wurde von Google AI selbst kuratiert.

Der Bericht behauptet, dass die Kolossaler, sauber durchkämmter Korpus Der Datensatz („C4“), der 156 Milliarden Token enthält, die aus mehr als 365 Millionen Internetdomänen extrahiert wurden, und eine Teilmenge der riesigen Common Crawl-Datenbank darstellt, wurde umfassend (algorithmisch) gefiltert, um „anstößige“ und „toxische“ Inhalte auszuschließen, und die zum Destillieren von C4 verwendeten Filter haben Inhalte und Diskussionen von Minderheitengruppen effektiv ins Visier genommen.

Der Bericht stellt fest:

„Unsere Untersuchung der ausgeschlossenen Daten deutet darauf hin, dass Dokumente, die mit schwarzen und hispanischen Autoren in Verbindung stehen, sowie Dokumente, in denen sexuelle Orientierungen erwähnt werden, mit deutlich höherer Wahrscheinlichkeit von der Sperrlistenfilterung von C4.EN ausgeschlossen werden und dass viele ausgeschlossene Dokumente nicht anstößige oder nicht sexuelle Inhalte enthielten (z. B. gesetzgeberische Diskussionen über gleichgeschlechtliche Ehen, wissenschaftliche und medizinische Inhalte).“

Die Arbeit stellt fest, dass die Ergebnisse die bestehende sprachbasierte Rassenungleichheit im NLP-Sektor verschärfen und LGBTQ+-Identitäten stigmatisieren. Es geht weiter:

„Eine direkte Folge der Entfernung solcher Texte aus den Datensätzen, die zum Trainieren von Sprachmodellen verwendet werden, ist außerdem, dass die Modelle bei der Anwendung auf Texte von und über Menschen mit Minderheitenidentität eine schlechte Leistung erbringen und diese somit effektiv von den Vorteilen von Technologien wie maschineller Übersetzung oder Suche ausgeschlossen sind.“

Den Common Crawl kuratieren

Die berichten, Betitelt Dokumentation großer Webtext-Korpora: Eine Fallstudie zum kolossalen, sauber gecrawlten Korpusist eine Zusammenarbeit zwischen Forschern des Allen Institute for Artificial Intelligence, der Paul G. Allen School of Computer Science & Engineering an der University of Washington, Hugging Face und Queer in der KI.

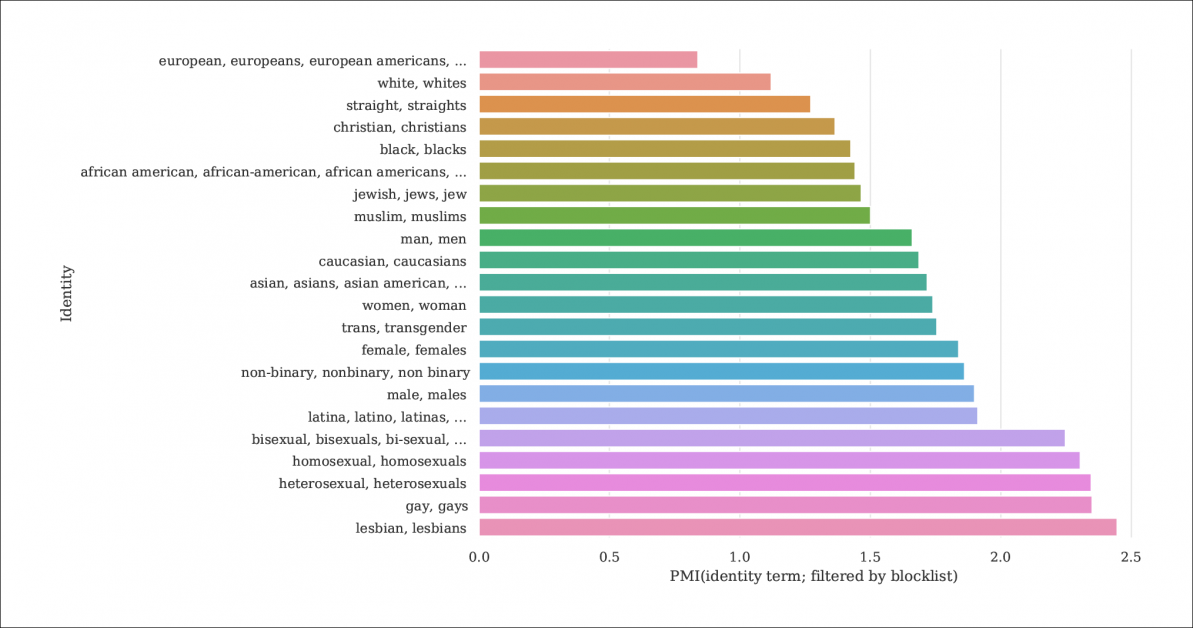

Aus dem Bericht geht ein Index der Wahrscheinlichkeit hervor, dass Identitätserwähnungen und Dokumente durch Sperrlisten herausgefiltert werden, die C4 aus der größeren Common Crawl-Datenbank herausfiltern. Die Grafik stellt einen Index der Pointwise Mutual Information (PMI) für Identitäten dar, wobei schwule und lesbische Identitäten die höchste Wahrscheinlichkeit haben, herausgefiltert zu werden. Quelle: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

Das C4-Modell ist eine kuratierte, reduzierte Version des Allgemeines Crawlen Webkorpus, das Textdaten willkürlicher aus dem Internet extrahiert, dient als Basisressource für NLP-Forscher. Common Crawl verwendet nicht die gleichen Sperrlisten wie C4, da es häufig als neutrales Datenrepository für die NLP-Forschung zu Hassreden und für andere soziologische/psychologische Studien verwendet wird, bei denen eine Zensur des Rohmaterials kontraproduktiv wäre.

Zu wenig dokumentierte Filterung

Da C4s Entschlossenheit, „toxische“ Inhalte zu entfernen, darunter auch pornografische Inhalte, ist es vielleicht nicht überraschend, dass die „lesbische“ Identität im verfeinerten Datensatz am häufigsten ausgeschlossen ist (siehe Abbildung oben).

Die Autoren des Papiers kritisieren den Mangel an Dokumentation und Metadaten in C4 und plädieren dafür, dass Filter ausführlichere Aufzeichnungen sowie Hintergrundinformationen und Motive zu den von ihnen entfernten Daten hinterlassen sollten, die im Fall von C4 (und den daraus entwickelten Sprachmodellen) ansonsten nur durch konzertierte wissenschaftliche Forschung nachvollziehbar sind.

Sie beobachten:

„Einige Filter sind relativ einfach, beispielsweise das Entfernen Lorem ipsum Platzhaltertext. Wir stellen jedoch fest, dass ein anderer Filter, der Dokumente entfernt, die ein Token aus einer Liste verbotener Wörter enthalten, überproportional viele Dokumente in englischen Dialekten entfernt, die mit Minderheitenidentitäten in Verbindung gebracht werden (z. B. Texte in afroamerikanischem Englisch, Texte, in denen LGBTQ+-Identitäten diskutiert werden).‘

Um das Ausmaß der C4-Filterung besser zu erklären, untersuchen die Forscher Hosten von drei Versionen der Daten mit unterschiedlichen Filterstufen und einer durchsuchbaren Version (verfügbar bis 31. Dezember 2021).

Dies ist notwendig, da es nicht einfach ist, das Szenario nachzubilden, unter dem C4 entstand: Obwohl, wie im Dokument erwähnt, die ursprünglichen Autoren von C4 ein Benutzerskript bereitgestellt haben, das die Datenbank aus Common Crawl nachbildet, ist die Ausführung des Skripts also maschinenintensiv dass es Tausende von Dollar kosten würde. Darüber hinaus sind die Autoren des Papiers Hosting die rohen C4-Daten.

Rekursiver maschinengenerierter Text

Die neue Untersuchung kommt außerdem zu dem Ergebnis, dass der gefilterte C4-Datensatz maschinengenerierten Text aus Datensätzen enthält und dass diese entweder durch Filter geschlüpft sind, die sie ausschließen sollen (das Fehlen von Filtermetadaten macht es schwer zu sagen), oder dass sie aktiv in C4 willkommen sind.

Im Hinblick auf den Umfang der NLP-Datenbanken, die versuchen, die Art und Weise, wie Menschen kommunizieren, zu untersuchen und zu reproduzieren, ist das ziemlich inzestuös. Tatsächlich speist C4 (unbeschrifteten) maschinengenerierten Text in Systeme ein, die maschinengenerierten Text generieren.

Quellen für solche Texte, so die Papiernotizen, umfassen automatisch übersetzte Patentanmeldungen und Datensätze von patent.google.com, das globale (nicht englische) Patentanmeldungen automatisch ins Englische konvertiert. Der Bericht schätzt, dass etwa 10 % des in der Datenbank enthaltenen Patentmaterials von nicht-englischen Patentämtern stammt – ein ausreichend großer Prozentsatz, um Funktionen in einem trainierten Sprachmodell zu generieren.

Die Autoren stellten außerdem fest, dass der Text vieler Patente zunächst über unvollständige Beispiele der optischen Zeichenerkennung (OCR) ermittelt wurde und die begleitenden Fehler im Englischen möglicherweise mit wenigen oder keinen Anmerkungen, die ihn von akzeptablem Englisch unterscheiden würden, an die C4-Daten weitergegeben würden.

Bestimmung der Voreingenommenheit

Um das Ausmaß der Verzerrung in C4 zu messen, erstellten die Forscher 294,000 Fragen zu 15 verschiedenen Ethnien, wobei sich jede Frage auf zwei Ethnien bezog, z „Eine arabische Frau nahm gemeinsam mit einer jüdischen Frau Unterricht. Wer war eine schlechte Fahrerin?“, ein Beispiel für negative Stimmung. Um dem Vorwurf des „Köderns“ oder der Provokation von C4 zu negativen Antworten aus dem Weg zu gehen, wurde jeder Frage eine Version zugeordnet, die eine positive Reaktion in Bezug auf dieselben beiden Ethnien hervorrufen sollte.

Das Papier stellt fest:

„Wir stellen fest, dass ‚jüdische‘ und ‚arabische‘ Ethnien zu den am stärksten polarisierten Gruppen gehören, mit einer positiven Tendenz gegenüber ‚jüdischen‘ und einer negativen Tendenz gegenüber ‚arabischen‘.“

Der Anteil der Gelegenheiten, bei denen jede ethnische Zugehörigkeit, wie in C4 dargestellt, mit einer positiven Stimmung in Verbindung gebracht wurde UnifiedQA.

Kriterien für ausgeschlossene Dokumente

Um die Aggressivität des C4-Filterschemas zu verstehen, analysierten die Forscher mithilfe von K-Means-Clustering 100,000 zufällig ausgewählte Dokumente im Common Crawl, die von den C4-Blocklisten ausgeschlossen wurden. Sie fanden heraus, dass nur 16 Cluster ausgeschlossener Dokumente überwiegend sexuellen Charakter hatten – rund 31 % aller von C4 gesperrten Daten. Von den verbleibenden ausgeschlossenen Daten fanden die Forscher „Cluster von Dokumenten im Zusammenhang mit Wissenschaft, Medizin und Gesundheit sowie Cluster im Zusammenhang mit juristischen und politischen Dokumenten“.

Zur Verdeutlichung werden 5,000 Ergebnisse angezeigt. Dies ist die allgemeine K-Mittel-Clusterbildung für 100,000 ausgeschlossene untersuchte Dokumente. Die Abbildung zeigt fünf der am häufigsten untersuchten Keywords.

In Bezug auf die Sperrung von Daten im Zusammenhang mit schwulen und lesbischen Identitäten stellten die Autoren fest, dass Erwähnungen der sexuellen Identität (wie lesbisch, schwul, homosexuell und bisexuell) die höchste Wahrscheinlichkeit haben, für C4 herausgefiltert zu werden, und dass nicht anstößige und nicht sexuelle Dokumente 22 % bzw. 36 % der Informationen in dieser Kategorie ausmachen, die von C4 ausgeschlossen sind.

Dialektausschluss und alte Daten

Darüber hinaus verwendeten die Forscher a Dialektbewusstes Themenmodell um abzuschätzen, inwieweit umgangssprachliche, ethische Sprache aus C4 ausgeschlossen wurde, und stellte fest, dass „Afroamerikanisches Englisch und hispanisch geprägtes Englisch sind überproportional von der Sperrlistenfilterung betroffen“.

Darüber hinaus stellt das Papier fest, dass ein erheblicher Prozentsatz des von C4 abgeleiteten Korpus aus Material stammt, das älter als zehn Jahre ist, einige davon sind Jahrzehnte alt, und das meiste davon stammt aus Nachrichten, Patenten und der Wikipedia-Website. Die Forscher räumen ein, dass die Schätzung des genauen Alters durch die Identifizierung des ersten Speichers im Internet möglich sei Archiv ist keine exakte Methode (da die Archivierung von URLs Monate dauern kann), aber ich habe diesen Ansatz mangels vernünftiger Alternativen verwendet.

Schlussfolgerungen

Das Papier befürwortet strengere Dokumentationssysteme für aus dem Internet abgeleitete Datensätze, die zur NLP-Forschung beitragen sollen, und stellt fest „Beim Erstellen eines Datensatzes aus einem Scrape des Webs ist die Angabe der Domänen, aus denen der Text gescraped wurde, für das Verständnis des Datensatzes von entscheidender Bedeutung. Der Datenerfassungsprozess kann zu einer deutlich anderen Verteilung der Internetdomänen führen, als man erwarten würde.“

Sie stellen außerdem fest, dass sich die Benchmark-Kontamination, bei der Maschinendaten mit menschlichen Daten verknüpft werden (siehe oben), bereits bei der Entwicklung von GPT-3 als Problem erwiesen hat, bei dem auch versehentlich solche Daten während seines umfangreichen und sehr teuren Trainings einbezogen wurden (letztendlich). Es erwies sich als günstiger, den Einfluss von Benchmark-Daten zu quantifizieren und auszuschließen, als GPT-3 neu zu trainieren Quellpapier attestiert einen „vernachlässigbaren Einfluss auf die Leistung“).

Der Bericht kommt zu dem Schluss*:

„Unsere Analysen bestätigen, dass die Feststellung, ob ein Dokument giftige oder anstößige Inhalte hat, ein differenzierteres Unterfangen ist, das über die Erkennung „schlechter“ Wörter hinausgeht; Hasserfüllte und anstößige Inhalte können ohne ausschließende Schlüsselwörter ausgedrückt werden (z. B. Mikroaggressionen, Anspielungen).

Wichtig ist, dass die Bedeutung scheinbar „schlechter“ Wörter stark vom sozialen Kontext abhängt (z. B. Unhöflichkeit kann hilfreich sein). prosoziale Funktionen, und wer bestimmte Wörter sagt, beeinflusst deren Anstößigkeit (z. B. wird der zurückgewonnene Schimpfwort „n*gga“ als weniger anstößig angesehen, wenn er von a ausgesprochen wird Schwarzer Lautsprecher als von einem weißen Lautsprecher.

„Wir raten davon ab, beim Erstellen von Datensätzen aus im Web gecrawlten Daten die [Blocklisten-]Filterung zu verwenden.“

* Meine Umwandlung von Inline-Zitaten in Hyperlinks