Andersons Blickwinkel

HIPAA kann zunehmend nicht verhindern, dass KI Patientendaten de-anonymisiert.

Selbst nachdem Krankenhäuser Namen und Postleitzahlen entfernt haben, kann moderne KI manchmal immer noch die Identität von Patienten ermitteln. Gute Nachrichten für Versicherungen; weniger gut für Patienten.

Neue Forschungsergebnisse der New York University zeigen, dass die Krankenakten von US-Patienten, denen Namen und andere Informationen fehlen, … HIPAA-Kennungen, kann Patienten aussetzen NeuidentifizierungDurch das Training von KI-Sprachmodellen mit einem großen Korpus realer, unzensierter Patientendaten bleiben identitätsbestimmende Details erhalten – in einigen Fällen ermöglichen sie sogar Rückschlüsse auf die Wohngegend eines Patienten. alleinige Diagnose.

Die neue Studie stellt dieses Risiko in den Kontext einer lukrativer Markt in anonymisierten Gesundheitsdaten, wo Krankenhäuser und Datenbroker routinemäßig bereinigte klinische Aufzeichnungen an Pharmaunternehmen, Versicherer und KI-Entwickler verkaufen oder lizenzieren.

Die Autoren der neuen Studie stellen sogar das Konzept der „Anonymisierung“ in Frage, das in den von ihnen etablierten Patientenschutzbestimmungen verankert ist. HIPAA nachdem der Gouverneur von Massachusetts, William Weld, seine medizinischen Daten erhalten hat 1997 de-anonymisiert:

„Selbst bei vollständiger Einhaltung der Safe-Harbor-Bestimmungen bleiben anonymisierte Notizen statistisch mit der Identität verknüpft, und zwar durch eben jene Korrelationen, die ihren klinischen Nutzen bestätigen. Der Konflikt ist struktureller und nicht technischer Natur.“

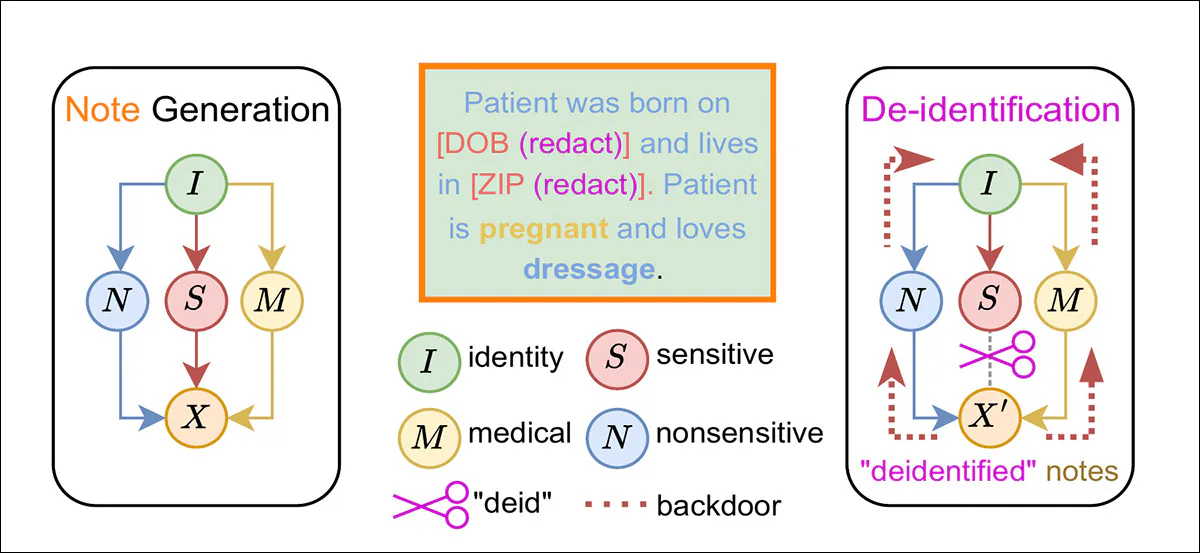

Die Forscher argumentieren, dass die derzeitigen, HIPAA-konformen Anonymisierungsframeworks zwei Hintertüren für sogenannte „Verknüpfungsangriffe“ offenlassen:

In der neuen Studie wird ein Kausaldiagramm vorgestellt, das veranschaulicht, wie die Anonymisierung nach HIPAA-Vorschriften explizit sensible Attribute entfernt, während identitätsbezogene Korrelationen erhalten bleiben, sodass die Identität des Patienten anhand nicht-sensibler und medizinischer Informationen abgeleitet werden kann. Quelle

Im obigen Beispiel sehen wir nicht nur, dass die Patientin schwanger ist – was bei der Anonymisierung am einfachsten ist, da dadurch das biologische Geschlecht eindeutig festgestellt wird –, sondern auch, dass sie ein Hobby pflegt, das laut den Forschern nicht mit einkommensschwächeren Bevölkerungsgruppen in Verbindung gebracht wird:

„Obwohl die geschützten Merkmale (Geburtsdatum und Postleitzahl) geschwärzt sind, lässt sich aufgrund der Schwangerschaft dennoch schließen, dass es sich bei der Patientin um eine erwachsene Frau handelt, die angesichts ihres Hobbys Dressurreiten in einer wohlhabenden Gegend wohnt.“

In einem Experiment enthielten selbst nach dem Entfernen der Patientenidentifikatoren mehr als 220,000 klinische Aufzeichnungen von 170,000 Patienten des NYU Langone noch genügend Informationen, um Rückschlüsse auf demografische Merkmale zu ermöglichen.

Bohren nach unten

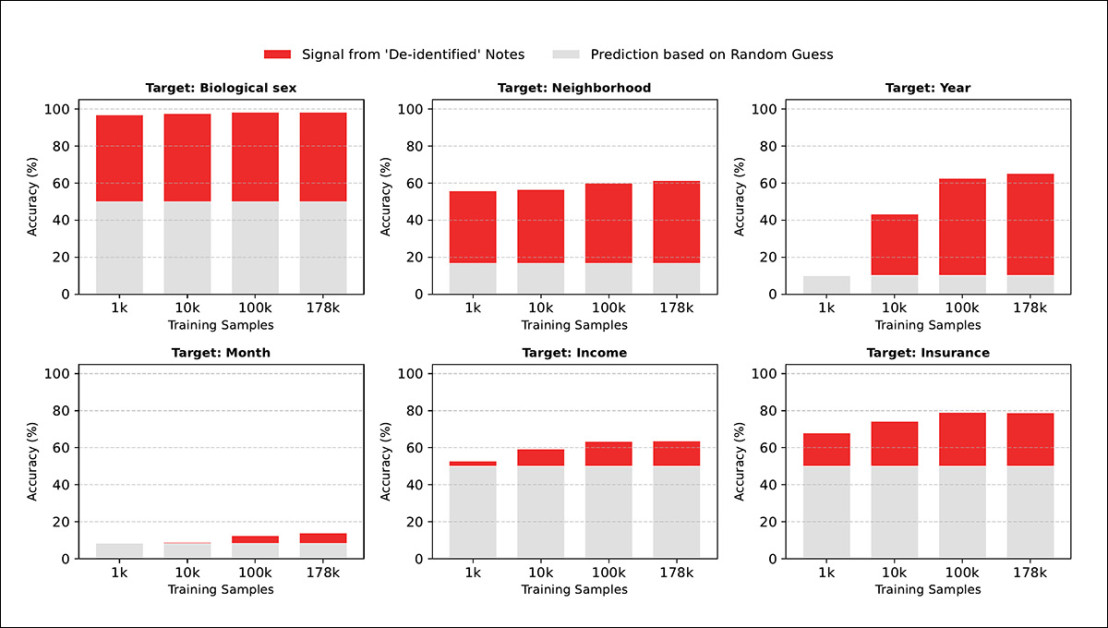

A BERT-basiertes Modell war fein abgestimmt Die Methode diente dazu, sechs Merkmale anhand der anonymisierten Datensätze vorherzusagen und übertraf, wie die Studie feststellt, bereits mit nur 1,000 Trainingsbeispielen die Zufallsgenauigkeit. Das biologische Geschlecht wurde mit einer Genauigkeit von über 99.7 % ermittelt, und selbst schwächere Hinweise wie der Monat der Aufzeichnung wurden mit überdurchschnittlicher Treffsicherheit vorhergesagt.

Zu experimentellen Zwecken wurden diese abgeleiteten Merkmale anschließend in einem Linkage-Angriff auf die Langone-Datenbank verwendet. Das maximale Risiko einer eindeutigen Reidentifizierung lag bei 0.34 % – etwa 37-mal höher als bei einer einfachen Mehrheitsklassen-Basislinie. Angewendet auf die US-Bevölkerung, würde dieser Angriff allein 800,000 Patienten anonymisieren.

Die Autoren bezeichnen das Problem als ein „Paradoxon“, da das, was in HIPAA-konformen, anonymisierten Patientendatensätzen zurückbleibt, eindeutig eine praktikable Grundlage für Anonymisierungsangriffe darstellt:

„Der überwiegende Teil des Risikos der Reidentifizierung geht nicht von geschützten Gesundheitsdaten aus, sondern von nicht sensiblen und medizinischen Inhalten, die wir als unbedenklich für die Weitergabe einstufen.“

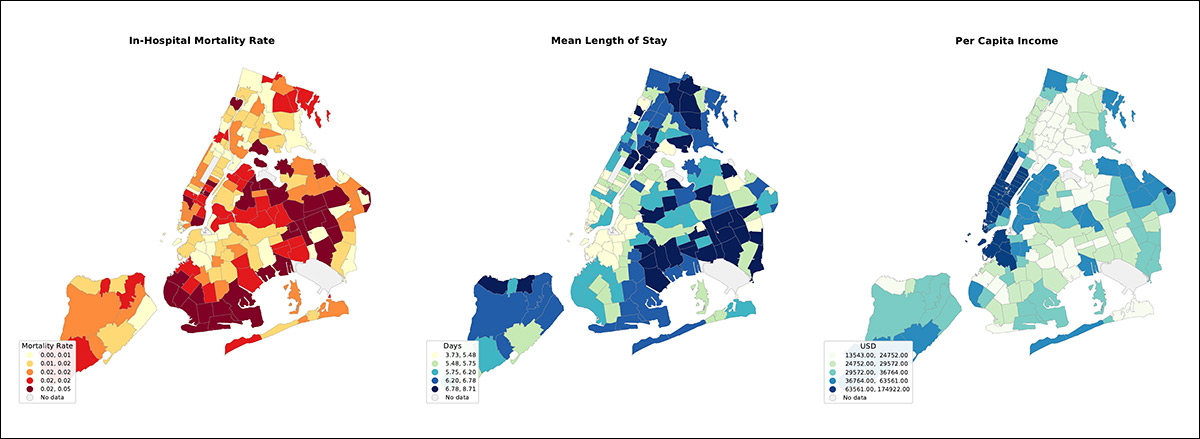

Karten der New Yorker Stadtbezirke zeigen Unterschiede in den Sterberaten in Krankenhäusern, der durchschnittlichen Verweildauer und dem Einkommensniveau. Sie veranschaulichen, wie sich Gesundheitsergebnisse und Wohlstand je nach Gebiet unterscheiden und selbst in anonymisierten Krankenakten ortsbezogene Hinweise hinterlassen können. Weitere Beispiele finden Sie in der Originalpublikation.

In dem Artikel wird argumentiert, dass die Safe-Harbor-Regeln des HIPAA nicht mehr so funktionieren, wie es die politischen Entscheidungsträger beabsichtigt hatten: 18 Kennungen entfernen Das System mag zwar formal den gesetzlichen Anforderungen genügen, doch laut den Autoren verhindert es nicht, dass die Identität mithilfe gängiger Sprachmodelle abgeleitet werden kann. Sie argumentieren, dass das System selbst auf überholten Annahmen darüber beruht, was Sprachwissenschaftler aus gewöhnlichen medizinischen Texten ableiten können und was nicht.

Die Arbeit legt außerdem nahe, dass diejenigen, die von den genannten Schwächen profitieren dürften, große Unternehmen aus dem Bereich der Krankenversicherung sind und nicht herkömmlich definierte kriminelle Organisationen (wie Hacker, Erpresser oder Social Engineers)*:

„Das Fortbestehen des Safe Harbor trotz bekannter Einschränkungen ist kein Versehen, sondern ein Merkmal eines Systems.“optimiert für Datenliquidität statt PatientenschutzAnonymisierte klinische Notizen stellen eine Multi-Milliarden-Dollar-MarktDadurch entstehen strukturelle Fehlanreize für Gesundheitseinrichtungen, datenschutzfreundliche Alternativen einzuführen, die den Nutzen der Daten verringern oder kostspielige Infrastrukturinvestitionen erfordern könnten.

„Es ist dringend notwendig, diesen Hemmfaktor sorgfältig zu untersuchen, zu verstehen und ihm entgegenzuwirken.“

Dies ist ein Positionspapier, das keine eindeutigen Antworten bietet; die Autoren schlagen jedoch vor, dass sich die Forschung zur Anonymisierung eher auf soziale Verträge und die rechtlichen Folgen von Vertragsbrüchen als auf technische Lösungen konzentrieren sollte (möglicherweise die gleiche Vorgehensweise wird vom DMCA verwendet, um das Kopieren von urheberrechtlich geschützten Werken einzuschränken, wenn technische Lösungen gescheitert).

Die neues Papier ist betitelt Das Paradoxon der Anonymisierung: Eine Kritik des HIPAA Safe Harbour im Zeitalter der LLM-Absolventenund stammt von vier Forschern der New York University in Zusammenarbeit mit dem NYU Langone Krankenhaus.

Methodik

Um ihre Theorie zu testen, entwickelten die Autoren ein zweistufiges Verfahren. Verknüpfungsangriff unter Verwendung von 222,949 identifizierten klinischen Notizen von 170,283 Patienten, die im NYU Langone behandelt wurden, wobei alle Notizen partitioniert Um Kreuzkontaminationen zu vermeiden, werden die Patientendaten in 80 % Trainings-, 10 % Validierungs- und 10 % Testdaten aufgeteilt.

Zum Vergleich: Diese Sammlung ist 3.34-mal größer als die MIMIC-IV-DatensatzEs handelt sich um die größte öffentlich zugängliche Sammlung elektronischer Patientenakten (EHR). Aus Datenschutzgründen wird der Langone-Datensatz in keiner Form veröffentlicht, Nutzer können jedoch mit den Projektprinzipien experimentieren. über ein GitHub-Repository das synthetische Daten erzeugt.

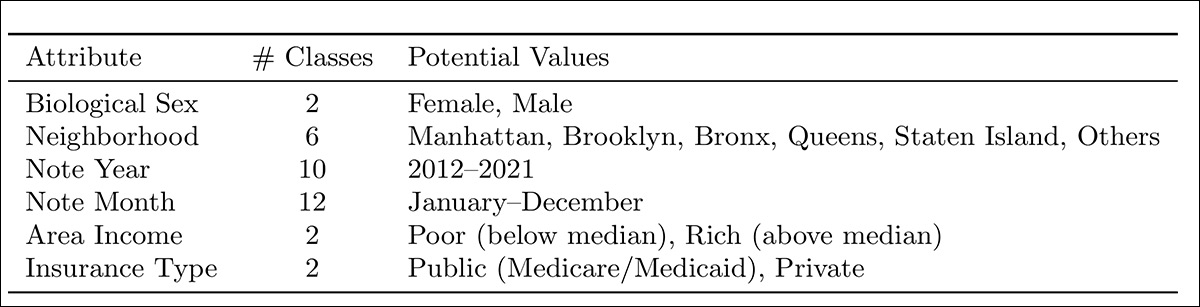

Sechs demografische Merkmale wurden ausgewählt, um das klassische Re-Identifizierungs-Trio, das in einem einflussreiche Vorarbeiten: biologisches Geschlecht; Gegend; Jahr der Notiz; Notizmonat; Gebietseinkommeneschriebenen Art und Weise; und Versicherungsart:

Demografische Merkmale, die aus anonymisierten klinischen Notizen von NYU Langone abgeleitet wurden und biologisches Geschlecht, Wohngegend, Jahr und Monat der Notiz, Einkommen in der Region und Versicherungsart umfassen, wurden so ausgewählt, dass sie dem in [Referenz einfügen] beschriebenen eindeutigen Identifikationstrio möglichst nahekommen. „Einfache demografische Daten identifizieren Menschen oft auf einzigartige Weise.“

Die Notizen wurden anonymisiert mithilfe von UCSF-Flüsterer vor der Modellierung.

A BERT-Base-ohne Gehäuse Ein Modell mit 110 Millionen Parametern, das anhand allgemeiner Texte vortrainiert wurde, um den vorherigen Kontakt mit klinischen Daten zu vermeiden, wurde für jedes Attribut separat feinabgestimmt. Dabei kamen acht NVIDIA A100 GPUs mit 40 GB Speicher oder H100 GPUs mit 80 GB Speicher zum Einsatz, und zwar für bis zu zehn... Epochen. Optimierung verwendet AdamW, Mit Lernrate von 2×10−5 und einem effektiven Losgröße von 256

Verallgemeinerung Die Auswertung des zurückgehaltenen Testdatensatzes erfolgte mit Genauigkeit und gewichtet ROC-AUCLetztere wurde gewählt, um der Klasse Rechnung zu tragen. Unausgewogenheit über alle Attribute hinweg.

Um den Angriff realistischer zu gestalten, wurden die Vorhersagen des Modells nicht als endgültige Antworten betrachtet. Stattdessen wurde für jedes Attribut Folgendes ermittelt: Top k Die wahrscheinlichsten Werte wurden beibehalten und die Patientendatenbank so gefiltert, dass alle Personen berücksichtigt wurden, die diesen vorhergesagten Merkmalen entsprachen. Dadurch entstand für jeden Eintrag eine Auswahlliste möglicher Identitäten anstelle einer einzelnen Vermutung.

Risikobewertung

Das Risiko der Reidentifizierung wurde dann in zwei Schritten berechnet: Erstens wurde gemessen, wie oft der tatsächliche Patient in der engeren Auswahl auftauchte; zweitens wurde die Wahrscheinlichkeit geschätzt, die richtige Person aus dieser Gruppe auszuwählen.

Da im letzten Schritt davon ausgegangen wurde, dass jemand einfach zufällig einen Namen aus den möglichen Übereinstimmungen auswählt, handelt es sich bei der angegebenen Zahl um eine vorsichtige Schätzung, und ein entschlossener Angreifer könnte wahrscheinlich ein besseres Ergebnis erzielen.

Das Experiment ging von einem Zugriff auf die gesamte Patientenpopulation in der externen Datenbank aus. Dies spiegelt ein realistisches Worst-Case-Szenario wider, in dem eine große Institution oder ein Datenbroker mit umfassenden Patientendaten die Verknüpfung versucht, anstatt einer Einzelperson mit begrenzten Informationen. Dies unterstreicht die Art der Bedrohung, die die Autoren in ihrer Arbeit thematisieren.

Ergebnisse

Das Risiko wurde auf drei Ebenen gemessen: Erfolgsrate der Gruppenwiederidentifizierung Erfasst wurde, wie häufig der reale Patient in der vom Modell in die engere Wahl gekommenen Kandidatenliste auftauchte, basierend auf korrekten Top-Werten. k Vorhersagen über alle Attribute hinweg; individuelle Reidentifizierung aus der Gruppe Die Wahrscheinlichkeit, die richtige Person auszuwählen, wurde gemessen, sobald diese Gruppe identifiziert war; und Wahrscheinlichkeit der eindeutigen Wiederidentifizierung Multipliziert man die beiden Werte, erhält man die Gesamtwahrscheinlichkeit, einen Patienten anhand anonymisierter Notizen eindeutig zu identifizieren:

Die Vorhersagegenauigkeit für biologisches Geschlecht, Nachbarschaft, Jahr, Monat, Einkommen und Versicherungsart zeigt, dass BERT-base-uncased, trainiert auf UCSF philter-de-identified NYU Langone Notes, selbst bei 1,000 Trainingsbeispielen das zufällige Raten übertrifft, wobei sich die Genauigkeit stetig verbessert, wenn der Datensatz auf 178,000 Beispiele anwächst.

Zu diesen ersten Ergebnissen merken die Autoren Folgendes an:

Wie oben dargestellt, bleiben anonymisierte klinische Notizen anfällig für Attributvorhersagen. Über alle sechs Attribute und alle Datenregime (1 bis 177 Beispiele) hinweg ist das Sprachmodell (rot) den zufälligen Vergleichsmodellen (grau) durchweg überlegen.

„Diese Ergebnisse unterstützen empirisch, dass der De-Identifizierungsprozess in den beiden Hintertürpfaden ausnutzbare Signale beibehält.“

„Das Datenschutzrisiko ist unmittelbar: Modelle erzielen bereits mit nur 1,000 Trainingsbeispielen eine überzufällige Leistung. Während das biologische Geschlecht das am stärksten exponierte Merkmal ist (mit einer Genauigkeit von > 99.7 % wiederhergestellt), werden selbst subtilste Signale (z. B. der Geburtsmonat) mit einer überzufälligen Genauigkeit vorhergesagt.“

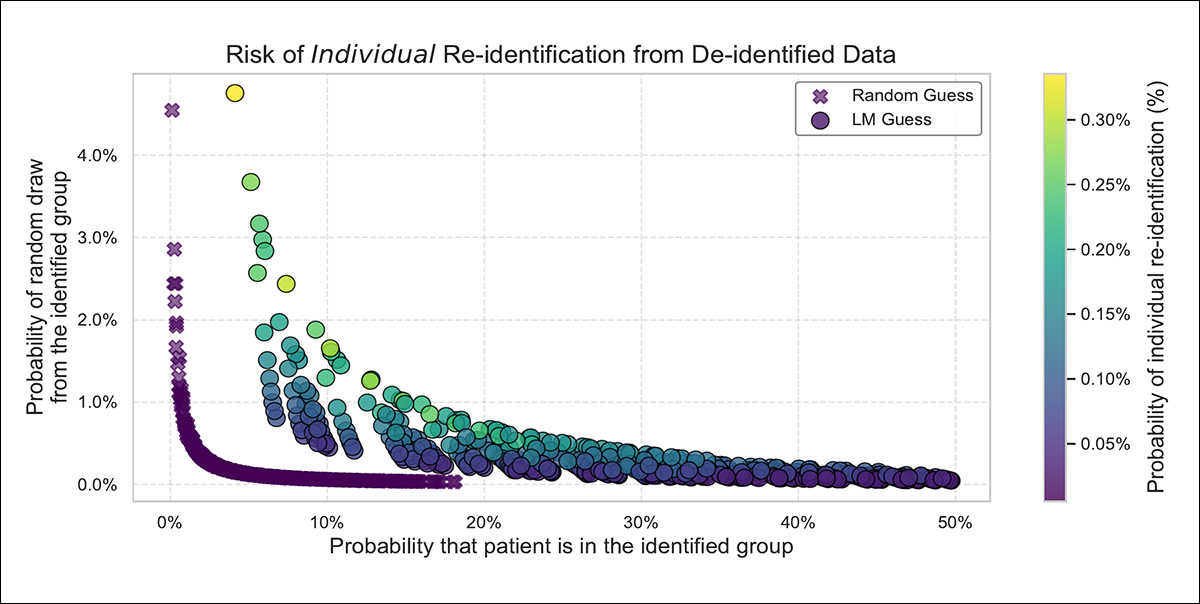

Im zweiten Ergebnisdiagramm unten zeigt die eine Richtung, wie oft das Modell den realen Patienten in seine Auswahlliste aufnimmt, die andere, wie klein diese Auswahlliste ist:

Wie oft die Auswahlliste des Modells den tatsächlichen Patienten enthält, im Vergleich dazu, wie einfach es ist, die richtige Person aus dieser Auswahlliste auszuwählen – was zeigt, dass das Sprachmodell ein höheres Gesamtrisiko der Reidentifizierung erzeugt als einfaches Raten, das 0.34 % erreicht, verglichen mit 0.0091 % für die stärkste Vergleichsbasis.

Je häufiger der tatsächliche Patient auftaucht und je kürzer die Auswahlliste ist, desto höher ist das Risiko. Das Sprachmodell der Autoren übertraf eine einfache Mehrheitsklassenschätzung in beiden Bereichen und erreichte im besten Fall eine Wahrscheinlichkeit von 0.34 %, einen Patienten eindeutig zu identifizieren – etwa 37-mal höher als die beste Vergleichsmethode.

Die Autoren weisen darauf hin, dass bei Patienten mit ungewöhnlichen Krankengeschichten oder marginalisierten Identitäten die Risiken der Anonymisierung höher sind, und schließen mit der Empfehlung zu einer ernsthaften Neubewertung des HIPAA Safe Harbor-Standards:

Der HIPAA Safe Harbor-Standard basiert auf einer binären Definition von Datenschutz: Daten sind entweder „identifiziert“ oder „anonymisiert“. HIPAA geht davon aus, dass das Entfernen einer statischen Liste von Tokens die Daten „sicher“ macht und somit die klinische Darstellung effektiv von der Identität des Patienten entkoppelt.

„Unsere Kausaldiagrammanalyse und empirischen Ergebnisse legen jedoch nahe, dass diese Entkopplung eine Illusion ist.“

„Klinische Befunde sind untrennbar mit der Identität verbunden. Die medizinische Diagnose eines Patienten und seine ungeschwärzten Erzählungen sind direkte Produkte seines einzigartigen Lebensweges und erzeugen eine hochdimensionale Signatur, die auf das Individuum zurückgeführt werden kann.“

Die Autoren betonen weiterhin, dass sich die aktuellen Anonymisierungsregeln auf das Entfernen einer festen Liste von Identifikatoren konzentrieren, während die im verbleibenden Text verbleibenden Muster ignoriert werden. Große Sprachmodelle, so merken sie an, sind darauf ausgelegt, solche Muster zu erkennen und zu kombinieren – was bedeutet, dass gewöhnliche klinische Details als „indirekte Identifikatoren“ fungieren können.

Die Studie schließt mit einer Reihe von Empfehlungen, darunter der Appell, die Feinabstimmung von Modellen einzustellen. synthetische Datenoder „deklassifizierte“ Daten, da die erste birgt Datenschutzrisiken in Bezug auf die realen Daten, die zur Begründung verwendet wurden; und die zweite Annahme setzt voraus, dass der bisherige Standard des Datenschutzes aus der HIPAA-Ära weiterhin wirksam ist.

Fazit

Da solche „Hintertüren“ eindeutig vor allem großen Organisationen wie Versicherungsunternehmen zugutekommen – die sie vermutlich heimlich und ohne Offenlegung nutzen werden –, wäre eine „rechtliche Blockade“ nach dem Vorbild des DCMA (bei der die handeln Die Umgehung von Schutzmaßnahmen ist an sich verboten, unabhängig von den verwendeten Technologien, und stellt daher einen ineffektiven Ansatz dar.

bekannt dass Versicherungsunternehmen Zugang zu solchen Informationen erhalten möchten und dass sie direkt oder über Verbindungen zu Datenbrokern einen außergewöhnlichen Zugang zu privaten Gesundheitsdaten haben; und je größer das Unternehmen ist, desto größer ist auch seine eigene Kundendatenbank.

Wenn die Bestimmungen und Schutzmechanismen des HIPAA also eher zu einer Art Gentlemen's Agreement werden als zu einem wirksamen Schutzwall gegen die Ausbeutung durch Unternehmen, erscheint eine Überprüfung sicherlich angebracht.

* Meine Konvertierung der Inline-Zitate der Autoren in Hyperlinks.

Erstveröffentlichung: Mittwoch, 11. Februar 2026