AI 101

Aşırı Uyum nedir?

Aşırı Uyum nedir?

Bir sinir ağını eğitirken, fazla uydurmadan kaçınmalısınız. Aşırı uyum gösterme makine öğrenimi ve istatistik kapsamında bir modelin eğitim veri kümesinin kalıplarını çok iyi öğrendiği, eğitim veri kümesini mükemmel şekilde açıkladığı ancak tahmin gücünü diğer veri kümelerine genelleyemediği bir sorundur.

Başka bir deyişle, aşırı uydurma modeli durumunda, genellikle eğitim veri setinde son derece yüksek doğruluk gösterecek, ancak toplanan ve gelecekte model boyunca çalıştırılacak verilerde düşük doğruluk gösterecektir. Bu, fazla uydurmanın hızlı bir tanımıdır, ancak hadi fazla takma kavramını daha ayrıntılı olarak ele alalım. Aşırı uyumun nasıl oluştuğuna ve nasıl önlenebileceğine bir göz atalım.

“Uyum”u ve Yetersiz Uyumu Anlamak

Yetersiz uyum kavramına bir göz atmak faydalı olacaktır ve “uygun” genellikle aşırı uyumu tartışırken. Bir modeli eğittiğimizde, bir veri kümesindeki öğelerin doğasını veya sınıfını, bu öğeleri tanımlayan özelliklere dayalı olarak tahmin edebilen bir çerçeve geliştirmeye çalışıyoruz. Bir model, bir veri kümesi içindeki bir modeli açıklayabilmeli ve bu modele dayanarak gelecekteki veri noktalarının sınıflarını tahmin edebilmelidir. Model, eğitim setinin özellikleri arasındaki ilişkiyi ne kadar iyi açıklarsa modelimiz o kadar “uyumlu” olur.

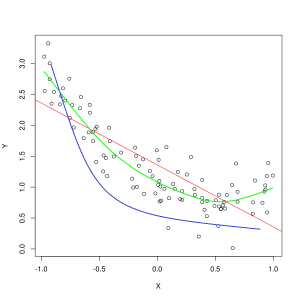

Mavi çizgi, uygun olmayan bir modelin tahminlerini temsil ederken, yeşil çizgi daha iyi uyan bir modeli temsil eder. Fotoğraf: Wikimedia Commons aracılığıyla Pep Roca, CC BY SA 3.0, (https://commons.wikimedia.org/wiki/File:Reg_ls_curvil%C3%ADnia.svg)

Eğitim verilerinin özellikleri arasındaki ilişkiyi yetersiz açıklayan ve bu nedenle gelecekteki veri örneklerini doğru bir şekilde sınıflandırmada başarısız olan bir model, eğitim verilerini yetersiz uydurmaktadır. Eksik uydurulmuş bir modelin öngörülen ilişkisini özelliklerin ve etiketlerin gerçek kesişim noktasına göre grafiklendirirseniz, tahminler hedeften sapar. Bir eğitim setinin gerçek değerlerinin etiketlendiği bir grafiğimiz olsaydı, ciddi şekilde yetersiz uydurulmuş bir model veri noktalarının çoğunu önemli ölçüde kaçırırdı. Daha iyi bir uyuma sahip bir model, veri noktalarının ortasından geçen bir yolu kesebilir ve bireysel veri noktaları öngörülen değerlerden yalnızca biraz sapabilir.

Doğru bir model oluşturmak için yeterli veri olmadığında veya doğrusal olmayan verilerle doğrusal bir model tasarlamaya çalışırken yetersiz uyum sıklıkla ortaya çıkabilir. Daha fazla eğitim verisi veya daha fazla özellik genellikle yetersiz uyumu azaltmaya yardımcı olur.

Öyleyse neden eğitim verilerindeki her noktayı mükemmel bir şekilde açıklayan bir model yaratmayalım? Kesinlikle mükemmel doğruluk arzu edilir? Eğitim verilerinin kalıplarını çok iyi öğrenmiş bir model oluşturmak, fazla uydurmaya neden olur. Model aracılığıyla çalıştırdığınız eğitim veri kümesi ve diğer gelecekteki veri kümeleri tam olarak aynı olmayacaktır. Muhtemelen pek çok açıdan çok benzer olacaklar, ancak aynı zamanda önemli açılardan da farklılık gösterecekler. Bu nedenle, eğitim veri setini mükemmel bir şekilde açıklayan bir model tasarlamak, özellikler arasındaki ilişki hakkında diğer veri setlerine iyi genellenemeyen bir teori elde etmeniz anlamına gelir.

Overfitting'i Anlamak

Aşırı uyum, bir model, eğitim veri kümesi içindeki ayrıntıları çok iyi öğrendiğinde meydana gelir ve dış veriler üzerinde tahminler yapıldığında modelin zarar görmesine neden olur. Bu durum, modelin yalnızca veri kümesinin özelliklerini öğrenmesi değil, aynı zamanda rastgele dalgalanmaları veya gürültü veri kümesi içinde, bu rastgele/önemsiz olaylara önem vermek.

Veri özelliklerini öğrenirken daha esnek olduklarından, doğrusal olmayan modeller kullanıldığında fazla uydurma meydana gelme olasılığı daha yüksektir. Parametrik olmayan makine öğrenimi algoritmaları, genellikle modelin verilere duyarlılığını sınırlamak ve böylece aşırı uydurmayı azaltmak için uygulanabilen çeşitli parametrelere ve tekniklere sahiptir. Örnek olarak, karar ağacı modelleri aşırı uydurmaya karşı oldukça hassastırlar, ancak modelin öğrendiği bazı ayrıntıları rastgele kaldırmak için budama adı verilen bir teknik kullanılabilir.

Modelin tahminlerini X ve Y eksenlerinde çizecek olsaydınız, ileri geri zikzaklar çizen bir tahmin çizginiz olurdu, bu da modelin veri kümesindeki tüm noktaları sığdırmak için çok uğraştığını gösterir. onun açıklaması.

Fazla uydurmayı kontrol etme

Bir modeli eğitirken ideal olarak modelin hiç hata yapmamasını isteriz. Modelin performansı, eğitim veri kümesindeki tüm veri noktalarında doğru tahminler yapmaya yaklaştığında uyum daha iyi hale geliyor. İyi bir uyuma sahip bir model, neredeyse tüm eğitim veri setini fazla uydurma olmadan açıklayabilir.

Bir model eğitildikçe performansı zamanla artar. Modelin hata oranı, eğitim süresi geçtikçe azalacaktır, ancak yalnızca belirli bir noktaya kadar düşmektedir. Modelin test setindeki performansının tekrar yükselmeye başladığı nokta, tipik olarak aşırı uyumun meydana geldiği noktadır. Bir model için en uygun olanı elde etmek için, hata tekrar artmaya başlamadan önce, eğitim setindeki en düşük kayıp noktasında modeli eğitmeyi durdurmak istiyoruz. Optimum durma noktası, eğitim süresi boyunca modelin performansının grafiği çizilerek ve kayıp en düşük olduğunda eğitim durdurularak belirlenebilir. Bununla birlikte, aşırı uydurmayı kontrol etmenin bu yöntemiyle ilgili bir risk, test performansına dayalı olarak eğitim için son noktayı belirlemenin, test verilerinin bir şekilde eğitim prosedürüne dahil edilmesi ve tamamen "el değmemiş" veri statüsünü kaybetmesi anlamına gelmesidir.

Aşırı uydurma ile mücadele etmenin birkaç farklı yolu vardır. Aşırı uydurmayı azaltmanın bir yöntemi, modelin doğruluğunu tahmin ederek çalışan bir yeniden örnekleme taktiği kullanmaktır. Ayrıca bir onaylama veri kümesini test kümesine ek olarak kullanın ve eğitim doğruluğunu test veri kümesi yerine doğrulama kümesine göre çizin. Bu, test veri kümenizin görünmemesini sağlar. Popüler bir yeniden örnekleme yöntemi, K katları çapraz doğrulamadır. Bu teknik, verilerinizi modelin üzerinde eğitildiği alt kümelere ayırmanızı sağlar ve ardından modelin dış veriler üzerinde nasıl performans göstereceğini tahmin etmek için modelin alt kümelerdeki performansı analiz edilir.

Çapraz doğrulamayı kullanmak, bir modelin görünmeyen veriler üzerindeki doğruluğunu tahmin etmenin en iyi yollarından biridir ve bir doğrulama veri seti ile birleştirildiğinde aşırı uydurma genellikle minimumda tutulabilir.