Ângulo de Anderson

As vantagens de engordar por meio da IA

Um novo sistema de IA pode remodelar realisticamente o corpo das pessoas em fotos, tornando-as mais gordas, mais magras ou mais musculosas, sem alterar o rosto, as roupas ou o fundo. O sistema é treinado com um conjunto de dados totalmente sintético que mostra cada identidade em vários tipos de corpo.

Além do uso cada vez mais comum da IA como método de refinando o formato do corpo nas redes sociais, ou (potencialmente) para alterar tipos de corpo para fins de efeitos visuais, o uso do aprendizado de máquina para alterar a aparência de indivíduos pode ter uma função mais importante: ajudar indivíduos com transtornos alimentares para entender sua própria interpretação dismórfica de sua aparência, além de oferecer uma ferramenta motivacional potencial para fins esportivos e de condicionamento físico mais gerais:

Do artigo "Estimativa do tamanho corporal em mulheres com anorexia nervosa e controles saudáveis usando avatares 3D", uma interface gráfica para visualizar mudanças na forma corporal. Indivíduos com dismorfia corporal podem ter dificuldade em associar uma interpretação realista de seu corpo a uma imagem semelhante, fornecendo assim aos clínicos uma métrica para respostas dismórficas, entre outros propósitos. Fonte: https://www.nature.com/articles/s41598-017-15339-z.pdf

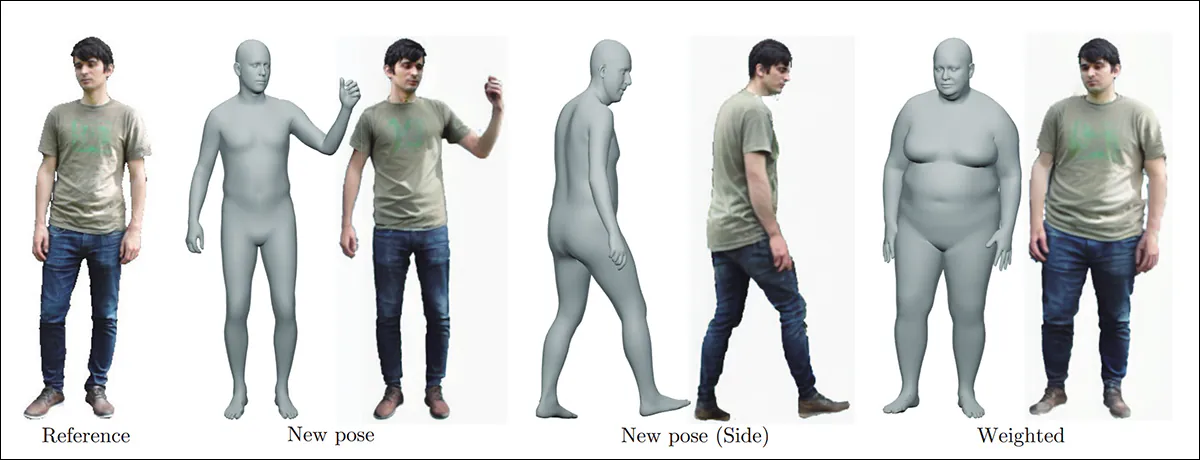

Além disso, o prova de moda muito procurada A subárea de pesquisa em visão computacional também tem interesse em fornecer visualizações precisas em uma variedade de formas corporais. Enquanto isso, estruturas como a de 2024 DiffBody oferecido pela Universidade de Tsukuba, no Japão, criaram algumas funcionalidades surpreendentes neste campo:

Algumas das transformações possíveis usando a técnica DiffBody anterior. Fonte: https://arxiv.org/pdf/2401.02804

Como os modelos de base da IA são otimizados para formas corporais convencionalmente atraentes ou comuns, tamanhos incomuns como 'obeso' estão minimamente disponíveis em modelos padrão ou então vem com alguns preconceitos punitivos.

Necessidades do par

Um dos maiores desafios na criação de sistemas de IA que podem adicionar ou subtrair gordura e músculo de forma realista em fotos de indivíduos – sem alterar sua identidade, ambientes ou roupas – é que isso envolve treinamento em pares, onde o sistema de IA aprende efetivamente imagens de "antes" e "depois" que definem qualquer transformação que o modelo pretende realizar.

Este tipo de treinamento voltou a ganhar destaque no verão devido ao sucesso do Black Forest Labs contexto série de modelos de edição de imagens, onde esse tipo de dados pareados foi usado para ensinar uma série de transformações aos modelos:

No site Flux Kontext, um exemplo de uma transformação que reflete o tipo de dados de origem necessários para treinar um modelo capaz de manter a integridade da imagem ao impor grandes mudanças. Fonte: https://bfl.ai/models/flux-kontext

Obviamente, no caso de desenvolver um modelo que pode alterar significativamente a aparência de uma pessoa (sem reimaginar a imagem inteira), é necessário algo que é totalmente impossível no mundo real: fotos radicais de "antes" e "depois" tiradas com apenas alguns segundos de diferença.

O único recurso é dados sintéticos. Alguns projetos desse tipo usaram pares contrastantes individuais de alto esforço criados manualmente no Photoshop; no entanto, isso não é realista em escala, e um processo automatizado ou semiautomatizado, orientado por IA, para gerar os pares é cada vez mais considerado preferível.

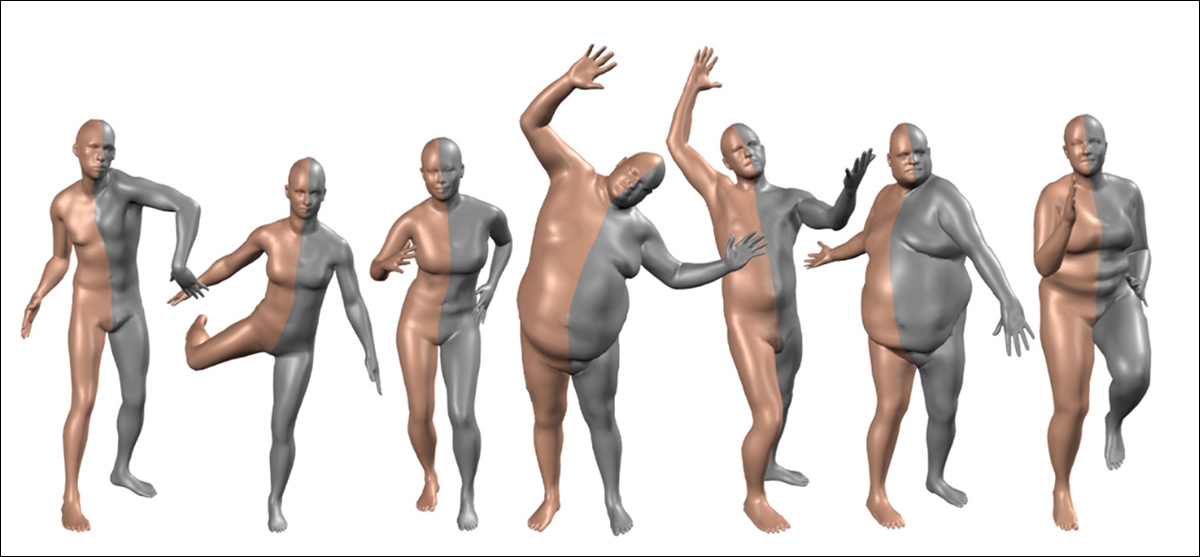

O problema com GAN-baseado e mais SMPL/Xabordagens baseadas em (onde uma figura CGI virtual é usada como uma espécie de mecanismo de troca entre imagens reais e as transformações desejadas) e com abordagens que usar distorção de imagem, é que o contexto e a identidade tendem a sofrer no processo.

Modelos CGI paramétricos baseados em vetores, como SMPL e SMPL-X (entre outros), fornecem coordenadas físicas 3D convencionais definidas que podem ser interpretadas e incorporadas em estruturas de visão computacional. Fonte: https://files.is.tue.mpg.de/black/papers/SMPL2015.pdf

Como é importante que a IA aprenda a mudar apenas os aspectos desejados, em vez de aprender a distorcer fundos e replicar outros erros indesejados, nenhum sistema de alteração corporal chegou ainda a uma solução perfeita.

Um artigo recente da Índia, no entanto, propõe um avanço notável no estado da arte através do uso de tecnologias mais antigas Fluxo estrutura do modelo de difusão, complementada com uma série de abordagens secundárias que permitem um conjunto de dados pareados superior e mais consistente:

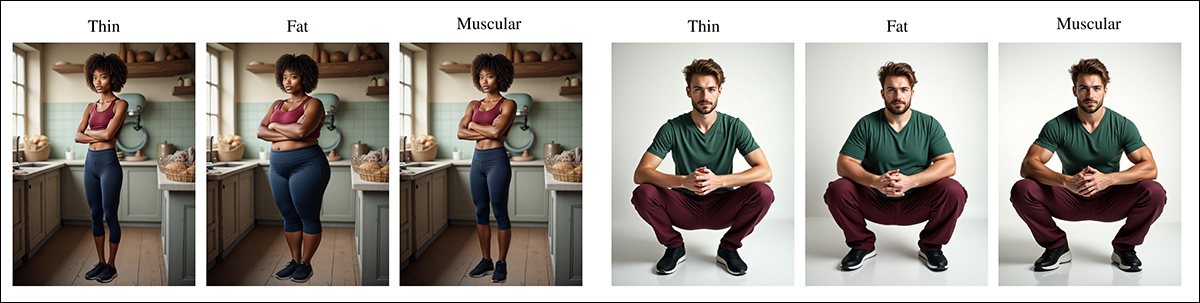

Exemplos de conjuntos de dados do novo projeto. Fonte: https://arxiv.org/pdf/2508.13065

O projeto compreende um novo e extenso conjunto de dados pareados; Odo, um modelo de difusão generativa treinado com base nesses dados; e um novo benchmark personalizado, projetado para avaliar quantitativamente o desempenho da edição de formas humanas. Nos testes, os autores afirmam um avanço notável em relação aos padrões alcançados por modelos semelhantes.

O MVP da novo papel é intitulado Odo: Difusão guiada por profundidade para remodelação corporal com preservação da identidade, e vem de três pesquisadores da Fast Code AI Pvt. Ltd em Bangalore.

Dados e Método

O conjunto de dados criado pelos pesquisadores apresenta 7,615 imagens de alta resolução (960x1280px) para cada tipo de corpo alvo (dietas ricas em gorduras , fino e muscular).

Inicialmente, 1,523 rostos humanos foram gerados através do FLUX.1-dev Modelo de difusão de 12 bilhões de parâmetros, embora aproveitando um número não especificado de faces de referência sem licença do Pexels e Unsplash, para aumentar a diversidade.

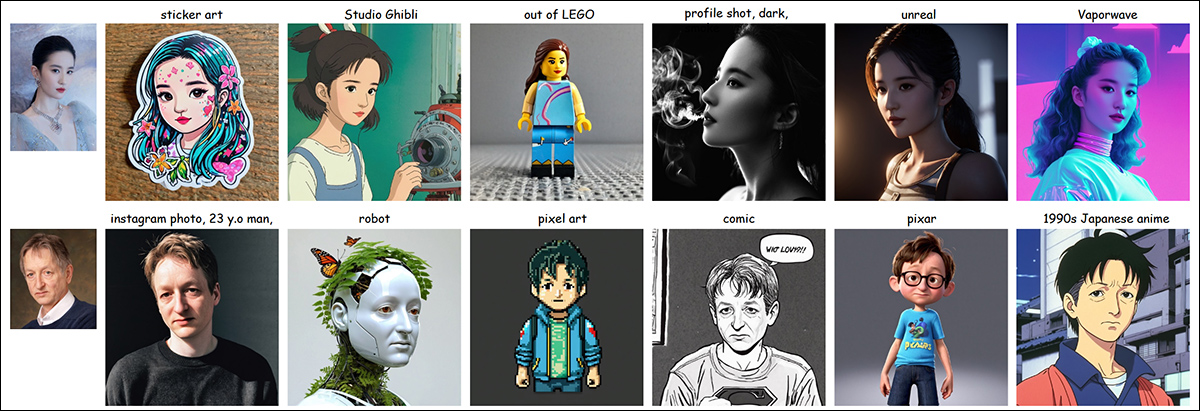

Para gerar imagens de corpo inteiro incorporando esses rostos, os pesquisadores usaram a oferta de 2024 da ByteDance PULID, um ponto de verificação ajustado com base no Flux e apresentando um perda de identificação contrastiva projetado para ajudar a conservar a identidade facial durante processos de transformação:

Exemplos do projeto PuLID. Fonte: https://arxiv.org/pdf/2404.16022

O modelo recebeu uma imagem facial e um prompt padronizado solicitando gênero, roupa, pose, cena, bem como o tipo de corpo de fino, dietas ricas em gorduras ou muscular.

As três imagens do tipo corporal para cada identidade às vezes exibiam pequenas mudanças no alinhamento do fundo e no tamanho percebido do sujeito, decorrentes da estocástico comportamento dos modelos de difusão, onde cada geração começa a partir de uma nova barulho semente. Mesmo pequenas alterações no prompt, como modificar a descrição do tipo de corpo, podem influenciar a trajetória do modelo em espaço latente, e causar desvio visual.

Para corrigir essa variação, foi aplicado um pipeline de pós-processamento automático de quatro estágios, com o fino imagem em cada tripleto selecionado como referência, já que sua silhueta menor expunha mais fundo.

A detecção de pessoas foi realizada usando RT-DETRv2, seguido de segmentação com SAM 2.1 para extrair máscaras de assunto para todos os três tipos de corpo. fino A imagem de referência foi então passada para o FLUX.1 Kontext Pro (o sistema de edição de imagens mais recente) para pintura de fundo, produzindo uma versão limpa da cena, com o sujeito removido.

O MVP da dietas ricas em gorduras e muscular As variantes foram redimensionadas usando escala uniforme para corresponder à altura da máscara de referência fina e compostas no fundo limpo no mesmo alinhamento inferior, garantindo enquadramento consistente em todas as imagens.

Os autores declaram:

Os trios de transformação resultantes (magro, gordo e musculoso) têm um fundo idêntico e uma escala de sujeitos uniforme. Isso elimina variações irrelevantes que poderiam afetar negativamente o treinamento ou a avaliação subsequente.

Cada trio de imagens magras, gordas e musculosas permitiu seis pares de transformações possíveis, resultando em 45,690 combinações teóricas em 7,615 identidades.

Após filtrar exemplos com roupas incompatíveis, poses artificiais, membros distorcidos, desvios de identidade ou alterações mínimas de forma, 18,573 pares de alta qualidade foram mantidos. Embora algumas pequenas diferenças de pose permanecessem, o modelo se mostrou robusto a essas variações.

Treinamento e Testes

As imagens resultantes foram usadas para treinar o modelo Odo – uma abordagem baseada em difusão para remodelar humanos, com o uso do Modelo Linear Multi-Pessoa Skinned (SMPL, ou seja, mapas CGI intermediários.

Informado pelo 2024 Localizador Neural métodos, os dados foram conformados ao valor SMPL por indivíduo, com os parâmetros otimizados resultantes capazes de produzir mapas de profundidade das quais as imagens alteradas seriam derivadas:

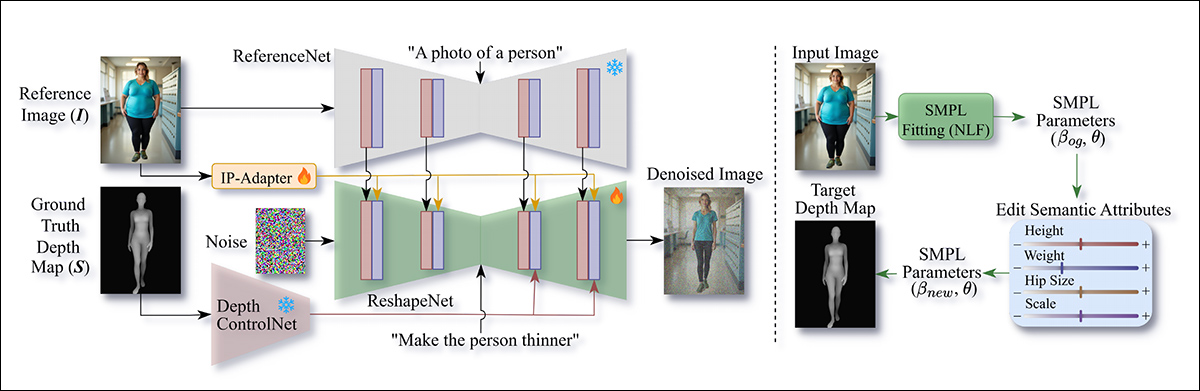

Esquema para o pipeline de treinamento. O lado esquerdo mostra a configuração de treinamento, onde mapas de profundidade SMPL da imagem alvo guiam o ReshapeNet via ControlNet para realizar a transformação corporal. Características da imagem de origem são extraídas pelo ReferenceNet e mescladas ao ReshapeNet usando autoatenção espacial. O lado direito mostra a inferência, onde os parâmetros SMPL são estimados a partir da imagem de entrada, modificados por atributos semânticos e renderizados em um mapa de profundidade alvo que condiciona o ReshapeNet durante a redução de ruído, para produzir a imagem final transformada.

O modelo (ver esquema acima) compreende o ReshapeNet módulo, apoiado por três módulos auxiliares: ReferenceNet; um Adaptador IP módulo; e um ControlNet baseado em profundidade módulo.

O ReferenceNet extrai características detalhadas, como fundo, vestimenta e identidade, da imagem de entrada e as transmite ao ReshapeNet. O IP-Adapter contribui com orientações de alto nível sobre características, enquanto o Depth ControlNet aplica condicionamento baseado em SMPL para orientar a transformação corporal. Em consonância com anterior funciona, um SDXLBaseada congelado UNet foi usado para extrair características intermediárias.

Quanto ao módulo IP-Adapter, este codifica a imagem de entrada via CLIP, com o resultado incorporações integrado novamente ao ReshapeNet via atenção cruzada.

Quanto ao módulo Depth ControlNet, este orienta as camadas intermediária e decodificadora do ReshapeNet usando conexões residuais. Posteriormente, ele pega um mapa de profundidade renderizado a partir dos parâmetros SMPL de destino e o alinha com a imagem de destino.

ReshapeNet, baseado no SDXL UNet, é a rede central do Odo. Durante o treinamento, as imagens alvo são codificadas no espaço latente com um codificador automático variacional, com ruído ao longo do tempo e, então, eliminado o ruído pelo ReshapeNet usando recursos do ControlNet e ReferenceNet.

Mensagens de texto específicas para cada categoria, como "Deixar a pessoa mais gorda", "Deixar a pessoa mais magra" ou "Deixar a pessoa musculosa", foram adicionadas para orientar as transformações. Enquanto os mapas de profundidade capturavam formas corporais grosseiras, as mensagens forneciam os detalhes semânticos necessários para alterações como definição muscular, permitindo que o modelo produzisse modificações mais precisas e realistas.

Implementação de treinamento

Odo foi treinado no conjunto de dados sintéticos do projeto, combinado com um subconjunto do DeepFashion-MultiModal conjunto de dados, gerando um total de 20,000 pares de imagens.

Os dados do DeepFashion-MultiModal forneceram variedade em vestimentas e características faciais, com imagens pareadas entre si durante o treinamento. Com todos os mapas de profundidade SMPL pré-calculados para maior eficiência, o treinamento durou 60 épocas em uma única GPU NVIDIA A100 com 80 GB de VRAM.

Com as imagens de entrada redimensionadas para 768×1024, o Adam otimizador foi usado, em um taxa de Aprendizagem de 1×10⁻⁵. O ReshapeNet foi inicializado com pesos SDXL UNet e ajustado juntamente com o adaptador IP do seu ponto de verificação.

O ReferenceNet foi inicializado com pesos SDXL e mantido congelado, enquanto o Depth ControlNet usou pesos pré-treinados e também permaneceu congelado.

O modelo final exigiu cerca de 23 GB de memória de GPU, exigindo 18 segundos para inferência de imagem única.

Uma nova métrica

A falta de conjuntos de dados do tipo necessário para esse tipo de projeto significava que nenhuma métrica existente realmente abordava o desafio. Por isso, os autores criaram um novo benchmark, composto por 3,600 pares de imagens, apresentando imagens de rostos reais e descrições de fundo, além de diversas variações de formas corporais.

Outras métricas utilizadas foram o Índice de Similaridade Estrutural (SSIM); Relação sinal-ruído de pico (PSNR); Similaridade de Patch de Imagem Perceptual Aprendida (LPIPS); e erro euclidiano corrigido por escala por vértice em pose neutra (T-) (PVE-T-SC).

Primeiro, os autores testaram seu método qualitativamente em imagens in-the-wild (imagens não vistas pelo modelo durante o treinamento):

Testes qualitativos. Os exemplos mostram conversões da imagem original para tipos de corpo mais magros, acima do peso e musculosos em diferentes poses, incluindo sentado e em pé. Consulte o artigo original para obter melhores definições e detalhes.

Destes resultados, o artigo afirma:

'[Nosso] método lida efetivamente com poses, fundos e roupas diversas, preservando a identidade da pessoa.

'Além dos formatos alvo do SMPL, fornecemos instruções textuais – 'Deixar a pessoa mais gorda', 'Deixar a pessoa mais magra' ou 'Deixar a pessoa musculosa' – para orientar explicitamente as transformações desejadas...

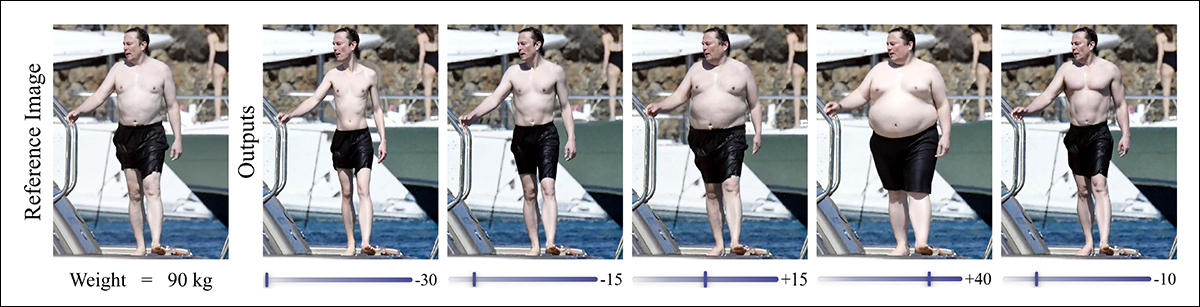

…'[A imagem abaixo] demonstra ainda mais a capacidade do nosso modelo de realizar diversas transformações de forma. O modelo segue com precisão os mapas de profundidade SMPL para gerar múltiplas variações de versões mais finas e mais grossas a partir da imagem de referência.'

Mais testes qualitativos abrangendo a gama de tipos de corpos-alvo. Consulte o artigo original para obter mais definições e detalhes.

Os autores comentam ainda:

'Nossos resultados demonstram transformações mais realistas de acordo com o peso alvo, pois nosso modelo ajusta simultaneamente o formato geral do corpo, as proporções dos membros e as roupas, resultando em modificações anatomicamente consistentes e visualmente convincentes.'

Para testes quantitativos, os autores compararam seu sistema com o modelo de código aberto Flux Kontext [dev], FLUX.1, e o 2022 oferecendo treinamento para distância Geração de fluxo com reconhecimento de estrutura para remodelação do corpo humano.

Para o FLUX.1 Kontext [dev], os prompts foram projetados para instruir 'Tornar a pessoa mais gorda', 'Tornar a pessoa mais magra' ou 'Tornar a pessoa musculosa', com pesos-alvo especificados — embora a falta de controles precisos limitasse o desempenho:

![Comparação de Odo com a geração de fluxo com reconhecimento de estrutura para remodelação do corpo humano e FLUX.1 Kontext [dev] no conjunto de teste, juntamente com resultados de ablação para modelos treinados sem condicionamento rápido no ReshapeNet, sem ReferenceNet (usando apenas o adaptador IP) e com treinamento restrito ao conjunto de dados BR-5K. A tabela também inclui material relacionado a estudos de ablação (BR-5K), que não abordaremos aqui.](https://www.unite.ai/wp-content/uploads/2025/08/table-2-1.jpg)

Comparação de Odo com geração de fluxo com reconhecimento de estrutura para remodelação do corpo humano e FLUX.1 Kontext [dev] no conjunto de teste, juntamente com resultados de ablação (não abordados neste artigo) para modelos treinados sem condicionamento rápido no ReshapeNet, sem ReferenceNet (usando apenas o adaptador IP) e com treinamento restrito ao conjunto de dados BR-5K.

Conclusão

O advento do Flux Kontext este ano, e ainda mais recentemente o lançamento dos pesos não quantizados para Edição de imagem Qwen, trouxeram os dados de imagens pareadas de volta à vanguarda das comunidades amadora e profissional. No clima de crescentes críticas e impaciência em relação à imprecisão da IA generativa, modelos desse tipo são projetados para uma fidelidade muito maior às imagens de origem (embora modelos em menor escala às vezes sejam prejudicados por seus objetivos de treinamento muito específicos).

Nesse caso, a utilidade de um sistema de modelagem corporal parece residir nos campos psicológico, médico e da moda. No entanto, ainda é possível que sistemas desse tipo alcancem um nível maior de destaque e, talvez, um conjunto de usos mais casuais e até potencialmente preocupantes.

Primeira publicação na segunda-feira, 25 de agosto de 2025