Inteligencia artificial

GOTCHA– Un sistema CAPTCHA para Live Deepfakes

Una nueva investigación de la Universidad de Nueva York se suma a las crecientes indicaciones de que es posible que pronto tengamos que realizar el equivalente falso de una 'prueba de embriaguez' para autenticarnos, antes de comenzar una videollamada confidencial, como una videoconferencia relacionada con el trabajo o cualquier otra. otro escenario sensible que puede atraer a los estafadores utilizando falsificación profunda en tiempo real software de transmisión.

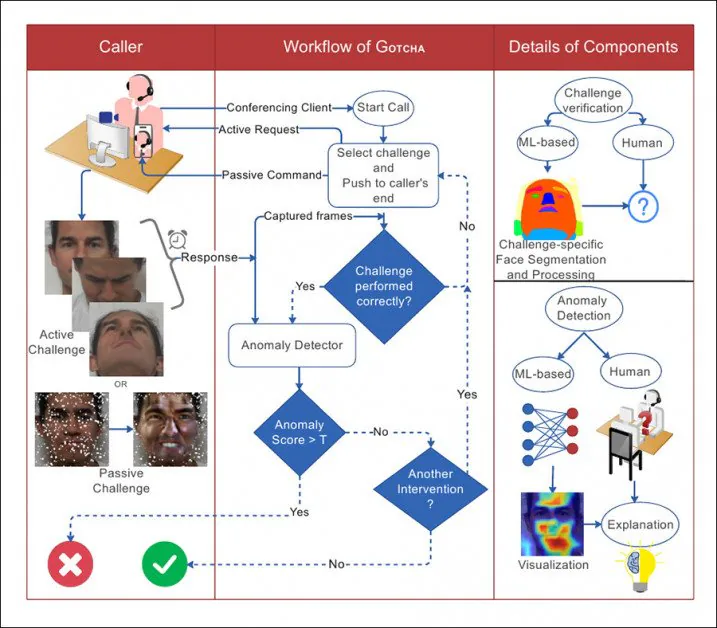

Algunos de los retos activos y pasivos aplicados a escenarios de videollamadas en GOTCHA. El usuario debe cumplir y superar los desafíos, mientras que se utilizan métodos 'pasivos' adicionales (como intentar sobrecargar un posible sistema falso profundo) sobre los cuales el participante no tiene influencia. Fuente: http://export.arxiv.org/pdf/2210.06186

El sistema propuesto se titula GOTCHA, un tributo a los sistemas CAPTCHA que se han convertido en un obstáculo cada vez mayor para la navegación web en los últimos 10 a 15 años, en los que los sistemas automatizados requieren que el usuario realice tareas en las que las máquinas son malas, como identificar animales. o descifrar texto ilegible (e, irónicamente, estos desafíos a menudo convierte al usuario en un libre AMT-estilo anotador subcontratado).

En esencia, GOTCHA extiende el mes de agosto de 2022 DF-Captcha artículo de la Universidad Ben-Gurion, que fue el primero en proponer que la persona al otro lado de la llamada pasara por algunos aros visualmente semánticos para probar su autenticidad.

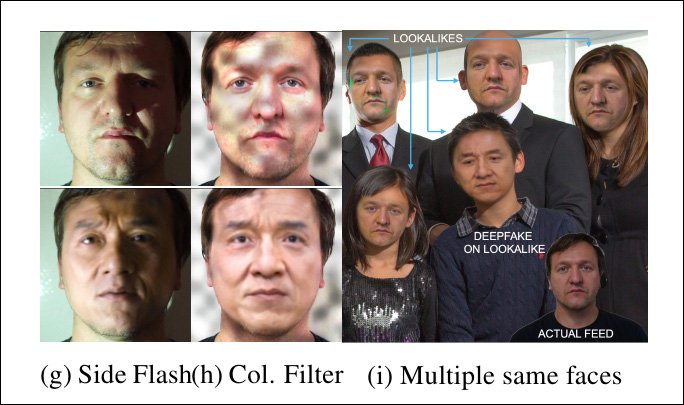

El artículo de agosto de 2022 de la Universidad Ben Gurion propuso por primera vez una variedad de pruebas interactivas para un usuario, incluida la oclusión de la cara o incluso la depresión de la piel, tareas que incluso los sistemas deepfake en vivo bien entrenados pueden no haber anticipado o no ser capaces de hacer frente de manera fotorrealista. . Fuente: https://arxiv.org/pdf/2208.08524.pdf

En particular, GOTCHA agrega metodologías 'pasivas' a una 'cascada' de pruebas propuestas, incluida la superposición automática de elementos irreales sobre la cara del usuario y la 'sobrecarga' de marcos que pasan por el sistema de origen. Sin embargo, solo las tareas que responden al usuario pueden evaluarse sin permisos especiales para acceder al sistema local del usuario, lo que, presumiblemente, vendría en forma de módulos locales o complementos para sistemas populares como Skype y Zoom, o incluso en el forma de software propietario dedicado específicamente encargado de eliminar a los falsificadores.

Del artículo, una ilustración de la interacción entre la persona que llama y el sistema en GOTCHA, con líneas punteadas a medida que fluye la decisión.

Los investigadores validaron el sistema en un nuevo conjunto de datos que contenía más de 2.5 millones de fotogramas de video de 47 participantes, cada uno de los cuales realizó 13 desafíos de GOTCHA. Afirman que el marco induce una reducción 'consistente y medible' en la calidad del contenido deepfake para usuarios fraudulentos, forzando el sistema local hasta que los artefactos evidentes dejan claro el engaño a simple vista (aunque GOTCHA también contiene algunos métodos de análisis algorítmicos más sutiles).

El nuevo documento se titula Gotcha: un sistema de desafío y respuesta para la detección de falsificaciones profundas en tiempo real (el nombre del sistema está en mayúscula en el cuerpo pero no el título de la publicación, aunque no es un acrónimo).

Una gama de desafíos

Principalmente de acuerdo con el documento de Ben Gurion, los desafíos reales que enfrentan los usuarios se dividen en varios tipos de tareas.

oclusión, el usuario debe oscurecer su rostro con la mano o con otros objetos, o presentar su rostro en un ángulo que probablemente no haya sido entrenado en un modelo falso profundo (generalmente debido a la falta de datos de entrenamiento para ' poses impares: consulte la gama de imágenes en la primera ilustración de arriba).

Además de las acciones que el usuario puede realizar por sí mismo de acuerdo con las instrucciones, GOTCHA puede superponer recortes faciales aleatorios, calcomanías y filtros de realidad aumentada para 'corromper' el flujo de rostros que un modelo falso local entrenado puede estar esperando, causando que falle. . Como se indicó anteriormente, aunque este es un proceso 'pasivo' para el usuario, es intrusivo para el software, que debe poder intervenir directamente en el flujo del corresponsal final.

A continuación, es posible que se le solicite al usuario que coloque su rostro en expresiones faciales inusuales que probablemente estén ausentes o subrepresentadas en cualquier conjunto de datos de entrenamiento, lo que provoca una disminución de la calidad de la salida falsificada (imagen 'b', segunda columna desde la izquierda , en la primera ilustración de arriba).

Como parte de esta serie de pruebas, es posible que se requiera que el usuario lea un texto o entable una conversación diseñada para desafiar un sistema local de falsificación en vivo, que puede no haber entrenado una variedad adecuada de fonemas u otros tipos de datos bucales a un nivel donde puede reconstruir el movimiento preciso de los labios bajo tal escrutinio.

Finalmente (y esto parece desafiar el talento actoral del corresponsal final), en esta categoría, se le puede pedir al usuario que realice una microexpresión, una expresión facial corta e involuntaria que desmiente una emoción. De esto dice el diario '[suele] durar entre 0.5 y 4.0 segundos y es difícil de falsificar'.

Aunque el documento no describe cómo extraer una microexpresión, la lógica sugiere que la única forma de hacerlo es crear una emoción apropiada en el usuario final, tal vez con algún tipo de contenido sorprendente presentado como parte de la rutina de la prueba. .

Distorsión facial, iluminación y Invitados inesperados

Además, en línea con las sugerencias del documento de agosto, el nuevo trabajo propone pedirle al usuario final que realice manipulaciones y distorsiones faciales inusuales, como presionar su dedo en su mejilla, interactuar con su cara y/o cabello, y realizar otras movimientos que es probable que ningún sistema deepfake en vivo actual pueda manejar bien, ya que se trata de acciones marginales; incluso si estuvieran presentes en el conjunto de datos de entrenamiento, su reproducción probablemente sería de baja calidad, en línea con otros datos 'atípicos'.

Una sonrisa, pero esta 'cara deprimida' no se traduce bien por un sistema local de deepfake en vivo.

Un desafío adicional radica en cambiar las condiciones de iluminación en las que se encuentra el usuario final, ya que es posible que el entrenamiento de un modelo deepfake se haya optimizado para situaciones de iluminación de videoconferencia estándar, o incluso las condiciones de iluminación exactas en las que se realiza la llamada. .

Por lo tanto, se le puede pedir al usuario que ilumine la cara con la linterna de su teléfono móvil o que altere la iluminación de alguna otra manera (y vale la pena señalar que esta táctica es la propuesta central de otro documento de detección de deepfake en vivo que salió este verano).

Los sistemas de deepfake en vivo se ven desafiados por una iluminación inesperada, e incluso por varias personas en la transmisión, donde solo esperaba una sola persona.

En el caso de que el sistema propuesto tenga la capacidad de interponerse en el flujo de usuarios local (que se sospecha que alberga un intermediario falso), agregar patrones inesperados (ver la columna central en la imagen de arriba) puede comprometer la capacidad del algoritmo falso para mantener una simulación. .

Además, aunque no es razonable esperar que un corresponsal tenga personas adicionales disponibles para ayudar a autenticarlo, el sistema puede intercalar caras adicionales (imagen arriba a la derecha) y ver si algún sistema falso local comete el error de cambiar la atención, o incluso tratando de falsificarlos a todos (los sistemas de autocodificación profunda no tienen capacidades de 'reconocimiento de identidad' que podrían mantener la atención enfocada en un individuo en este escenario).

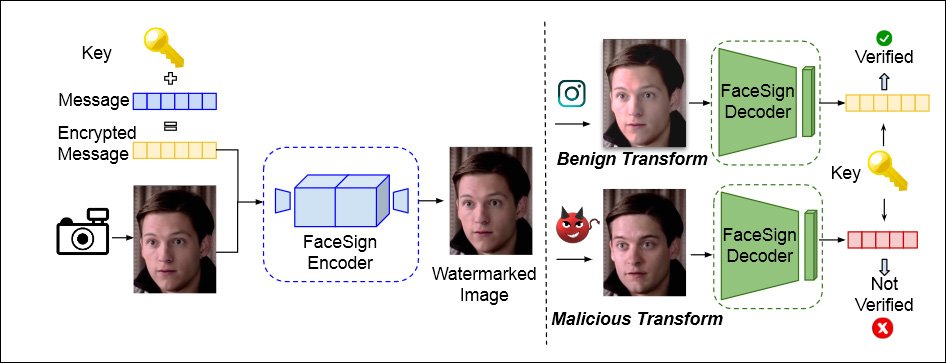

Esteganografía y sobrecarga

GOTCHA también incorpora un enfoque primero propuesto por UC San Diego en abril de este año, y que usa esteganografía para encriptar un mensaje en la transmisión de video local del usuario. Las rutinas de Deepfake destruirán por completo este mensaje, lo que provocará una falla de autenticación.

De un artículo de abril de 2022 de la Universidad de California en San Diego y la Universidad Estatal de San Diego, un método para determinar la identidad auténtica al ver si una señal esteganográfica enviada a la transmisión de video de un usuario sobrevive intacta al bucle local. puede estar a la mano. Fuente: https://arxiv.org/pdf/2204.01960.pdf

Además, GOTCHA es capaz de sobrecargar el sistema local (con acceso y permiso dados), al duplicar un flujo y presentar datos 'excesivos' a cualquier sistema local, diseñado para causar fallas en la replicación en un sistema deepfake local.

El sistema contiene más pruebas (consulte el documento para obtener más detalles), incluido un desafío, en el caso de un corresponsal basado en un teléfono inteligente, de poner su teléfono al revés, lo que distorsionará un sistema local de falsificación profunda:

Nuevamente, este tipo de cosas solo funcionaría con un caso de uso convincente, donde el usuario se ve obligado a otorgar acceso local a la transmisión y no puede implementarse mediante una simple evaluación pasiva del video del usuario, a diferencia de las pruebas interactivas (como presionar un dedo en la cara).

Sentido práctico

El documento aborda brevemente hasta qué punto las pruebas de esta naturaleza pueden molestar al usuario final, o de alguna manera incomodarlo, por ejemplo, al obligar al usuario a tener a mano una serie de objetos que pueden ser necesarios para las pruebas, como gafas de sol.

También reconoce que puede ser difícil lograr que corresponsales poderosos cumplan con las rutinas de prueba. Respecto al caso de una videollamada con un CEO, los autores afirman:

“La facilidad de uso puede ser clave aquí, por lo que los desafíos informales o frívolos (como distorsiones o expresiones faciales) pueden no ser apropiados. Los desafíos que utilizan artículos físicos externos pueden no ser deseables. El contexto aquí se modifica adecuadamente y GOTCHA adapta su conjunto de desafíos en consecuencia.'

Datos y Pruebas

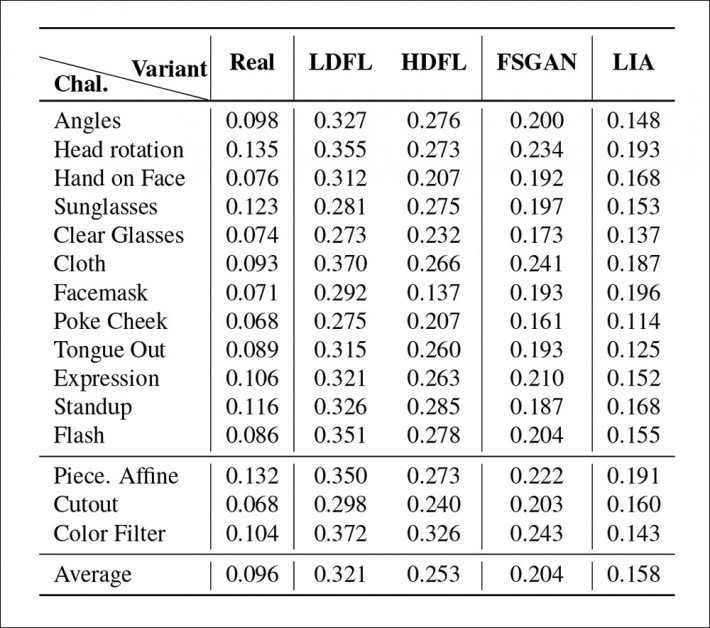

GOTCHA se probó con cuatro variantes del sistema local de deepfakes en vivo, incluidas dos variaciones del muy popular creador de deepfakes con codificador automático. ProfundoFaceLab ('DFL', aunque, sorprendentemente, el documento no menciona cara profunda en vivo, que ha sido, desde agosto de 2021, la implementación 'en vivo' de DeepFaceLab, y parece el recurso inicial más probable para un falsificador potencial).

Los cuatro sistemas DFL fueron entrenados 'ligeramente' en una persona no famosa que participaba en las pruebas y una celebridad emparejada; DFL entrenó más completamente, a más de 2 millones de iteraciones o pasos, donde uno esperaría un modelo mucho más eficaz; Animador de imagen latente (LIA); y Red adversaria generativa de intercambio de rostros (FSGAN).

Para los datos, los investigadores capturaron y seleccionaron los videoclips antes mencionados, con 47 usuarios realizando 13 desafíos activos, con cada usuario produciendo alrededor de 5 a 6 minutos de video de 1080p a 60 fps. Los autores afirman también que estos datos eventualmente se harán públicos.

La detección de anomalías puede ser realizada por un observador humano o algorítmicamente. Para esta última opción, el sistema fue entrenado en 600 caras de la Conjunto de datos de FaceForensics. La función de pérdida de regresión fue la poderosa similitud de parche de imagen perceptual aprendida (LPIPS), mientras que la entropía cruzada binaria se usó para entrenar al clasificador. Cámara propia se utilizó para visualizar los pesos del detector.

Resultados primarios de las pruebas de GOTCHA.

Los investigadores encontraron que para la cascada completa de pruebas en los cuatro sistemas, la distribución DFL más entrenada obtuvo el número y la gravedad más bajos de anomalías (es decir, artefactos que revelarían la presencia de un sistema deepfake). La versión menos entrenada luchó en particular para recrear movimientos de labios complejos (que ocupan muy poco del encuadre, pero que reciben mucha atención humana), mientras que FSGAN ocupó el punto medio entre las dos versiones DFL, y LIA demostró ser completamente inadecuado para la tarea. , con los investigadores opinando que LIA fallaría en un despliegue real.

Publicado por primera vez el 17 de octubre de 2022.