Robotik

Wie Roboter lernen, um Hilfe zu bitten

In der sich entwickelnden Welt der Robotik sticht eine bahnbrechende Zusammenarbeit zwischen der Princeton University und Google heraus. Ingenieure dieser renommierten Institutionen haben eine innovative Methode entwickelt, die Robotern eine entscheidende Fähigkeit beibringt: zu erkennen, wann sie Hilfe benötigen und wie sie darum bitten können. Diese Entwicklung stellt einen bedeutenden Fortschritt in der Robotik dar und schließt die Lücke zwischen autonomem Funktionieren und Mensch-Roboter-Interaktion.

Der Weg zu intelligenteren und unabhängigeren Robotern wurde schon immer durch eine große Herausforderung behindert: die Komplexität und Mehrdeutigkeit der menschlichen Sprache. Anders als die binäre Klarheit von Computercodes ist die menschliche Sprache voller Nuancen und Feinheiten, was sie für Roboter zu einem Labyrinth macht. Beispielsweise kann ein so einfacher Befehl wie „Hebe die Schüssel auf“ zu einer komplexen Aufgabe werden, wenn mehrere Schüsseln vorhanden sind. Roboter, die in der Lage sind, ihre Umgebung wahrzunehmen und auf Sprache zu reagieren, stehen angesichts solcher sprachlicher Unsicherheiten oft an einem Scheideweg.

Quantifizierung der Unsicherheit

Um diese Herausforderung zu meistern, hat das Team von Princeton und Google einen neuartigen Ansatz entwickelt, der die Unschärfe menschlicher Sprache quantifiziert. Diese Technik misst im Wesentlichen den Grad der Unsicherheit in Sprachbefehlen und nutzt diesen Messwert, um Roboteraktionen zu steuern. In Situationen, in denen ein Befehl zu mehreren Interpretationen führen könnte, kann der Roboter nun den Grad der Unsicherheit einschätzen und entscheiden, wann er nachfragen muss. In einer Umgebung mit mehreren Schüsseln würde beispielsweise ein höherer Grad der Unsicherheit den Roboter dazu veranlassen, zu fragen, welche Schüssel er nehmen soll, wodurch potenzielle Fehler oder Ineffizienzen vermieden werden.

Dieser Ansatz ermöglicht Robotern nicht nur ein besseres Sprachverständnis, sondern erhöht auch ihre Sicherheit und Effizienz bei der Aufgabenausführung. Durch die Integration großer Sprachmodelle (LLMs) wie denen hinter ChatGPT haben die Forscher einen bedeutenden Schritt getan, um Roboteraktionen besser an die Erwartungen und Bedürfnisse des Menschen anzupassen.

Rolle großer Sprachmodelle

Die Integration von LLMs spielt bei diesem neuen Ansatz eine zentrale Rolle. LLMs sind maßgeblich an der Verarbeitung und Interpretation der menschlichen Sprache beteiligt. In diesem Zusammenhang werden sie verwendet, um die Unsicherheit bei Sprachbefehlen an Roboter zu bewerten und zu messen.

Allerdings ist die Nutzung von LLMs nicht ohne Herausforderungen. Wie das Forschungsteam betont, können die Ergebnisse von LLMs manchmal unzuverlässig sein.

Anirudha Majumdar, Assistenzprofessorin in Princeton, betont die Bedeutung dieses Gleichgewichts:

„Das blinde Befolgen von Plänen, die von einem LLM erstellt wurden, könnte dazu führen, dass Roboter unsicher oder nicht vertrauenswürdig handeln. Deshalb müssen unsere LLM-basierten Roboter wissen, wann sie etwas nicht wissen.“

Dies unterstreicht die Notwendigkeit eines differenzierten Ansatzes, bei dem LLMs als Orientierungsinstrumente und nicht als unfehlbare Entscheidungsträger eingesetzt werden.

Praktische Anwendung und Prüfung

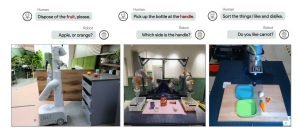

Die Praktikabilität dieser Methode wurde in verschiedenen Szenarien getestet und ihre Vielseitigkeit und Effektivität unter Beweis gestellt. Ein solcher Test umfasste einen Roboterarm, der Spielzeuglebensmittel in verschiedene Kategorien sortieren sollte. Dieser einfache Aufbau demonstrierte die Fähigkeit des Roboters, Aufgaben mit klaren Auswahlmöglichkeiten effektiv zu bewältigen.

Bild: Princeton University

In einem weiteren Experiment mit einem Roboterarm, der auf einer Rollplattform in einer Büroküche montiert war, nahm die Komplexität erheblich zu. Hier stand der Roboter vor realen Herausforderungen wie der Identifizierung des richtigen Gegenstands, der in die Mikrowelle gestellt werden sollte, wenn ihm mehrere Optionen zur Verfügung standen.

Durch diese Tests stellten die Roboter erfolgreich ihre Fähigkeit unter Beweis, die quantifizierte Unsicherheit zu nutzen, um Entscheidungen zu treffen oder Klärungen anzustreben, und bestätigten so den praktischen Nutzen dieser Methode.

Zukünftige Implikationen und Forschung

Mit Blick auf die Zukunft gehen die Implikationen dieser Forschung weit über die aktuellen Anwendungen hinaus. Das Team unter der Leitung von Majumdar und dem Doktoranden Allen Ren untersucht, wie dieser Ansatz auf komplexere Probleme der Roboterwahrnehmung und KI angewendet werden kann. Dazu gehören Szenarien, in denen Roboter Seh- und Sprachinformationen kombinieren müssen, um Entscheidungen zu treffen, wodurch die Lücke zwischen Roboterverständnis und menschlicher Interaktion weiter geschlossen wird.

Die laufende Forschung zielt nicht nur darauf ab, die Fähigkeit von Robotern zu verbessern, Aufgaben mit höherer Genauigkeit auszuführen, sondern auch, die Welt mit einem Verständnis zu navigieren, das dem der menschlichen Kognition ähnelt. Diese Forschung könnte den Weg für Roboter ebnen, die nicht nur effizienter und sicherer sind, sondern auch besser auf die differenzierten Anforderungen der menschlichen Umgebung abgestimmt sind.

Hier finden Sie die veröffentlichten Forschungsergebnisse werden auf dieser Seite erläutert.