Künstliche Intelligenz

KI-Bildmattierung, die Szenen versteht

In der Extras-Dokumentation zur DVD-Veröffentlichung von 2003 Alien3 (1992) erinnerte sich die Visual-Effects-Legende Richard Edlund mit Entsetzen an das „Sumo-Ringen“ der photochemischen Mattextraktion, das die Arbeit mit Visual Effects zwischen den späte 1930er-Jahre und den späten 1980er Jahren. Edlund beschrieb die Hit-and-Miss-Natur des Prozesses als „Sumo-Ringen“, im Vergleich zu den digitalen Blue/Green-Screen-Techniken, die sich in den frühen 1990er Jahren durchsetzten (und er hat ist zurückgekommen zur Metapher seitdem).

Das Extrahieren eines Vordergrundelements (z. B. einer Person oder eines Raumschiffmodells) aus einem Hintergrund, damit das ausgeschnittene Bild zu einer Hintergrundplatte zusammengesetzt werden kann, wurde ursprünglich dadurch erreicht, dass das Vordergrundobjekt vor einem einheitlichen blauen oder grünen Hintergrund gefilmt wurde.

Aufwändige fotochemische Extraktionsverfahren für eine VFX-Aufnahme von ILM für „Die Rückkehr der Jedi-Ritter“ (1983). Quelle: https://www.youtube.com/watch?v=qwMLOjqPmbQ

Im resultierenden Filmmaterial würde die Hintergrundfarbe anschließend chemisch isoliert und als Vorlage verwendet, um das Vordergrundobjekt (oder die Person) in einem nachzudrucken optischer Drucker als „schwebendes“ Objekt in einer ansonsten transparenten Filmzelle.

Der Prozess wurde als Color Separation Overlay (CSO) bezeichnet – obwohl dieser Begriff später eher mit dem Rohprodukt in Verbindung gebracht wurde „Chromakey“ Videoeffekte im preisgünstigeren Fernsehen der 1970er und 1980er Jahre, die eher mit analogen als mit chemischen oder digitalen Mitteln erzielt wurden.

Eine Demonstration von Color Separation Overlay im Jahr 1970 für die britische Kindersendung „Blue Peter“. Quelle: https://www.bbc.co.uk/archive/blue_peter_noakes_CSO/zwb9vwx

Unabhängig davon, ob es sich um Film- oder Videoelemente handelt, kann das extrahierte Filmmaterial anschließend in jedes andere Filmmaterial eingefügt werden.

Obwohl Disneys deutlich teurere und proprietäre Natriumdampfverfahren (was speziell auf Gelb schaltete und auch war benutzt für Alfred Hitchcocks Horrorfilm von 1963 Die Vögel) eine bessere Definition und schärfere Mattierungen lieferte, blieb die photochemische Extraktion mühsam und unzuverlässig.

Disneys firmeneigenes Natriumdampfextraktionsverfahren erforderte Hintergründe im gelben Farbspektrum. Hier hängt Angela Lansbury während der Produktion einer VFX-Sequenz für „Die tollkühne Hexe in ihrem fliegenden Bett“ (1971) an Drähten. Quelle

Jenseits der digitalen Mattierung

In den 1990er-Jahren machte die digitale Revolution die Chemikalien überflüssig, aber nicht die Notwendigkeit von Greenscreens. Es war nun möglich, den grünen Hintergrund (oder eine andere Farbe) zu entfernen, indem einfach nach Pixeln innerhalb eines Toleranzbereichs dieser Farbe gesucht wurde, in Pixelbearbeitungsprogrammen wie Photoshop und einer neuen Generation von Video-Compositing-Suiten, die automatisch auskeyen konnten die farbigen Hintergründe. Fast über Nacht, sechzig Jahre der optischen Druckindustrie gehörten der Vergangenheit an.

Die letzten zehn Jahre der GPU-beschleunigten Computer-Vision-Forschung läuten die Matte-Extraktion in ein drittes Zeitalter ein und stellen Forscher vor die Aufgabe, Systeme zu entwickeln, die hochwertige Mattes extrahieren können, ohne dass Greenscreens erforderlich sind. Allein bei Arxiv gibt es wöchentlich Vorträge zu Innovationen in der auf maschinellem Lernen basierenden Vordergrundextraktion.

Bringen Sie uns ins Bild

Dieser Brennpunkt des akademischen und industriellen Interesses an der KI-Extraktion hat bereits Auswirkungen auf den Verbraucherbereich: Grobe, aber praktikable Implementierungen sind uns allen in Form von bekannt Zoom sowie Skype Filter, die unsere Wohnzimmerhintergründe in Videokonferenzgesprächen durch tropische Inseln usw. ersetzen können.

Allerdings erfordern die besten Matten immer noch einen Greenscreen, z Zoom notiert letzten Mittwoch.

Links: Ein Mann vor einem Greenscreen, dessen Haare mithilfe der Funktion „Virtueller Hintergrund“ von Zoom gut extrahiert wurden. Rechts: Eine Frau vor einer normalen häuslichen Szene, deren Haare algorithmisch extrahiert wurden, weniger genau und mit höheren Rechenleistungsanforderungen. Quelle: https://support.zoom.us/hc/en-us/articles/210707503-Changing-your-Virtual-Background-image

A weiterer post von der Plattform Zoom Support warnt, dass die Nicht-Greenscreen-Extraktion auch eine höhere Rechenleistung im Aufnahmegerät erfordert.

Die Notwendigkeit, es herauszuschneiden

Verbesserungen hinsichtlich Qualität, Tragbarkeit und Ressourceneinsparung bei „in der freien Wildbahn“ stattfindenden Mattenextraktionssystemen (d. h. Isolierung von Personen ohne die Notwendigkeit von Greenscreens) sind für weitaus mehr Sektoren und Zwecke relevant als nur für Videokonferenzfilter.

Für die Entwicklung von Datensätzen bietet eine verbesserte Gesichts-, Ganzkopf- und Ganzkörpererkennung die Möglichkeit, sicherzustellen, dass irrelevante Hintergrundelemente nicht in Computervisionsmodelle menschlicher Probanden eintrainiert werden. Eine genauere Isolierung würde die semantische Segmentierung Techniken zur Unterscheidung und Assimilation von Domänen (d. h 'Katze', 'Person', 'Boot'), und verbessern VAE sowie Transformator-basierte Bildsynthesesysteme wie OpenAIs neue DALL-E2; und bessere Extraktionsalgorithmen würden den Bedarf an teuren Handbüchern verringern rotoscoping in kostspieligen VFX-Pipelines.

Tatsächlich ist der Aufstieg von multimodal (normalerweise Text/Bild) Methoden, bei denen eine Domäne wie „Katze“ sowohl als Bild als auch mit zugehörigen Textreferenzen kodiert wird, finden bereits Eingang in die Bildverarbeitung. Ein aktuelles Beispiel ist die Text2Live Architektur, die multimodales (Text/Bild-)Training nutzt, um neben unzähligen anderen Möglichkeiten auch Videos zu erstellen. Kristallschwäne und Glasgiraffen.

Szenenbezogene KI-Mattierung

Ein großer Teil der Forschung zur KI-basierten automatischen Mattierung konzentrierte sich auf die Grenzerkennung und Bewertung pixelbasierter Gruppierungen innerhalb eines Bild- oder Videorahmens. Neue Forschungsergebnisse aus China bieten jedoch eine Extraktionspipeline, die durch Nutzung die Abgrenzung und Mattierungsqualität verbessert textbasierte Beschreibungen einer Szene (ein multimodaler Ansatz, der in den letzten drei bis vier Jahren im Bereich der Computer-Vision-Forschung an Bedeutung gewonnen hat) und behauptet, frühere Methoden in vielerlei Hinsicht verbessert zu haben.

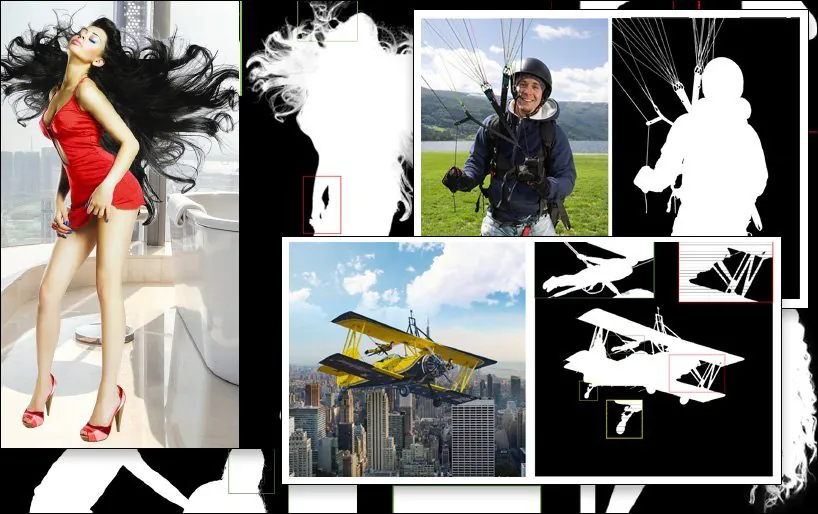

Ein Beispiel für die SPG-IM-Extraktion (letztes Bild unten rechts) im Vergleich mit konkurrierenden früheren Methoden. Quelle: https://arxiv.org/pdf/2204.09276.pdf

Die Herausforderung für den Teilsektor der Extraktionsforschung besteht darin, Arbeitsabläufe zu erstellen, die ein Minimum an manuellen Anmerkungen und menschlichen Eingriffen erfordern – im Idealfall gar keine. Neben den Kostenauswirkungen stellen die Forscher des neuen Papiers fest, dass Anmerkungen und manuelle Segmentierungen, die von ausgelagerten Crowdworkern in verschiedenen Kulturen vorgenommen werden, dazu führen können, dass Bilder auf unterschiedliche Weise gekennzeichnet oder sogar segmentiert werden, was zu inkonsistenten und unbefriedigenden Algorithmen führt.

Ein Beispiel hierfür ist die subjektive Interpretation dessen, was ein „Vordergrundobjekt“ definiert:

Aus dem neuen Artikel: Frühere Methoden LFM sowie MODNet („GT“ steht für Ground Truth, ein „ideales“ Ergebnis, das oft manuell oder mit nicht-algorithmischen Methoden erreicht wird) haben unterschiedliche und unterschiedlich effektive Ansätze zur Definition von Vordergrundinhalten, während die neue SPG-IM-Methode „nahe Inhalte“ durch den Szenenkontext effektiver abgrenzt.

Um dieses Problem anzugehen, haben die Forscher eine zweistufige Pipeline mit dem Titel entwickelt Situationswahrnehmungsgesteuerte Bildmattierung (SPG-IM). Die zweistufige Encoder-/Decoder-Architektur umfasst Situational Perception Distillation (SPD) und Situational Perception Guided Matting (SPGM).

Zunächst trainiert SPD vorab visuelle Transformationen von Textmerkmalen und generiert Bildunterschriften, die zu den zugehörigen Bildern passen. Danach wird die Vorhersage der Vordergrundmaske aktiviert, indem die Pipeline mit einem Roman verbunden wird Vorhersage der Ausprägung Technik.

Anschließend gibt SPGM eine geschätzte Alpha-Matte aus, die auf der Roh-RGB-Bildeingabe und der im ersten Modul erhaltenen generierten Maske basiert.

Das Ziel ist eine situative Wahrnehmungsführung, bei der das System über ein kontextbezogenes Verständnis davon verfügt, woraus das Bild besteht, und es ihm so ermöglicht, beispielsweise die Herausforderung, komplexe Haare aus einem Hintergrund zu extrahieren, vor dem Hintergrund bekannter Merkmale einer solchen spezifischen Aufgabe einzuordnen.

Im folgenden Beispiel geht SPG-IM davon aus, dass die Schnüre zu einem „Fallschirm“ gehören, während MODNet diese Details nicht speichert und definiert. Ebenso geht die komplette Struktur des Spielplatzgeräts in MODNet willkürlich verloren.

The new Krepppapier ist betitelt Situationswahrnehmungsgesteuerte Bildmattierungund stammt von Forschern des OPPO Research Institute, PicUp.ai und Xmotors.

Intelligente automatisierte Matten

SPG-IM bietet außerdem ein Adaptive Focal Transformation (AFT) Refinement Network, das lokale Details und globalen Kontext separat verarbeiten kann und so „intelligente Matten“ ermöglicht.

Das Verständnis des Szenenkontexts, in diesem Fall „Mädchen mit Pferd“, kann die Vordergrundextraktion möglicherweise einfacher machen als frühere Methoden.

Das Papier sagt:

„Wir glauben, dass visuelle Darstellungen von der visuell-textuellen Aufgabe, z Bei der Bildbeschriftung liegt der Fokus auf semantisch umfassenderen Signalen zwischen a) Objekt zu Objekt und b) Objekt zur Umgebung, um Beschreibungen zu generieren, die sowohl allgemeine Informationen als auch lokale Details abdecken. Darüber hinaus können Textbeschriftungen im Vergleich zur teuren Pixelannotation der Bildmattierung sehr kostengünstig in großen Mengen erfasst werden.

Der SPD-Zweig der Architektur wird gemeinsam mit der University of Michigan vortrainiert VirTex transformatorbasierter Textdecoder, der visuelle Darstellungen aus semantisch dichten Untertiteln lernt.

VirTex trainiert gemeinsam ein ConvNet und Transformers über Bildunterschriften-Couplets und überträgt die gewonnenen Erkenntnisse auf nachgelagerte Vision-Aufgaben wie die Objekterkennung. Quelle: https://arxiv.org/pdf/2006.06666.pdf

Neben anderen Tests und Ablationsstudien testeten die Forscher SPG-IM im Vergleich zum neuesten Stand der Technik Trimap-basierte Methoden Deep Image Matting (DIM), IndexNet, kontextbezogene Bildmattierung (CAM), Geführte kontextuelle Aufmerksamkeit (GCA), FBAund semantische Bildzuordnung (JA).

Andere zuvor getestete Frameworks umfassten trimapfreie Ansätze LFM, HAttMatting und MODNet. Für einen fairen Vergleich wurden die Testmethoden basierend auf den unterschiedlichen Methodologien angepasst; wo kein Code verfügbar war, wurden die Techniken des Papiers aus der beschriebenen Architektur reproduziert.

Im neuen Papier heißt es:

„Unser SPG-IM übertrifft alle konkurrierenden Trimap-freien Methoden ([LFM], [HAttMatting] und [MODNet]) bei weitem. Gleichzeitig zeigt unser Modell auch eine bemerkenswerte Überlegenheit gegenüber den modernsten (SOTA) Trimap-basierten und maskengesteuerten Methoden in Bezug auf alle vier Metriken der öffentlichen Datensätze (d. h. Composition-1K, Distinction-646 und Human-2K) und unseren Multi-Object-1K-Benchmark.“

Und fährt fort:

„Es ist deutlich zu erkennen, dass unsere Methode feine Details (z. B. Haarspitzen, transparente Texturen und Grenzen) ohne die Hilfe von Trimap bewahrt. Darüber hinaus kann unser SPG-IM im Vergleich zu anderen konkurrierenden Trimap-freien Modellen eine bessere globale semantische Vollständigkeit bewahren.“

Erstveröffentlichung am 24. April 2022.