Кут Андерсона

До повного контролю у створенні відео зі штучним інтелектом

Відео моделі основи, такі як Хуньюань та Ван 2.1, хоч і є потужним, але не пропонує користувачам такого детального контролю, якого вимагає виробництво фільмів і телепередач (зокрема виробництво VFX).

У професійних студіях візуальних ефектів такі моделі з відкритим кодом, як ці, а також більш ранні моделі на основі зображень (а не відео), як-от Стабільна дифузія, Кандинський та Потік, як правило, використовуються разом із набором допоміжних інструментів, які адаптують необроблений вихід для задоволення конкретних творчих потреб. Коли директор каже, «Це виглядає чудово, але чи можемо ми зробити це трохи більше [n]?» Ви не можете відповідати, кажучи, що модель недостатньо точна, щоб обробляти такі запити.

Замість цього команда VFX зі штучним інтелектом використовуватиме низку традиційних CGI і композиційні техніки в поєднанні з користувальницькими процедурами та робочими процесами, розробленими з часом, щоб спробувати трохи розширити межі відеосинтезу.

Отже, за аналогією, базова відеомодель дуже схожа на стандартну інсталяцію веб-браузера, такого як Chrome; вона багато чого робить "з коробки", але якщо ви хочете, щоб вона адаптувалася до ваших потреб, а не навпаки, вам знадобляться деякі плагіни.

Контрольні фрики

У світі синтезу зображень на основі дифузії найважливішою є така стороння система ControlNet.

ControlNet — це техніка для додавання структурованого керування до генеративних моделей на основі дифузії, що дозволяє користувачам керувати створенням зображень або відео за допомогою додаткових вхідних даних, таких як карти країв, карти глибиниабо представляти інформацію.

Різні методи ControlNet дозволяють виконувати такі дії: глибина>зображення (верхній ряд), семантична сегментація>зображення (внизу ліворуч) та генерація зображень людей і тварин на основі поз (внизу ліворуч).

Замість того, щоб покладатися виключно на текстові підказки, ControlNet представляє окремі гілки нейронної мережі, або Адаптери, які обробляють ці сигнали кондиціонування, зберігаючи генеративні можливості базової моделі.

Це дозволяє точно налаштувати виходи, які більше відповідають специфікаціям користувача, що робить його особливо корисним у програмах, де потрібна точна композиція, структура або керування рухом:

Завдяки керівній позі через ControlNet можна отримати різноманітні точні типи вихідних даних. Джерело: https://arxiv.org/pdf/2302.05543

Однак подібні фреймворки на основі адаптерів діють ззовні на набір нейронних процесів, які дуже орієнтовані на внутрішні процеси. Ці підходи мають кілька недоліків.

Спочатку адаптери навчаються самостійно, приводячи до галузеві конфлікти при поєднанні кількох адаптерів, що може призвести до погіршення якості генерації.

По-друге, вводять надмірність параметрів, що вимагає додаткових обчислень і пам’яті для кожного адаптера, що робить масштабування неефективним.

По-третє, незважаючи на свою гнучкість, перехідники часто випускають неоптимальний результати порівняно з моделями, які повністю тонко налаштований для створення кількох умов. Ці проблеми роблять методи на основі адаптера менш ефективними для завдань, що вимагають повної інтеграції кількох керуючих сигналів.

В ідеалі можливості ControlNet повинні бути навчені спочатку у модель модульним способом, який міг би вмістити пізніші та довгоочікувані очевидні нововведення, такі як одночасна генерація відео/аудіо або власні можливості синхронізації губ (для зовнішнього аудіо).

Наразі кожна додаткова функціональність являє собою або завдання постпродакшну, або ненативну процедуру, яка має орієнтуватися в жорстко пов'язаних та чутливих вагах будь-якої базової моделі, на якій вона працює.

FullDiT

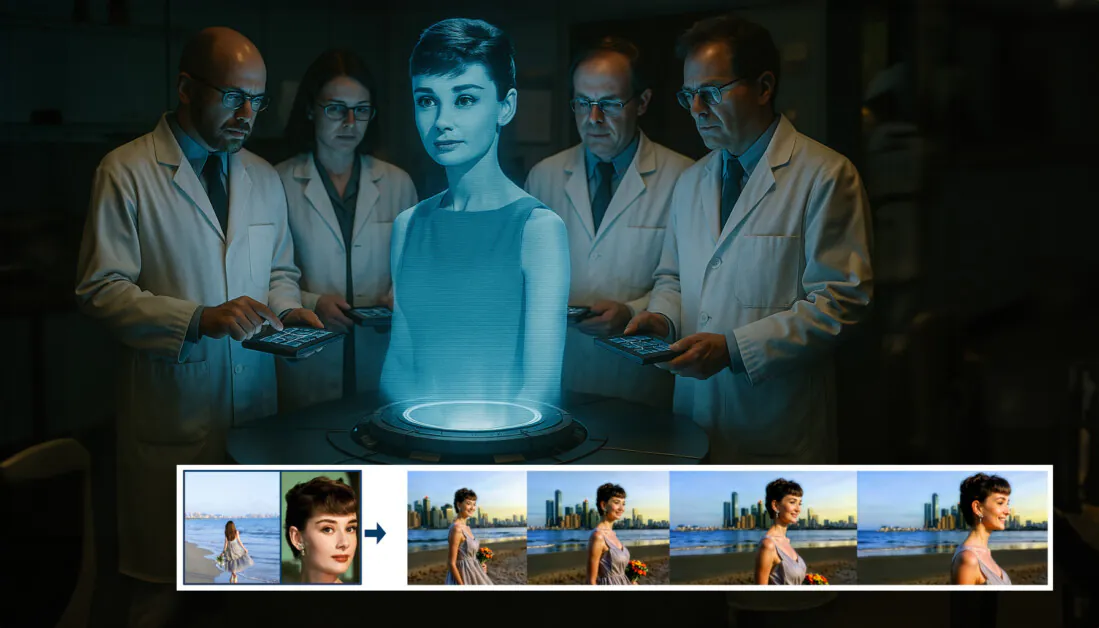

У цьому протистоянні з’явилася нова пропозиція з Китаю, яка передбачає систему, в якій вимірювання у стилі ControlNet запікаються безпосередньо в генеративну відеомодель під час навчання, замість того, щоб залишатися позаду.

З нової статті: підхід FullDiT може включати нав’язування ідентичності, глибину та рух камери в рідне покоління, і може викликати будь-яку комбінацію цього одночасно. Джерело: https://arxiv.org/pdf/2503.19907

Титулований FullDiT, новий підхід поєднує багатозадачні умови, такі як передача ідентичності, відображення глибини та рух камери, в інтегровану частину навченої генеративної відеомоделі, для якої автори створили прототип навченої моделі та супровідні відеокліпи на сайт проекту.

У прикладі нижче ми бачимо покоління, які включають рух камери, ідентифікаційну інформацію та текстову інформацію (тобто керівні текстові підказки користувача):

Натисніть, щоб відтворити. Приклади верстки користувача в стилі ControlNet лише з власною навченою базовою моделлю. Джерело: https://fulldit.github.io/

Слід зазначити, що автори не пропонують свою експериментальну навчену модель як функціональну базову модель, а радше як доказ концепції для власних моделей перетворення тексту у відео (T2V) і зображень у відео (I2V), які пропонують користувачам більше контролю, ніж просто підказка зображення або текстова підказка.

Оскільки подібних моделей поки що немає, дослідники створили новий тест під назвою FullBench, для оцінки багатозадачних відео, і стверджувати про найсучаснішу продуктивність у подібних тестах, які вони розробили на основі попередніх підходів. Однак, оскільки FullBench був розроблений самими авторами, його об’єктивність не перевірена, а його набір даних із 1,400 випадків може бути занадто обмеженим для ширших висновків.

Мабуть, найцікавішим аспектом архітектури, висунутим у документі, є її потенціал для включення нових типів контролю. Автори стверджують:

«У цій роботі ми досліджуємо лише умови керування камерою, ідентифікатори та інформацію про глибину. Ми не досліджували далі інші умови та модальності, такі як аудіо, мовлення, хмара точок, рамки обмеження об'єктів, оптичний потік тощо. Хоча FullDiT може безперешкодно інтегрувати інші модальності з мінімальною модифікацією архітектури, як швидко та економічно ефективно адаптувати існуючі моделі до нових умов та модальностей, все ще залишається важливим питанням, яке потребує подальшого дослідження».

Хоча дослідники представляють FullDiT як крок вперед у створенні багатозадачного відео, слід враховувати, що ця нова робота базується на існуючих архітектурах, а не вводить принципово нову парадигму.

Тим не менш, FullDiT наразі стоїть окремо (наскільки мені відомо) як модель відеоплатформи з «жорстко запрограмованими» можливостями типу ControlNet – і приємно бачити, що запропонована архітектура також може враховувати пізніші інновації.

Натисніть, щоб відтворити. Приклади керованих користувачем рухів камери з сайту проекту.

Команда новий папір має титул FullDiT: багатозадачна генеративна базова модель відео з повною увагою, і походить від дев’яти дослідників з Kuaishou Technology і Китайського університету Гонконгу. Сторінка проекту є тут і нові контрольні дані в Hugging Face.

Метод

Автори стверджують, що уніфікований механізм концентрації уваги FullDiT забезпечує ефективніше крос-модальне навчання репрезентації, фіксуючи як просторові, так і часові зв’язки в різних умовах:

Згідно з новим документом, FullDiT інтегрує кілька вхідних умов через повну самоконтроль, перетворюючи їх у єдину послідовність. Навпаки, моделі на основі адаптера (крайня зліва вгорі) використовують окремі модулі для кожного входу, що призводить до надмірності, конфліктів і нижчої продуктивності.

На відміну від налаштувань на основі адаптера, які обробляють кожен вхідний потік окремо, ця структура спільної уваги дозволяє уникнути конфліктів розгалужень і зменшити витрати параметрів. Вони також стверджують, що архітектура може масштабуватися до нових типів введення без серйозного перепроектування – і що схема моделі демонструє ознаки узагальнення до комбінацій умов, яких не бачили під час навчання, наприклад, зв’язування руху камери з ідентичністю персонажа.

Натисніть, щоб відтворити. Приклади генерації ідентичності з сайту проекту.

В архітектурі FullDiT усі вхідні дані, такі як текст, рух камери, ідентичність і глибина, спочатку перетворюються в уніфікований формат маркерів. Потім ці маркери об’єднуються в одну довгу послідовність, яка обробляється через стек трансформатор шарів, використовуючи повну самоувагу. Цей підхід відповідає попереднім роботам, таким як План Open-Sora та Фільм Gen.

Ця конструкція дозволяє моделі спільно вивчати часові та просторові зв’язки в усіх умовах. Кожен трансформаторний блок працює по всій послідовності, забезпечуючи динамічну взаємодію між модальностями, не покладаючись на окремі модулі для кожного входу – і, як ми зазначали, архітектура розроблена таким чином, щоб бути розширюваною, що значно полегшує включення додаткових сигналів керування в майбутньому без серйозних структурних змін.

Сила трьох

FullDiT перетворює кожен керуючий сигнал у стандартизований формат маркера, щоб усі умови могли оброблятися разом в єдиній системі уваги. Для руху камери модель кодує послідовність зовнішніх параметрів, таких як положення та орієнтація, для кожного кадру. Ці параметри мають мітку часу та проектуються у вектори вбудовування, які відображають часову природу сигналу.

Інформацію про ідентифікацію обробляють по-іншому, оскільки вона за своєю суттю є просторовою, а не часовою. Модель використовує ідентифікаційні карти, які вказують, які символи присутні в яких частинах кожного кадру. Ці карти поділяються на патчі, з кожним патчем, спроектованим на вбудовування який фіксує ознаки просторової ідентичності, дозволяючи моделі пов’язувати конкретні області кадру з конкретними об’єктами.

Глибина — це просторово-часовий сигнал, і модель обробляє його, розділяючи відео глибини на 3D-патчі, які охоплюють простір і час. Потім ці патчі вбудовуються таким чином, що зберігає їх структуру між кадрами.

Після вбудовування всі ці маркери умов (камера, ідентичність і глибина) об’єднуються в одну довгу послідовність, що дозволяє FullDiT обробляти їх разом, використовуючи повний самоувага. Це спільне представлення дає змогу моделі вивчати взаємодії різних модальностей і в часі, не покладаючись на ізольовані потоки обробки.

Дані та тести

Підхід FullDiT до навчання спирався на вибірково анотовані набори даних, адаптовані до кожного типу обумовленості, а не вимагав одночасної присутності всіх умов.

Для текстових умов ініціатива дотримується підходу структурованих субтитрів, описаного в MiraData Проект.

Конвеєр колекції відео та анотацій із проекту MiraData. Джерело: https://arxiv.org/pdf/2407.06358

Для руху камери RealEstate10K набір даних був основним джерелом даних завдяки високоякісним анотаціям наземних параметрів камери.

Однак автори помітили, що навчання виключно на наборах даних статичних сцен, таких як RealEstate10K, як правило, зменшувало динамічні рухи об’єктів і людей у створених відео. Щоб протидіяти цьому, вони провели додаткове тонке налаштування за допомогою внутрішніх наборів даних, які включали більш динамічні рухи камери.

Ідентифікаційні анотації були створені за допомогою конвеєра, розробленого для ConceptMaster проект, який дозволив ефективно фільтрувати та витягувати детальну ідентифікаційну інформацію.

Фреймворк ConceptMaster розроблений для вирішення проблем із розмежуванням ідентичності, зберігаючи точність концепції в налаштованих відео. Джерело: https://arxiv.org/pdf/2501.04698

Глибинні анотації були отримані з Панда-70М використання набору даних Глибина будь-що.

Оптимізація за допомогою впорядкування даних

Автори також запровадили прогресивний графік тренувань, запровадивши більш складні умови раніше під час навчання щоб гарантувати, що модель отримала надійні представлення до того, як додадуться простіші завдання. Наказ про навчання виходив з текст до кімната умови, то тотожності, і, нарешті глибина, із легшими завданнями, як правило, представленими пізніше та з меншою кількістю прикладів.

Автори підкреслюють цінність упорядкування робочого навантаження таким чином:

«Під час фази попереднього навчання ми зауважили, що складніші завдання вимагають більшого часу навчання, і їх слід вводити раніше в навчальний процес. Ці складні завдання включають складні розподіли даних, які суттєво відрізняються від вихідного відео, вимагаючи від моделі достатньої потужності для точного захоплення та представлення їх.

«І навпаки, занадто раннє введення простіших завдань може призвести до того, що модель надаватиме пріоритет їхньому навчанню, оскільки вони забезпечують більш негайний зворотний зв'язок щодо оптимізації, що перешкоджає конвергенції складніших завдань».

Ілюстрація порядку навчання даних, прийнятого дослідниками, червоний колір означає більший обсяг даних.

Після початкового попереднього навчання на завершальному етапі тонкого налаштування модель ще більше вдосконалювалася для покращення якості зображення та динаміки руху. Після цього навчання відбувалося за стандартною структурою дифузії*: шум, доданий до латентів відео, і модель навчитися передбачати і знімати його, використовуючи вбудовані маркери умов як керівництво.

Щоб ефективно оцінити FullDiT і забезпечити чесне порівняння з існуючими методами, а також за відсутності будь-якого іншого відповідного порівняльного тесту, автори представили FullBench, підібраний набір тестів, що складається з 1,400 окремих тестів.

Екземпляр дослідника даних для нового тесту FullBench. Джерело: https://huggingface.co/datasets/KwaiVGI/FullBench

Кожна точка даних надала базові анотації істинності для різних сигналів кондиціонування, в тому числі рух камери, особистість та глибина.

Метрика

Автори оцінили FullDiT за допомогою десяти показників, що охоплюють п’ять основних аспектів продуктивності: вирівнювання тексту, керування камерою, схожість ідентичності, точність глибини та загальну якість відео.

Вирівнювання тексту було виміряно за допомогою Подібність CLIP, тоді як контроль камери оцінювався через помилка обертання (RotErr), помилка перекладу (TransErr), А також послідовність руху камери (CamMC), слідуючи підходу CamI2V (в CameraCtrl проект).

Подібність ідентичності оцінювали за допомогою ДІНО-І та CLIP-I, а точність контролю глибини була кількісно визначена за допомогою Середня абсолютна помилка (MAE).

Якість відео оцінювалася за трьома показниками від MiraData: подібність CLIP на рівні кадру для плавності; відстань руху на основі оптичного потоку для динаміки; і LAION-Естетичні оцінки для візуальної привабливості.

Навчання

Автори навчили FullDiT за допомогою внутрішньої (нерозкритої) моделі дифузії тексту у відео, яка містить приблизно один мільярд параметрів. Вони навмисно вибрали скромний розмір параметра, щоб підтримувати справедливість у порівнянні з попередніми методами та забезпечити відтворюваність.

Оскільки навчальні відео відрізнялися довжиною та роздільною здатністю, автори стандартизували кожне партія шляхом зміни розміру та доповнення відео до загальної роздільної здатності, вибірки 77 кадрів на послідовність, використання прикладеної уваги та маски втрати оптимізувати ефективність навчання.

Команда Адам оптимізатор використовувався на a рівень навчання 1 × 10-5 у кластері з 64 графічних процесорів NVIDIA H800 із загальною сумою 5,120 ГБ відеопам’яті (зверніть увагу, що в спільнотах ентузіастів синтезу, 24GB на RTX 3090 все ще вважається стандартом розкоші).

Модель було навчено приблизно за 32,000 20 кроків, включаючи до трьох ідентифікаторів на відео, а також 21 кадрів умов камери та 77 кадр умов глибини, обидва рівномірно відібрані із загальних XNUMX кадрів.

Для висновку модель генерувала відео з роздільною здатністю 384 × 672 пікселів (приблизно п’ять секунд при 15 кадрах в секунду) з 50 кроками розповсюдження та п’ятиричною шкалою без класифікаторів.

Попередні методи

Для оцінки камери на відео автори порівняли FullDiT з MotionCtrl, CameraCtrl і CamI2V, причому всі моделі навчені за допомогою набору даних RealEstate10k для забезпечення послідовності та справедливості.

У генерації з умовою ідентичності, оскільки не було доступних порівнянних моделей мультиідентичності з відкритим вихідним кодом, модель порівняли з моделлю ConceptMaster з 1B-параметром, використовуючи ті самі навчальні дані та архітектуру.

Для завдань від глибини до відео порівняння проводилися з Ctrl-адаптер та ControlVideo.

Кількісні результати для однозадачної генерації відео. FullDiT порівнювали з MotionCtrl, CameraCtrl і CamI2V для генерації камери до відео; ConceptMaster (версія параметрів 1B) для ідентичності до відео; і Ctrl-Adapter і ControlVideo для глибини відео. Усі моделі були оцінені з використанням параметрів за замовчуванням. Для узгодженості 16 кадрів були рівномірно відібрані з кожного методу, що відповідає вихідній довжині попередніх моделей.

Результати показують, що FullDiT, незважаючи на одночасну обробку кількох сигналів кондиціонування, досяг найсучаснішої продуктивності в метриках, пов’язаних із керуванням текстом, рухом камери, ідентифікацією та глибиною.

За загальними показниками якості система загалом перевершила інші методи, хоча її плавність була дещо нижчою, ніж у ConceptMaster. Ось коментарі авторів:

«Гладкість FullDiT трохи нижча, ніж у ConceptMaster, оскільки обчислення плавності базується на подібності CLIP між сусідніми кадрами. Оскільки FullDiT демонструє значно більшу динаміку порівняно з ConceptMaster, на показник плавності впливають великі варіації між сусідніми кадрами.

«Щодо естетичної оцінки, оскільки модель оцінювання надає перевагу зображенням у стилі живопису, а ControlVideo зазвичай генерує відео в цьому стилі, вона отримує високий бал за естетику».

Щодо якісного порівняння, можливо, було б краще звернутися до зразків відео на сайті проекту FullDiT, оскільки PDF-приклади неминуче статичні (а також занадто великі, щоб повністю відтворити тут).

Перший розділ якісних результатів у PDF. Будь ласка, зверніться до вихідної статті, щоб отримати додаткові приклади, які надто великі, щоб їх тут відтворити.

Автори коментують:

«FullDiT демонструє чудове збереження ідентичності та створює відео з кращою динамікою та візуальною якістю порівняно з [ConceptMaster]. Оскільки ConceptMaster і FullDiT навчаються на одній основі, це підкреслює ефективність введення умов із повною увагою.

«…[Інші] результати демонструють кращу керованість та якість генерації FullDiT порівняно з існуючими методами глибини-відео та камери-відео».

Розділ із прикладами виводу FullDiT з кількома сигналами у форматі PDF. Додаткові приклади дивіться у вихідному документі та на сайті проекту.

Висновок

Незважаючи на те, що FullDiT є захоплюючим кроком до більш повнофункціональної моделі базової відеосистеми, варто задатися питанням, чи попит на інструменти типу ControlNet колись виправдає впровадження таких функцій у великих масштабах, принаймні для проектів FOSS, яким буде важко отримати необхідну величезну потужність обробки GPU без комерційної підтримки.

Основна проблема полягає в тому, що використання таких систем, як Depth і Pose, зазвичай вимагає нетривіального знайомства з відносно складними інтерфейсами користувача, такими як ComfyUI. Тому здається, що така функціональна модель FOSS, швидше за все, буде розроблена кадрами менших компаній VFX, яким бракує грошей (або бажання, враховуючи, що такі системи швидко застарівають через оновлення моделі), щоб курувати та навчати таку модель за зачиненими дверима.

З іншого боку, системи «оренди штучного інтелекту» на основі API можуть бути добре мотивовані для розробки простіших та зручніших методів інтерпретації моделей, на яких безпосередньо навчалися допоміжні системи керування.

Натисніть, щоб відтворити. Елементи керування «Глибина+текст», накладені на створення відео за допомогою FullDiT.

* Автори не вказують жодної відомої базової моделі (наприклад, SDXL тощо)

Вперше опубліковано в четвер, 27 березня 2025 р