ปัญญาประดิษฐ์

AI ต่อเนื่องหลายรูปแบบพัฒนาขึ้นเมื่อ ChatGPT ได้รับการมองเห็นด้วย GPT-4V (ision)

ด้วยความพยายามอย่างต่อเนื่องที่จะทำให้ AI เหมือนมนุษย์มากขึ้น โมเดล GPT ของ OpenAI ได้ก้าวข้ามขีดจำกัดอย่างต่อเนื่อง GPT-4 สามารถรับข้อความแจ้งทั้งข้อความและรูปภาพได้แล้ว

ความหลากหลายใน generative AI แสดงถึงความสามารถของโมเดลในการสร้างเอาท์พุตที่หลากหลาย เช่น ข้อความ รูปภาพ หรือเสียงตามอินพุต โมเดลเหล่านี้ได้รับการฝึกอบรมเกี่ยวกับข้อมูลเฉพาะ เรียนรู้รูปแบบพื้นฐานเพื่อสร้างข้อมูลใหม่ที่คล้ายกัน ซึ่งจะทำให้แอปพลิเคชัน AI สมบูรณ์ยิ่งขึ้น

ความก้าวหน้าล่าสุดใน Multimodal AI

การก้าวกระโดดที่โดดเด่นเมื่อเร็วๆ นี้ในสาขานี้เห็นได้จากการรวม DALL-E 3 เข้ากับ ChatGPT ซึ่งเป็นการอัปเกรดครั้งสำคัญในเทคโนโลยีการแปลงข้อความเป็นรูปภาพของ OpenAI การผสมผสานนี้ช่วยให้การโต้ตอบราบรื่นยิ่งขึ้น โดยที่ ChatGPT ช่วยสร้างข้อความเตือนที่แม่นยำสำหรับ DALL-E 3 โดยเปลี่ยนความคิดของผู้ใช้ให้เป็นงานศิลปะที่สร้างสรรค์โดย AI ดังนั้น แม้ว่าผู้ใช้สามารถโต้ตอบกับ DALL-E 3 ได้โดยตรง แต่การมี ChatGPT ผสมอยู่จะทำให้กระบวนการสร้างงานศิลปะ AI ใช้งานง่ายยิ่งขึ้น

ดูข้อมูลเพิ่มเติมเกี่ยวกับ DALL-E 3 และการผสานรวมกับ ChatGPT โปรดคลิกที่นี่เพื่ออ่านรายละเอียดเพิ่มเติม. ความร่วมมือนี้ไม่เพียงแต่แสดงให้เห็นถึงความก้าวหน้าใน AI ต่อเนื่องหลายรูปแบบเท่านั้น แต่ยังทำให้การสร้างสรรค์งานศิลปะด้วย AI เป็นเรื่องง่ายสำหรับผู้ใช้อีกด้วย

ในทางกลับกัน สุขภาพของ Google ถูกนำมาใช้ เมด-ปาล์ม ม ในเดือนมิถุนายนปีนี้ เป็นโมเดลกำเนิดหลายรูปแบบที่เชี่ยวชาญในการเข้ารหัสและตีความข้อมูลชีวการแพทย์ที่หลากหลาย ความสำเร็จนี้เกิดขึ้นได้ด้วยการปรับแต่ง PaLM-E ซึ่งเป็นโมเดลภาษาอย่างละเอียด เพื่อรองรับโดเมนทางการแพทย์โดยใช้เกณฑ์มาตรฐานแบบโอเพ่นซอร์สอย่าง MultiMedBench เกณฑ์มาตรฐานนี้ประกอบด้วยตัวอย่างมากกว่า 1 ล้านตัวอย่างจากข้อมูลชีวการแพทย์ 7 ประเภท และงาน 14 งาน เช่น การตอบคำถามทางการแพทย์และการสร้างรายงานรังสีวิทยา

อุตสาหกรรมต่างๆ กำลังใช้เครื่องมือ AI ที่เป็นนวัตกรรมหลายรูปแบบเพื่อกระตุ้นการขยายธุรกิจ ปรับปรุงการดำเนินงาน และยกระดับการมีส่วนร่วมของลูกค้า ความก้าวหน้าของความสามารถด้าน AI เสียง วิดีโอ และข้อความ กำลังขับเคลื่อนการเติบโตของ AI ต่อเนื่องหลายรูปแบบ

องค์กรต่างๆ มองหาแอปพลิเคชัน AI หลากหลายรูปแบบที่สามารถยกเครื่องโมเดลและกระบวนการทางธุรกิจ เปิดช่องทางการเติบโตทั่วทั้งระบบนิเวศ AI ตั้งแต่เครื่องมือข้อมูลไปจนถึงแอปพลิเคชัน AI ที่เกิดขึ้นใหม่

หลังการเปิดตัว GPT-4 ในเดือนมีนาคม ผู้ใช้บางรายสังเกตเห็นคุณภาพการตอบสนองที่ลดลงเมื่อเวลาผ่านไป ซึ่งเป็นข้อกังวลที่สะท้อนโดยนักพัฒนาที่มีชื่อเสียงและในฟอรัมของ OpenAI ในตอนแรก OpenAI ไล่ออกในภายหลัง ศึกษา ยืนยันปัญหาแล้ว โดยเผยให้เห็นความแม่นยำของ GPT-4 ลดลงจาก 97.6% เป็น 2.4% ระหว่างเดือนมีนาคมถึงมิถุนายน ซึ่งบ่งชี้ถึงคุณภาพคำตอบที่ลดลงในการอัปเดตโมเดลในภายหลัง

ความฮือฮารอบตัว เปิด AI ของ ChatGPT กลับมาแล้ว ตอนนี้มันมาพร้อมกับคุณสมบัติการมองเห็น GPT-4Vทำให้ผู้ใช้สามารถวิเคราะห์รูปภาพ GPT-4 ที่ได้รับจากพวกเขาได้ นี่เป็นฟีเจอร์ใหม่ล่าสุดที่เปิดให้ผู้ใช้ใช้งาน

การเพิ่มการวิเคราะห์รูปภาพให้กับโมเดลภาษาขนาดใหญ่ (LLM) เช่น GPT-4 ถือเป็นก้าวสำคัญในการวิจัยและพัฒนา AI LLM ต่อเนื่องหลายรูปแบบประเภทนี้เปิดโอกาสใหม่ ๆ โดยใช้โมเดลภาษานอกเหนือจากข้อความเพื่อนำเสนออินเทอร์เฟซใหม่และแก้ไขงานประเภทใหม่ สร้างประสบการณ์ใหม่ให้กับผู้ใช้

การฝึกอบรม GPT-4V เสร็จสิ้นในปี 2022 และเปิดให้ทดลองใช้ก่อนใครในเดือนมีนาคม 2023 ฟีเจอร์ภาพใน GPT-4V ขับเคลื่อนโดยเทคโนโลยี GPT-4 กระบวนการฝึกอบรมยังคงเหมือนเดิม ในขั้นต้น แบบจำลองนี้ได้รับการฝึกฝนให้คาดเดาคำถัดไปในข้อความโดยใช้ชุดข้อมูลขนาดใหญ่ทั้งข้อความและรูปภาพจากแหล่งต่างๆ รวมถึงอินเทอร์เน็ต

ต่อมามีการปรับแต่งข้อมูลเพิ่มเติมโดยใช้วิธีการที่เรียกว่าการเรียนรู้แบบเสริมกำลังจากผลตอบรับของมนุษย์ (RLHF) เพื่อสร้างผลลัพธ์ที่มนุษย์ต้องการ

กลศาสตร์การมองเห็น GPT-4

ความสามารถด้านภาษาการมองเห็นอันน่าทึ่งของ GPT-4 แม้ว่าจะน่าประทับใจ แต่ก็มีวิธีการพื้นฐานที่ยังคงอยู่บนพื้นผิว

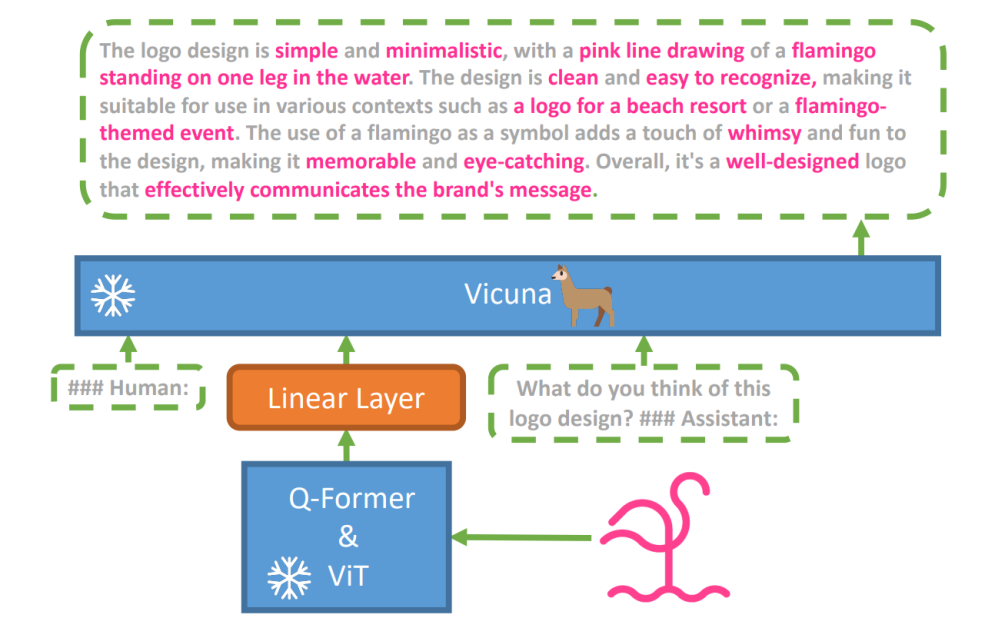

เพื่อสำรวจสมมติฐานนี้ ซึ่งเป็นโมเดลภาษาวิสัยทัศน์ใหม่ มินิจีพีที-4 ได้รับการแนะนำโดยใช้ LLM ขั้นสูงที่มีชื่อว่า วิคูนา. โมเดลนี้ใช้ตัวเข้ารหัสการมองเห็นพร้อมส่วนประกอบที่ได้รับการฝึกอบรมล่วงหน้าสำหรับการรับรู้ทางสายตา โดยปรับคุณสมบัติภาพที่เข้ารหัสให้สอดคล้องกับโมเดลภาษา Vicuna ผ่านเลเยอร์การฉายภาพเดียว สถาปัตยกรรมของ MiniGPT-4 นั้นเรียบง่ายแต่มีประสิทธิภาพ โดยมุ่งเน้นที่การปรับฟีเจอร์ภาพและภาษาให้สอดคล้องกัน เพื่อปรับปรุงความสามารถในการสนทนาด้วยภาพ

สถาปัตยกรรมของ MiniGPT-4 ประกอบด้วยตัวเข้ารหัสการมองเห็นพร้อม ViT และ Q-Former ที่ผ่านการฝึกอบรมมาแล้ว เลเยอร์การฉายภาพเชิงเส้นเดี่ยว และโมเดลภาษาขนาดใหญ่ Vicuna ขั้นสูง

แนวโน้มของแบบจำลองภาษาแบบถอยหลังอัตโนมัติในงานภาษาที่มีการมองเห็นก็เพิ่มขึ้นเช่นกัน โดยใช้ประโยชน์จากการถ่ายโอนข้ามโมดัลเพื่อแบ่งปันความรู้ระหว่างภาษาและโดเมนหลายรูปแบบ

MiniGPT-4 เชื่อมโยงโดเมนภาพและภาษาโดยการจัดข้อมูลภาพจากตัวเข้ารหัสการมองเห็นที่ได้รับการฝึกอบรมล่วงหน้ากับ LLM ขั้นสูง แบบจำลองนี้ใช้ Vicuna เป็นตัวถอดรหัสภาษาและปฏิบัติตามแนวทางการฝึกอบรมสองขั้นตอน ในขั้นต้น ได้รับการฝึกอบรมเกี่ยวกับชุดข้อมูลขนาดใหญ่ของคู่ข้อความรูปภาพเพื่อทำความเข้าใจความรู้เกี่ยวกับภาษาที่มีการมองเห็น ตามด้วยการปรับแต่งชุดข้อมูลขนาดเล็กและมีคุณภาพสูงเพื่อเพิ่มความน่าเชื่อถือและการใช้งานของรุ่น

เพื่อปรับปรุงความเป็นธรรมชาติและการใช้งานของภาษาที่สร้างขึ้นใน MiniGPT-4 นักวิจัยได้พัฒนากระบวนการจัดตำแหน่งแบบสองขั้นตอน โดยจัดการกับการขาดชุดข้อมูลการจัดตำแหน่งภาษาที่มองเห็นเพียงพอ พวกเขารวบรวมชุดข้อมูลพิเศษเพื่อจุดประสงค์นี้

ในขั้นแรก โมเดลจะสร้างคำอธิบายโดยละเอียดของรูปภาพอินพุต ปรับปรุงรายละเอียดโดยใช้ข้อความสนทนาที่สอดคล้องกับรูปแบบของโมเดลภาษา Vicuna ขั้นตอนนี้มีวัตถุประสงค์เพื่อสร้างคำอธิบายรูปภาพที่ครอบคลุมมากขึ้น

พรอมต์คำอธิบายรูปภาพเริ่มต้น:

###มนุษย์: อธิบายภาพนี้โดยละเอียด ให้รายละเอียดมากที่สุด พูดทุกอย่างที่คุณเห็น ###ผู้ช่วย:

สำหรับการประมวลผลข้อมูลภายหลัง ความคลาดเคลื่อนหรือข้อผิดพลาดในคำอธิบายที่สร้างขึ้นได้รับการแก้ไขโดยใช้ ChatGPT ตามด้วยการตรวจสอบด้วยตนเองเพื่อให้แน่ใจว่ามีคุณภาพสูง

พร้อมท์การปรับแต่งแบบละเอียดขั้นที่สอง:

###มนุษย์: ###ผู้ช่วย:

การสำรวจนี้จะเปิดหน้าต่างสู่การทำความเข้าใจกลไกของ AI ที่สร้างหลายรูปแบบ เช่น GPT-4 ซึ่งให้ความกระจ่างว่าวิธีการมองเห็นและภาษาสามารถบูรณาการอย่างมีประสิทธิภาพเพื่อสร้างผลลัพธ์ที่สอดคล้องและสมบูรณ์ตามบริบทได้อย่างไร

สำรวจวิสัยทัศน์ GPT-4

การกำหนดที่มาของภาพด้วย ChatGPT

GPT-4 Vision ช่วยเพิ่มความสามารถของ ChatGPT ในการวิเคราะห์ภาพและระบุแหล่งที่มาทางภูมิศาสตร์ ฟีเจอร์นี้เปลี่ยนการโต้ตอบของผู้ใช้จากเพียงข้อความไปเป็นการผสมผสานระหว่างข้อความและภาพ กลายเป็นเครื่องมือที่มีประโยชน์สำหรับผู้ที่อยากรู้เกี่ยวกับสถานที่ต่างๆ ผ่านข้อมูลรูปภาพ

แนวคิดทางคณิตศาสตร์ที่ซับซ้อน

GPT-4 Vision เป็นเลิศในการเจาะลึกแนวคิดทางคณิตศาสตร์ที่ซับซ้อนโดยการวิเคราะห์นิพจน์แบบกราฟิกหรือลายมือ คุณลักษณะนี้ทำหน้าที่เป็นเครื่องมือที่มีประโยชน์สำหรับผู้ที่ต้องการแก้ปัญหาทางคณิตศาสตร์ที่ซับซ้อน ทำให้ GPT-4 Vision เป็นตัวช่วยที่โดดเด่นในด้านการศึกษาและวิชาการ

การแปลงอินพุตที่เขียนด้วยลายมือเป็นรหัส LaTeX

ความสามารถที่โดดเด่นอย่างหนึ่งของ GPT-4V คือความสามารถในการแปลอินพุตที่เขียนด้วยลายมือเป็นโค้ด LaTeX คุณลักษณะนี้เป็นประโยชน์สำหรับนักวิจัย นักวิชาการ และนักศึกษาที่มักจะต้องแปลงนิพจน์ทางคณิตศาสตร์ที่เขียนด้วยลายมือหรือข้อมูลทางเทคนิคอื่นๆ ให้อยู่ในรูปแบบดิจิทัล การเปลี่ยนแปลงจากการเขียนด้วยลายมือเป็น LaTeX ช่วยขยายขอบเขตของการแปลงเอกสารเป็นดิจิทัล และทำให้กระบวนการเขียนทางเทคนิคง่ายขึ้น

การแยกรายละเอียดตาราง

GPT-4V นำเสนอทักษะในการดึงรายละเอียดจากตารางและตอบคำถามที่เกี่ยวข้อง ซึ่งเป็นทรัพย์สินสำคัญในการวิเคราะห์ข้อมูล ผู้ใช้สามารถใช้ GPT-4V เพื่อกรองตาราง รวบรวมข้อมูลเชิงลึกที่สำคัญ และแก้ไขปัญหาที่ขับเคลื่อนด้วยข้อมูล ทำให้เป็นเครื่องมือที่มีประสิทธิภาพสำหรับนักวิเคราะห์ข้อมูลและผู้เชี่ยวชาญอื่นๆ

การเข้าใจการชี้ภาพ

ความสามารถพิเศษของ GPT-4V ในการเข้าใจการชี้ด้วยภาพช่วยเพิ่มมิติใหม่ให้กับการโต้ตอบของผู้ใช้ ด้วยการทำความเข้าใจสัญญาณภาพ GPT-4V สามารถตอบสนองต่อคำถามด้วยความเข้าใจบริบทที่สูงขึ้น

การสร้างเว็บไซต์จำลองอย่างง่ายโดยใช้ภาพวาด

แรงบันดาลใจจากสิ่งนี้ tweetฉันพยายามสร้างแบบจำลองสำหรับเว็บไซต์ unite.ai

แม้ว่าผลลัพธ์จะไม่ตรงกับวิสัยทัศน์เริ่มแรกของฉัน แต่นี่คือผลลัพธ์ที่ฉันได้รับ

ข้อจำกัดและข้อบกพร่องของ GPT-4V(ision)

เพื่อวิเคราะห์ GPT-4V ทีม Open AI ได้ทำการประเมินเชิงคุณภาพและเชิงปริมาณ การทดสอบเชิงคุณภาพประกอบด้วยการทดสอบภายในและการตรวจสอบจากผู้เชี่ยวชาญภายนอก ในขณะที่การทดสอบเชิงปริมาณจะวัดการปฏิเสธโมเดลและความแม่นยำในสถานการณ์ต่างๆ เช่น การระบุเนื้อหาที่เป็นอันตราย การรับรู้ทางประชากรศาสตร์ ข้อกังวลด้านความเป็นส่วนตัว ตำแหน่งทางภูมิศาสตร์ ความปลอดภัยทางไซเบอร์ และการเจลเบรกหลายรูปแบบ

โมเดลก็ยังไม่สมบูรณ์แบบ

พื้นที่ กระดาษ ไฮไลต์ข้อจำกัดของ GPT-4V เช่น การอนุมานที่ไม่ถูกต้อง และข้อความหรืออักขระที่หายไปในรูปภาพ มันอาจทำให้เกิดภาพหลอนหรือประดิษฐ์ข้อเท็จจริง โดยเฉพาะอย่างยิ่ง มันไม่เหมาะสำหรับการระบุสารอันตรายในภาพซึ่งมักจะระบุสารเหล่านั้นอย่างไม่ถูกต้อง

ในภาพทางการแพทย์ GPT-4V สามารถให้การตอบสนองที่ไม่สอดคล้องกันและขาดความตระหนักในหลักปฏิบัติมาตรฐาน นำไปสู่การวินิจฉัยผิดพลาดได้

ประสิทธิภาพที่ไม่น่าเชื่อถือเพื่อวัตถุประสงค์ทางการแพทย์ (แหล่ง)

นอกจากนี้ยังไม่เข้าใจความแตกต่างของสัญลักษณ์แสดงความเกลียดชังบางอย่าง และอาจสร้างเนื้อหาที่ไม่เหมาะสมตามข้อมูลที่ป้อนด้วยภาพ OpenAI ไม่แนะนำให้ใช้ GPT-4V สำหรับการตีความเชิงวิพากษ์วิจารณ์ โดยเฉพาะในบริบททางการแพทย์หรือที่มีความละเอียดอ่อน

ห่อขึ้น

สร้างโดยใช้ Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

การมาถึงของ GPT-4 Vision (GPT-4V) นำมาซึ่งความเป็นไปได้เจ๋งๆ มากมายและอุปสรรคใหม่ๆ ที่จะก้าวข้ามไป ก่อนที่จะเปิดตัว มีการใช้ความพยายามอย่างมากเพื่อให้แน่ใจว่าความเสี่ยง โดยเฉพาะอย่างยิ่งเมื่อพูดถึงรูปภาพของผู้คน จะได้รับการตรวจสอบและลดอย่างดี เป็นเรื่องน่าประทับใจที่ได้เห็นว่า GPT-4V ก้าวขึ้นมาได้อย่างไร โดยแสดงให้เห็นโอกาสมากมายในด้านที่ยุ่งยาก เช่น การแพทย์และวิทยาศาสตร์

ตอนนี้มีคำถามสำคัญอยู่บนโต๊ะ ตัวอย่างเช่น โมเดลเหล่านี้ควรสามารถระบุบุคคลที่มีชื่อเสียงจากภาพถ่ายได้หรือไม่ พวกเขาควรเดาเพศ เชื้อชาติ หรือความรู้สึกจากรูปภาพหรือไม่? และควรมีการปรับแต่งพิเศษเพื่อช่วยเหลือผู้พิการทางสายตาหรือไม่? คำถามเหล่านี้ทำให้เกิดหนอนบ่อนไส้เกี่ยวกับความเป็นส่วนตัว ความยุติธรรม และวิธีที่ AI ควรเข้ากับชีวิตของเรา ซึ่งเป็นสิ่งที่ทุกคนควรแสดงความคิดเห็น