ปัญญาประดิษฐ์

LoReFT: การปรับแต่งการเป็นตัวแทนสำหรับโมเดลภาษา

การปรับแต่งแบบละเอียดหรือ PeFT อย่างมีประสิทธิภาพด้วยพารามิเตอร์จะพยายามปรับโมเดลภาษาขนาดใหญ่ผ่านการอัปเดตน้ำหนักจำนวนเล็กน้อย อย่างไรก็ตาม งานตีความที่มีอยู่ส่วนใหญ่ได้แสดงให้เห็นว่าการเป็นตัวแทนเข้ารหัสข้อมูลเชิงความหมาย ซึ่งบ่งบอกว่าอาจเป็นทางเลือกที่ดีกว่าและมีประสิทธิภาพมากกว่าในการแก้ไขการเป็นตัวแทนเหล่านี้ โมเดลขนาดใหญ่ที่ได้รับการฝึกล่วงหน้ามักจะได้รับการปรับแต่งอย่างละเอียดเพื่อใช้สำหรับโดเมนหรืองานใหม่ และในระหว่างกระบวนการปรับแต่ง โมเดลพื้นฐานเดียวสามารถปรับให้เข้ากับงานได้หลากหลาย แม้ว่าจะมีข้อมูลในโดเมนเพียงเล็กน้อยเท่านั้น ถึงโมเดล อย่างไรก็ตาม กระบวนการปรับแต่งโมเดลทั้งหมดอย่างละเอียดนั้นใช้ทรัพยากรมากและมีราคาแพง โดยเฉพาะอย่างยิ่งสำหรับโมเดลภาษาที่มีจำนวนขนาดและพารามิเตอร์ที่สูงกว่าอย่างมาก

การปรับอย่างละเอียดแบบประหยัดพารามิเตอร์หรือวิธี PeFT เสนอเพื่อจัดการกับต้นทุนสูงที่เกี่ยวข้องกับการปรับแต่งโมเดลทั้งหมดโดยการอัปเดตน้ำหนักทั้งหมดที่มีอยู่เพียงเล็กน้อย ซึ่งเป็นกระบวนการที่ช่วยลดเวลาการฝึกอบรมควบคู่ไปกับการใช้หน่วยความจำ สิ่งที่สำคัญกว่านั้นคือการปรับอย่างละเอียดโดยใช้พารามิเตอร์อย่างมีประสิทธิภาพหรือวิธี PeFT ได้แสดงให้เห็นประสิทธิภาพที่คล้ายคลึงกันในการปรับแต่งอย่างละเอียดในการตั้งค่าในทางปฏิบัติหลายประการ อะแดปเตอร์ ซึ่งเป็นตระกูลทั่วไปของการปรับแต่งพารามิเตอร์แบบละเอียดหรือวิธี PeFT เรียนรู้การแก้ไขที่สามารถเพิ่มลงในชุดน้ำหนักเพิ่มเติมที่ทำงานควบคู่ไปกับโมเดลฐานแช่แข็ง โดยอะแดปเตอร์ล่าสุด เช่น LoRA จะลดจำนวนพารามิเตอร์ที่ฝึกได้ในการเรียนรู้ การอัปเดตน้ำหนักโดยใช้การประมาณระดับต่ำแทนเมทริกซ์น้ำหนักเต็มเมื่อฝึกอะแดปเตอร์

จากผลงานก่อนหน้านี้ที่สาธิตการแก้ไขแทนอาจเป็นทางเลือกที่ดีกว่าการปรับแต่งอย่างละเอียดแบบพารามิเตอร์ที่มีประสิทธิภาพหรือวิธี PeFT ในบทความนี้ เราจะพูดถึงวิธีการปรับแต่งแบบละเอียดแทนการนำเสนอหรือ ReFT ที่ทำงานบนแบบจำลองที่ค้างอยู่ และเรียนรู้เฉพาะงาน การแทรกแซงการเป็นตัวแทนที่ซ่อนอยู่ บทความนี้มีจุดมุ่งหมายเพื่อครอบคลุมกรอบงาน ReFt หรือ Representation Fine-tuning ในเชิงลึก และเราสำรวจกลไก วิธีการ สถาปัตยกรรมของกรอบงาน รวมถึงการเปรียบเทียบกับกรอบงานที่ทันสมัย มาเริ่มกันเลย

ReFT: การปรับแต่งการเป็นตัวแทนอย่างละเอียดสำหรับโมเดลภาษา

ในความพยายามที่จะนำโมเดลภาษาที่ได้รับการฝึกล่วงหน้ามาใช้กับโดเมนและงานใหม่ กรอบงานปัจจุบันจะปรับแต่งโมเดลภาษาที่ได้รับการฝึกล่วงหน้าเหล่านี้อย่างละเอียดบ่อยครั้ง เช่นเดียวกับกระบวนการปรับแต่งอย่างละเอียดที่นำไปใช้ โมเดลพื้นฐานเดียวสามารถปรับให้เข้ากับงานที่หลากหลายได้ เมื่อทำงานกับข้อมูลในโดเมนจำนวนเล็กน้อย แม้ว่ากระบวนการปรับแต่งอย่างละเอียดจะช่วยเพิ่มประสิทธิภาพโดยรวม แต่ก็เป็นกระบวนการที่มีราคาแพง โดยเฉพาะอย่างยิ่งหากโมเดลภาษามีจำนวนพารามิเตอร์ที่สูงมาก เพื่อแก้ไขปัญหานี้ และลดต้นทุนที่เกี่ยวข้อง PeFT หรือพารามิเตอร์ที่มีประสิทธิภาพ กรอบการปรับแต่งอย่างละเอียด อัปเดตเพียงส่วนเล็กๆ ของน้ำหนักทั้งหมด ซึ่งเป็นกระบวนการที่ไม่เพียงแต่ลดเวลาการฝึกเท่านั้น แต่ยังลดการใช้หน่วยความจำอีกด้วย ช่วยให้เฟรมเวิร์ก PeFT บรรลุประสิทธิภาพที่คล้ายคลึงกันเมื่อเปรียบเทียบกับแนวทางการปรับแต่งเต็มรูปแบบในสถานการณ์จริง อะแดปเตอร์ ซึ่งเป็นกลุ่ม PeFT ทั่วไป ทำงานโดยการเรียนรู้การแก้ไขที่สามารถเพิ่มลงในชุดน้ำหนักเพิ่มเติมได้ พร้อมด้วยชุดย่อยของน้ำหนักที่ทำงานพร้อมกันกับโมเดลพื้นฐานที่มีน้ำหนักคงที่ เฟรมเวิร์กอะแดปเตอร์ล่าสุดเช่น LoRA และ QLoRA ได้แสดงให้เห็นว่าเป็นไปได้ที่จะฝึกอะแดปเตอร์ที่มีความแม่นยำเต็มรูปแบบนอกเหนือจากโมเดลที่มีความแม่นยำลดลง โดยไม่ส่งผลกระทบต่อประสิทธิภาพ อะแดปเตอร์มักจะมีประสิทธิภาพและประสิทธิผลมากกว่าเมื่อเปรียบเทียบกับวิธีอื่นที่แนะนำส่วนประกอบรุ่นใหม่

จุดเด่นที่สำคัญของกรอบงานการปรับพารามิเตอร์ที่มีประสิทธิภาพแบบละเอียดที่ทันสมัยในปัจจุบันก็คือ แทนที่จะแก้ไขการแสดง แต่จะปรับเปลี่ยนน้ำหนัก อย่างไรก็ตาม กรอบงานที่เกี่ยวข้องกับความสามารถในการตีความได้แสดงให้เห็นว่าการเป็นตัวแทนเข้ารหัสข้อมูลความหมายที่หลากหลาย ซึ่งบ่งชี้ว่าการแก้ไขการเป็นตัวแทนอาจเป็นแนวทางที่ดีกว่าและมีประสิทธิภาพมากกว่าเมื่อเปรียบเทียบกับการอัปเดตน้ำหนัก สมมติฐานของการแก้ไขการเป็นตัวแทนเป็นแนวทางที่ดีกว่าคือสิ่งที่ก่อให้เกิดรากฐานของ ReFT หรือ Representation Fine-tuning framework ที่ฝึกการแทรกแซงแทนการปรับน้ำหนักแบบจำลอง ทำให้แบบจำลองสามารถจัดการส่วนเล็กๆ ของการเป็นตัวแทนทั้งหมดเพื่อพยายามควบคุมพฤติกรรมของแบบจำลอง เพื่อแก้ไขงานปลายน้ำระหว่างการอนุมาน วิธีการปรับแต่ง ReFT หรือ Representation เป็นการแทนที่แบบดรอปอินสำหรับ PeFT ตามน้ำหนักหรือเฟรมเวิร์กการปรับแต่งอย่างละเอียดที่ประหยัดด้วยพารามิเตอร์ แนวทาง ReFT ได้รับแรงบันดาลใจจากโมเดลล่าสุดที่ทำงานด้วยการตีความโมเดลขนาดใหญ่ ซึ่งแทรกแซงการเป็นตัวแทนเพื่อค้นหากลไกเชิงสาเหตุที่น่าเชื่อถือ และควบคุมพฤติกรรมของโมเดลในระหว่างการอนุมาน ดังนั้นจึงสามารถมองเห็นได้ว่าเป็นลักษณะทั่วไปของโมเดลการแก้ไขการเป็นตัวแทน การสร้างจากที่เดียวกัน LoReFT หรือ Low-Rank Subspace ReFT เป็นอินสแตนซ์ที่แข็งแกร่งและมีประสิทธิภาพของ ReFT และเป็นการกำหนดพารามิเตอร์ของ ReFT ที่แทรกแซงการแสดงที่ซ่อนอยู่ในพื้นที่เชิงเส้นที่ขยายโดยเมทริกซ์การฉายภาพระดับต่ำ และสร้างโดยตรงบน DAS หรือกรอบงานการค้นหาการจัดตำแหน่งแบบกระจาย

ตรงกันข้ามกับการปรับแต่งแบบละเอียดทั้งหมด โดยที่เฟรมเวิร์กการปรับแต่งแบบละเอียดที่มีประสิทธิภาพ PeFT หรือพารามิเตอร์จะฝึกพารามิเตอร์เพียงส่วนเล็กๆ ของโมเดล และจัดการเพื่อปรับโมเดลให้เข้ากับงานดาวน์สตรีม เฟรมเวิร์กการปรับค่าพารามิเตอร์ที่มีประสิทธิภาพสามารถแบ่งได้เป็นสามประเภทหลัก:

- วิธีการที่ใช้อะแดปเตอร์: วิธีการที่ใช้อะแดปเตอร์จะฝึกโมดูลเพิ่มเติม เช่น เลเยอร์ที่เชื่อมต่ออย่างสมบูรณ์ ที่ด้านบนของโมเดลที่ได้รับการฝึกล่วงหน้าด้วยตุ้มน้ำหนักแบบแช่แข็ง อะแดปเตอร์ซีรีส์จะแทรกส่วนประกอบระหว่าง Perceptron หลายชั้นหรือ MLP และ LM หรือเลเยอร์ความสนใจของโมเดลขนาดใหญ่ ในขณะที่อะแดปเตอร์แบบขนานจะเพิ่มโมดูลควบคู่ไปกับส่วนประกอบที่มีอยู่ เนื่องจากอะแดปเตอร์เพิ่มส่วนประกอบใหม่ที่ไม่สามารถพับเข้ากับตุ้มน้ำหนักโมเดลที่มีอยู่ได้อย่างง่ายดาย จึงทำให้เกิดภาระเพิ่มเติมในระหว่างการอนุมาน

- โลรา: LoRA พร้อมด้วยตัวแปรล่าสุดจะประมาณน้ำหนักบวกโดยประมาณระหว่างการฝึกโดยใช้เมทริกซ์ระดับต่ำ และพวกมันไม่ต้องการค่าใช้จ่ายเพิ่มเติมในระหว่างการอนุมาน เนื่องจากสามารถรวมการอัปเดตน้ำหนักเข้ากับแบบจำลองได้ และนี่คือเหตุผลที่ว่าทำไมพวกมันจึงถูกพิจารณาว่าเป็นปัจจุบัน เฟรมเวิร์ก PeFT ที่แข็งแกร่งที่สุด

- วิธีการตามพร้อมท์: วิธีการตามพรอมต์จะเพิ่มโทเค็นแบบอ่อนที่เริ่มต้นแบบสุ่มในอินพุต และฝึกการฝังในขณะที่ยังคงรักษาน้ำหนักของโมเดลภาษาไว้ ประสิทธิภาพที่นำเสนอโดยวิธีการเหล่านี้มักจะไม่เป็นที่น่าพอใจเมื่อเปรียบเทียบกับวิธี PeFT อื่นๆ และยังมีต้นทุนค่าโสหุ้ยในการอนุมานที่สำคัญอีกด้วย

แทนที่จะอัปเดตน้ำหนัก กรอบงาน ReFT จะเรียนรู้การแทรกแซงเพื่อแก้ไขส่วนเล็กๆ ของการนำเสนอทั้งหมด นอกจากนี้ งานล่าสุดเกี่ยวกับวิศวกรรมการนำเสนอและการบังคับเลี้ยวได้แสดงให้เห็นว่าการเพิ่มเวกเตอร์การบังคับเลี้ยวแบบตายตัวให้กับกระแสที่เหลืออาจอำนวยความสะดวกในการควบคุมโมเดลขนาดใหญ่ที่ได้รับการฝึกอบรมไว้ล่วงหน้าโดยไม่ต้องใช้ทรัพยากรมาก ปรับจูน- เฟรมเวิร์กอื่นๆ ได้แสดงให้เห็นว่าการแก้ไขการนำเสนอด้วยสเกลที่เรียนรู้และการดำเนินการแปลสามารถพยายามจับคู่ได้ แต่ไม่เกินประสิทธิภาพที่นำเสนอโดยอะแดปเตอร์ LoRA ในงานที่หลากหลายโดยมีพารามิเตอร์ที่เรียนรู้น้อยกว่า นอกจากนี้ ความสำเร็จของกรอบการทำงานเหล่านี้ในงานต่างๆ ได้แสดงให้เห็นว่าการนำเสนอที่นำเสนอโดยโมเดลภาษาที่ได้รับการฝึกอบรมล่วงหน้านั้นมีความหมายที่หลากหลาย แม้ว่าประสิทธิภาพของโมเดลเหล่านี้จะไม่ค่อยเหมาะสมนักก็ตาม ส่งผลให้ PeFT ยังคงดำเนินต่อไปในฐานะแนวทางที่ล้ำสมัย โดยไม่มีภาระการอนุมานเพิ่มเติม

ReFT : ระเบียบวิธีและสถาปัตยกรรม

เพื่อให้กระบวนการรักษารูปแบบเรียบง่าย กรอบงาน ReFT จะถือว่าโมเดลขนาดใหญ่ที่ใช้หม้อแปลงเป็นโมเดลเป้าหมายที่สามารถสร้างการแสดงลำดับของโทเค็นตามบริบทได้ สำหรับลำดับที่กำหนดซึ่งมีโทเค็นอินพุต n จำนวน เฟรมเวิร์ก ReFT จะฝังโทเค็นอินพุตเหล่านี้ลงในรายการการเป็นตัวแทนก่อน จากนั้นเลเยอร์ m จะคำนวณรายการการเป็นตัวแทนที่ซ่อนอยู่ตามลำดับเป็นฟังก์ชันของรายการการเป็นตัวแทนที่ซ่อนอยู่ก่อนหน้านี้ การเป็นตัวแทนที่ซ่อนอยู่แต่ละรายการนั้นเป็นเวกเตอร์ และโมเดลภาษาจะใช้การเป็นตัวแทนที่ซ่อนอยู่ขั้นสุดท้ายเพื่อสร้างการทำนาย กรอบงาน ReFT พิจารณาทั้งแบบจำลองภาษาที่ปกปิดและแบบจำลองภาษาแบบถอยหลังอัตโนมัติ ตอนนี้ ตามสมมติฐานการเป็นตัวแทนเชิงเส้น ในโครงข่ายประสาทเทียม แนวคิดต่างๆ จะถูกเข้ารหัสภายในพื้นที่ย่อยเชิงเส้นของการเป็นตัวแทน โมเดลล่าสุดพบว่าการอ้างสิทธิ์นี้เป็นจริงในโมเดลโครงข่ายประสาทเทียมที่ได้รับการฝึกภาษาธรรมชาติควบคู่ไปกับการกระจายอินพุตอื่นๆ

นอกจากนี้ ในการศึกษาความสามารถในการตีความ กรอบงานนามธรรมแบบไม่เป็นทางการใช้การแทรกแซงการแลกเปลี่ยนเพื่อสร้างบทบาทของส่วนประกอบโครงข่ายประสาทเทียมแบบไม่เป็นทางการเมื่อใช้พฤติกรรมเฉพาะ ตรรกะที่อยู่เบื้องหลังการแทรกแซงการแลกเปลี่ยนคือ ถ้าใครแก้ไขการเป็นตัวแทนในสิ่งที่มันจะเป็นสำหรับอินพุตที่ขัดแย้ง และการแทรกแซงนี้จะส่งผลต่อเอาท์พุตของแบบจำลองอย่างสม่ำเสมอในลักษณะที่การอ้างสิทธิ์ที่ทำโดยกรอบงาน ReFT เกี่ยวกับส่วนประกอบที่รับผิดชอบในการผลิต การเป็นตัวแทนนั้น องค์ประกอบจึงมีบทบาทเชิงสาเหตุในพฤติกรรม แม้ว่าจะมีวิธีการอยู่สองสามวิธี แต่การแทรกแซงการแลกเปลี่ยนแบบกระจายเป็นแนวทางที่เหมาะสมที่สุดในการทดสอบว่าแนวคิดถูกเข้ารหัสในพื้นที่ย่อยเชิงเส้นของการเป็นตัวแทนหรือไม่ ตามที่อ้างโดยสมมติฐานการแทนเชิงเส้น นอกจากนี้ ก่อนหน้านี้วิธี DAS เคยใช้เพื่อค้นหาการแสดงเชิงเส้นในแบบจำลองภาษาของคุณลักษณะเอนทิตี ความรู้สึก ลักษณะทางภาษา และการใช้เหตุผลทางคณิตศาสตร์ อย่างไรก็ตาม การทดลองหลายครั้งได้ชี้ให้เห็นว่าวิธี DAS แสดงออกได้ชัดเจน และมีความสามารถในการค้นหาพื้นที่ย่อยที่มีประสิทธิภาพเชิงสาเหตุ แม้ว่าแบบจำลองภาษาของหม้อแปลงไฟฟ้าจะถูกเตรียมใช้งานแบบสุ่ม ดังนั้น ดังนั้นจึงยังไม่ได้เรียนรู้การนำเสนอเฉพาะงานใดๆ ส่งผลให้ อภิปรายว่า DAS มีประสิทธิภาพและมีความรับผิดชอบเพียงพอสำหรับงานตีความหรือไม่

การแสดงออกที่นำเสนอโดย DAS ชี้ให้เห็นว่าแนวทางนี้อาจเป็นเครื่องมือในอุดมคติในการควบคุมพฤติกรรมของแบบจำลองภาษาควบคู่ไปกับงานในการสร้างที่ควบคุมได้และการแก้ไขอย่างมีความรับผิดชอบ ดังนั้น เพื่อปรับโมเดลภาษาสำหรับงานดาวน์สตรีม กรอบงาน ReFT จะใช้การดำเนินการแทรกแซงการแลกเปลี่ยนแบบกระจายเพื่อสร้างวิธีการใหม่ที่มีประสิทธิภาพของพารามิเตอร์ นอกจากนี้ วิธีการ ReFT ยังเป็นชุดของการแทรกแซง และกรอบการทำงานบังคับใช้ว่าสำหรับการแทรกแซงสองรายการใดๆ ที่ทำงานบนเลเยอร์เดียวกัน ตำแหน่งการแทรกแซงจะต้องแยกจากกัน โดยพารามิเตอร์ของฟังก์ชันการแทรกแซงทั้งหมดยังคงเป็นอิสระ ด้วยเหตุนี้ ReFT จึงเป็นกรอบงานทั่วไปที่ครอบคลุมการแทรกแซงในการนำเสนอที่ซ่อนอยู่ในระหว่างการส่งต่อโมเดล

ReFT: การทดลองและผลลัพธ์

เพื่อประเมินประสิทธิภาพเทียบกับเฟรมเวิร์ก PEFT ที่มีอยู่ กรอบงาน ReFT จะทำการทดลองกับเกณฑ์มาตรฐานการประมวลผลภาษาธรรมชาติที่หลากหลายสี่ชุด และครอบคลุมชุดข้อมูลมากกว่า 20 ชุด โดยมีเป้าหมายหลักเพื่อให้เห็นภาพที่สมบูรณ์ว่ากรอบงาน LoReFT ทำงานอย่างไรในสถานการณ์ที่แตกต่างกัน นอกจากนี้ เมื่อมีการนำเฟรมเวิร์ก LoReFT ไปใช้ในชีวิตจริง นักพัฒนาจำเป็นต้องตัดสินใจว่าจะเรียนรู้การแทรกแซงจำนวนเท่าใด รวมถึงตำแหน่งอินพุตและเลเยอร์ที่จะใช้แต่ละรายการ เพื่อให้งานเสร็จสมบูรณ์ กรอบงาน ReFT จะปรับแต่งไฮเปอร์พารามิเตอร์สี่ตัว

- จำนวนตำแหน่งคำนำหน้าที่จะแทรกแซง

- จำนวนตำแหน่งต่อท้ายที่จะแทรกแซง

- ชุดชั้นใดที่จะเข้าไปแทรกแซง

- ไม่ว่าจะผูกพารามิเตอร์การแทรกแซงในตำแหน่งต่างๆ ในเลเยอร์เดียวกันหรือไม่

ด้วยการทำเช่นนี้ กรอบงาน ReFT จะทำให้พื้นที่การค้นหาไฮเปอร์พารามิเตอร์ง่ายขึ้น และรับประกันเฉพาะต้นทุนการอนุมานเพิ่มเติมคงที่ซึ่งไม่ได้ปรับขนาดตามความยาวของข้อความแจ้ง

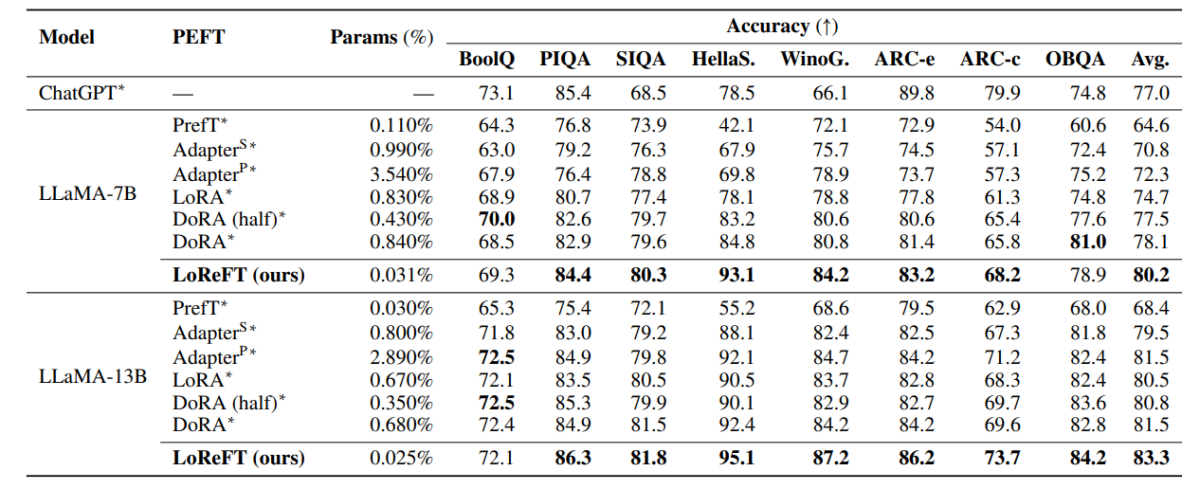

ตารางด้านบนเปรียบเทียบความแม่นยำของเฟรมเวิร์ก LLaMA-7B และ LLaMA-13B กับโมเดล PEFT ที่มีอยู่ในชุดข้อมูลการให้เหตุผลทั่วไป 8 ชุด ตามที่สังเกตได้ โมเดล LoReFT มีประสิทธิภาพเหนือกว่าแนวทาง PEFT ที่มีอยู่ด้วยระยะขอบที่เหมาะสม แม้ว่าจะมีพารามิเตอร์น้อยกว่ามาก โดยมีการรายงานประสิทธิภาพโดยเฉลี่ยของการรันสามครั้งพร้อมค่าเริ่มต้นพารามิเตอร์ที่แตกต่างกันสำหรับโมเดล LoReFT พารามิเตอร์ (%) คำนวณโดยการหารจำนวนพารามิเตอร์ที่ฝึกได้ด้วยจำนวนพารามิเตอร์รวมของโมเดลฐานขนาดใหญ่

ตารางด้านบนสรุปการเปรียบเทียบความแม่นยำของเฟรมเวิร์ก LLaMA-7B และ LLaMA-13B กับโมเดล PEFT ที่มีอยู่ในชุดข้อมูลการใช้เหตุผลทางคณิตศาสตร์ที่แตกต่างกัน 4 ชุด โดยมีเฟรมเวิร์กรายงานประสิทธิภาพโดยเฉลี่ยของการรันสามครั้งโดยมีข้อมูลสุ่มที่แตกต่างกัน ดังที่สังเกตได้ แม้ว่าจะมีพารามิเตอร์น้อยกว่ามาก (%) แต่เฟรมเวิร์ก LoReFT ก็มีประสิทธิภาพเหนือกว่าเฟรมเวิร์ก PEFT ที่มีอยู่ด้วยอัตรากำไรขั้นต้นที่มาก

ตารางด้านบนสรุปการเปรียบเทียบความแม่นยำของเฟรมเวิร์ก RoBERTa-base และ RoBERTa-large เทียบกับโมเดล PEFT ที่มีอยู่ในเกณฑ์มาตรฐาน GLUE โดยเฟรมเวิร์กจะรายงานประสิทธิภาพโดยเฉลี่ยของการรันห้าครั้งด้วยการสุ่มตัวอย่างที่แตกต่างกัน ดังที่สังเกตได้ แม้ว่าจะมีพารามิเตอร์น้อยกว่ามาก (%) แต่เฟรมเวิร์ก LoReFT ก็มีประสิทธิภาพเหนือกว่าเฟรมเวิร์ก PEFT ที่มีอยู่ด้วยอัตรากำไรขั้นต้นที่มาก

ข้อคิด

ในบทความนี้ เราได้พูดคุยเกี่ยวกับ LoReFT ซึ่งเป็นทางเลือกอันทรงพลังแทนเฟรมเวิร์ก PEFT ที่มีอยู่ ซึ่งได้รับประสิทธิภาพที่ยอดเยี่ยมจากการวัดประสิทธิภาพจากสี่โดเมนที่แตกต่างกัน ในขณะเดียวกันก็ให้ประสิทธิภาพที่สูงกว่าที่นำเสนอโดยรุ่น PEFT อันล้ำสมัยก่อนหน้านี้ถึง 50 เท่า โมเดลขนาดใหญ่ที่ได้รับการฝึกล่วงหน้ามักจะได้รับการปรับแต่งอย่างละเอียดเพื่อใช้สำหรับโดเมนหรืองานใหม่ และในระหว่างกระบวนการปรับแต่ง โมเดลพื้นฐานเดียวสามารถปรับให้เข้ากับงานได้หลากหลาย แม้ว่าจะมีข้อมูลในโดเมนเพียงเล็กน้อยเท่านั้น ถึงโมเดล อย่างไรก็ตาม กระบวนการปรับแต่งโมเดลทั้งหมดอย่างละเอียดนั้นใช้ทรัพยากรมากและมีราคาแพง โดยเฉพาะอย่างยิ่งสำหรับโมเดลภาษาที่มีจำนวนขนาดและพารามิเตอร์ที่สูงกว่าอย่างมาก การปรับอย่างละเอียดแบบประหยัดพารามิเตอร์หรือวิธี PeFT เสนอเพื่อจัดการกับต้นทุนสูงที่เกี่ยวข้องกับการปรับแต่งโมเดลทั้งหมดโดยการอัปเดตน้ำหนักทั้งหมดที่มีอยู่เพียงเล็กน้อย ซึ่งเป็นกระบวนการที่ช่วยลดเวลาการฝึกอบรมควบคู่ไปกับการใช้หน่วยความจำ โดยเฉพาะอย่างยิ่ง LoReFT สร้างประสิทธิภาพที่ล้ำสมัยใหม่ในด้านการใช้เหตุผลสามัญสำนึก การปฏิบัติตามคำสั่ง และความเข้าใจภาษาธรรมชาติเทียบกับ PEFT ที่แข็งแกร่งที่สุด