Искусственный интеллект

RigNeRF: новый метод дипфейков, использующий поля нейронного излучения

Новое исследование, разработанное в Adobe, предлагает первый жизнеспособный и эффективный метод дипфейков, основанный на Поля нейронного излучения (NeRF) — пожалуй, первое настоящее нововведение в архитектуре или подходе за пять лет с момента появления дипфейков в 2017 году.

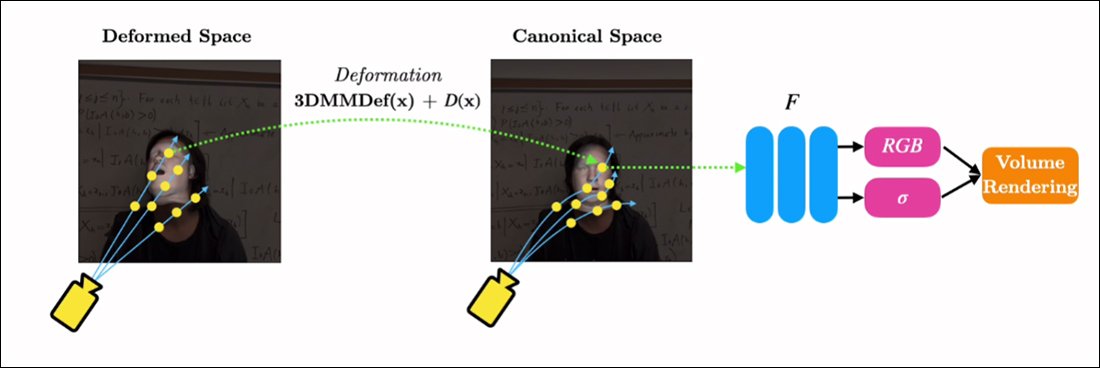

Метод под названием РигНерФ, использует 3D трансформируемые модели лица (3DMM) как промежуточный инструментальный слой между желаемым вводом (т. е. личностью, которая должна быть введена в визуализацию NeRF) и нейронным пространством, метод, который был широкое распространение в последние годы с помощью подходов к синтезу лиц генеративно-состязательной сети (GAN), ни один из которых еще не создал функциональных и полезных фреймворков для замены лиц для видео.

В отличие от традиционных дипфейковых видео, здесь абсолютно ничего из движущегося контента не является «реальным», а представляет собой исследуемое нейронное пространство, обученное на коротких видеоматериалах. Справа мы видим трёхмерную морфируемую модель лица (3DMM), выступающую в качестве интерфейса между желаемыми манипуляциями («улыбка», «взгляд влево», «взгляд вверх» и т. д.) и обычно трудно поддающимися обработке параметрами визуализации нейронного поля излучения. Высококачественную версию этого клипа, а также другие примеры, см. Проект страницу, или встроенные видео в конце этой статьи. Источник: https://shahrukhathar.github.io/2022/06/06/RigNeRF.html.

3DMM фактически представляют собой CGI-модели лиц, параметры которых могут быть адаптированы к более абстрактным системам синтеза изображений, таким как NeRF и GAN, которые иначе трудно контролировать.

То, что вы видите на изображении выше (среднее изображение, мужчина в синей рубашке), а также на изображении прямо под ним (левое изображение, мужчина в синей рубашке), — это не «реальное» видео, на которое наложен небольшой участок «поддельного» лица, а полностью синтезированная сцена, существующая исключительно как объемная нейронная визуализация, включая тело и фон:

В примере выше реальное видео справа (женщина в красном платье) используется в качестве «марионетки» для захваченной личности (мужчина в синей рубашке) слева с помощью RigNeRF, которая (по утверждению авторов) является первой системой на основе NeRF, которая добилась разделения позы и выражения, а также способна выполнять синтез новых ракурсов.

Мужская фигура слева на изображении выше была «захвачена» из 70-секундного видео, снятого на смартфон, а входные данные (включая всю информацию о сцене) впоследствии были обучены на четырех графических процессорах V4 для получения сцены.

Так как параметрические установки в стиле 3DMM также доступны как параметрические CGI-прокси всего тела (а не только лицевые риги), RigNeRF потенциально открывает возможность дипфейков всего тела, когда реальные человеческие движения, текстура и выражение передаются параметрическому слою на основе компьютерной графики, который затем переводит действие и выражение в визуализированные среды и видео NeRF. .

Что касается RigNeRF, можно ли считать его методом дипфейка в том смысле, в каком его понимают в заголовках? Или это просто очередная полуприхрамываемая работа с DeepFaceLab и другими трудоемкими автокодирующими системами дипфейка эпохи 2017 года?

Исследователи новой статьи высказывают по этому поводу однозначную позицию:

«Поскольку RigNeRF — это метод, позволяющий реанимировать лица, злоумышленники могут использовать его для создания глубоких подделок».

Новый статье называется RigNeRF: полностью управляемые нейронные 3D-портретыи принадлежит Шахрукху Атха из Университета Стоунибрук, стажеру Adobe во время разработки RigNeRF, и четырем другим авторам из Adobe Research.

Помимо дипфейков на основе автоэнкодера

Большинство вирусных дипфейков, попавших в заголовки за последние несколько лет, созданы автоэнкодер, основанные на коде, который был опубликован на быстро забаненном сабреддите r/deepfakes в 2017 году — хотя и не раньше, чем скопировано на GitHub, где он в настоящее время разветвлен более тысячи раз, не в последнюю очередь в популярные (если спорный) DeepFaceLab распространение, а также обмен лицами проект.

Помимо GAN и NeRF, фреймворки автокодировщиков также экспериментировали с 3DMM в качестве «руководства» для улучшенных фреймворков синтеза лиц. Примером этого является Проект ХифиФейс с июля 2021 года. Однако на сегодняшний день на основе этого подхода не было разработано никаких полезных или популярных инициатив.

Данные для сцен RigNeRF получаются путём съёмки коротких видеороликов на смартфон. В рамках проекта исследователи RigNeRF использовали iPhone XR или iPhone 12 для всех экспериментов. В первой половине съёмки испытуемому предлагается воспроизводить широкий спектр мимики и речи, сохраняя неподвижность головы, пока камера перемещается вокруг него.

Во второй половине захвата камера сохраняет фиксированное положение, в то время как субъект должен двигать головой, демонстрируя широкий спектр выражений. Полученные 40-70 секунд отснятого материала (около 1200-2100 кадров) представляют собой весь набор данных, который будет использоваться для обучения модели.

Сокращение сбора данных

Напротив, системы автокодировщика, такие как DeepFaceLab, требуют относительно трудоемкого сбора и обработки тысяч разнообразных фотографий, часто взятых из видео на YouTube и других каналов социальных сетей, а также из фильмов (в случае дипфейков со знаменитостями).

Полученные обученные модели автоэнкодеров часто предназначены для использования в самых разных ситуациях. Однако самые требовательные мастера дипфейка, работающие со «знаменитостями», могут обучать целые модели с нуля для одного видео, несмотря на то, что обучение может занять неделю или даже больше.

Несмотря на предостережение исследователей новой статьи, «лоскутные» и широко собранные наборы данных, лежащие в основе ИИ-порно, а также популярных «дипфейковых рекастов» на YouTube/TikTok, вряд ли дадут приемлемые и стабильные результаты в системе дипфейка, такой как RigNeRF, использующей методологию, специфичную для конкретной сцены. Учитывая ограничения на сбор данных, описанные в новой работе, это может в некоторой степени стать дополнительной защитой от случайного присвоения личности злонамеренными дипфейкерами.

Адаптация NeRF к дипфейковому видео

NeRF — это метод, основанный на фотограмметрии, в котором небольшое количество исходных изображений, сделанных с разных точек зрения, собираются в исследуемое трехмерное нейронное пространство. Этот подход стал известен в начале этого года, когда NVIDIA представила свою Мгновенный NeRF система, способная сократить чрезмерное время обучения NeRF до минут или даже секунд:

Мгновенный НРФ. Источник: https://www.youtube.com/watch?v=DJ2hcC1orc4

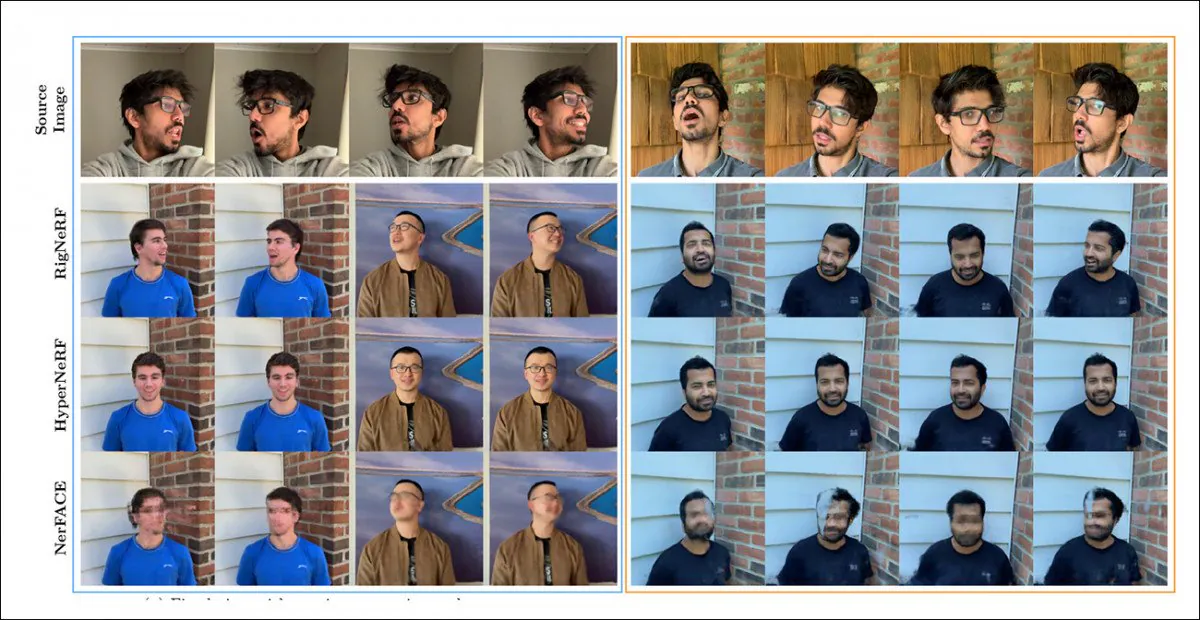

Получившаяся в результате сцена Neural Radiance Field представляет собой статичную среду, которую можно исследовать, но которая трудно редактировать. Исследователи отмечают, что две предыдущие инициативы на основе NeRF — ГиперНеРФ + Э/П и НерФЕЙС — попытались синтезировать видео лица и (очевидно, ради полноты и усердия) сравнили RigNeRF с этими двумя фреймворками в раунде тестирования:

Качественное сравнение RigNeRF, HyperNeRF и NerFACE. Смотрите связанные исходные видео и PDF для версий более высокого качества. Источник статического изображения: https://arxiv.org/pdf/2012.03065.pdf

Однако в этом случае результаты, которые говорят в пользу RigNeRF, являются довольно аномальными по двум причинам: во-первых, авторы отмечают, что «не существует работ для сравнения яблок с яблоком»; во-вторых, это потребовало ограничения возможностей RigNeRF, чтобы хотя бы частично соответствовать более ограниченной функциональности предыдущих систем.

Поскольку полученные результаты не являются постепенным улучшением по сравнению с предыдущей работой, а скорее представляют собой «прорыв» в области редактирования и полезности NeRF, мы оставим этап тестирования в стороне и вместо этого посмотрим, что RigNeRF делает иначе, чем его предшественники.

Объединенные сильные стороны

Основное ограничение NerFACE, позволяющего управлять позой и выражением лица в среде NeRF, заключается в том, что исходный материал будет снят статичной камерой. Фактически, это означает, что система не может создавать новые ракурсы, выходящие за пределы её возможностей. В результате получается система, способная создавать «движущиеся портреты», но непригодная для видео в стиле deepfake.

HyperNeRF, с другой стороны, хотя и способен генерировать новые и гиперреальные изображения, не имеет инструментов, позволяющих ему изменять позы головы или выражения лица, что опять же не приводит к появлению какого-либо конкурента для дипфейков на основе автоэнкодера.

RigNeRF способен объединить эти две изолированные функции, создав «каноническое пространство» — базовую линию по умолчанию, относительно которой могут быть введены отклонения и деформации с помощью входных данных от модуля 3DMM.

Создание «канонического пространства» (без поз и выражений), на которое могут воздействовать деформации (т. е. позы и выражения), создаваемые с помощью 3DMM.

Поскольку система 3DMM не будет точно соответствовать объекту съёмки, важно компенсировать это в процессе. RigNeRF достигает этого с помощью предварительного поля деформации, которое рассчитывается на основе Многослойный персептрон (MLP), полученный из исходных кадров.

Параметры камеры, необходимые для расчета деформаций, получаются с помощью КОЛМАП, а параметры выражения и формы для каждого кадра получаются из ТОГО, ЧТО.

Позиционирование дополнительно оптимизировано за счет примерка ориентира и параметры камеры COLMAP, а из-за ограничений вычислительных ресурсов выходной видеосигнал понижается до разрешения 256×256 для обучения (аппаратно-ограниченный процесс сжатия, который также затрудняет сцену глубокой фальсификации автокодировщика).

После этого деформационная сеть обучается на четырех V100 — грозном оборудовании, которое вряд ли будет доступно рядовым энтузиастам (однако, когда речь идет об обучении машинному обучению, часто можно пожертвовать весом ради времени и просто смириться с тем, что обучение модели займет несколько дней или даже недель).

В заключении исследователи констатируют:

«В отличие от других методов, RigNeRF, благодаря использованию модуля деформации под управлением 3DMM, способен моделировать позу головы, выражение лица и полную сцену 3D-портрета с высокой точностью, тем самым обеспечивая более качественные реконструкции с четкими деталями».

См. встроенные видеоролики ниже для получения дополнительной информации и видеоматериалов о результатах.

Впервые опубликовано 15 июня 2022 г.