Ângulo de Anderson

A programação baseada em vibrações sofre com a expansão do papel da IA.

Um novo estudo descobriu que a codificação por vibração melhora quando os humanos dão as instruções, mas piora quando a IA o faz, sendo que a melhor configuração híbrida mantém os humanos como principais responsáveis, com a IA atuando como árbitro ou juiz.

Uma nova pesquisa dos Estados Unidos examina o que acontece quando os sistemas de IA têm permissão para controlar... codificação de vibração, em vez de simplesmente executar instruções humanas, descobriu que quando Modelos de Linguagem Grandes (LLMs) assumir um papel diretivo maior, os resultados são quase sempre piores.

Embora os pesquisadores tenham usado a OpenAI GPT-5 como estrutura para seus experimentos colaborativos entre humanos e IA, eles confirmaram posteriormente que ambos os Anthropic Claude Opus 4.5 e Google Gêmeos 3 Pro estavam sujeitos à mesma curva de deterioração à medida que as responsabilidades aumentavam, afirmando que 'mesmo um envolvimento humano limitado melhora o desempenho de forma constante':

"[Os humanos] fornecem uma orientação de alto nível excepcionalmente eficaz ao longo das iterações, [enquanto] a orientação da IA muitas vezes leva ao colapso do desempenho. Além disso, descobrimos que uma alocação cuidadosa de funções, que mantém os humanos no comando da direção, enquanto delega a avaliação à IA, pode melhorar o desempenho híbrido."

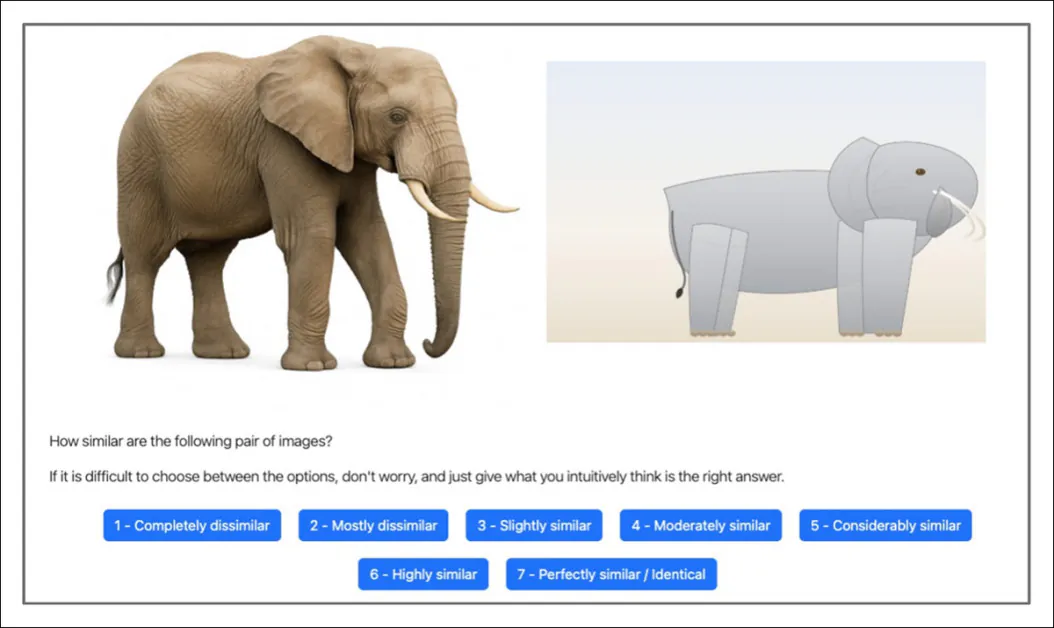

Para fornecer um teste consistente que pudesse ser avaliado igualmente por humanos e por IA, foi construída uma estrutura experimental controlada em torno de uma tarefa de codificação iterativa na qual uma imagem de referência – apresentando uma foto de um gato, cachorro, tigre, pássaro, elefante, pinguim, tubarão, zebra, girafa ou panda – tinha que ser recriada usando gráficos vetoriais escaláveis (SVG), e essa recriação foi avaliada em comparação com a fonte fotográfica da qual foi derivada:

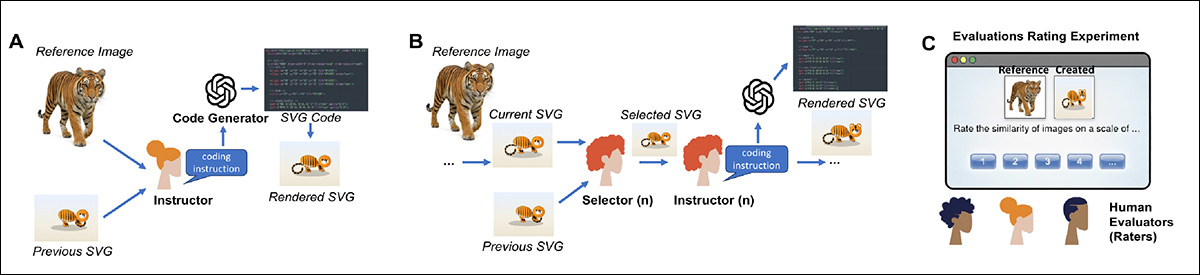

Tanto os participantes humanos quanto os participantes de IA visualizaram uma imagem fotográfica de referência ao lado de uma reconstrução SVG gerada por IA e foram solicitados a avaliar o grau de semelhança entre as duas em uma escala de sete pontos. fonte

Em cada rodada, um agente fornecia instruções de alto nível em linguagem natural para orientar um gerador de código, e outro decidia se mantinha a nova versão ou revertia para a anterior – um ciclo estruturado que espelha fluxos de trabalho colaborativos reais.

Em 16 experimentos envolvendo 604 participantes e milhares de chamadas de API, rodadas de teste totalmente conduzidas por humanos foram comparadas diretamente com rodadas totalmente conduzidas por IA, sob condições idênticas.

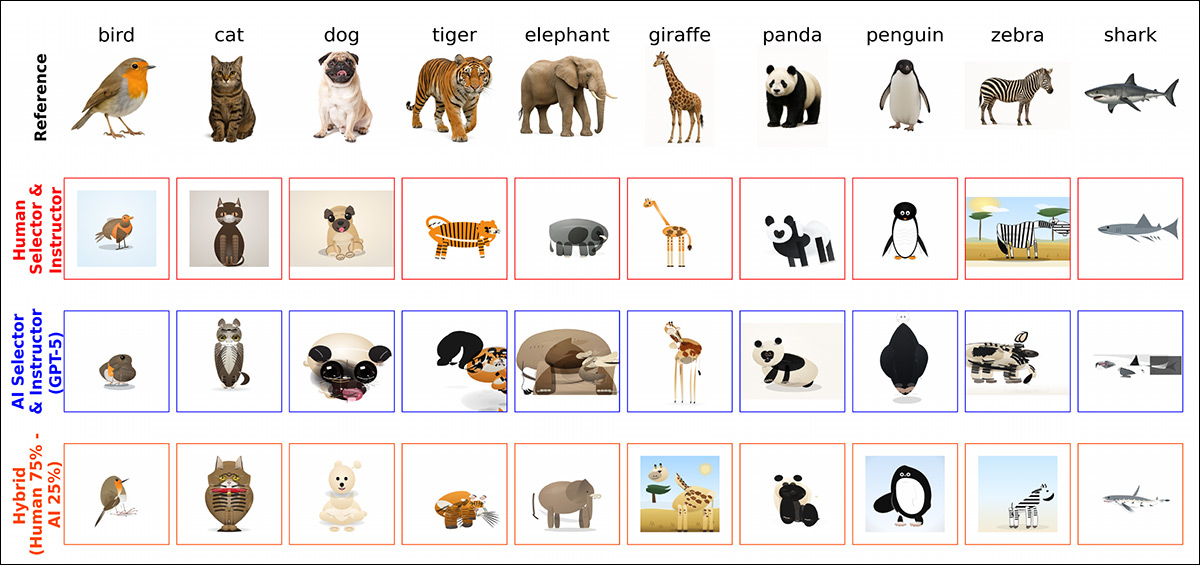

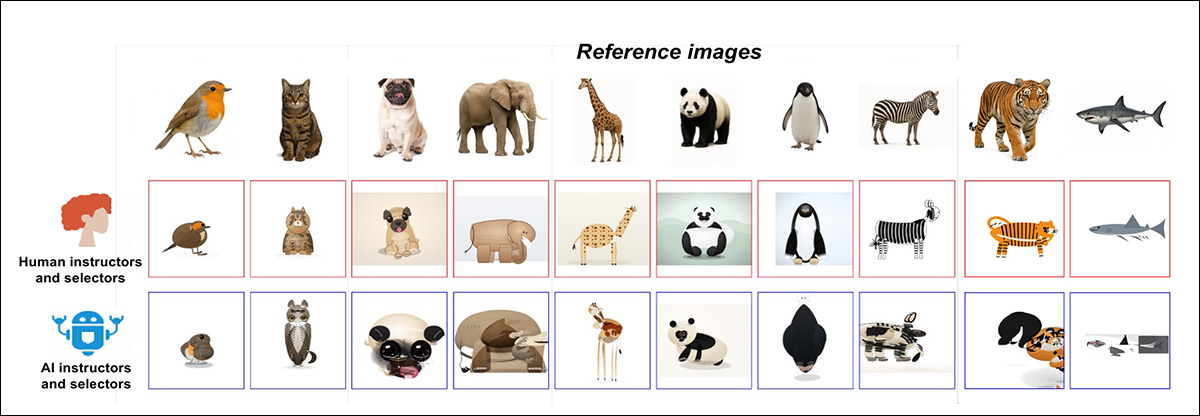

Algumas das diversas soluções alcançadas por meio de diferentes combinações de percentagens e tipos de colaboração entre humanos e IA (retiradas de uma ilustração maior no artigo original, ao qual remetemos o leitor).

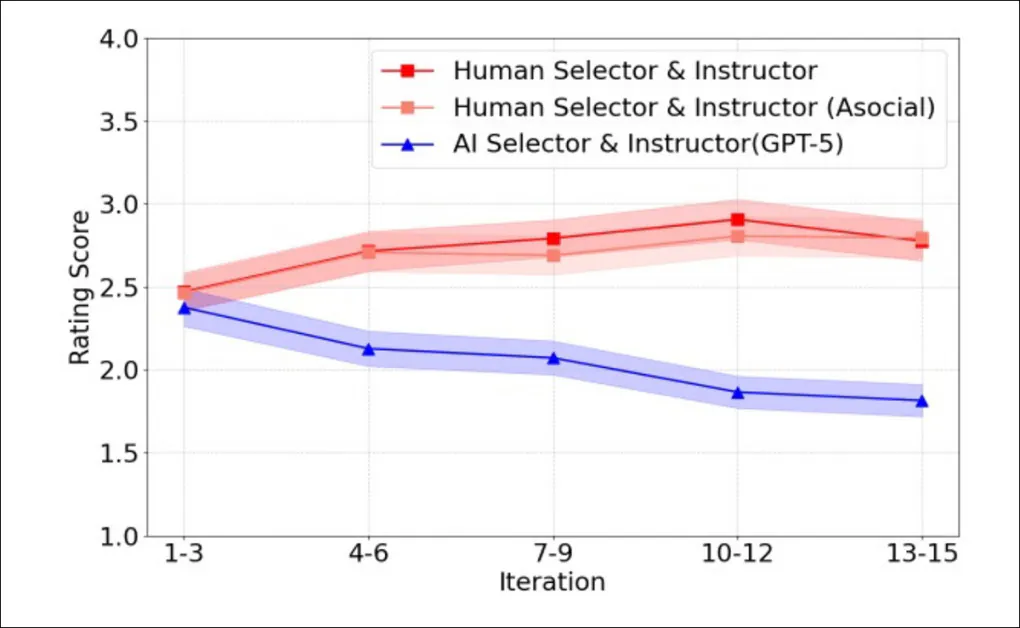

Embora humanos e IA tivessem um desempenho semelhante no início dos testes, com o tempo, suas trajetórias divergiram: quando os humanos forneciam as instruções e tomavam as decisões de seleção, as pontuações de similaridade aumentavam ao longo das iterações, com uma melhoria cumulativa constante; mas quando os sistemas de IA desempenhavam ambas as funções, o desempenho não apresentava ganhos consistentes e frequentemente declinava ao longo das rodadas – mesmo que o mesmo modelo subjacente fosse usado para a geração de código e a IA tivesse acesso às mesmas informações que os participantes humanos.

O Efeito Prolixo

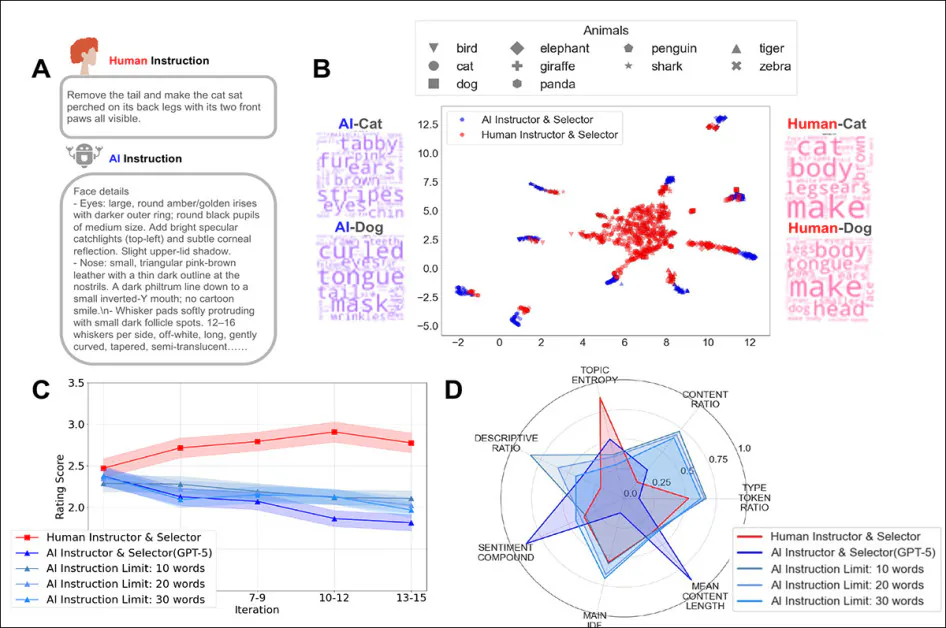

Os resultados também mostraram que as instruções humanas eram tipicamente curtas e orientadas para a ação, focando no que mudar em seguida na imagem atual; por outro lado, as instruções da IA eram muito mais longas e altamente descritivas (um fator que foi parametrizado para GPT-5), detalhando atributos visuais em vez de priorizar correções incrementais.

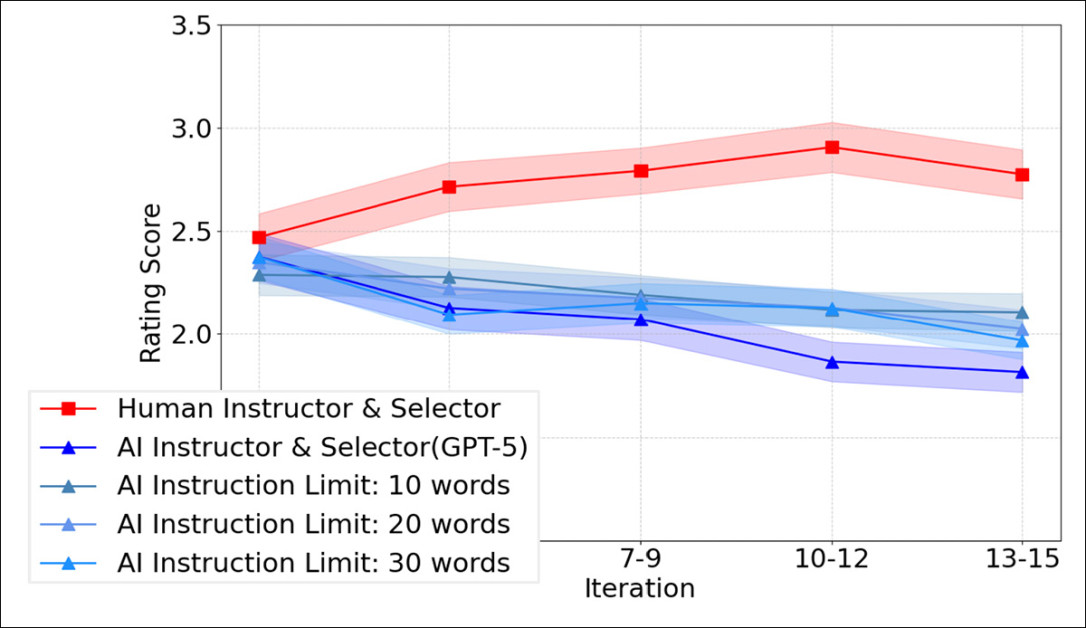

Mas, como mostra o gráfico abaixo, impor limites rígidos de palavras às instruções de IA não reverteu o padrão; mesmo quando limitadas a 10, 20 ou 30 palavras, as cadeias lideradas por IA ainda não conseguiram melhorar ao longo do tempo:

Classificações de similaridade entre iterações para rodadas conduzidas por humanos em comparação com rodadas totalmente conduzidas por IA, limitadas a instruções de 10, 20 ou 30 palavras. Evidentemente, encurtar as instruções da IA não impede o declínio iterativo de desempenho observado quando a IA direciona tanto a instrução quanto a seleção.

Experimentos híbridos tornaram o padrão mais claro, mostrando que adicionar mesmo uma pequena intervenção humana melhorava os resultados, em comparação com configurações totalmente lideradas por IA; no entanto, o desempenho geralmente diminuía à medida que a participação da orientação da IA aumentava.

Quando as funções foram separadas, a avaliação e a seleção puderam ser entregues à IA com relativamente pouca perda de qualidade; mas a substituição da instrução humana de alto nível pela orientação da IA levou a quedas notáveis no desempenho, sugerindo que o que mais importava não era quem fazia o trabalho. gerou o código, mas quem estabeleceu e manteve a direção ao longo das iterações.

Os autores concluem:

Em diversos experimentos, a codificação conduzida por humanos apresentou melhorias consistentes ao longo das iterações, enquanto a codificação conduzida por IA frequentemente falhava, apesar do acesso às mesmas informações e de capacidades de execução semelhantes.

'Isso aponta para as principais dificuldades dos sistemas de IA atuais em manter uma direção coerente de alto nível em interações repetidas, do tipo necessário para uma codificação de vibrações bem-sucedida.'

O novo papel é intitulado Por que a orientação humana é importante na codificação colaborativa de ambientes dinâmicose é fruto da colaboração de sete pesquisadores da Universidade Cornell, da Universidade Princeton, do Instituto de Tecnologia de Massachusetts e da Universidade de Nova York.

Forma

Para os experimentos, um instrutor humano analisou uma foto de referência de um animal gerada pelo GPT-5, juntamente com a tentativa mais recente de imitação em SVG. Em seguida, ele escreveu instruções em linguagem natural para orientar o gerador de código em direção a uma correspondência mais precisa.

Assim, o gerador produziria um novo SVG a cada rodada, fornecendo um ciclo iterativo para testar como o efeito da orientação se acumula ao longo do tempo. Os alvos eram dez imagens de animais geradas pelo GPT-5, abrangendo uma variedade de formas e texturas para que melhorias ou erros fossem fáceis de detectar:

Esquema do fluxo de trabalho de codificação de vibração usado no estudo. Em A), um instrutor humano visualiza uma imagem fotográfica de referência juntamente com o melhor SVG produzido até o momento e escreve instruções em linguagem natural para o gerador de código seguir ao produzir o próximo SVG; em B), um selecionador humano compara o novo SVG com o anterior e escolhe qual versão melhor corresponde à imagem de referência, antes de passar o SVG selecionado para a próxima rodada de instruções; e em C), avaliadores humanos independentes classificam o quão semelhante cada SVG gerado é à sua imagem de referência, fornecendo as pontuações usadas para avaliar o desempenho geral.

Um selecionador humano comparava cada SVG recém-gerado com o anterior e o aceitava ou rejeitava, mantendo o processo alinhado com a imagem de referência ao longo das rodadas. Nessa configuração básica, a mesma pessoa desempenhava ambas as funções.

Medir qualidadeAvaliadores humanos independentes classificaram o grau de similaridade de cada SVG gerado com sua imagem de referência. Ao longo de dezesseis experimentos, 120 pessoas produziram 4,800 avaliações. Todos os experimentos foram executados na plataforma. PsyNet framework, um portal projetado para facilitar interações estruturadas entre humanos e sistemas de IA.

O estudo recrutaria 604 falantes nativos de inglês, em testes que envolveriam 4,800 chamadas de API para geração de código e 5,327 chamadas de API para instruções. Embora o GPT-5 fosse o modelo principal utilizado, lotes comparativos menores foram feitos com o Claude Opus 4.5 e o Gemini 3 Pro, cada um processando 280 consultas.

Resultados

Foram realizadas trinta rodadas de codificação de vibrações, cada uma compreendendo quinze edições das dez imagens de referência principais. Para essas rodadas, foram selecionados 45 participantes humanos, cada um atuando como selecionador e instrutor ao longo de dez iterações, nas rodadas "conduzidas por humanos".

Em cada rodada, o mesmo participante primeiro escolhia entre o SVG atual e o anterior e, em seguida, escrevia a próxima rodada de instruções. Uma segunda versão do teste substituiu essas decisões humanas por chamadas à API do GPT-5, mantendo o restante da configuração inalterado. Em todos os casos, o instrutor e o selecionador forneciam instruções ao gerador de código em linguagem natural.

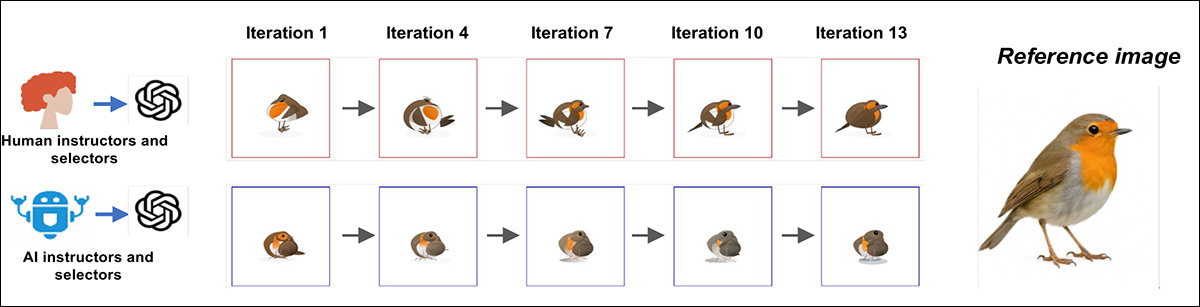

Um exemplo representativo de codificação de vibrações em múltiplas rodadas mostra como o processo diverge ao longo do tempo; quando humanos atuavam como seletores e instrutores, a saída SVG melhorava constantemente ao longo das iterações, aproximando-se da imagem de referência a cada rodada:

Exemplos de progressão para uma imagem de referência sob codificação de vibração conduzida por humanos (acima) e por IA (abaixo), mostrando melhoria constante ao longo das iterações com humanos em ambas as funções, e estagnação ou deriva quando ambas as funções são desempenhadas por IA.

Por outro lado, na versão liderada por IA, as primeiras rodadas às vezes capturavam características visuais importantes, mas as tentativas posteriores não conseguiam aproveitar esses ganhos e, em alguns casos, se afastavam do objetivo:

Resultados finais da última iteração, comparando as curvas conduzidas por humanos (linha superior) com as curvas conduzidas por IA (linha inferior), no mesmo conjunto de imagens de referência. Os resultados conduzidos por humanos se assemelham mais aos animais originais, enquanto os resultados conduzidos por IA demonstram distorções visíveis ou perda de características importantes.

Para medir quantitativamente as tendências emergentes, as imagens finais foram mostradas a avaliadores humanos independentes, que as pontuaram quanto à similaridade com as imagens de referência. Nas primeiras rodadas, as avaliações conduzidas por humanos e por IA obtiveram pontuações semelhantes; porém, na décima quinta rodada, a diferença ficou evidente, com as imagens escolhidas pelos humanos apresentando pontuações muito mais próximas das imagens de referência. Ao longo do tempo, as pontuações dos avaliadores humanos aumentaram de forma constante, com o maior ganho relativo em relação à IA atingindo 27.1%.

As pontuações médias de similaridade entre as iterações para a codificação de vibrações conduzida por humanos e por IA mostram ganhos constantes quando os humanos atuam como selecionadores e instrutores, e um declínio gradual quando ambas as funções são desempenhadas pelo GPT 5.

Para garantir que as tendências emergentes não fossem devidas ao poder coletivo de múltiplos participantes humanos simultâneos, os pesquisadores recrutaram dez pessoas adicionais para trabalharem sozinhas, cada uma realizando três rodadas individualmente – e os resultados melhoraram da mesma forma constante, demonstrando que os ganhos não foram um acaso do esforço coletivo.

The Big Picture

No entanto, se o GPT-5 avaliasse os resultados por conta própria, admitiria que as avaliações humanas eram melhores? As avaliações humanas e de IA geralmente seguiam a mesma direção, então o modelo conseguia distinguir o bom do ruim, mas pontuava consistentemente as imagens geradas por IA. mais alto do que os humanos.

'Especificamente, questionamos se os agentes de IA reconheceriam que seus próprios resultados são inferiores aos produzidos por humanos, ou se, em vez disso, demonstrariam preferência por suas próprias criações, o que indicaria um possível problema de alinhamento.'

Como se constatou, existe de fato um problema de alinhamento*:

Os avaliadores de IA atribuíram classificações mais altas aos resultados gerados por IA. Essas descobertas sugerem que as diferenças de desempenho observadas podem decorrer de um desalinhamento nas representações entre humanos e IA.'

Ao examinar como humanos e IA formulam suas orientações, discrepâncias tornaram-se evidentes nos testes. Como pode ser visto na figura abaixo, ambos focam e A duração é um tema de divergência entre IA e humanos:

Uma comparação de como humanos e IA forneceram instruções durante a tarefa de codificação. 'A' mostra que os humanos escrevem instruções curtas e diretas, enquanto a IA escreve descrições longas e detalhadas. 'B' mapeia as instruções, revelando que as instruções humanas se agrupam, enquanto as instruções da IA se separam por animal. 'C' mostra como limitar o tamanho das instruções da IA não corrige seus resultados ruins ao longo do tempo; e 'D' ilustra que os humanos fornecem orientações mais variadas e equilibradas do que a IA, mesmo quando limites de palavras são impostos.

As instruções humanas tendiam a ser curtas e objetivas, oferecendo edições claras que podiam ser aplicadas de forma geral a todos os alvos. As instruções de IA, por outro lado, eram densas em detalhes descritivos e frequentemente repletas de especificidades sobre sombreamento, texturas, iluminação ou minúcias anatômicas – descrições que podem fazer sentido isoladamente, mas não fornecem próximos passos úteis para o modelo (e que serão familiares para aqueles familiarizados com os problemas dos LLMs). em torno do comprimento do contextoOu seja, ser capaz de manter a visão geral à medida que um projeto se desenvolve e cresce).

Para verificar se a redução da verbosidade melhoraria o desempenho, o GPT-5 foi limitado a 10, 20 ou 30 palavras por instrução; mas mesmo essas instruções compactadas não mostraram nenhuma melhoria (veja o canto inferior direito do gráfico acima).

Iniciativas conjuntas

Para testar o que acontece quando humanos e IA (Inteligência Artificial) interagem. share Para controlar as tarefas de codificação, os pesquisadores executaram experimentos com diferentes combinações de entrada humana e de IA, variando de principalmente humanos para principalmente IA.

Todas as combinações híbridas superaram o controle total por IA, de modo que mesmo uma pequena intervenção humana melhorou os resultados:

Configurações de codificação híbrida com diferentes combinações de humanos e IA. (A) Mostra como humanos e IA se revezaram como instrutores e selecionadores em cada etapa da codificação; (B) mostra que maior envolvimento humano levou a resultados de maior qualidade, enquanto maior contribuição da IA reduziu as pontuações; e (C) ilustra uma queda constante na qualidade do resultado final à medida que a participação humana diminui, confirmando que uma direção humana mais consistente produziu melhores resultados.

À medida que a IA assumiu mais responsabilidades no processo, o desempenho caiu, com os melhores resultados observados quando os humanos lideraram a maioria das rodadas e os piores quando a IA liderou a maioria das rodadas. Nenhuma dessas configurações mistas conseguiu manter a melhoria a cada nova rodada, sugerindo que a direção humana funciona melhor quando é constante e consistente, em vez de ocasional.

Inversão de papéis

O estudo também explorou se isso importa. quem faz o quê nesse tipo de tarefa, e testado para isso. O exercício revisado envolvia duas tarefas: um participante ditava como alterar a imagem e outro escolhia uma versão preferida.

Quando ambas as tarefas eram realizadas por pessoas, a qualidade era mantida; mas quando um ser humano dava as instruções e ninguém Ao escolher entre versões, a qualidade piorou.

Testes para divisão de papéis na codificação de vibrações: em (A), remover o papel de seletor levou a um desempenho pior, mesmo quando um humano forneceu instruções; em (B), substituir o seletor humano por uma IA reduziu ligeiramente a qualidade, mas não tão severamente quanto pular a seleção completamente.

Quando a IA estava no comando, pular a etapa de escolha não fazia diferença, já que seus resultados permaneciam consistentes de qualquer maneira; mas quando os humanos davam as instruções e a IA escolhia entre os resultados, a qualidade permanecia próxima à da configuração totalmente humana.

O oposto não funcionou: ter a IA dando instruções enquanto os humanos escolhiam as saídas levou a mais fraco Os resultados sugerem que a orientação criativa humana continua sendo essencial, enquanto a tarefa de escolher entre as opções pode ser transferida para a IA sem grandes perdas.

O artigo conclui:

'A geração de ideias [de alto nível] e a instrução são as contribuições humanas essenciais, enquanto a avaliação e a seleção podem muitas vezes ser delegadas à IA sem perda de desempenho.'

'Isso sugere um princípio de design prático para sistemas híbridos: os humanos devem definir a direção, enquanto a IA pode apoiar a avaliação e a execução.'

Conclusão

Resta saber em que medida janelas de contexto aprimoradas e/ou ampliadas afetarão o desempenho dos LLMs em tarefas desse tipo. O dia em que a "amnésia do LLM" deixar de ser um problema cotidiano na colaboração entre humanos e IA poderá ser motivo tanto de comemoração quanto de alarme, visto que o problema que a IA busca resolver, indiscutivelmente, é pessoas.

No entanto, o trabalho dos autores também deixa claro que existem inato e divergências críticas entre IA e humanos a respeito de qualidade, que poderá ainda ser considerado, pelos consumidores, um conceito insubstituivelmente humano.

* Minha conversão das citações inline dos autores em hiperlinks.

Primeira publicação sexta-feira, 13 de fevereiro de 2026