Intelligenza Artificiale

I modelli di intelligenza artificiale inciampano nella lettura elementare dell'orologio, mentre gli esseri umani eccellono

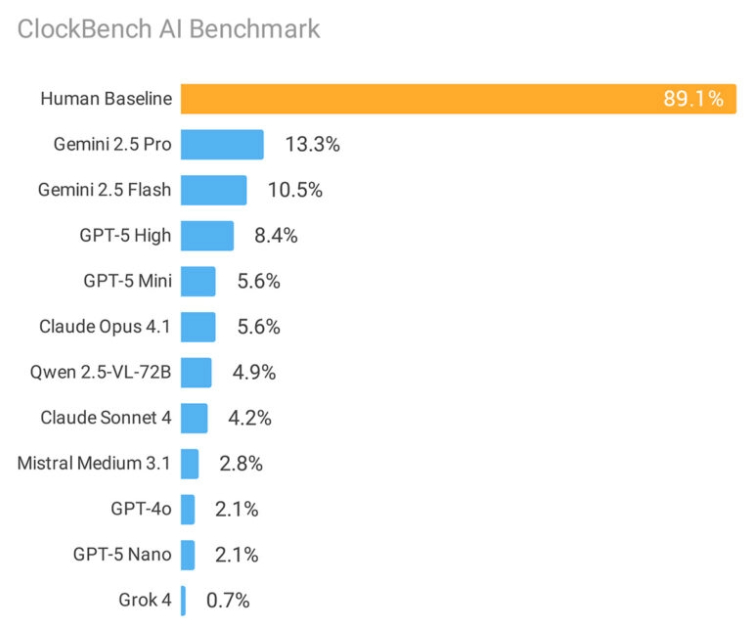

A studio completo Il test di 11 modelli di intelligenza artificiale leader sul mercato, confrontandoli con gli esseri umani nella lettura degli orologi analogici, ha evidenziato una sorprendente debolezza degli attuali sistemi di intelligenza artificiale. Mentre gli esseri umani hanno raggiunto un'accuratezza dell'89.1% nella lettura dell'ora, il modello più performante di Google ha raggiunto solo il 13.3% nello stesso test.

Lo studio ClockBench, condotto dal ricercatore Alek Safar, dimostra che anche i sistemi di intelligenza artificiale più avanzati hanno difficoltà a svolgere compiti visivi che la maggior parte delle persone padroneggia da bambini. I sistemi di Google testati con il benchmark, OpenAI, Antropicoe altri importanti laboratori di intelligenza artificiale che utilizzano 180 orologi analogici progettati su misura.

Questo va oltre gli orologi. I risultati evidenziano limiti fondamentali nel modo in cui i sistemi di intelligenza artificiale elaborano e ragionano sulle informazioni visive. "La lettura degli orologi analogici pone un livello elevato per il ragionamento all'interno dello spazio visivo", osserva Safar nell'articolo di ricerca. Il compito richiede modelli per identificare le lancette dell'orologio, comprenderne le relazioni e tradurre il posizionamento visivo in tempo numerico.

Il divario prestazionale diventa ancora più evidente se si esaminano i modelli di errore. Quando gli esseri umani commettevano errori, l'errore mediano era di soli tre minuti. I modelli di intelligenza artificiale, al contrario, mancavano l'obiettivo di una-tre ore, all'incirca l'equivalente di una stima casuale su un orologio di 12 ore.

Debolezze specifiche rivelate

I sistemi di intelligenza artificiale hanno incontrato in particolare difficoltà:

- Numeri romani (precisione del 3.2%)

- Quadranti dell'orologio specchiati o al contrario

- Sfondi colorati o disegni complessi

- Orologi con lancette dei secondi che richiedono letture precise

È interessante notare che quando i modelli di intelligenza artificiale sono riusciti a leggere un orologio, hanno ottenuto buoni risultati anche in compiti successivi, come l'aggiunta di ore o la conversione di fusi orari. Questo suggerisce che la sfida principale risiede nel riconoscimento visivo iniziale piuttosto che nel ragionamento matematico.

Analisi delle prestazioni del settore

I modelli di Google hanno guidato il gruppo, con Gemelli 2.5 Pro raggiungendo una precisione del 13.3% e Gemini 2.5 Flash raggiungendo il 10.5%. GPT-5 di OpenAI ha ottenuto l'8.4%, mentre Anthropic Claude i modelli hanno avuto performance inferiori, con Claude 4 Sonnet al 4.2% e Claude 4.1 Opus al 5.6%.

Grok 4 di xAI ha registrato risultati sorprendentemente scarsi, con una precisione dello 0.7%, sebbene ciò sia dovuto al fatto che il modello ha segnalato erroneamente il 63% di tutti gli orologi come indicanti tempi impossibili, quando in realtà lo facevano solo il 20.6%.

Fonte: Alek Safar

Implicazioni più ampie per lo sviluppo dell’intelligenza artificiale

Lo studio si basa sull’approccio di riferimento “facile per gli umani, difficile per l’IA” visto in test come ARC-AGI e SimpleBenchSebbene i sistemi di intelligenza artificiale abbiano rapidamente superato compiti ad alta intensità di conoscenza e abbiano persino superato le prestazioni umane in molti test standardizzati, il ragionamento visivo di base rimane problematico.

La ricerca suggerisce che gli attuali approcci di scaling potrebbero non risolvere le sfide del ragionamento visivo. Safar ipotizza che gli orologi analogici possano essere sottorappresentati nei dati di training e che la traduzione delle rappresentazioni visive degli orologi in testo per il ragionamento crei ulteriori complicazioni.

ClockBench si aggiunge a una crescente raccolta di benchmark progettati per identificare i limiti dell'intelligenza artificiale non immediatamente evidenti dalle prestazioni nei test tradizionali. L'intero set di dati rimane privato per evitare contaminazioni nel futuro training dell'intelligenza artificiale, e solo piccoli campioni vengono resi pubblici per i test.

I risultati sollevano interrogativi sulla possibilità che gli attuali paradigmi di sviluppo dell'intelligenza artificiale possano colmare queste lacune nel ragionamento visivo o se saranno necessari approcci completamente nuovi, in modo simile a come l'elaborazione in fase di test ha sbloccato i progressi in altri ambiti.

Per ora, l'umile orologio analogico si erge come una fortezza inaspettata contro l'intelligenza artificiale, leggibile praticamente da qualsiasi essere umano ma che confonde i sistemi di intelligenza artificiale più sofisticati del mondo.