Inteligencia Artificial

Zero123++: una imagen única para un modelo base de difusión de múltiples vistas consistente

Los últimos años han sido testigos de un rápido avance en el rendimiento, la eficiencia y las capacidades generativas de las nuevas tecnologías emergentes. Modelos generativos de IA que aprovechan amplios conjuntos de datos y prácticas de generación de difusión 2D. Hoy en día, los modelos de IA generativa son extremadamente capaces de generar diferentes formas de contenido multimedia en 2D y, hasta cierto punto, en 3D, incluidos texto, imágenes, vídeos, GIF y más.

En este artículo, hablaremos sobre el marco Zero123++, un modelo de IA generativa de difusión condicionada por imágenes con el objetivo de generar imágenes de múltiples vistas consistentes en 3D utilizando una sola entrada de vista. Para maximizar la ventaja obtenida de los modelos generativos previamente entrenados, el marco Zero123++ implementa numerosos esquemas de entrenamiento y acondicionamiento para minimizar la cantidad de esfuerzo que se necesita para ajustar los modelos de imágenes de difusión disponibles en el mercado. Profundizaremos en la arquitectura, el funcionamiento y los resultados del marco Zero123++, y analizaremos sus capacidades para generar imágenes consistentes de múltiples vistas de alta calidad a partir de una sola imagen. Entonces empecemos.

Zero123 y Zero123++: Introducción

El marco Zero123++ es un modelo de IA generativa de difusión condicionada por imagen que busca generar imágenes de múltiples vistas consistentes en 3D utilizando una sola vista de entrada. El marco Zero123++ es una continuación del marco Zero123 o Zero-1-to-3, que aprovecha la novedosa técnica de síntesis de imágenes de vista cero para ser pionero en la conversión de imágenes individuales a 3D de código abierto. Si bien el marco Zero123++ ofrece un rendimiento prometedor, las imágenes generadas por él presentan inconsistencias geométricas visibles, lo que explica principalmente la brecha entre las escenas 3D y las imágenes de múltiples vistas.

El marco Zero-1-to-3 sirve como base para varios otros marcos, incluidos SyncDreamer, One-2-3-45, Consistent123 y más, que agregan capas adicionales al marco Zero123 para obtener resultados más consistentes al generar imágenes 3D. Otros marcos como ProlificDreamer, DreamFusion, DreamGaussian y más siguen un enfoque basado en optimización para obtener imágenes 3D destilando una imagen 3D de varios modelos inconsistentes. Aunque estas técnicas son efectivas y generan imágenes 3D satisfactorias, los resultados podrían mejorarse con la implementación de un modelo de difusión base capaz de generar imágenes multivista de manera consistente. En consecuencia, el marco Zero123++ lleva el Zero-1 al-3 y ajusta un nuevo modelo de difusión base de múltiples vistas de Stable Diffusion.

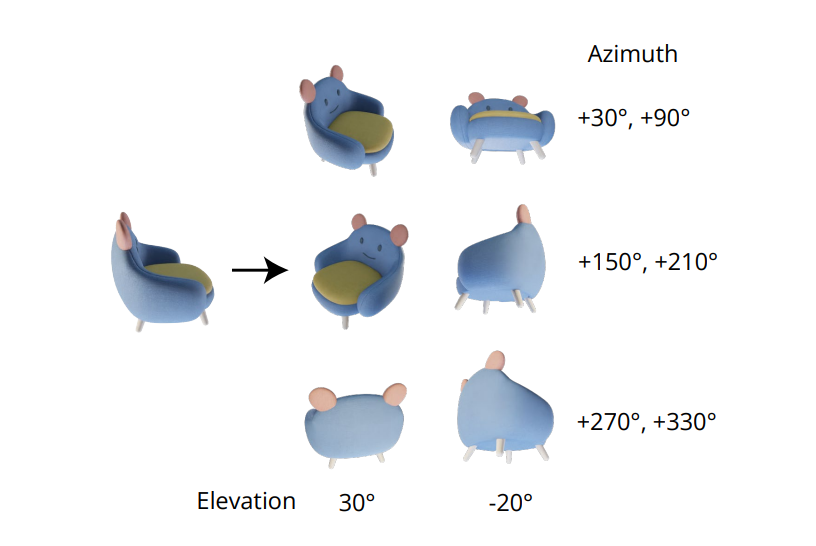

En el marco de cero 1 a 3, cada vista novedosa se genera de forma independiente, y este enfoque conduce a inconsistencias entre las vistas generadas, ya que los modelos de difusión tienen una naturaleza de muestreo. Para abordar este problema, el marco Zero123++ adopta un enfoque de diseño en mosaico, con el objeto rodeado por seis vistas en una sola imagen, y garantiza el modelado correcto para la distribución conjunta de las imágenes de múltiples vistas de un objeto.

Otro desafío importante que enfrentan los desarrolladores que trabajan en el marco Zero-1-to-3 es que subutiliza las capacidades ofrecidas por Difusión estable eso, en última instancia, conduce a la ineficiencia y a costos adicionales. Hay dos razones principales por las que el marco Zero-1-to-3 no puede maximizar las capacidades que ofrece Stable Diffusion

- Cuando se entrena con condiciones de imagen, el marco Zero-1-to-3 no incorpora de manera efectiva los mecanismos de acondicionamiento locales o globales ofrecidos por Stable Diffusion.

- Durante el entrenamiento, el marco Zero-1-to-3 utiliza una resolución reducida, un enfoque en el que la resolución de salida se reduce por debajo de la resolución de entrenamiento que puede reducir la calidad de la generación de imágenes para los modelos de Difusión Estable.

Para abordar estos problemas, el marco Zero123++ implementa una serie de técnicas de acondicionamiento que maximizan la utilización de los recursos ofrecidos por Stable Diffusion y mantienen la calidad de la generación de imágenes para los modelos de Stable Diffusion.

Mejorar el acondicionamiento y las consistencias

En un intento por mejorar el acondicionamiento de la imagen y la coherencia de la imagen de múltiples vistas, el marco Zero123++ implementó diferentes técnicas, con el objetivo principal de reutilizar técnicas anteriores obtenidas del modelo de Difusión Estable previamente entrenado.

Generación de vistas múltiples

La cualidad indispensable para generar imágenes multivista consistentes radica en modelar correctamente la distribución conjunta de múltiples imágenes. En el marco Zero-1-to-3, la correlación entre imágenes de vistas múltiples se ignora porque para cada imagen, el marco modela la distribución marginal condicional de forma independiente y por separado. Sin embargo, en el marco Zero123++, los desarrolladores han optado por un enfoque de diseño en mosaico que agrupa 6 imágenes en un solo cuadro/imagen para una generación consistente de múltiples vistas, y el proceso se demuestra en la siguiente imagen.

Además, se ha observado que las orientaciones de los objetos tienden a eliminar la ambigüedad cuando se entrena el modelo en las posturas de la cámara y, para evitar esta desambiguación, el marco Zero-1-to-3 entrena las posturas de la cámara con ángulos de elevación y azimut relativo a la entrada. Para implementar este enfoque, es necesario conocer el ángulo de elevación de la vista de la entrada que luego se utiliza para determinar la pose relativa entre las nuevas vistas de entrada. En un intento por conocer este ángulo de elevación, los marcos a menudo agregan un módulo de estimación de elevación, y este enfoque a menudo tiene el costo de errores adicionales en la tubería.

Horario de ruido

Programa lineal escalado, el programa de ruido original para Difusión Estable se centra principalmente en detalles locales, pero como se puede ver en la siguiente imagen, tiene muy pocos pasos con SNR o relación señal-ruido más baja.

Estos pasos de baja relación señal-ruido ocurren temprano durante la etapa de eliminación de ruido, una etapa crucial para determinar la estructura global de baja frecuencia. Reducir el número de pasos durante la etapa de eliminación de ruido, ya sea durante la interferencia o el entrenamiento, a menudo da como resultado una mayor variación estructural. Aunque esta configuración es ideal para la generación de una sola imagen, limita la capacidad del marco para garantizar la coherencia global entre diferentes vistas. Para superar este obstáculo, el marco Zero123++ ajusta un modelo LoRA en el marco de predicción v Stable Diffusion 2 para realizar una tarea de juguete, y los resultados se demuestran a continuación.

Con el programa de ruido lineal escalado, el modelo LoRA no se sobreajusta, sino que solo blanquea ligeramente la imagen. Por el contrario, cuando se trabaja con el programa de ruido lineal, el marco LoRA genera una imagen en blanco con éxito independientemente del mensaje de entrada, lo que significa el impacto del programa de ruido en la capacidad del marco para adaptarse a los nuevos requisitos a nivel global.

Atención de referencia escalada para condiciones locales

La entrada de vista única o las imágenes de acondicionamiento en el marco Cero-1 a 3 se concatenan con las entradas ruidosas en la dimensión de la característica que se va a ruido para el acondicionamiento de la imagen.

Esta concatenación conduce a una correspondencia espacial incorrecta en píxeles entre la imagen de destino y la entrada. Para proporcionar una entrada de acondicionamiento local adecuada, el marco Zero123++ utiliza una atención de referencia escalada, un enfoque en el que la ejecución de un modelo UNet de eliminación de ruido se hace referencia a una imagen de referencia adicional, seguido de la adición de matrices de valores y claves de autoatención de la referencia. imagen a las respectivas capas de atención cuando se elimina el ruido de la entrada del modelo, y se demuestra en la siguiente figura.

El enfoque de Atención de referencia es capaz de guiar el modelo de difusión para generar imágenes que comparten una textura similar con la imagen de referencia y contenido semántico sin ningún ajuste. Con un ajuste fino, el enfoque de Atención de referencia ofrece resultados superiores al escalar lo latente.

Acondicionamiento global: FlexDiffuse

En el enfoque original de Difusión estable, las incrustaciones de texto son la única fuente para incrustaciones globales, y el enfoque emplea el marco CLIP como codificador de texto para realizar exámenes cruzados entre las incrustaciones de texto y las latentes del modelo. Como resultado, los desarrolladores son libres de utilizar la alineación entre los espacios de texto y las imágenes CLIP resultantes para utilizarla para acondicionamientos de imágenes globales.

El marco Zero123++ propone hacer uso de una variante entrenable del mecanismo de guía lineal para incorporar el acondicionamiento de imagen global en el marco con un mínimo sintonia FINA Se requiere, y los resultados se muestran en la siguiente imagen. Como se puede observar, sin un condicionamiento de imagen global, la calidad del contenido generado por el marco es satisfactoria para las regiones visibles que corresponden a la imagen de entrada. Sin embargo, la calidad de la imagen generada por el marco para las regiones invisibles presenta un deterioro significativo, debido principalmente a la incapacidad del modelo para inferir la semántica global del objeto.

Arquitectura modelo

El marco Zero123++ se entrena con el modelo Stable Diffusion 2v como base utilizando los diferentes enfoques y técnicas mencionados en el artículo. El marco Zero123++ está previamente entrenado en el conjunto de datos Objaverse que se representa con iluminación HDRI aleatoria. El marco también adopta el enfoque de programa de entrenamiento por fases utilizado en el marco de Variaciones de imágenes de difusión estable en un intento de minimizar aún más la cantidad de ajustes necesarios y preservar tanto como sea posible en la Difusión estable anterior.

El funcionamiento o la arquitectura del marco Zero123++ se puede dividir en pasos o fases secuenciales. En la primera fase, el marco afina las matrices KV de las capas de atención cruzada y las capas de autoatención de Stable Diffusion con AdamW como optimizador, 1000 pasos de calentamiento y el programa de tasa de aprendizaje del coseno que se maximiza en 7×10.-5. En la segunda fase, el marco emplea una tasa de aprendizaje constante altamente conservadora con 2000 series de calentamiento y emplea el enfoque Min-SNR para maximizar la eficiencia durante el entrenamiento.

Zero123++: Comparación de resultados y rendimiento

Rendimiento cualitativo

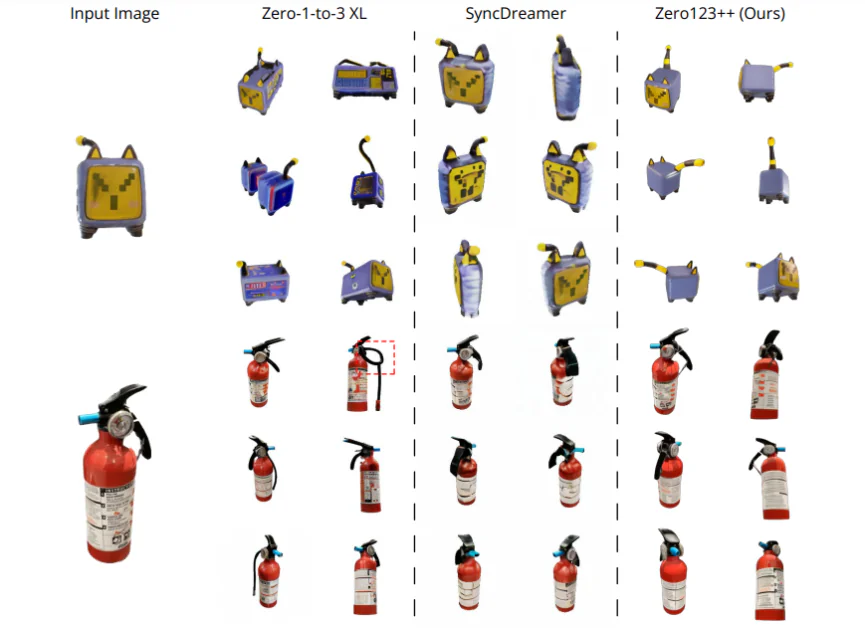

Para evaluar el rendimiento del marco Zero123++ en función de la calidad generada, se lo compara con SyncDreamer y Zero-1-to-3-XL, dos de los mejores marcos de última generación para la generación de contenido. Los marcos se comparan con cuatro imágenes de entrada con diferente alcance. La primera imagen es un gato de juguete eléctrico, tomada directamente del conjunto de datos de Objaverse, y se jacta de una gran incertidumbre en la parte trasera del objeto. La segunda es la imagen de un extintor de incendios y la tercera es la imagen de un perro sentado en un cohete, generada por el modelo SDXL. La imagen final es una ilustración de anime. Los pasos de elevación requeridos para los marcos se logran utilizando el método de estimación de elevación del marco One-2-3-4-5, y la eliminación del fondo se logra utilizando el marco SAM. Como puede verse, el marco Zero123++ genera imágenes multivista de alta calidad de manera consistente y es capaz de generalizarse igualmente bien a ilustraciones 2D fuera de dominio e imágenes generadas por IA.

Análisis cuantitativo

Para comparar cuantitativamente el marco Zero123++ con los marcos Zero-1-to-3 y Zero-1to-3 XL de última generación, los desarrolladores evalúan la puntuación de similitud de parche de imagen perceptual aprendida (LPIPS) de estos modelos en los datos divididos de validación, un subconjunto del conjunto de datos Objaverse. Para evaluar el rendimiento del modelo en la generación de imágenes de múltiples vistas, los desarrolladores colocan en mosaico las imágenes de referencia reales y 6 imágenes generadas respectivamente, y luego calculan la puntuación de similitud de parches de imágenes perceptuales aprendidas (LPIPS). Los resultados se demuestran a continuación y, como se puede ver claramente, el marco Zero123++ logra el mejor rendimiento en el conjunto dividido de validación.

Evaluación de texto a vista múltiple

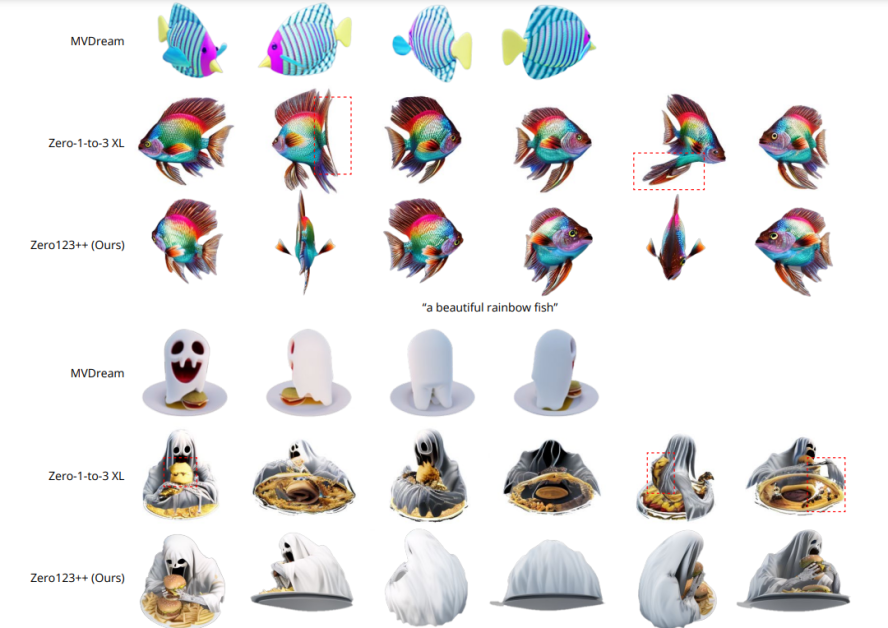

Para evaluar la capacidad del marco Zero123++ en la generación de contenido de texto a vista múltiple, los desarrolladores primero usan el marco SDXL con mensajes de texto para generar una imagen y luego emplean el marco Zero123++ para la imagen generada. Los resultados se demuestran en la siguiente imagen y, como se puede ver, en comparación con el marco Zero-1-to-3 que no puede garantizar una generación consistente de múltiples vistas, el marco Zero123++ arroja múltiples vistas consistentes, realistas y altamente detalladas. ver imágenes implementando el texto a imagen a vista múltiple enfoque o tubería.

Red de control de profundidad Zero123++

Además del marco base Zero123++, los desarrolladores también lanzaron Depth ControlNet Zero123++, una versión controlada en profundidad del marco original creado utilizando la arquitectura ControlNet. Las imágenes lineales normalizadas se representan con respecto a las imágenes RGB posteriores, y se entrena un marco ControlNet para controlar la geometría del marco Zero123++ mediante la percepción de profundidad.

Conclusión

En este artículo, hemos hablado de Zero123++, un modelo de IA generativa de difusión condicionada por imágenes con el objetivo de generar imágenes de múltiples vistas consistentes en 3D utilizando una única entrada de vista. Para maximizar la ventaja obtenida de los modelos generativos previamente entrenados, el marco Zero123++ implementa numerosos esquemas de entrenamiento y acondicionamiento para minimizar la cantidad de esfuerzo que se necesita para ajustar los modelos de imágenes de difusión disponibles en el mercado. También hemos discutido los diferentes enfoques y mejoras implementadas por el marco Zero123++ que lo ayudan a lograr resultados comparables e incluso superiores a los logrados por los marcos de última generación actuales.

Sin embargo, a pesar de su eficiencia y capacidad para generar imágenes multivista de alta calidad de manera consistente, el marco Zero123++ todavía tiene cierto margen de mejora, siendo áreas potenciales de investigación un

- Modelo de refinador de dos etapas eso podría resolver la incapacidad de Zero123++ para cumplir con los requisitos globales de coherencia.

- Ampliaciones adicionales para mejorar aún más la capacidad de Zero123++ de generar imágenes de una calidad aún mayor.