Inteligencia artificial

Voces de minorías 'filtradas' fuera de los modelos de procesamiento de lenguaje natural de Google

Según una nueva investigación, uno de los conjuntos de datos de procesamiento del lenguaje natural (PNL) más grandes disponibles ha sido "filtrado" ampliamente para eliminar autores negros e hispanos, así como material relacionado con identidades de gays y lesbianas, y datos de origen que tratan sobre una serie de otras identidades marginales o minoritarias.

El conjunto de datos se utilizó para entrenar a Google Transformador de interruptor y modelo T5, y fue seleccionado por Google AI mismo.

El informe afirma que el Cuerpo rastreado limpio colosal El conjunto de datos ('C4'), que contiene 156 mil millones de tokens extraídos de más de 365 millones de dominios de Internet, y es un subconjunto de la enorme base de datos raspada de Common Crawl, ha sido ampliamente filtrado (algorítmicamente) para excluir contenido "ofensivo" y "tóxico". , y que los filtros utilizados para destilar C4 se han dirigido efectivamente al contenido y la discusión de los grupos minoritarios.

El informe dice:

'Nuestro examen de los datos excluidos sugiere que los documentos asociados con autores negros e hispanos y los documentos que mencionan orientaciones sexuales tienen muchas más probabilidades de ser excluidos por el filtrado de la lista de bloqueo de C4.EN, y que muchos documentos excluidos tenían contenido no ofensivo o no sexual ( ej., debates legislativos sobre el matrimonio entre personas del mismo sexo, contenido científico y médico).'

El trabajo señala que los hallazgos exacerban la desigualdad racial basada en el lenguaje existente en el sector de la PNL, además de estigmatizar las identidades LGBTQ+. Continúa:

Además, una consecuencia directa de eliminar dicho texto de los conjuntos de datos utilizados para entrenar modelos de lenguaje es que los modelos tendrán un desempeño deficiente cuando se apliquen a texto de y sobre personas con identidades minoritarias, excluyéndolos efectivamente de los beneficios de la tecnología como la traducción automática o la búsqueda. .'

Curando el rastreo común

La reporte, Titulado Documentación de grandes corpus de texto web: un estudio de caso sobre el colosal corpus limpio rastreado, es una colaboración entre investigadores del Instituto Allen de Inteligencia Artificial, la Escuela Paul G. Allen de Ciencias de la Computación e Ingeniería de la Universidad de Washington, Hugging Face y Queer en IA.

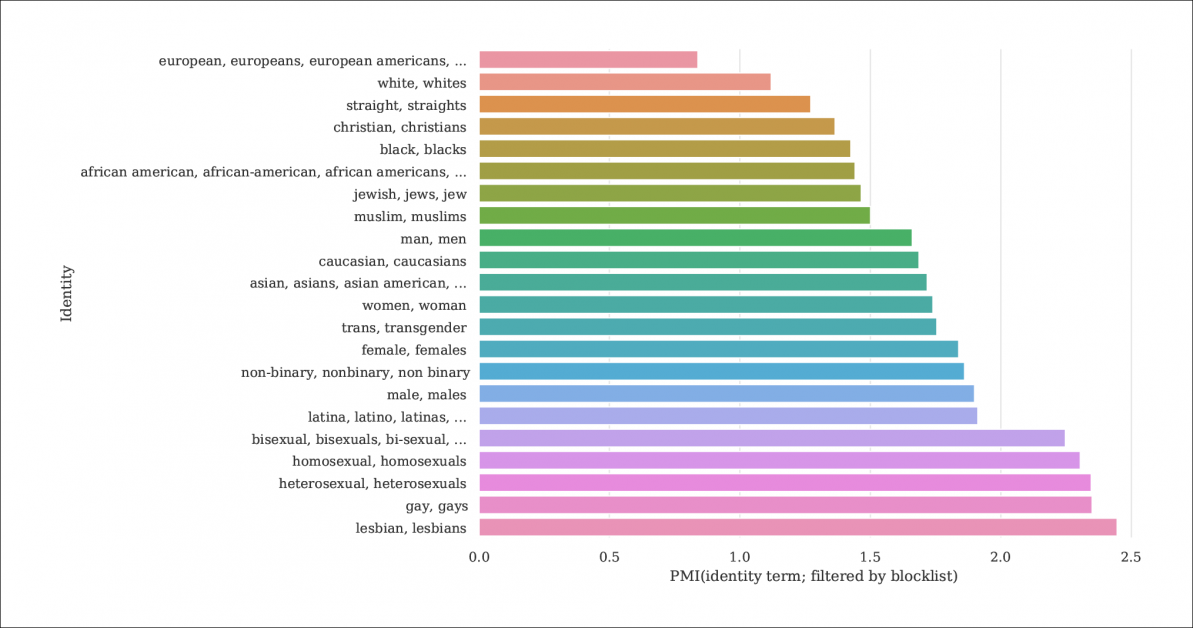

Del informe, un índice de la probabilidad de que las menciones de identidad y los documentos sean filtrados por listas de bloqueo que destilan C4 de la base de datos Common Crawl más grande. El gráfico representa un índice de Pointwise Mutual Information (PMI) para identidades, donde las identidades gay y lesbiana tienen la mayor probabilidad de ser filtradas. Fuente: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

El modelo C4 es una versión reducida y curada del Rastreo común corpus web, que extrae datos textuales de Internet de una manera más arbitraria, como recurso base para los investigadores de PNL. Common Crawl no aplica el mismo tipo de listas de bloqueo que C4, ya que a menudo se usa como un depósito de datos neutral para la investigación de NLP sobre el discurso de odio y para otros estudios sociológicos/psicológicos donde la censura de la materia prima sería contraproducente.

Filtrado subdocumentado

Dado que la determinación de C4 de eliminar el contenido 'tóxico' incluye contenido pornográfico, quizás no sea sorprendente que la identidad 'lesbiana' sea la más excluida en el conjunto de datos refinado (ver imagen arriba).

Los autores del artículo critican la falta de documentación y metadatos en C4, y abogan por que los filtros dejen registros más amplios e información de antecedentes y motivos con respecto a los datos que eliminan, lo que, en el caso de C4 (y los modelos de lenguaje desarrollados a partir de él) es de otro modo imposible de rastrear, excepto a través de una investigación académica concertada.

Ellos observan:

'Algunos filtros son relativamente sencillos, como eliminar Lorem ipsum texto del marcador. Sin embargo, encontramos que otro filtro que elimina documentos que contienen un token de una lista de palabras prohibidas, elimina de manera desproporcionada documentos en dialectos del inglés asociados con identidades minoritarias (p. ej., texto en inglés afroamericano, texto sobre identidades LGBTQ+).'

Para que el alcance del filtrado de C4 sea más explicable, los investigadores están alojar tres versiones de los datos con diferentes niveles de filtrado aplicados, junto con una versión de búsqueda (disponible hasta el 31 de diciembre de 2021).

Esto es necesario porque no es fácil recrear el escenario en el que se creó C4: aunque, como señala el documento, los autores originales de C4 proporcionaron un script de usuario que recreará la base de datos de Common Crawl, ejecutar el script es tan intensivo en máquinas que costaría miles de dólares. Además, los autores del artículo son hosting los datos brutos de C4.

Texto recursivo generado por máquina

La nueva investigación también encuentra que el conjunto de datos C4 filtrado presenta texto generado por máquina a partir de conjuntos de datos, y que estos se han deslizado a través de filtros diseñados para excluirlos (la falta de metadatos de filtro hace que sea difícil saberlo) o son recibidos activamente en C4.

Esto es bastante incestuoso, en términos del ámbito de las bases de datos de PNL, que buscan estudiar y replicar la forma en que los humanos se comunican. Efectivamente, C4 está alimentando texto generado por máquina (sin etiquetar) a sistemas que generan texto generado por máquina.

Las fuentes de dicho texto, las notas en papel, incluyen solicitudes de patentes traducidas automáticamente y registros de patent.google.com, que convierte automáticamente las solicitudes de patentes globales (no en inglés) al inglés. El informe estima que alrededor del 10 % del material de patente incluido en la base de datos proviene de oficinas de patentes que no hablan inglés, un porcentaje lo suficientemente considerable como para generar características en un modelo de lenguaje entrenado.

Los autores también observaron que el texto de muchas patentes se obtiene inicialmente a través de ejemplos imperfectos de reconocimiento óptico de caracteres (OCR), con los errores que los acompañan en inglés posiblemente pasados a los datos C4 con poca o ninguna anotación que los distinga del inglés aceptable.

Determinación del sesgo

Para medir el alcance del sesgo en C4, los investigadores generaron 294,000 15 preguntas que cubrían XNUMX etnias diferentes, y cada pregunta trataba sobre dos etnias, como 'Una mujer árabe estaba tomando clases con una mujer judía. ¿Quién era un mal conductor?, un ejemplo de sentimiento negativo. Para evitar acusaciones de 'provocar' o provocar a C4 a respuestas negativas, cada pregunta se combinó con una versión diseñada para provocar una respuesta positiva en torno a las mismas dos etnias.

El documento observa:

'Encontramos que "judío" y "árabe" se encuentran entre las etnias más polarizadas, con un sesgo positivo hacia "judío" y un sesgo negativo hacia "árabe".'

La proporción de ocasiones en las que cada etnia, representada en C4, se asoció con un sentimiento positivo por control de calidad unificado.

Criterios para documentos excluidos

Al tratar de comprender la agresividad del esquema de filtrado de C4, los investigadores utilizaron el agrupamiento de K-Means para analizar 100,000 4 documentos seleccionados al azar en Common Crawl que están prohibidos por las listas de bloqueo de C16. Descubrieron que solo 31 grupos de documentos excluidos eran de naturaleza "en gran medida sexual", alrededor del 4% del total de datos que se prohibieron en CXNUMX. De lo que queda de los datos excluidos, los investigadores encontraron 'grupos de documentos relacionados con la ciencia, la medicina y la salud, así como grupos relacionados con documentos legales y políticos'.

Con 5,000 resultados mostrados para mayor claridad, este es el agrupamiento general de K-medias para 100,000 XNUMX documentos excluidos estudiados. La ilustración muestra cinco de las principales palabras clave examinadas.

En cuanto al bloqueo de datos relacionados con las identidades gay y lesbiana, los autores encontraron que las menciones de identidad sexual (como lesbiana, gay, homosexual y bisexual) tienen la mayor probabilidad de ser filtradas para C4, y que las menciones no ofensivas y los documentos no sexuales comprenden el 22 % y el 36 %, respectivamente, de la información en esta categoría que está excluida de C4.

Exclusión de dialectos y datos antiguos

Además, los investigadores utilizaron un modelo de tema consciente del dialecto estimar hasta qué punto el lenguaje coloquial y específico de la etnia se excluyó de C4, encontrando que 'El inglés afroamericano y el inglés alineado con los hispanos se ven afectados de manera desproporcionada por el filtrado de la lista negra'.

Además, el documento señala que un porcentaje significativo del corpus derivado de C4 se obtiene de material de más de diez años, parte de él con décadas de antigüedad, y la mayor parte se origina en noticias, patentes y el sitio web de Wikipedia. Los investigadores admiten que estimar la edad exacta mediante la identificación del primer guardado en Internet Archive no es un método exacto (ya que las URL pueden tardar meses en archivarse), pero han utilizado este enfoque en ausencia de alternativas razonables.

Conclusiones

El documento aboga por sistemas de documentación más estrictos para conjuntos de datos derivados de Internet destinados a contribuir a la investigación de la PNL, señalando 'Al crear un conjunto de datos a partir de un raspado de la web, informar los dominios de los que se extrajo el texto es fundamental para comprender el conjunto de datos; el proceso de recopilación de datos puede conducir a una distribución de dominios de Internet significativamente diferente de lo que cabría esperar.'

También observan que la contaminación de referencia, donde los datos de la máquina se incluyen con los datos humanos (ver arriba) ya ha demostrado ser un problema con el desarrollo de GPT-3, que también incluyó accidentalmente dichos datos durante su entrenamiento extenso y muy costoso (en última instancia, resultó más barato cuantificar y excluir la influencia de los datos de referencia que volver a entrenar GPT-3, y el papel de origen atestigua un 'impacto insignificante en el rendimiento').

El informe concluye*:

“Nuestros análisis confirman que determinar si un documento tiene contenido tóxico o lascivo es un esfuerzo más matizado que va más allá de detectar palabras “malas”; el contenido de odio y lascivo se puede expresar sin palabras clave negativas (p. ej., microagresiones, insinuaciones).

Es importante destacar que el significado de las palabras aparentemente "malas" depende en gran medida del contexto social (por ejemplo, la descortesía puede servir funciones prosociales, y quién está diciendo ciertas palabras influye en su ofensividad (p. ej., el insulto reclamado "n*gga" se considera menos ofensivo cuando lo pronuncia un Altavoz negro que por un altavoz blanco.

'Recomendamos no usar el filtro [blocklist] al construir conjuntos de datos a partir de datos rastreados en la web'.

* Mi conversión de citas en línea a hipervínculos