Inteligencia artificial

LoReFT: ajuste de representación para modelos de lenguaje

Los métodos de ajuste fino de parámetros eficientes o PeFT buscan adaptar modelos de lenguaje grandes mediante actualizaciones a una pequeña cantidad de pesos. Sin embargo, la mayoría de los trabajos de interpretabilidad existentes han demostrado que las representaciones codifican información semántica rica, lo que sugiere que podría ser una alternativa mejor y más poderosa editar estas representaciones. Los modelos grandes previamente entrenados a menudo se ajustan para usarlos en nuevos dominios o tareas, y durante el proceso de ajuste, un único modelo base se puede adaptar a una amplia variedad de tareas incluso con solo pequeñas cantidades de datos disponibles en el dominio. al modelo. Sin embargo, el proceso de ajuste de un modelo completo consume recursos y es costoso, especialmente para modelos de lenguaje con un número significativamente mayor de tamaños y parámetros.

Los métodos de ajuste eficiente de parámetros o PeFT proponen abordar los altos costos asociados con el ajuste de todo el modelo actualizando solo una pequeña cantidad de los pesos totales disponibles, un proceso que ayuda a reducir el tiempo de entrenamiento junto con el uso de memoria. Lo que es más importante es que los métodos de ajuste fino eficiente en parámetros o PeFT han demostrado un rendimiento similar al ajuste fino en varias configuraciones prácticas. Los adaptadores, una familia común de métodos de ajuste fino eficientes en parámetros o PeFT, aprenden una edición que se puede agregar a un conjunto adicional de pesos que operan junto con el modelo base congelado, y los adaptadores recientes como LoRA reducen la cantidad de parámetros entrenables en los aprendidos. Actualizaciones de peso mediante el uso de aproximaciones de rango bajo en lugar de matrices de peso completo al entrenar los adaptadores.

Con trabajos anteriores que demuestran que editar representaciones podría ser una mejor alternativa a los métodos de ajuste fino eficiente en parámetros o PeFT, en este artículo hablaremos sobre los métodos de ajuste fino de representación o ReFT que operan en un modelo congelado y aprenderemos tareas específicas. Intervenciones sobre representaciones ocultas. Este artículo tiene como objetivo cubrir en profundidad el marco ReFt o Representation Fine-tuning, y exploramos el mecanismo, la metodología, la arquitectura del marco junto con su comparación con los marcos más avanzados. Entonces empecemos.

ReFT: ajuste de representación para modelos de lenguaje

En un intento por adoptar modelos de lenguaje previamente entrenados para nuevos dominios y tareas, los marcos actuales afinan estos modelos de lenguaje previamente entrenados con frecuencia, ya que con el proceso de ajuste implementado, un único modelo base se puede adaptar a una variedad de tareas incluso cuando se trabaja con una pequeña cantidad de datos en el dominio. Aunque el proceso de ajuste mejora el rendimiento general, es un proceso costoso, especialmente si el modelo de lenguaje tiene una cantidad significativamente alta de parámetros. Para abordar este problema y reducir los costos asociados, PeFT o parámetros eficientes marcos de ajuste fino actualice solo una pequeña fracción de los pesos totales, un proceso que no solo reduce el tiempo de entrenamiento, sino que también reduce el uso de memoria, lo que permite que los marcos PeFT alcancen un rendimiento similar en comparación con enfoques de ajuste completo en escenarios prácticos. Los adaptadores, una familia común de PeFT, funcionan aprendiendo una edición que se puede agregar a un conjunto adicional de pesos junto con un subconjunto de pesos que operan al unísono con el modelo base con pesos congelados. Marcos de adaptadores recientes como LoRA y QLoRA han demostrado que es posible entrenar adaptadores de precisión total sobre modelos de precisión reducida sin afectar el rendimiento. Los adaptadores suelen ser más eficientes y eficaces en comparación con otros métodos que introducen nuevos componentes del modelo.

Un aspecto importante del estado actual del arte de los marcos de ajuste fino de parámetros eficientes es que, en lugar de modificar las representaciones, modifican los pesos. Sin embargo, los marcos que se ocupan de la interpretabilidad han demostrado que las representaciones codifican información semántica rica, lo que sugiere que la edición de representaciones podría ser un enfoque mejor y más poderoso en comparación con las actualizaciones de peso. Esta suposición de que la edición de representaciones es el mejor enfoque es lo que forma la base de ReFT o marco de ajuste fino de representación que entrena intervenciones en lugar de adaptar los pesos del modelo, lo que permite que el modelo manipule una pequeña fracción de todas las representaciones en un intento de dirigir los comportamientos del modelo. para resolver tareas posteriores durante la inferencia. Los métodos ReFT o de ajuste fino de representación son sustitutos directos de los marcos de ajuste fino basados en peso o PeFT eficientes en parámetros. El enfoque ReFT se inspira en modelos recientes que trabajan con una gran interpretabilidad de modelos que interviene en las representaciones para encontrar mecanismos causales fieles y dirige el comportamiento del modelo durante la inferencia y, por lo tanto, puede verse como una generalización de los modelos de edición de representaciones. Sobre la base de lo mismo, LoReFT o ReFT subespacial de bajo rango es una instancia sólida y efectiva de ReFT, y es una parametrización de ReFT que interviene en representaciones ocultas en el espacio lineal abarcado por una matriz de proyección de bajo rango y se basa directamente en el DAS. o marco de búsqueda de alineación distribuida.

Avanzando, a diferencia del ajuste fino completo, el marco de ajuste fino PeFT o eficiente en parámetros entrena solo una pequeña fracción de los parámetros del modelo y logra adaptar el modelo a las tareas posteriores. El marco de ajuste fino eficiente en parámetros se puede clasificar en tres categorías principales:

- Métodos basados en adaptadores: Los métodos basados en adaptadores entrenan módulos adicionales como capas completamente conectadas encima del modelo previamente entrenado con pesos congelados. Los adaptadores en serie insertan componentes entre el perceptrón multicapa o MLP y LM o capas de atención de modelos grandes, mientras que los adaptadores paralelos agregan módulos junto con los componentes existentes. Dado que los adaptadores añaden nuevos componentes que no se pueden incorporar fácilmente a los pesos de los modelos existentes, suponen una carga adicional durante la inferencia.

- LORA: LoRA, junto con sus variantes recientes, aproxima los pesos aditivos durante el entrenamiento mediante el uso de matrices de bajo rango, y no requieren gastos generales adicionales durante la inferencia, ya que las actualizaciones de peso se pueden fusionar en el modelo, y es la razón por la que se consideran las actuales. marcos PeFT más sólidos.

- Métodos basados en indicaciones: Los métodos basados en solicitudes agregan tokens de software que se inicializan aleatoriamente en la entrada y entrenan sus incorporaciones mientras mantienen congelados los pesos del modelo de lenguaje. El rendimiento que ofrecen estos métodos a menudo no es satisfactorio en comparación con otros enfoques de PeFT y también conllevan un costo general de inferencia significativo.

En lugar de actualizar las ponderaciones, el marco ReFT aprende intervenciones para modificar una pequeña fracción de las representaciones totales. Además, trabajos recientes sobre ingeniería de representación y dirección de activación han demostrado que agregar vectores de dirección fijos al flujo residual podría facilitar cierto grado de control sobre grandes generaciones de modelos previamente entrenados sin requerir un uso intensivo de recursos. sintonia FINA. Otros marcos han demostrado que la edición de representaciones con una operación de escalado y traducción aprendida puede intentar igualar, pero no superar, el rendimiento ofrecido por los adaptadores LoRA en una amplia gama de tareas con menos parámetros aprendidos. Además, el éxito de estos marcos en una variedad de tareas ha demostrado que las representaciones introducidas por modelos de lenguaje previamente entrenados tienen una semántica rica, aunque el rendimiento de estos modelos es subóptimo, lo que hace que los PeFT continúen como el enfoque de vanguardia. sin carga de inferencia adicional.

ReFT: Metodología y Arquitectura

Para mantener simple el proceso de preservación del estilo, el marco ReFT asume un modelo grande basado en transformador como modelo objetivo que es capaz de producir una representación contextualizada de la secuencia de tokens. Para una secuencia dada con n número de tokens de entrada, el marco ReFT primero incorpora estos tokens de entrada en una lista de representaciones, después de lo cual las m capas calculan la lista de representaciones ocultas sucesivamente como una función de la lista anterior de representaciones ocultas. Cada representación oculta es un vector y el modelo de lenguaje utiliza las representaciones ocultas finales para producir las predicciones. El marco ReFT considera tanto modelos de lenguaje enmascarados como modelos de lenguaje autorregresivos. Ahora bien, según la hipótesis de la representación lineal, en las redes neuronales los conceptos están codificados dentro de los subespacios lineales de las representaciones. Modelos recientes han descubierto que esta afirmación es cierta en modelos de redes neuronales entrenados en lenguaje natural junto con otras distribuciones de entrada.

Además, en los estudios de interpretabilidad, el marco de abstracción casual utiliza intervenciones de intercambio para establecer el papel de los componentes de la red neuronal de manera casual al implementar comportamientos particulares. La lógica detrás de la intervención de intercambio es que si uno fija una representación en lo que habría sido para un insumo contrafactual, y esta intervención afecta la salida del modelo consistentemente de la manera en que las afirmaciones hechas por el marco ReFT sobre el componente responsable de producir esa representación, entonces el componente juega un papel causal en la conducta. Aunque existen algunos métodos, la intervención de intercambio distribuido es el enfoque ideal para probar si un concepto está codificado en un subespacio lineal de una representación, como lo afirma la hipótesis de la representación lineal. Además, el método DAS se ha utilizado anteriormente para encontrar representaciones lineales en modelos lingüísticos de atributos de entidades, sentimientos, características lingüísticas y razonamiento matemático. Sin embargo, varios experimentos han indicado que el método DAS es altamente expresivo y posee la capacidad de encontrar subespacios causales eficaces incluso cuando el modelo del lenguaje transformador se ha inicializado aleatoriamente y, por lo tanto, aún no ha aprendido ninguna representación de tarea específica, lo que resulta en la debatir si el DAS es lo suficientemente eficaz y responsable para las tareas de interpretabilidad.

La expresividad ofrecida por DAS sugiere que el enfoque podría ser una herramienta ideal para controlar el comportamiento del modelo de lenguaje junto con su trabajo de generación controlable y edición responsable. Por lo tanto, para adaptar los modelos de lenguaje para tareas posteriores, el marco ReFT utiliza la operación de intervención de intercambio distribuido para hacer que un nuevo parámetro sea un método eficiente. Además, el método ReFT es un conjunto de intervenciones, y el marco exige que para dos intervenciones cualesquiera que operen en la misma capa, las posiciones de intervención deben ser disjuntas, y los parámetros de todas las funciones de intervención deben permanecer independientes. Como resultado, ReFT es un marco genérico que abarca intervenciones en representaciones ocultas durante el avance del modelo.

ReFT: experimentos y resultados

Para evaluar su desempeño frente a los marcos PEFT existentes, el marco ReFT realiza experimentos en cuatro puntos de referencia diversos de procesamiento de lenguaje natural y cubre más de 20 conjuntos de datos, con el objetivo principal de proporcionar una imagen rica de cómo se desempeña el marco LoReFT en diferentes escenarios. Además, cuando el marco LoReFT se implementa en la vida real, los desarrolladores deben decidir cuántas intervenciones aprender junto con las posiciones de entrada y las capas en las que aplicar cada una. Para completar la tarea, el marco ReFT ajusta cuatro hiperparámetros.

- El número de posiciones de prefijo sobre las que intervenir.

- El número de posiciones de sufijo sobre las que intervenir.

- Sobre qué conjunto de capas intervenir.

- Si vincular o no los parámetros de intervención en diferentes posiciones en la misma capa.

Al hacer esto, el marco ReFT simplifica el espacio de búsqueda de hiperparámetros y garantiza solo un costo de inferencia adicional fijo que no aumenta con la longitud del mensaje.

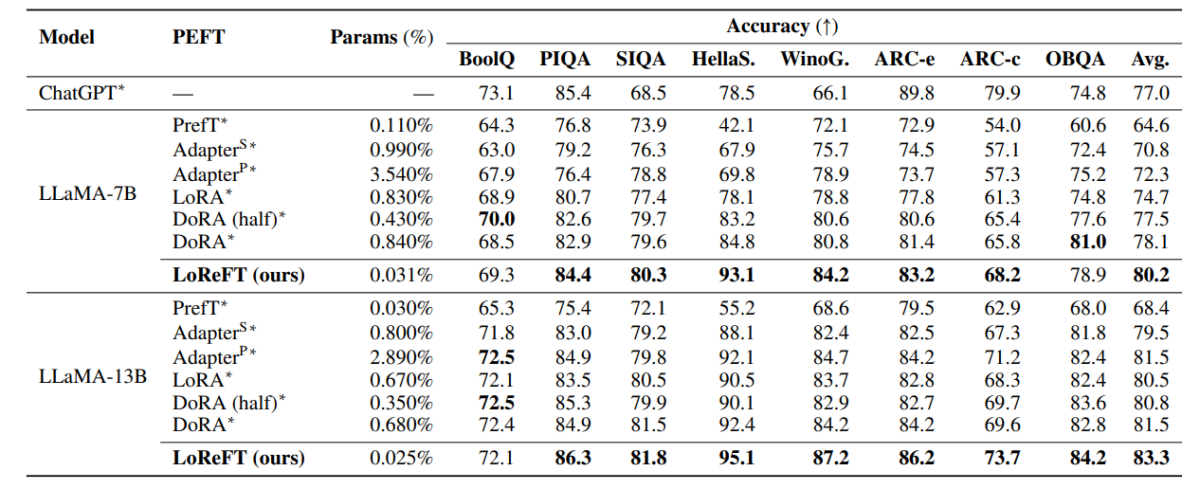

La tabla anterior compara la precisión de los marcos LLaMA-7B y LLaMA-13B con los modelos PEFT existentes en 8 conjuntos de datos de razonamiento de sentido común. Como se puede observar, el modelo LoReFT supera a los enfoques PEFT existentes por un margen decente, a pesar de tener muchos menos parámetros, y el rendimiento promedio de tres ejecuciones se informa con distintos parámetros para el modelo LoReFT. El parámetro (%) se calcula dividiendo el número de parámetros entrenables por el número de parámetros totales del modelo grande base.

La tabla anterior resume la comparación de precisión de los marcos LLaMA-7B y LLaMA-13B con los modelos PEFT existentes en 4 conjuntos de datos de razonamiento aritmético diferentes, y el marco informa el rendimiento promedio de tres ejecuciones con distintas semillas aleatorias. Como se puede observar, a pesar de tener muchos menos parámetros (%), el marco LoReFT supera a los marcos PEFT existentes por un margen considerable.

La tabla anterior resume la comparación de precisión de los marcos RoBERTa-base y RoBERTa-large con los modelos PEFT existentes en el punto de referencia GLUE, y el marco informa el rendimiento promedio de cinco ejecuciones con distintas semillas aleatorias. Como se puede observar, a pesar de tener muchos menos parámetros (%), el marco LoReFT supera a los marcos PEFT existentes por un margen considerable.

Consideraciones Finales:

En este artículo, hemos hablado de LoReFT, una poderosa alternativa a los marcos PEFT existentes que logra un sólido rendimiento en pruebas comparativas de cuatro dominios diferentes y, al mismo tiempo, ofrece hasta 50 veces la eficiencia ofrecida por los modelos PEFT de última generación anteriores. Los modelos grandes previamente entrenados a menudo se ajustan para usarlos en nuevos dominios o tareas, y durante el proceso de ajuste, un único modelo base se puede adaptar a una amplia variedad de tareas incluso con solo pequeñas cantidades de datos disponibles en el dominio. al modelo. Sin embargo, el proceso de ajuste de un modelo completo consume recursos y es costoso, especialmente para modelos de lenguaje con un número significativamente mayor de tamaños y parámetros. Los métodos de ajuste eficiente de parámetros o PeFT proponen abordar los altos costos asociados con el ajuste de todo el modelo actualizando solo una pequeña cantidad de los pesos totales disponibles, un proceso que ayuda a reducir el tiempo de entrenamiento junto con el uso de memoria. En particular, LoReFT establece un rendimiento de vanguardia en razonamiento de sentido común, seguimiento de instrucciones y comprensión del lenguaje natural frente a los PEFT más sólidos.