Inteligencia artificial

Alteración de emociones en secuencias de video con IA

Investigadores de Grecia y el Reino Unido han desarrollado un enfoque novedoso de aprendizaje profundo para cambiar las expresiones y el estado de ánimo aparente de las personas en las imágenes de video, al tiempo que preservan la fidelidad de los movimientos de sus labios al audio original de una manera que los intentos anteriores no han podido igualar. .

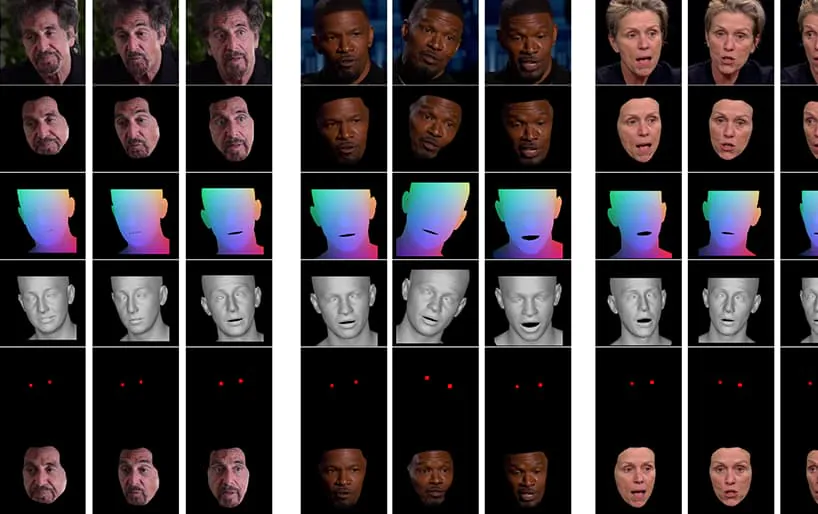

Del video que acompaña al documento (incrustado al final de este artículo), un breve clip del actor Al Pacino con su expresión alterada sutilmente por NED, basado en conceptos semánticos de alto nivel que definen expresiones faciales individuales y su emoción asociada. El método 'basado en referencias' de la derecha toma las emociones interpretadas de un video de origen y las aplica a la totalidad de una secuencia de video. Fuente: https://www.youtube.com/watch?v=Li6W8pRDMJQ

Este campo en particular cae en la creciente categoría de emociones falsas, donde se conserva la identidad del hablante original, pero se alteran sus expresiones y microexpresiones. A medida que esta tecnología de IA en particular madura, ofrece la posibilidad a que las producciones cinematográficas y televisivas realicen modificaciones sutiles en las expresiones de los actores, pero también abre una categoría bastante nueva de videos deepfakes con "emociones alteradas".

Caras cambiantes

Las expresiones faciales de figuras públicas, como los políticos, se seleccionan rigurosamente; en 2016 surgieron las expresiones faciales de Hillary Clinton bajo intenso escrutinio mediático por su potencial impacto negativo en sus perspectivas electorales; Las expresiones faciales, resulta, también son un tema de interes al FBI; y son un indicador crítico en entrevistas de trabajo, lo que hace que la perspectiva (muy lejana) de un filtro de "control de expresión" en vivo sea un desarrollo deseable para los solicitantes de empleo que intentan pasar una pantalla previa en Zoom.

Un estudio de 2005 del Reino Unido afirmó que la apariencia facial afecta las decisiones de votación, mientras que un artículo del Washington Post de 2019 examinó la uso de intercambio de videoclips 'fuera de contexto', que actualmente es lo más parecido que tienen los defensores de las noticias falsas a poder cambiar la forma en que una figura pública parece comportarse, responder o sentir.

Hacia la manipulación de la expresión neuronal

Por el momento, el estado del arte en la manipulación del afecto facial es bastante rudimentario, ya que implica abordar la desenredo de conceptos de alto nivel (como triste, enojado, Ahorrar, sonriente) del contenido de video real. Aunque las arquitecturas deepfake tradicionales parecen lograr este desenredo bastante bien, reflejar emociones en diferentes identidades aún requiere que dos conjuntos de caras de entrenamiento contengan expresiones coincidentes para cada identidad.

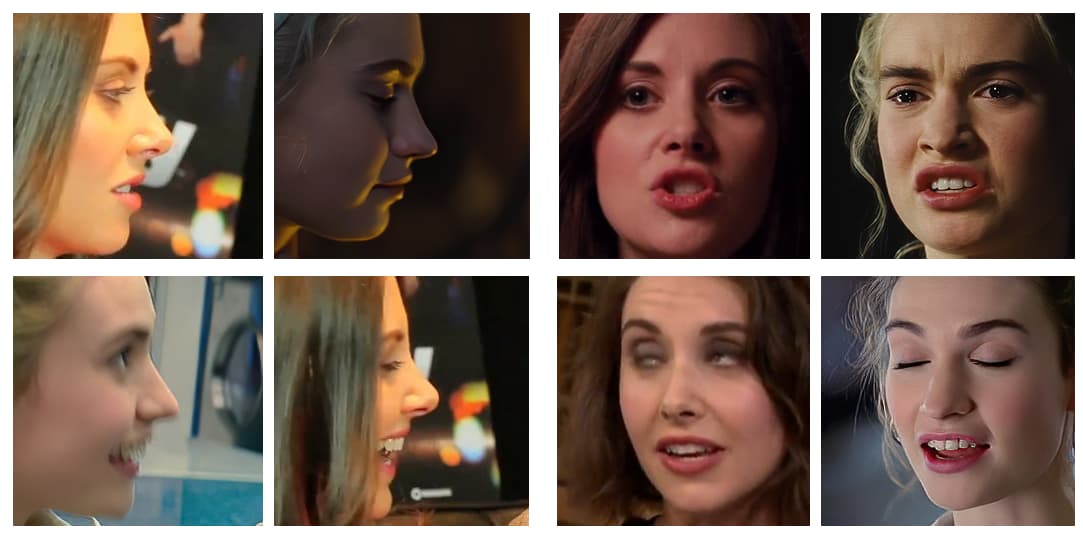

Ejemplos típicos de imágenes de rostros en conjuntos de datos utilizados para entrenar deepfakes. Actualmente, solo puede manipular la expresión facial de una persona mediante la creación de rutas de expresión<>expresión específicas de identificación en una red neuronal falsa. El software deepfake de la era de 2017 no tiene una comprensión semántica intrínseca de una 'sonrisa': solo mapea y combina los cambios percibidos en la geometría facial en los dos sujetos.

Lo que es deseable, y aún no se ha logrado perfectamente, es reconocer cómo sonríe el sujeto B (por ejemplo), y simplemente crear una 'sonrisa' cambiar en la arquitectura, sin necesidad de mapearlo a una imagen equivalente del sujeto A sonriendo.

El nuevo documento se titula Director de emociones neuronales: control semántico de las expresiones faciales que preserva el habla en videos "en estado salvaje", y proviene de investigadores de la Escuela de Ingeniería Eléctrica e Informática de la Universidad Técnica Nacional de Atenas, el Instituto de Ciencias de la Computación de la Fundación para la Investigación y la Tecnología Hellas (FORTH) y la Facultad de Ingeniería, Matemáticas y Ciencias Físicas de la Universidad de Exeter en el Reino Unido.

El equipo ha desarrollado un marco llamado Directora de emociones neuronales (NED), que incorpora una red de traducción de emociones basada en 3D, Manipulador de emociones basado en 3D.

NED toma una secuencia recibida de parámetros de expresión y los traduce a un dominio de destino. Está entrenado en datos sin paralelo, lo que significa que no es necesario entrenar en conjuntos de datos donde cada identidad tiene expresiones faciales correspondientes.

El video, que se muestra al final de este artículo, pasa por una serie de pruebas en las que NED impone un estado emocional aparente en imágenes del conjunto de datos de YouTube.

Los autores afirman que NED es el primer método basado en video para 'dirigir' a actores en situaciones aleatorias e impredecibles, y han puesto el código a disposición en NED's. página del proyecto.

Método y Arquitectura

El sistema está entrenado en dos grandes conjuntos de datos de video que han sido anotados con etiquetas de "emoción".

La salida está habilitada por un renderizador de rostros de video que convierte la emoción deseada en video utilizando técnicas tradicionales de síntesis de imágenes faciales, que incluyen segmentación de rostros, alineación de puntos de referencia faciales y combinación, donde solo se sintetiza el área facial y luego se impone en el metraje original.

La arquitectura para la canalización del Neural Emotion Detector (NED). Fuente: https://arxiv.org/pdf/2112.00585.pdf

Inicialmente, el sistema obtiene recuperación facial 3D e impone alineaciones de puntos de referencia faciales en los cuadros de entrada para identificar la expresión. Después de esto, estos parámetros de expresión recuperados se pasan al manipulador de emociones basado en 3D y se calcula un vector de estilo por medio de una etiqueta semántica (como 'feliz') o mediante un archivo de referencia.

Un archivo de referencia es un video que representa una expresión/emoción particular reconocida, que luego se impone en la totalidad del video de destino, intercambiando la expresión original.

Etapas en el proceso de transferencia de emociones, con varios actores extraídos de videos de YouTube.

La forma de la cara 3D generada final se concatena con la Coordenada de la cara media normalizada (NMFC) y las imágenes de los ojos (los puntos rojos en la imagen de arriba) y se pasa al renderizador neuronal, que realiza la manipulación final.

Resultados

Los investigadores realizaron amplios estudios, incluidos estudios de usuarios y de ablación, para evaluar la eficacia del método frente a trabajos anteriores, y descubrieron que, en la mayoría de las categorías, NED supera el estado actual del arte en este subsector de la manipulación neural facial.

Los autores del artículo prevén que las implementaciones posteriores de este trabajo y herramientas de naturaleza similar serán útiles principalmente en las industrias de la televisión y el cine, afirmando:

"Nuestro método abre una plétora de nuevas posibilidades para aplicaciones útiles de tecnologías de renderizado neuronal, que van desde la postproducción de películas y videojuegos hasta avatares afectivos fotorrealistas".

Este es un trabajo temprano en el campo, pero uno de los primeros en intentar la recreación facial con video en lugar de imágenes fijas. Aunque los videos son esencialmente muchas imágenes fijas que se ejecutan juntas muy rápido, existen consideraciones temporales que hacen que las aplicaciones anteriores de transferencia de emociones sean menos efectivas. En el video adjunto y en los ejemplos del documento, los autores incluyen comparaciones visuales de los resultados de NED con otros métodos recientes comparables.

Se pueden encontrar comparaciones más detalladas y muchos más ejemplos de NED en el video completo a continuación:

3 de diciembre de 2021, 18:30 GMT+2 – A pedido de uno de los autores del artículo, se hicieron correcciones con respecto al 'archivo de referencia', que erróneamente dije que era una foto fija (cuando en realidad es un videoclip). También se modifica el nombre del Instituto de Ciencias de la Computación de la Fundación para la Investigación y la Tecnología.

3 de diciembre de 2021, 20:50 GMT+2: una segunda solicitud de uno de los autores del artículo para una nueva modificación del nombre de la institución mencionada anteriormente.