Inteligencia Artificial

Una guía completa para ajustar modelos de lenguajes grandes

By

Aayush Mittal Mittal

Grandes modelos de idiomas (LLM) como GPT-4, LaMDA, PaLM y otros han conquistado el mundo con su notable capacidad para comprender y generar texto similar al humano sobre una amplia gama de temas. Estos modelos están previamente entrenados en conjuntos de datos masivos que comprenden miles de millones de palabras de Internet, libros y otras fuentes.

Esta fase de preentrenamiento dota a los modelos de un amplio conocimiento general sobre el lenguaje, temas, habilidades de razonamiento e incluso ciertos sesgos presentes en los datos de entrenamiento. Sin embargo, a pesar de su increíble amplitud, estos LLM previamente capacitados carecen de experiencia especializada para dominios o tareas específicas.

Aquí es donde entra en juego el ajuste: el proceso de adaptar un LLM previamente capacitado para sobresalir en una aplicación o caso de uso particular. Al entrenar aún más el modelo en un conjunto de datos más pequeño y específico para una tarea, podemos ajustar sus capacidades para alinearlas con los matices y requisitos de ese dominio.

El perfeccionamiento es similar a transferir los amplios conocimientos de un generalista altamente cualificado para formar un experto en la materia especializado en un campo específico. En esta guía, exploraremos los porqués, los cómo y los qué del perfeccionamiento de los LLM.

¿Qué es el ajuste fino?

En esencia, sintonia FINA Implica tomar un modelo grande previamente entrenado y actualizar sus parámetros mediante una segunda fase de entrenamiento en un conjunto de datos adaptado a su tarea o dominio objetivo. Esto permite que el modelo aprenda e interiorice los matices, patrones y objetivos específicos de esa área más limitada.

Mientras que la formación previa capta una comprensión lingüística amplia de un corpus textual amplio y diverso, el perfeccionamiento especializa esa competencia general. Es como tomar a un hombre del Renacimiento y convertirlo en un experto en la industria.

Los pesos del modelo preentrenado, que codifican su conocimiento general, se utilizan como punto de partida o inicialización para el proceso de ajuste. Posteriormente, el modelo se entrena aún más, pero esta vez con ejemplos directamente relevantes para la aplicación final.

Al exponer el modelo a esta distribución de datos especializada y ajustar los parámetros del modelo en consecuencia, hacemos que el LLM sea más preciso y efectivo para el caso de uso objetivo, sin dejar de beneficiarnos de las amplias capacidades previamente capacitadas como base.

¿Por qué perfeccionar los LLM?

Hay varias razones clave por las que es posible que desee ajustar un modelo de lenguaje grande:

- Personalización del dominio: Cada campo, desde el derecho hasta la medicina y la ingeniería de software, tiene sus propias convenciones de lenguaje, jerga y contextos matizados. El ajuste fino le permite personalizar un modelo general para comprender y producir texto adaptado al dominio específico.

- Especialización de tareas: Los LLM se pueden ajustar para diversas tareas de procesamiento del lenguaje natural, como resúmenes de texto, traducción automática, respuesta a preguntas, etc. Esta especialización aumenta el rendimiento en la tarea objetivo.

- Cumplimiento de datos: Las industrias altamente reguladas, como la atención médica y las finanzas, tienen requisitos estrictos de privacidad de datos. El ajuste permite capacitar a los LLM sobre datos organizacionales patentados y al mismo tiempo proteger la información confidencial.

- Datos etiquetados limitadosObtener grandes conjuntos de datos etiquetados para entrenar modelos desde cero puede ser un desafío. El ajuste fino permite lograr un alto rendimiento de la tarea a partir de ejemplos supervisados limitados, aprovechando las capacidades del modelo preentrenado.

- Actualización del modelo: A medida que con el tiempo aparecen nuevos datos disponibles en un dominio, puede ajustar aún más los modelos para incorporar los últimos conocimientos y capacidades.

- Mitigar los sesgos: Los LLM pueden detectar sesgos sociales a partir de datos amplios previos a la capacitación. El ajuste de conjuntos de datos seleccionados puede ayudar a reducir y corregir estos sesgos indeseables.

En esencia, el ajuste fino cierra la brecha entre un modelo amplio y general y los requisitos específicos de una aplicación especializada. Mejora la precisión, la seguridad y la relevancia de los resultados del modelo para casos de uso específicos.

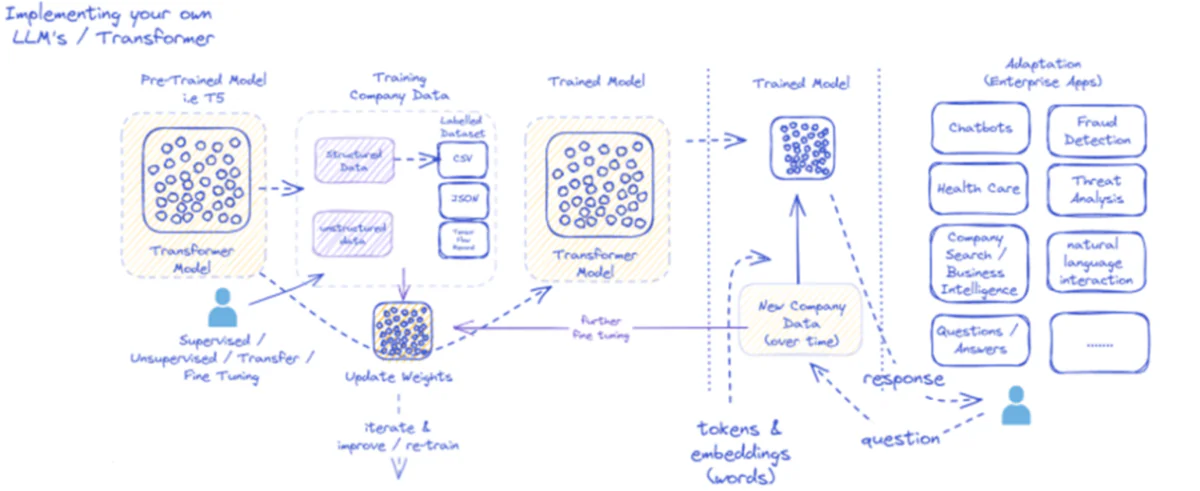

El diagrama proporcionado describe el proceso de implementación y utilización de modelos de lenguaje grandes (LLM), específicamente para aplicaciones empresariales. Inicialmente, un modelo preentrenado, como el T5, se alimenta con datos empresariales estructurados y no estructurados, que pueden presentarse en diversos formatos, como CSV o JSON. Estos datos se someten a procesos de ajuste supervisados, no supervisados o de transferencia, lo que mejora la relevancia del modelo para las necesidades específicas de la empresa.

Una vez que el modelo se ajusta con los datos de la empresa, sus ponderaciones se actualizan en consecuencia. Luego, el modelo entrenado itera a través de ciclos de capacitación adicionales, mejorando continuamente sus respuestas a lo largo del tiempo con nuevos datos de la empresa. El proceso es iterativo y dinámico, y el modelo aprende y se reentrena para adaptarse a los patrones de datos en evolución.

El resultado de este modelo entrenado (tokens e incrustaciones que representan palabras) se implementa luego para diversas aplicaciones empresariales. Estas aplicaciones pueden variar desde chatbots hasta atención médica, y cada una requiere que el modelo comprenda y responda consultas específicas de la industria. En finanzas, las aplicaciones incluyen detección de fraude y análisis de amenazas; En el sector sanitario, los modelos pueden ayudar con las consultas y diagnósticos de los pacientes.

La capacidad del modelo entrenado para procesar y responder a nuevos datos de la empresa a lo largo del tiempo garantiza que su utilidad se mantenga y aumente. Como resultado, los usuarios empresariales pueden interactuar con el modelo a través de aplicaciones, formulando preguntas y recibiendo respuestas fundamentadas que reflejan el entrenamiento y el ajuste del modelo con datos específicos del dominio.

Esta infraestructura admite una amplia gama de aplicaciones empresariales, lo que muestra la versatilidad y adaptabilidad de los LLM cuando se implementan y mantienen adecuadamente dentro de un contexto empresarial.

Enfoques de ajuste

Existen dos estrategias principales cuando se trata de ajustar modelos de lenguaje grandes:

1) Ajuste completo del modelo

En el enfoque de ajuste completo, todos los parámetros (pesos y sesgos) del modelo previamente entrenado se actualizan durante la segunda fase de entrenamiento. El modelo está expuesto al conjunto de datos etiquetados de tarea específica y el proceso de entrenamiento estándar optimiza todo el modelo para esa distribución de datos.

Esto permite que el modelo realice ajustes más completos y se adapte de manera integral a la tarea o dominio objetivo. Sin embargo, un ajuste completo tiene algunas desventajas:

- Requiere importantes recursos computacionales y tiempo para entrenar, similar a la fase de preentrenamiento.

- Los requisitos de almacenamiento son altos, ya que es necesario mantener una copia separada y ajustada del modelo para cada tarea.

- Existe el riesgo de un "olvido catastrófico", donde el ajuste fino hace que el modelo pierda algunas capacidades generales aprendidas durante el entrenamiento previo.

A pesar de estas limitaciones, el ajuste completo sigue siendo una técnica poderosa y ampliamente utilizada cuando los recursos lo permiten y la tarea objetivo difiere significativamente del lenguaje general.

2) Métodos eficientes de ajuste

Para superar los desafíos computacionales del ajuste fino completo, los investigadores han desarrollado estrategias eficientes que solo actualizan un pequeño subconjunto de los parámetros del modelo durante el ajuste fino. Estas técnicas paramétricamente eficientes logran un equilibrio entre la especialización y la reducción de la demanda de recursos.

Algunos métodos populares de ajuste eficiente incluyen:

Ajuste de prefijoAquí, se introduce y entrena un pequeño número de vectores o "prefijos" específicos de la tarea para condicionar la atención del modelo preentrenado a la tarea objetivo. Solo estos prefijos se actualizan durante el ajuste fino.

LoRA (adaptación de bajo rango): lora inyecta matrices entrenables de bajo rango en cada capa del modelo previamente entrenado durante el ajuste fino. Estos pequeños ajustes de rango ayudan a especializar el modelo con muchos menos parámetros entrenables que el ajuste fino completo.

Claro, puedo proporcionar una explicación detallada de LoRA (adaptación de bajo rango) junto con la formulación matemática y ejemplos de código. LoRA es una técnica popular de ajuste fino eficiente en parámetros (PEFT) que ha ganado un impulso significativo en el campo de la adaptación de modelos de lenguaje grande (LLM).

¿Qué es LoRA?

LoRA es un método de ajuste fino que introduce una pequeña cantidad de parámetros entrenables en el LLM preentrenado, lo que permite una adaptación eficiente a las tareas posteriores, preservando al mismo tiempo la mayor parte del conocimiento del modelo original. En lugar de ajustar todos los parámetros del LLM, LoRA inyecta matrices de bajo rango específicas de cada tarea en las capas del modelo, lo que permite un ahorro significativo de cómputo y memoria durante el proceso de ajuste fino.

Formulación matemática

LoRA (adaptación de bajo rango) es un método de ajuste fino para modelos de lenguaje grandes (LLM) que introduce una actualización de bajo rango en las matrices de peso. Para una matriz de peso 0∈W0 ∈Rd×k, LoRA agrega una matriz de bajo rango BA, en el que A∈Rr×k y B∈Rd×r, donde el r es el rango. Este enfoque reduce significativamente la cantidad de parámetros entrenables, lo que permite una adaptación eficiente a tareas posteriores con recursos computacionales mínimos. La matriz de peso actualizada está dada por W=W0 +B⋅A.

Esta actualización de rango bajo se puede interpretar como una modificación de la matriz de peso original $W_{0}$ agregando una matriz de rango bajo $BA$. La ventaja clave de esta formulación es que en lugar de actualizar todos los parámetros $d \times k$ en $W_{0}$, LoRA solo necesita optimizar los parámetros $r \times (d + k)$ en $A$ y $B. $, lo que reduce significativamente la cantidad de parámetros entrenables.

Aquí hay un ejemplo en Python que utiliza el peft Biblioteca para aplicar LoRA a un LLM previamente capacitado para clasificación de texto:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

En este ejemplo, cargamos un modelo BERT previamente entrenado para la clasificación de secuencias y definimos una configuración LoRA. El r El parámetro especifica el rango de la actualización de rango bajo, y lora_alpha es un factor de escala para la actualización. El target_modules El parámetro indica qué capas del modelo deben recibir las actualizaciones de bajo rango. Después de crear el modelo habilitado para LoRA, podemos continuar con el proceso de ajuste utilizando el procedimiento de capacitación estándar.

Capas adaptadoras: Similar a LoRA, pero en lugar de actualizaciones de bajo rango, se insertan capas delgadas de "adaptadores" dentro de cada bloque transformador del modelo previamente entrenado. Solo se entrenan los parámetros de estas pocas capas compactas nuevas.

Sintonización rápidaEste enfoque mantiene el modelo preentrenado completamente congelado. En su lugar, se introducen incrustaciones de "indicación" entrenables como entrada para activar el conocimiento preentrenado del modelo para la tarea objetivo.

Estos métodos eficientes pueden proporcionar reducciones informáticas de hasta 100 veces en comparación con un ajuste fino completo, y al mismo tiempo lograr un rendimiento competitivo en muchas tareas. También reducen las necesidades de almacenamiento al evitar la duplicación completa del modelo.

Sin embargo, su desempeño puede ir a la zaga de un ajuste completo para tareas que son muy diferentes del lenguaje general o que requieren una especialización más holística.

El proceso de ajuste fino

Independientemente de la estrategia de ajuste, el proceso general para especializar un LLM sigue un marco general:

- Preparación del conjunto de datosNecesitará obtener o crear un conjunto de datos etiquetado que asigne las entradas (indicaciones) a las salidas deseadas para su tarea objetivo. Para tareas de generación de texto, como el resumen, esto sería el texto de entrada con los pares de salidas resumidas.

- División de conjuntos de datos: Siguiendo las mejores prácticas, divida su conjunto de datos etiquetados en conjuntos de entrenamiento, validación y prueba. Esto separa los datos para el entrenamiento del modelo, el ajuste de hiperparámetros y la evaluación final.

- Ajuste de hiperparámetros: Es necesario ajustar parámetros como la tasa de aprendizaje, el tamaño del lote y el programa de capacitación para lograr el ajuste más efectivo de sus datos. Por lo general, esto implica un pequeño conjunto de validación.

- Entrenamiento de modelos:Utilizando los hiperparámetros ajustados, ejecute el proceso de optimización de ajuste fino en el conjunto de entrenamiento completo hasta que el rendimiento del modelo en el conjunto de validación deje de mejorar (detención anticipada).

- Evaluación:Evaluar el desempeño del modelo ajustado en el conjunto de pruebas establecido, que idealmente incluye ejemplos del mundo real para el caso de uso objetivo, para estimar la eficacia en el mundo real.

- Implementación y monitoreoUna vez satisfactorio, el modelo ajustado puede implementarse para la inferencia con nuevas entradas. Es crucial monitorear su rendimiento y precisión a lo largo del tiempo para detectar posibles desviaciones conceptuales.

Si bien esto describe el proceso general, muchos matices pueden afectar el éxito del ajuste para un LLM o tarea en particular. Estrategias como el aprendizaje curricular, el ajuste de múltiples tareas y las indicaciones breves pueden mejorar aún más el rendimiento.

Además, los métodos de ajuste eficientes implican consideraciones adicionales. Por ejemplo, LoRA requiere técnicas como condicionar los resultados del modelo previamente entrenado a través de una capa de combinación. La sintonización rápida necesita indicaciones cuidadosamente diseñadas para activar los comportamientos correctos.

Ajuste avanzado: incorporación de la retroalimentación humana

Si bien el ajuste estándar supervisado utilizando conjuntos de datos etiquetados es efectivo, una frontera interesante es capacitar a los LLM directamente utilizando preferencias y comentarios humanos. Este enfoque humano-in-the-loop aprovecha técnicas del aprendizaje por refuerzo:

OPP (Optimización de políticas proximales)Aquí, el LLM se considera un agente de aprendizaje por refuerzo, cuyos resultados son "acciones". Se entrena un modelo de recompensa para predecir las calificaciones humanas o las puntuaciones de calidad para estos resultados. PPO optimiza el LLM para generar resultados que maximicen las puntuaciones del modelo de recompensa.

RLHF (Aprendizaje por refuerzo a partir de la retroalimentación humana)Esto amplía el PPO al incorporar directamente la retroalimentación humana en el proceso de aprendizaje. En lugar de un modelo de recompensa fijo, las recompensas provienen de evaluaciones humanas iterativas de los resultados del LLM durante el ajuste.

Si bien requieren un uso intensivo de computación, estos métodos permiten moldear el comportamiento de LLM con mayor precisión en función de las características deseadas evaluadas por los humanos, más allá de lo que se puede capturar en un conjunto de datos estáticos.

Empresas como Anthropic utilizaron RLHF para dotar a sus modelos lingüísticos como Claude de mayor veracidad, ética y conciencia de seguridad más allá de la simple competencia en la tarea.

Riesgos potenciales y limitaciones

Si bien los LLM son inmensamente poderosos, el ajuste fino no está exento de riesgos que deben gestionarse cuidadosamente:

Amplificación de polarización: Si los datos de ajuste contienen sesgos sociales en torno al género, la raza, la edad u otros atributos, el modelo puede amplificar estos sesgos indeseables. Es fundamental seleccionar conjuntos de datos representativos y no sesgados.

Deriva fáctica: Incluso después de realizar ajustes con datos de alta calidad, los modelos de lenguaje pueden "alucinar" hechos incorrectos o resultados inconsistentes con los ejemplos de entrenamiento en conversaciones o indicaciones más largas. Es posible que se necesiten métodos de recuperación de hechos.

Desafíos de escalabilidad: El ajuste completo de modelos enormes como GPT-3 requiere inmensos recursos informáticos que pueden resultar inviables para muchas organizaciones. Un ajuste eficiente mitiga parcialmente esto, pero tiene sus ventajas y desventajas.

Olvido catastrófico: Durante el ajuste completo, los modelos pueden experimentar un olvido catastrófico, donde pierden algunas capacidades generales aprendidas durante el entrenamiento previo. Es posible que sea necesario el aprendizaje multitarea.

Riesgos de propiedad intelectual y privacidad: Los datos de propiedad utilizados para el ajuste pueden filtrarse en los resultados del modelo de lenguaje publicados públicamente, lo que plantea riesgos. Las técnicas diferenciales de mitigación de riesgos de información y privacidad son áreas activas de investigación.

En general, si bien es excepcionalmente útil, el ajuste es un proceso matizado que requiere atención a la calidad de los datos, consideraciones de identidad, mitigación de riesgos y equilibrio entre rendimiento y eficiencia en función de los requisitos del caso de uso.

El futuro: personalización del modelo de lenguaje a escala

De cara al futuro, los avances en las técnicas de ajuste y adaptación de modelos serán cruciales para desbloquear todo el potencial de los grandes modelos de lenguaje en diversas aplicaciones y dominios.

Métodos más eficientes que permitan ajustar modelos aún más grandes como PaLM con recursos limitados podrían democratizar el acceso. La automatización de los procesos de creación de conjuntos de datos y la ingeniería rápida podrían agilizar la especialización.

Las técnicas autosupervisadas para realizar ajustes a partir de datos sin procesar y sin etiquetas pueden abrir nuevas fronteras. Y los enfoques compositivos para combinar submodelos ajustados entrenados en diferentes tareas o datos podrían permitir la construcción de modelos altamente personalizados bajo demanda.

En última instancia, a medida que los LLM se vuelvan más ubicuos, la capacidad de personalizarlos y especializarlos sin problemas para cada caso de uso imaginable será fundamental. El ajuste y las estrategias de adaptación de modelos relacionados son pasos fundamentales para hacer realidad la visión de grandes modelos de lenguaje como asistentes de IA flexibles, seguros y potentes que aumentan las capacidades humanas en todos los dominios y esfuerzos.

He pasado los últimos cinco años sumergiéndome en el fascinante mundo del aprendizaje automático y el aprendizaje profundo. Mi pasión y experiencia me han llevado a contribuir en más de 50 proyectos diversos de ingeniería de software, con un enfoque particular en AI/ML. Mi curiosidad constante también me ha atraído hacia el procesamiento del lenguaje natural, un campo que estoy ansioso por explorar más a fondo.

Te podría gustar

-

Un método «zen» para evitar que los modelos lingüísticos produzcan alucinaciones

-

Una investigación revela que los LLM recurren al razonamiento simple cuando aumenta la complejidad

-

Utilizar la serie de televisión 'House' para desarrollar las capacidades de diagnóstico de la IA

-

Identificación del robo de modelos de IA mediante datos de seguimiento secretos

-

El fin de la tabula rasa: cómo los modelos del mundo preentrenados están redefiniendo el aprendizaje por refuerzo

-

Cómo colar artículos científicos absurdos a los revisores de IA