Vigilancia

Los rostros sintéticos 'degradados' podrían ayudar a mejorar el reconocimiento de imágenes faciales

Investigadores de la Universidad Estatal de Michigan han ideado una forma para que los rostros sintéticos se tomen un descanso de la escena de los deepfakes y hagan algo bueno en el mundo: ayudando a que los sistemas de reconocimiento de imágenes sean más precisos.

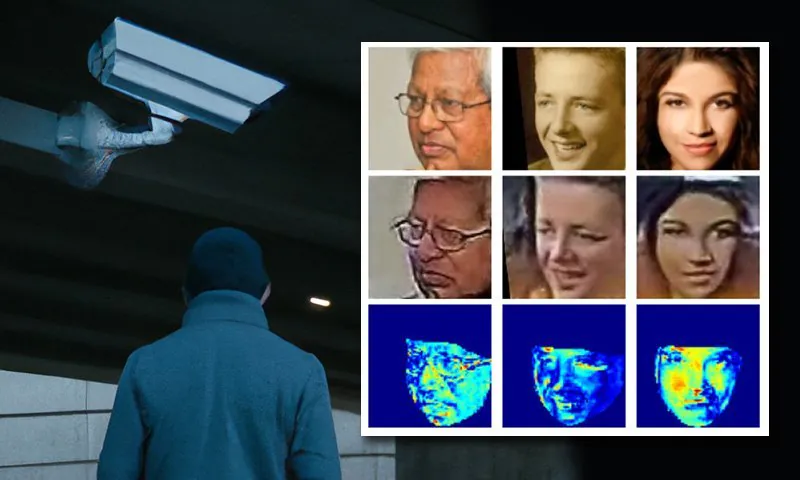

El nuevo módulo controlable de síntesis de rostros (CFSM, por sus siglas en inglés) que han diseñado es capaz de regenerar rostros al estilo de las secuencias de videovigilancia del mundo real, en lugar de depender de las imágenes uniformemente de mayor calidad utilizadas en los populares conjuntos de datos de código abierto de celebridades, que no no refleja todas las fallas y deficiencias de los sistemas CCTV genuinos, como el desenfoque facial, la baja resolución y el ruido del sensor, factores que pueden afectar la precisión del reconocimiento.

Arquitectura conceptual del Módulo de Síntesis de Rostros Controlables (CFSM). Fuente: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022.pdf

CFSM no está destinado específicamente a simular de forma auténtica las poses de la cabeza, las expresiones o todos los demás rasgos habituales que son el objetivo de los sistemas deepfake, sino generar una gama de vistas alternativas al estilo del sistema de reconocimiento de objetivos, utilizando transferencia de estilo.

El sistema está diseñado para imitar el dominio de estilo del sistema de destino y para adaptar su salida de acuerdo con la resolución y el rango de 'excentricidades' del mismo. El caso de uso incluye sistemas heredados que probablemente no se actualicen debido al costo, pero que actualmente pueden contribuir poco a la nueva generación de tecnologías de reconocimiento facial, debido a la mala calidad de la salida que alguna vez pudo haber sido de vanguardia.

Al probar el sistema, los investigadores descubrieron que logró avances notables en los sistemas de reconocimiento de imágenes de última generación que tienen que lidiar con este tipo de datos ruidosos y de bajo grado.

Entrenamiento de los modelos de reconocimiento facial para adaptarse a las limitaciones de los sistemas de destino. Fuente: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022_supp.pdf

Además, encontraron un subproducto útil del proceso: que los conjuntos de datos de destino ahora se pueden caracterizar y comparar entre sí, lo que facilita en el futuro la comparación, la evaluación comparativa y la generación de conjuntos de datos personalizados para diversos sistemas de CCTV.

Además, el método se puede aplicar a conjuntos de datos existentes, realizando de facto adaptación de dominio y hacerlos más adecuados para los sistemas de reconocimiento facial.

La nuevo documento se titula Síntesis facial controlable y guiada para reconocimiento facial sin restricciones, cuenta con el apoyo parcial de la Oficina del Director de Inteligencia Nacional de EE. UU. (ODNI, en IARPA), y proviene de cuatro investigadores del departamento de Ingeniería y Ciencias de la Computación de la MSU.

Contenido destacado

El reconocimiento facial de baja calidad (LQFR) se ha convertido en un notable área de estudio en los ultimos años. Debido a que las autoridades cívicas y municipales construyeron sistemas de videovigilancia para que fueran resilientes y duraderos (sin querer reasignar recursos al problema periódicamente), muchas redes de vigilancia "heredadas" se han convertido en víctimas de una deuda técnica, en términos de su adaptabilidad como datos. Fuentes para el aprendizaje automático.

Diferentes niveles de resolución facial en una gama de sistemas de videovigilancia históricos y más recientes. Fuente: https://arxiv.org/pdf/1805.11519.pdf

Afortunadamente, esta es una tarea que los modelos de difusión y otros modelos basados en el ruido están excepcionalmente bien adaptados para resolver. Muchos de los sistemas de síntesis de imágenes más populares y efectivos de los últimos años realizan ampliación de la escala de imágenes de baja resolución como parte de su canalización, mientras que esto también es absolutamente esencial para las técnicas de compresión neuronal (métodos para guardar imágenes y películas como datos neuronales en lugar de datos de mapa de bits).

Parte del desafío del reconocimiento facial es obtener la máxima precisión posible a partir del mínimo número de Características que se puede extraer de las imágenes de baja resolución más pequeñas y menos prometedoras. Esta restricción existe no solo porque es útil para poder identificar (o crear) una cara a baja resolución, sino también por las limitaciones técnicas en el tamaño de las imágenes que pueden pasar a través del espacio latente emergente de un modelo que está siendo entrenado en lo que sea. VRAM está disponible en una GPU local.

En este sentido, el término "características" resulta confuso, ya que dichas características también pueden obtenerse a partir de un conjunto de datos de bancos de parques. En el sector de la visión por computadora, "características" se refiere a la características distintivas obtenido a partir de imágenes – any imágenes, ya sean los lineamientos de una iglesia, una montaña, o la disposición de facial características en un conjunto de datos faciales.

Dado que los algoritmos de visión por computadora ahora son expertos en ampliar imágenes y secuencias de video, se han propuesto varios métodos para 'mejorar' el material de vigilancia heredado de baja resolución o degradado, hasta el punto de que podría ser posible utilizar dichos aumentos con fines legales, como colocar a una persona en particular en una escena, en relación con una investigación criminal.

Además de la posibilidad de identificación errónea, que tiene de vez en cuando recogía titulares, en teoría, no debería ser necesario hiper-resolver o transformar imágenes de baja resolución para hacer una identificación positiva de un individuo, ya que un sistema de reconocimiento facial que ingresa características de bajo nivel no debería necesitar ese nivel de resolución y claridad. Además, tales transformaciones son costosas en la práctica y plantean costos adicionales, preguntas recurrentes en torno a su potencial validez y legalidad.

La necesidad de más celebridades 'deprimidos'

Sería más útil si un sistema de reconocimiento facial pudiera derivar características (es decir, características de aprendizaje automático de humana características) de la salida de los sistemas heredados tal como están, al comprender mejor la relación entre la identidad de "alta resolución" y las imágenes degradadas que están disponibles en los implacables (y a menudo irremplazables) marcos de videovigilancia existentes.

El problema aquí es uno de los estándares: conjuntos de datos comunes recopilados en la web, como MS-Celeb-1M and WebFace260M (entre varios otros), han sido enganchado a por la comunidad de investigación porque proporcionan puntos de referencia consistentes contra los cuales los investigadores pueden medir su progreso incremental o mayor contra el estado actual del arte.

Ejemplos del popular conjunto de datos MS-Celeb1m de Microsoft. Fuente: https://www.microsoft.com/en-us/research/project/ms-celeb-1m-challenge-recognizing-one-million-celebrities-real-world/

Sin embargo, los autores argumentan que los algoritmos de reconocimiento facial (FR) entrenados en estos conjuntos de datos son material inadecuado para los "dominios" visuales de la salida de muchos sistemas de vigilancia más antiguos.

El documento dice*:

Los modelos FR [de última generación] (SoTA) no funcionan bien en imágenes de vigilancia del mundo real (sin restricciones) debido al problema del cambio de dominio, es decir, los conjuntos de datos de entrenamiento a gran escala (semi-restringidos) obtenidos Los rostros de celebridades rastreados por la web carecen de variaciones naturales, como el ruido inherente del sensor, la baja resolución, el desenfoque de movimiento, el efecto de turbulencia, etc.

'Por ejemplo, la precisión de verificación 1:1 reportada por uno de los modelos SoTA en sin restricciones IJB-S el conjunto de datos es aproximadamente un 30% más bajo que en semi-restringido LFW.

'Un remedio potencial para tal brecha de rendimiento es ensamblar un conjunto de datos faciales sin restricciones a gran escala. Sin embargo, construir un conjunto de datos de entrenamiento de este tipo con decenas de miles de sujetos es prohibitivamente difícil con un alto costo de etiquetado manual.'

El documento relata varios métodos anteriores que han intentado 'coincidir' con los diversos tipos de resultados de los sistemas de vigilancia históricos o de bajo costo, pero tenga en cuenta que estos se han ocupado de aumentos 'ciegos'. Por el contrario, CFSM recibe retroalimentación directa de la salida del mundo real del sistema de destino durante el entrenamiento y se adapta a través de la transferencia de estilo para imitar ese dominio.

La actriz Natalie Portman, que no es ajena al puñado de conjuntos de datos que dominan la comunidad de visión por computadora, figura entre las identidades en este ejemplo de CFSM que realiza una adaptación de dominio de estilo coincidente basada en la retroalimentación del dominio del modelo de destino real.

La arquitectura diseñada por los autores utiliza el método de signo de degradado rápido (FGSM) para individualizar e "importar" los estilos y características obtenidos a partir de la salida real del sistema de destino. La parte del pipeline dedicada a la generación de imágenes mejorará posteriormente y se volverá más fiel al sistema de destino con entrenamiento. Esta retroalimentación del espacio de estilo de baja dimensión del sistema de destino es de bajo nivel y corresponde a los descriptores visuales derivados más amplios.

Los autores comentan:

"Con la retroalimentación del modelo FR, las imágenes sintetizadas son más beneficiosas para el rendimiento FR, lo que conduce a capacidades de generalización significativamente mejoradas de los modelos FR entrenados con ellas".

Examenes

Los investigadores utilizaron la propia MSU trabajo prioritario como plantilla para probar su sistema. Basándose en los mismos protocolos experimentales, utilizaron MS-Celeb-1m, que consiste exclusivamente en fotografías de celebridades rastreadas en la web, como el conjunto de datos de entrenamiento etiquetado. Para ser justos, también incluyeron MS1M-V2, que contiene 3.9 millones de imágenes con 85,700 clases.

Los datos de destino fueron los Conjunto de datos de WiderFace, de la Universidad China de Hong Kong. Este es un conjunto particularmente diverso de imágenes diseñado para tareas de detección de rostros en situaciones desafiantes. Se utilizaron 70,000 imágenes de este conjunto.

Para la evaluación, el sistema se probó con cuatro puntos de referencia de reconocimiento facial: IJB-B, IJB-C, IJB-Sy carapequeña.

CFSM se entrenó con ~10 % de los datos de entrenamiento de MS-Celeb-1m, alrededor de 0.4 millones de imágenes, para 125,000 32 iteraciones en 1 lotes de tamaño bajo el optimizador Adam a una tasa de aprendizaje (muy baja) de 4e-XNUMX.

El modelo objetivo de reconocimiento facial utilizó un modificación de ResNet-50 para la red troncal, con la función de pérdida de ArcFace habilitada durante el entrenamiento. Además, se entrenó un modelo con CFSM como ejercicio de ablación y comparación (indicado como 'ArcFace' en la tabla de resultados a continuación).

Los autores comentan sobre los resultados primarios:

'El modelo ArcFace supera todas las líneas base en las tareas de identificación y verificación de rostros, y logra un nuevo rendimiento SoTA'.

La capacidad de extraer dominios de las diversas características de los sistemas de vigilancia heredados o no especificados también permite a los autores comparar y evaluar la similitud de distribución entre estos marcos y presentar cada sistema en términos de un estilo visual que podría aprovecharse en trabajos posteriores. .

Los autores señalan además que su sistema podría hacer un uso valioso de algunas tecnologías que, hasta la fecha, se han visto únicamente como problemas que deben resolver la comunidad de investigación y visión:

'[CFSM] muestra que la manipulación adversaria podría ir más allá de ser un atacante y servir para aumentar la precisión del reconocimiento en tareas de visión. Mientras tanto, definimos una métrica de similitud de conjunto de datos basada en las bases de estilo aprendidas, que capturan las diferencias de estilo en una etiqueta o predictor agnóstico.

"Creemos que nuestra investigación ha presentado el poder de un modelo de síntesis facial controlado y guiado para FR sin restricciones y proporciona una comprensión de las diferencias de conjuntos de datos".

* Mi conversión de las citas en línea de los autores a hipervínculos.

Publicado por primera vez el 1 de agosto de 2022.