Künstliche Intelligenz

StyleTTS 2: Text-to-Speech auf menschlicher Ebene mit großen Sprachmodellen

Aufgrund der Zunahme natürlicher und synthetischer Sprachsyntheseansätze ist eine der größten Errungenschaften der KI-Branche in den letzten Jahren die effektive Synthese von Text-to-Speech-Frameworks mit potenziellen Anwendungen in verschiedenen Branchen, darunter Hörbücher, virtuelle Assistenten und Sprache -über Erzählungen und mehr, wobei einige hochmoderne Modi eine Leistung und Effizienz auf menschlichem Niveau bei einem breiten Spektrum sprachbezogener Aufgaben bieten. Trotz ihrer starken Leistung gibt es jedoch immer noch Raum für Verbesserungen bei Aufgaben dank ausdrucksstarker und vielfältiger Sprache, der Notwendigkeit einer großen Menge an Trainingsdaten zur Optimierung von Zero-Shot-Text-to-Speech-Frameworks und der Robustheit für OOD- oder Out-of-Distribution-Texte Entwickler sollen an einem robusteren und zugänglicheren Text-to-Speech-Framework arbeiten.

In diesem Artikel sprechen wir über StyleTTS-2, ein robustes und innovatives Text-to-Speech-Framework, das auf den Grundlagen des StyleTTS-Frameworks aufbaut und den nächsten Schritt in Richtung modernster Text-to-Speech-Systeme darstellen soll. Das StyleTTS2-Framework modelliert Sprachstile als latente Zufallsvariablen und verwendet ein probabilistisches Diffusionsmodell, um diese Sprachstile oder Zufallsvariablen abzutasten, sodass das StyleTTS2-Framework realistische Sprache effektiv synthetisieren kann, ohne Referenz-Audioeingänge zu verwenden. Aufgrund dieses Ansatzes ist das StyleTTS2-Framework in der Lage, bessere Ergebnisse zu liefern und eine hohe Effizienz im Vergleich zu aktuellen Text-to-Speech-Frameworks zu zeigen, ist aber auch in der Lage, die vielfältige Sprachsynthese zu nutzen, die Diffusionsmodell-Frameworks bieten. Wir werden das StyleTTS2-Framework ausführlicher besprechen, über seine Architektur und Methodik sprechen und auch einen Blick auf die mit dem Framework erzielten Ergebnisse werfen. Also lasst uns anfangen.

StyleTTS2 für die Text-to-Speech-Synthese: Eine Einführung

StyleTTS2 ist ein innovatives Text-to-Speech-Synthesemodell, das den nächsten Schritt zum Aufbau von TTS-Frameworks auf menschlicher Ebene macht und auf StyleTTS aufbaut, einem stilbasierten Text-to- Sprachgeneratives Modell. Das StyleTTS2-Framework modelliert Sprachstile als latente Zufallsvariablen und verwendet ein probabilistisches Diffusionsmodell, um diese Sprachstile oder Zufallsvariablen abzutasten, sodass das StyleTTS2-Framework realistische Sprache effektiv synthetisieren kann, ohne Referenz-Audioeingänge zu verwenden. Die Modellierung von Stilen als latente Zufallsvariablen unterscheidet das StyleTTS2-Framework von seinem Vorgänger, dem StyleTTS-Framework, und zielt darauf ab, den am besten geeigneten Sprachstil für den Eingabetext zu generieren, ohne dass eine Referenz-Audioeingabe erforderlich ist, und ist in der Lage, während der Aufnahme effektive latente Diffusionen zu erreichen Nutzen Sie die vielfältigen Möglichkeiten der Sprachsynthese von Diffusionsmodelle. Darüber hinaus verwendet das StyleTTS2-Framework auch vorab trainierte große SLM- oder Sprachsprachenmodelle als Diskriminatoren wie das WavLM-Framework und koppelt es mit seinem eigenen neuartigen Ansatz zur differenziellen Dauermodellierung, um das Framework Ende-zu-Ende zu trainieren und letztendlich Sprache mit verbesserter Natürlichkeit zu erzeugen. Dank des verfolgten Ansatzes übertrifft das StyleTTS2-Framework aktuelle State-of-the-Art-Frameworks für Sprachgenerierungsaufgaben und ist eines der effizientesten Frameworks für das Vortraining großer Sprachmodelle im Zero-Shot-Setting für Sprecheranpassungsaufgaben.

Um eine Text-zu-Sprache-Synthese auf menschlicher Ebene bereitzustellen, integriert das StyleTTs2-Framework die Erkenntnisse aus bestehenden Arbeiten, einschließlich Diffusionsmodellen für die Sprachsynthese und großen Sprachmodellen. Diffusionsmodelle werden aufgrund ihrer Fähigkeit zur feinkörnigen Sprachsteuerung und vielfältigen Sprachabtastfunktionen normalerweise für Sprachsyntheseaufgaben verwendet. Allerdings sind Diffusionsmodelle nicht so effizient wie GAN-basierte nicht-iterative Frameworks und ein Hauptgrund dafür ist die Anforderung, latente Darstellungen, Wellenformen und Mel-Spektrogramme iterativ bis zur Zieldauer der Sprache abzutasten.

Andererseits haben neuere Arbeiten zu Large-Speech-Sprachmodellen gezeigt, dass sie in der Lage sind, die Qualität von Text-zu-Sprache-Generierungsaufgaben zu verbessern und sich gut an den Sprecher anzupassen. Große Sprachsprachmodelle konvertieren Texteingaben typischerweise entweder in quantisierte oder kontinuierliche Darstellungen, die von vorab trainierten Sprachsprachenrahmen für Sprachrekonstruktionsaufgaben abgeleitet werden. Die Funktionen dieser Sprachsprachmodelle sind jedoch nicht direkt für die Sprachsynthese optimiert. Im Gegensatz dazu nutzt das StyleTTS2-Framework das Wissen, das große SLM-Frameworks mithilfe von kontradiktorischem Training gewonnen haben, um die Merkmale von Sprachmodellen zu synthetisieren, ohne latente Raumkarten zu verwenden, und erlernt daher direkt einen für die Sprachsynthese optimierten latenten Raum.

StyleTTS2: Architektur und Methodik

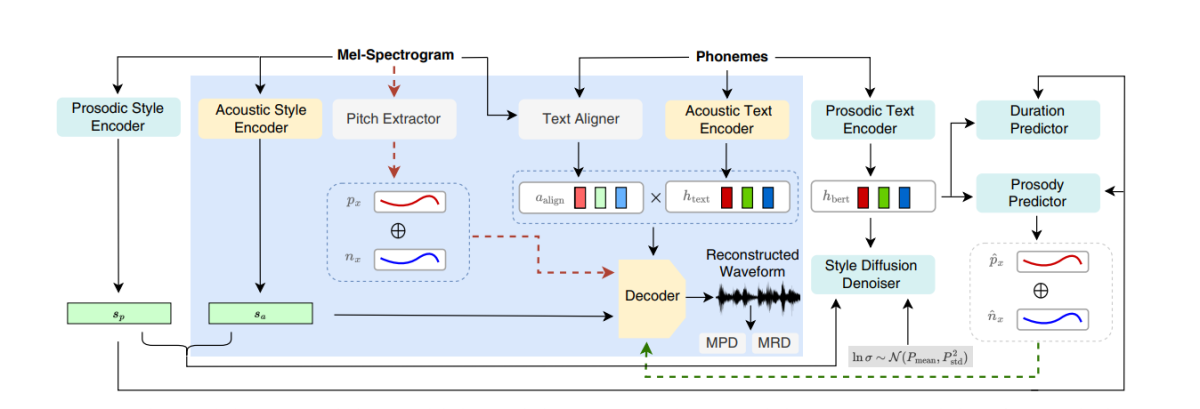

Im Kern basiert StyleTTS2 auf seinem Vorgänger, dem StyleTTS-Framework, einem nicht autoregressiven Text-to-Speech-Framework, das einen Stilencoder verwendet, um einen Stilvektor aus dem Referenzaudio abzuleiten und so eine ausdrucksstarke und natürliche Spracherzeugung zu ermöglichen. Der im StyleTTS-Framework verwendete Stilvektor wird mithilfe von AdaIN oder Adaptive Instance Normalization direkt in den Encoder, die Dauer und die Prädiktoren integriert, sodass das StyleTTS-Modell Sprachausgaben mit unterschiedlicher Prosodie, Dauer und sogar Emotionen generieren kann. Das StyleTTS-Framework besteht aus insgesamt 8 Modellen, die in drei Kategorien unterteilt sind

- Akustische Modelle oder Spracherzeugungssystem mit einem Stil-Encoder, einem Text-Encoder und einem Sprachdecoder.

- Ein Text-to-Speech-Vorhersagesystem, das Prosodie- und Dauerprädiktoren nutzt.

- Ein Versorgungssystem mit einem Textausrichtungsgerät, einem Tonhöhenextraktor und einem Diskriminator für Schulungszwecke.

Dank seines Ansatzes liefert das StyleTTS-Framework modernste Leistung in Bezug auf kontrollierbare und vielfältige Sprachsynthese. Diese Leistung hat jedoch Nachteile wie eine Verschlechterung der Sample-Qualität, Ausdruckseinschränkungen und die Abhängigkeit von sprachbehindernden Anwendungen in Echtzeit.

Das StyleTTS2-Modell verbessert das StyleTTS-Framework und führt zu einer verbesserten Ausdruckskraft Text zu Sprache Aufgaben mit einer verbesserten Out-of-Distribution-Leistung und einer hohen menschlichen Qualität. Das StyleTTS2-Framework nutzt einen End-to-End-Trainingsprozess, der die verschiedenen Komponenten durch gegnerisches Training und direkte Wellenformsynthese gemeinsam optimiert. Im Gegensatz zum StyleTTS-Framework modelliert das StyleTTS2-Framework den Sprachstil als latente Variable und tastet ihn über Diffusionsmodelle ab, wodurch verschiedene Sprachproben generiert werden, ohne dass ein Referenzaudio verwendet wird. Werfen wir einen detaillierten Blick auf diese Komponenten.

End-to-End-Training für Einmischung

Im StyleTTS2-Framework wird ein End-to-End-Trainingsansatz verwendet, um verschiedene Text-zu-Sprache-Komponenten auf Interferenzen zu optimieren, ohne auf feste Komponenten angewiesen zu sein. Das StyleTTS2-Framework erreicht dies, indem es den Decoder so modifiziert, dass er die Wellenform direkt aus dem Stilvektor, Tonhöhen- und Energiekurven und ausgerichteten Darstellungen generiert. Das Framework entfernt dann die letzte Projektionsschicht des Decoders und ersetzt sie durch einen Wellenformdecoder. Das StyleTTS2-Framework nutzt zwei Encoder: einen HifiGAN-basierten Decoder zur direkten Generierung der Wellenform und einen iSTFT-basierten Decoder zur Erzeugung von Phase und Betrag, die für schnellere Interferenz und Training in Wellenformen umgewandelt werden.

Die obige Abbildung stellt die akustischen Modelle dar, die für das Vortraining und das gemeinsame Training verwendet werden. Um die Trainingszeit zu verkürzen, werden die Module zunächst in der Vortrainingsphase optimiert, gefolgt von der Optimierung aller Komponenten abzüglich des Pitch-Extraktors während des gemeinsamen Trainings. Der Grund dafür, dass gemeinsames Training den Tonhöhenextraktor nicht optimiert, liegt darin, dass er dazu verwendet wird, die Grundwahrheit für Tonhöhenkurven bereitzustellen.

Die obige Abbildung stellt das kontradiktorische Training des Speech Language Model und die Interferenz mit dem WavLM-Framework dar, das vorab trainiert, aber nicht vorab abgestimmt ist. Der Prozess unterscheidet sich von dem oben genannten, da er unterschiedliche Eingabetexte verarbeiten kann, aber die Farbverläufe akkumuliert, um die Parameter in jedem Stapel zu aktualisieren.

Stilverbreitung

Das StyleTTS2-Framework zielt darauf ab, Sprache als bedingte Verteilung durch eine latente Variable zu modellieren, die der bedingten Verteilung folgt. Diese Variable wird als verallgemeinerter Sprachstil bezeichnet und repräsentiert jedes Merkmal in der Sprachprobe, das über den Rahmen eines phonetischen Inhalts hinausgeht, einschließlich lexikalischer Betonung. Prosodie, Sprechgeschwindigkeit und sogar Formantenübergänge.

Diskriminatoren für Sprachsprachenmodelle

Sprachsprachmodelle sind für ihre allgemeine Fähigkeit bekannt, wertvolle Informationen zu einem breiten Spektrum semantischer und akustischer Aspekte zu kodieren, und SLM-Darstellungen waren traditionell in der Lage, menschliche Wahrnehmungen nachzuahmen, um die Qualität der erzeugten synthetisierten Sprache zu bewerten. Das StyleTTS2-Framework nutzt einen kontradiktorischen Trainingsansatz, um die Fähigkeit von SLM-Encodern zur Ausführung generativer Aufgaben zu nutzen, und verwendet ein 12-schichtiges WavLM-Framework als Diskriminator. Dieser Ansatz ermöglicht es dem Framework, Schulungen zu OOD- oder Out-of-Distribution-Texten zu ermöglichen, die zur Verbesserung der Leistung beitragen können. Um Überanpassungsprobleme zu vermeiden, prüft das Framework außerdem OOD-Texte und In-Distribution mit gleicher Wahrscheinlichkeit.

Differenzierbare Dauermodellierung

Traditionell wird in Text-zu-Sprache-Frameworks ein Dauerprädiktor verwendet, der Phonemdauern erzeugt. Die von diesen Dauerprädiktoren verwendeten Upsampling-Methoden blockieren jedoch häufig den Gradientenfluss während des E2E-Trainingsprozesses, und das NaturalSpeech-Framework verwendet einen aufmerksamkeitsbasierten Upsampler für die menschliche Ebene Text-zu-Sprache-Konvertierung. Allerdings erachtet das StyleTTS2-Framework diesen Ansatz während des kontradiktorischen Trainings als instabil, da das StyleTTS2-Training differenzierbares Upsampling mit unterschiedlichem kontradiktorischem Training verwendet, ohne dass zusätzliche Terme aufgrund von Längeninkongruenzen aufgrund von Abweichungen verloren gehen. Obwohl die Verwendung eines sanften dynamischen Time-Warping-Ansatzes dazu beitragen kann, diese Diskrepanz zu mildern, ist seine Verwendung nicht nur rechenintensiv, sondern seine Stabilität ist auch ein Problem bei der Arbeit mit kontradiktorischen Zielen oder Mel-Rekonstruktionsaufgaben. Um mit gegnerischem Training eine Leistung auf menschlicher Ebene zu erreichen und den Trainingsprozess zu stabilisieren, verwendet das StyleTTC2-Framework daher einen nichtparametrischen Upsampling-Ansatz. Gaußsches Upsampling ist ein beliebter nichtparametrischer Upsampling-Ansatz zum Konvertieren der vorhergesagten Dauer, obwohl es aufgrund der festen Länge der vorgegebenen Gaußschen Kernel seine Grenzen hat. Diese Einschränkung für das Gaußsche Upsampling schränkt seine Fähigkeit ein, Ausrichtungen mit unterschiedlichen Längen genau zu modellieren.

Um dieser Einschränkung zu begegnen, schlägt das StyleTTC2-Framework die Verwendung eines neuen nichtparametrischen Upsampling-Ansatzes ohne zusätzliche Schulung vor, der in der Lage ist, unterschiedliche Längen der Alignments zu berücksichtigen. Für jedes Phonem modelliert das StyleTTC2-Framework die Ausrichtung als Zufallsvariable und gibt den Index des Sprachrahmens an, an dem das Phonem ausgerichtet ist.

Modelltraining und -evaluierung

Das StyleTTC2-Framework wird anhand von drei Datensätzen trainiert und experimentiert: VCTK, LibriTTS und LJSpeech. Die Single-Speaker-Komponente des StyleTTS2-Frameworks wird mithilfe des LJSpeech-Datensatzes trainiert, der mehr als 13,000 Audio-Samples enthält, aufgeteilt in 12,500 Trainings-Samples, 100 Validierungs-Samples und fast 500 Test-Samples, mit einer Gesamtlaufzeit von insgesamt fast 24 Stunden. Die Multi-Speaker-Komponente des Frameworks wird auf dem VCTK-Datensatz trainiert, der aus über 44,000 Audioclips mit über 100 einzelnen Muttersprachlern mit unterschiedlichen Akzenten besteht, und ist in 43,500 Trainingsbeispiele, 100 Validierungsbeispiele und fast 500 Testbeispiele aufgeteilt. Um das Framework schließlich mit Zero-Shot-Anpassungsfunktionen auszustatten, wird das Framework auf dem kombinierten LibriTTS-Datensatz trainiert, der aus Audioclips von insgesamt etwa 250 Stunden Audio mit über 1,150 einzelnen Sprechern besteht. Um seine Leistung zu bewerten, verwendet das Modell zwei Metriken: MOS-N oder mittlerer Meinungswert der Natürlichkeit, und MOOS oder mittlerer Meinungswert der Ähnlichkeit.

Ergebnisse

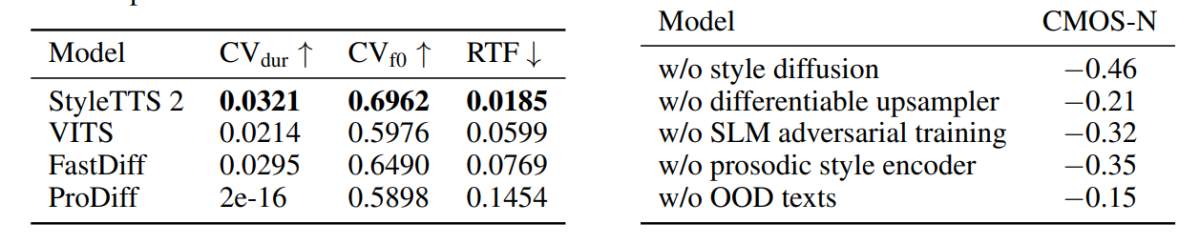

Der im StyleTTS2-Framework verwendete Ansatz und die Methodik zeigen sich in seiner Leistung, da das Modell mehrere hochmoderne TTS-Frameworks übertrifft, insbesondere im NaturalSpeech-Datensatz, und dabei einen neuen Standard für den Datensatz setzt. Darüber hinaus übertrifft das StyleTTS2-Framework das hochmoderne VITS-Framework im VCTK-Datensatz. Die Ergebnisse sind in der folgenden Abbildung dargestellt.

Das StyleTTS2-Modell übertrifft auch frühere Modelle im LJSpeech-Datensatz und zeigt keinen Grad an Qualitätsverschlechterung bei OOD- oder Out-of-Distribution-Texten, wie sie von früheren Frameworks bei denselben Metriken angezeigt wurden. Darüber hinaus übertrifft das StyleTTC2-Modell in der Zero-Shot-Einstellung das vorhandene Vall-E-Framework in Bezug auf Natürlichkeit, fällt jedoch in Bezug auf die Ähnlichkeit zurück. Es ist jedoch erwähnenswert, dass das StyleTTS2-Framework trotz des Trainings mit nur 245 Stunden Audiobeispielen eine konkurrenzfähige Leistung erzielen kann, verglichen mit über 60 Trainingsstunden für das Vall-E-Framework, was StyleTTC2 als dateneffiziente Alternative beweist zu bestehenden großen Vortrainingsmethoden, wie sie im Vall-E verwendet werden.

Aufgrund des Mangels an mit Emotionen gekennzeichneten Audiotextdaten verwendet das StyleTTC2-Framework das GPT-4-Modell, um über 500 Instanzen über verschiedene Emotionen hinweg für die Visualisierung von Stilvektoren zu generieren, die das Framework mithilfe seines Modells erstellt Rundfunk

In der ersten Abbildung werden emotionale Stile als Reaktion auf Eingabetextgefühle durch die Stilvektoren des LJSpeech-Modells veranschaulicht und demonstriert die Fähigkeit des StyleTTC2-Frameworks, ausdrucksstarke Sprache mit unterschiedlichen Emotionen zu synthetisieren. Die zweite Abbildung zeigt unterschiedliche Clusterformen für jeden der fünf einzelnen Sprecher und stellt somit eine große Vielfalt an Vielfalt dar, die aus einer einzigen Audiodatei stammt. Die letzte Abbildung zeigt die lose Ansammlung von Emotionen von Sprecher 1 und zeigt, dass trotz einiger Überschneidungen emotionsbasierte Anhäufungen im Vordergrund stehen, was auf die Möglichkeit hinweist, die emotionale Stimmung eines Sprechers unabhängig von der Referenz-Audioprobe und ihrem Eingabeton zu manipulieren . Trotz der Verwendung eines diffusionsbasierten Ansatzes gelingt es dem StyleTTS2-Framework, bestehende hochmoderne Frameworks wie VITS, ProDiff und FastDiff zu übertreffen.

Fazit

In diesem Artikel haben wir über StyleTTS2 gesprochen, ein neuartiges, robustes und innovatives Text-to-Speech-Framework, das auf den Grundlagen des StyleTTS-Frameworks aufbaut und den nächsten Schritt in Richtung hochmoderner Text-to-Speech-Systeme darstellen soll. Das StyleTTS2-Framework modelliert Sprachstile als latente Zufallsvariablen und verwendet ein probabilistisches Diffusionsmodell, um diese Sprachstile oder Zufallsvariablen abzutasten. Dadurch kann das StyleTTS2-Framework realistische Sprache effektiv synthetisieren, ohne Referenz-Audioeingaben zu verwenden. Das StyleTTS2-Framework verwendet Stildiffusion und SLM-Diskriminatoren um bei Text-to-Speech-Aufgaben eine Leistung auf menschlichem Niveau zu erreichen, und schafft es, bestehende, hochmoderne Frameworks bei einer Vielzahl von Sprachaufgaben zu übertreffen.