Кут Андерсона

Майже 80% навчальних наборів даних можуть становити юридичну небезпеку для ШІ підприємства

Нещодавня стаття LG AI Research показує, що нібито «відкриті» набори даних, які використовуються для навчання моделей штучного інтелекту, можуть створювати хибне відчуття безпеки, виявивши, що майже чотири з п’яти наборів даних штучного інтелекту, позначених як «комерційно придатні», насправді містять приховані правові ризики.

Такі ризики варіюються від включення нерозголошених матеріалів, захищених авторським правом, до обмежувальних умов ліцензування, глибоко захованих у залежностях набору даних. Якщо висновки статті точні, компаніям, які покладаються на загальнодоступні набори даних, можливо, доведеться переглянути свої поточні канали штучного інтелекту або ризикувати юридичним ризиком.

Дослідники пропонують радикальне та потенційно суперечливе рішення: агенти відповідності на основі ШІ, здатні сканувати та перевіряти історію наборів даних швидше та точніше, ніж люди-юристи.

У папері зазначено:

«У цьому документі стверджується, що юридичний ризик навчальних наборів даних штучного інтелекту не можна визначити виключно шляхом перегляду умов ліцензії на поверхневому рівні; Ретельний наскрізний аналіз перерозподілу набору даних є важливим для забезпечення відповідності.

«Оскільки такий аналіз виходить за рамки людських можливостей через його складність і масштаб, агенти ШІ можуть подолати цю прогалину, проводячи його з більшою швидкістю та точністю. Без автоматизації критичні юридичні ризики залишаються в основному невивченими, що ставить під загрозу етичну розробку ШІ та дотримання нормативних актів.

«Ми закликаємо дослідницьке співтовариство штучного інтелекту визнати наскрізний юридичний аналіз фундаментальною вимогою та прийняти підходи, керовані ШІ, як життєздатний шлях до відповідності масштабованого набору даних».

Вивчивши 2,852 популярних набори даних, які здавалися придатними для комерційного використання на основі їхніх індивідуальних ліцензій, автоматизована система дослідників виявила, що лише 605 (приблизно 21%) були фактично юридично безпечними для комерціалізації після того, як усі їхні компоненти та залежності були відстежені.

Команда новий папір має титул Не довіряйте ліцензіям, які ви бачите — відповідність набору даних вимагає масштабного відстеження життєвого циклу за допомогою ШІ, і походить від восьми дослідників LG AI Research.

Права і Права

Автори виділяють те проблеми з якими стикаються компанії, які просувають розвиток штучного інтелекту у все більш невизначеному правовому середовищі – оскільки колишнє академічне мислення «чесного використання» навколо навчання набору даних поступається місцем роздробленому середовищу, де правовий захист є нечітким і безпечна гавань більше не гарантується.

Як одне видання зазначив, Останнім часом компанії дедалі більше захищаються щодо джерел своїх навчальних даних. Автор Адам Бьюїк коментує*:

«[Хоча] OpenAI розкрив основні джерела даних для GPT-3, документ представляє GPT-4 виявлено лише те, що дані, на яких була навчена модель, були сумішшю «загальнодоступних даних (таких як дані з Інтернету) і даних, ліцензованих сторонніми постачальниками».

«Мотиви, що стоять за відходом від прозорості, не були детально сформульовані розробниками штучного інтелекту, які в багатьох випадках взагалі не дали жодних пояснень.

«Зі свого боку, OpenAI виправдав своє рішення не оприлюднювати подальші подробиці щодо GPT-4 на основі занепокоєння щодо «конкурентного середовища та наслідків для безпеки великомасштабних моделей» без додаткових пояснень у звіті».

Прозорість може бути нещирим терміном або просто помилковим; наприклад, флагман Adobe світляк Генеративна модель, навчена на фондових даних, які Adobe мала права використовувати, нібито пропонувала клієнтам запевнення щодо законності використання ними системи. Пізніше деякі з'явилися докази що банк даних Firefly був «збагачений» потенційно захищеними авторським правом даними з інших платформ.

Як ми обговорювався на початку цього тижня, існує все більше ініціатив, спрямованих на забезпечення відповідності ліцензій у наборах даних, включно з ініціативою, яка збиратиме лише відео YouTube за допомогою гнучких ліцензій Creative Commons.

Проблема полягає в тому, що ліцензії самі по собі можуть бути помилковими або виданими помилково, як показує нове дослідження.

Вивчення наборів даних з відкритим кодом

Важко розробити таку систему оцінювання, як Nexus авторів, коли контекст постійно змінюється. Тому в документі стверджується, що рамкова система відповідності даних NEXUS базується на «різних прецедентах і правових підставах на даний момент часу».

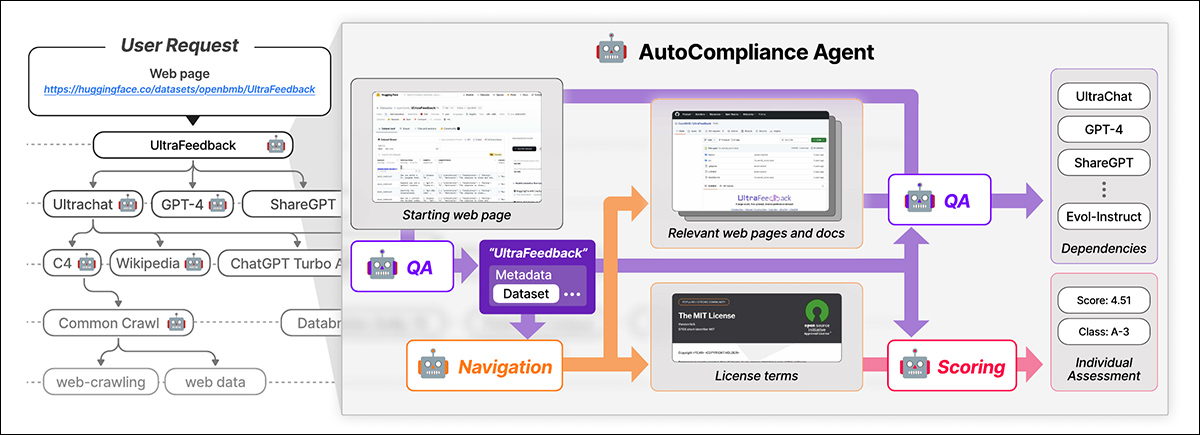

NEXUS використовує керований ШІ агент під назвою Автовідповідність для автоматизованої відповідності даних. AutoCompliance складається з трьох ключових модулів: навігаційного модуля для веб-дослідження; модуль запитань (QA) для отримання інформації; і модуль оцінки юридичних ризиків.

AutoCompliance починається з веб-сторінки, наданої користувачем. AI витягує ключові деталі, шукає пов’язані ресурси, визначає умови ліцензії та залежності та призначає оцінку юридичного ризику. Джерело: https://arxiv.org/pdf/2503.02784

Ці модулі працюють на основі точно налаштованих моделей штучного інтелекту, включаючи EXAONE-3.5-32B-Instruct модель, навчена на синтетичних і позначених людиною даних. AutoCompliance також використовує базу даних для кешування результатів для підвищення ефективності.

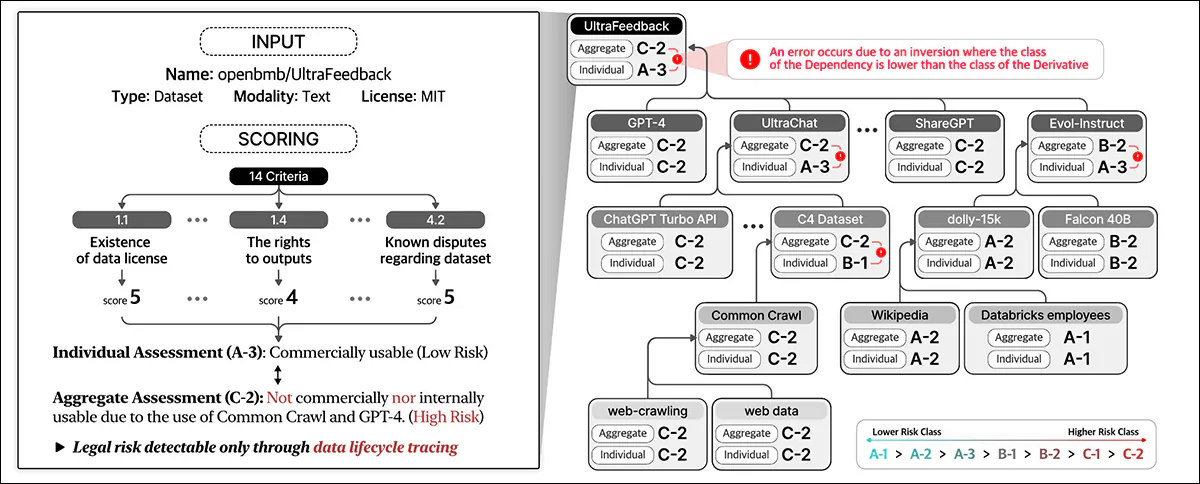

AutoCompliance починається з наданої користувачем URL-адреси набору даних і розглядає його як кореневу сутність, шукаючи його умови ліцензії та залежності, а також рекурсивно відстежуючи зв’язані набори даних для побудови графіка залежностей ліцензії. Після відображення всіх з’єднань він обчислює оцінки відповідності та призначає класифікацію ризиків.

Структура відповідності даних, викладена в новій роботі, визначає різні† типи сутностей, що беруть участь у життєвому циклі даних, у тому числі набори даних, які є основними вхідними даними для навчання ШІ; програмне забезпечення для обробки даних і моделі ШІ, які використовуються для перетворення та використання даних; і Постачальники послуг платформи, що полегшує обробку даних.

Система цілісно оцінює правові ризики, враховуючи ці різні суб’єкти та їхні взаємозалежності, виходячи за рамки механічної оцінки ліцензій на набори даних і включаючи ширшу екосистему компонентів, залучених до розробки ШІ.

Відповідність даних оцінює юридичні ризики протягом усього життєвого циклу даних. Він призначає бали на основі деталей набору даних і 14 критеріїв, класифікуючи окремі об’єкти та агрегуючи ризики за залежностями.

Навчання та метрика

Автори витягли URL-адреси з 1,000 найбільш завантажуваних наборів даних на Hugging Face, випадково відібравши 216 елементів, щоб скласти тестовий набір.

Модель EXAONE була тонко налаштований на спеціальному наборі даних авторів із використанням навігаційного модуля та модуля відповідей на запитання синтетичні дані, а також модуль підрахунку балів, використовуючи дані, позначені людиною.

П’ять юридичних експертів, які пройшли принаймні 31-годинну підготовку для виконання подібних завдань, створили ярлики, що відповідають дійсності. Ці експерти-людини вручну визначили залежності та умови ліцензії для 216 тестових прикладів, а потім узагальнили й уточнили свої висновки шляхом обговорення.

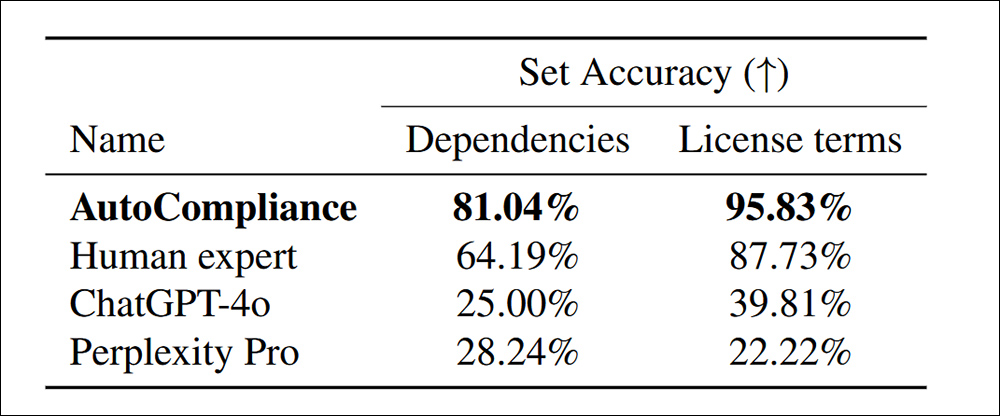

З навченою, відкаліброваною людиною системою AutoCompliance, протестованою ChatGPT-4o та Розгубленість Професіонали, особливо більше залежностей було виявлено в умовах ліцензії:

Точність визначення залежностей і умов ліцензії для 216 наборів оціночних даних.

У папері зазначено:

«AutoCompliance значно перевершує всі інші агенти та Human Expert, досягаючи точності 81.04% та 95.83% у кожному завданні. Навпаки, і ChatGPT-4o, і Perplexity Pro показують відносно низьку точність для завдань Джерело та Ліцензія відповідно.

«Ці результати підкреслюють чудову продуктивність AutoCompliance, демонструючи його ефективність у виконанні обох завдань із надзвичайною точністю, а також вказують на значну різницю в продуктивності між моделями на основі штучного інтелекту та людськими експертами в цих областях».

З точки зору ефективності, підхід AutoCompliance запустив лише 53.1 секунди, на відміну від 2,418 секунд для еквівалентної людської оцінки тих самих завдань.

Крім того, оцінка коштувала 0.29 доларів США порівняно з 207 доларами США для експертів-людей. Однак слід зазначити, що це базується на оренді вузла GCP a2-megagpu-16gpu щомісяця за ставкою 14,225 XNUMX доларів США на місяць, що означає, що така економічна ефективність пов’язана насамперед із великомасштабною операцією.

Дослідження набору даних

Для аналізу дослідники відібрали 3,612 наборів даних, поєднавши 3,000 наборів даних, які найчастіше завантажували з Hugging Face, і 612 наборів даних з 2023 року. Ініціатива походження даних.

У папері зазначено:

«Починаючи з 3,612 цільових об’єктів, ми ідентифікували загалом 17,429 13,817 унікальних об’єктів, де XNUMX XNUMX об’єктів фігурували як прямі чи непрямі залежності цільових об’єктів.

«Для нашого емпіричного аналізу ми вважаємо, що об’єкт і його графік залежностей від ліцензії мають одношарову структуру, якщо об’єкт не має жодних залежностей, і багаторівневу структуру, якщо він має одну чи більше залежностей.

«З 3,612 цільових наборів даних 2,086 (57.8%) мали багатошарові структури, тоді як інші 1,526 (42.2%) мали одношарові структури без залежностей».

Набори даних, захищені авторським правом, можна перерозповсюджувати лише з юридичними повноваженнями, які можуть випливати з ліцензії, винятків із закону про авторське право чи умов контракту. Несанкціоноване розповсюдження може призвести до юридичних наслідків, зокрема до порушення авторських прав або договору. Тому чітке визначення невідповідності є важливим.

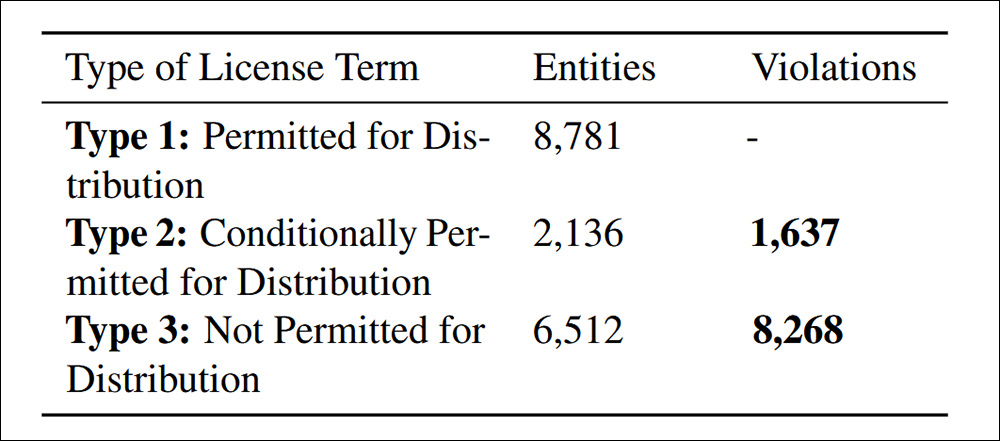

Порушення розподілу, виявлені відповідно до критерію 4.4. відповідності даних.

Дослідження виявило 9,905 випадків невідповідного перерозподілу наборів даних, розділених на дві категорії: 83.5% були прямо заборонені умовами ліцензування, що робить перерозподіл явним порушенням законодавства; і 16.5% включали набори даних із суперечливими ліцензійними умовами, де перерозподіл було дозволено теоретично, але які не відповідали вимогам, що створювало юридичний ризик у подальшому.

Автори визнають, що критерії ризику, запропоновані в NEXUS, не є універсальними і можуть відрізнятися залежно від юрисдикції та застосування штучного інтелекту, і що майбутні вдосконалення мають бути зосереджені на адаптації до глобальних нормативних актів, що змінюються, удосконалюючи правовий огляд за допомогою штучного інтелекту.

Висновок

Це багатогранний і в значній мірі недружній документ, але він розглядає, мабуть, найбільший фактор, що гальмує нинішнє впровадження штучного інтелекту в індустрії – можливість того, що очевидно «відкриті» дані пізніше будуть заявлені різними суб’єктами, особами та організаціями.

Відповідно до Закону про захист авторських прав у цифрову епоху (DMCA), порушення можуть спричинити за собою великі штрафи на випадок основа. Там, де порушення можуть обчислюватися мільйонами, як у випадках, виявлених дослідниками, потенційна юридична відповідальність є справді значною.

Крім того, компанії, які, як можна довести, отримали вигоду від первинних даних, не можуть (як завжди) виправдовують незнання, принаймні на впливовому ринку США. Наразі вони також не мають жодних реалістичних інструментів, щоб проникнути в лабіринт наслідків, похованих у нібито ліцензійних угодах щодо набору даних із відкритим кодом.

Проблема у формулюванні такої системи, як NEXUS, полягає в тому, що було б досить складно відкалібрувати її на основі кожного штату в США або кожної нації всередині ЄС; Перспектива створення справді глобальної структури (своєрідного «Інтерполу для визначення походження набору даних») підривається не лише суперечливими мотивами залучених урядів різних країн, але й тим фактом, що ці уряди та стан їхніх поточних законів у цьому відношенні постійно змінюються.

* Моя заміна гіперпосилань на цитати авторів.

† У документі описано шість типів, але останні два не визначені.

Вперше опубліковано в п’ятницю, 7 березня 2025 р