Artificiell intelligens

UniTune: Googles alternativa neurala bildredigeringsteknik

Det verkar som att Google Research attackerar textbaserad bildredigering från flera olika håll, och förmodligen väntar de på att se vad som "ska hända". De är hett på spåren inför veckans lansering av dess Trollpapper, har sökjätten föreslagit ytterligare en latent diffusionsbaserad metod för att utföra annars omöjliga AI-baserade redigeringar på bilder via textkommandon, denna gång kallad UniTune.

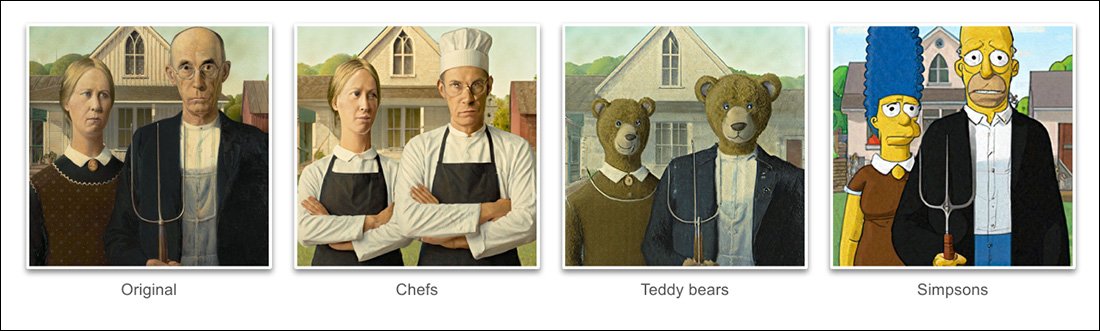

Baserat på exemplen som ges i projektets nytt papper, UniTune har uppnått en extraordinär grad av lösgöring av semantisk pose och idé från verkligt hård bildinnehåll:

UniTunes behärskning av semantisk komposition är enastående. Lägg märke till hur de två personernas ansikten i den översta raden av bilder inte har förvrängts av den extraordinära förvandlingen i resten av källbilden (höger). Källa: https://arxiv.org/pdf/2210.09477.pdf

Som Stable Diffusion fans kommer att ha lärt sig vid det här laget, kan det vara en knepig, ibland omöjlig operation, att tillämpa redigeringar på delar av en bild utan att negativt förändra resten av bilden. Även om populära distributioner som t.ex AUTOMATISK1111 kan skapa masker för lokala och begränsade redigeringar, processen är slingrande och ofta oförutsägbar.

Det uppenbara svaret, åtminstone för en utövare av datorseende, är att lägga in ett lager av semantisk segmentering som kan känna igen och isolera objekt i en bild utan användarintervention, och det har faktiskt funnits flera nya initiativ på sistone i den här riktningen.

Annan Möjligheten för att låsa ner röriga och intrasslade neurala bildredigeringsoperationer är att utnyttja OpenAI:s inflytelserika förträning av kontrastivt språk och bild (KLÄMMA)-modulen, som är kärnan i latenta diffusionsmodeller som DALL-E 2 och Stable Diffusion, för att fungera som ett filter vid den punkt där en text-till-bild-modell är redo att skicka en tolkad rendering tillbaka till användaren . I detta sammanhang bör CLIP fungera som en övervaknings- och kvalitetskontrollmodul, som avvisar felaktiga eller på annat sätt olämpliga renderingar. Detta är på väg att inrättas (Discord-länk) på Stability.ais DreamStudio API-drivna portal.

Men eftersom CLIP utan tvekan är både boven i dramat och lösningen i ett sådant scenario (eftersom det i huvudsak också påverkade hur bilden utvecklades), och eftersom hårdvarukraven kan överstiga vad som sannolikt är tillgängligt lokalt för en slutanvändare, kanske denna metod inte är idealisk.

Komprimerat språk

Den föreslagna UniTune "finjusterar" istället en befintlig diffusionsmodell – i det här fallet Googles egen Imagen, även om forskarna uppger att metoden är kompatibel med andra latenta diffusionsarkitekturer – så att en unik token injiceras i den som kan framkallas genom att inkludera den i en textprompt.

Till nominellt värde låter detta som Google drömbås, för närvarande en besatthet bland Stable Diffusion-fans och utvecklare, som kan injicera nya karaktärer eller föremål i en befintlig checkpoint, ofta på mindre än en timme, baserat på bara en handfull källbilder; eller annat som Textinversion, vilket skapar "sidovagnsfiler" för en kontrollpunkt, vilka sedan behandlas som om de ursprungligen tränades in i modellen, och kan dra nytta av modellens egna stora resurser genom att modifiera dess textklassificerare, vilket resulterar i en liten fil (jämfört med DreamBooths minst 2 GB beskurna kontrollpunkter).

I själva verket, hävdar forskarna, avvisade UniTune båda dessa tillvägagångssätt. De fann att Textual Inversion utelämnade för många viktiga detaljer, medan DreamBooth "presterade sämre och tog längre tid" än den lösning som de slutligen slog sig på.

UniTune använder dock samma inkapslade semantiska "metaprompt"-metod som DreamBooth, med tränade ändringar som framkallas av unika ord valda av tränaren, och som inte kommer att kollidera med några termer som för närvarande finns i en mödosamt tränad modell för offentlig utgivning.

För att utföra redigeringen samplar vi de finjusterade modellerna med prompten “[rare_tokens] edit_prompt” (t.ex. “beikkpic två hundar på en restaurang” eller “beikkpic en minion”).

Processen

Även om det är förbryllande varför två nästan identiska dokument, vad gäller deras slutfunktionalitet, skulle komma från Google samma vecka, finns det, trots ett stort antal likheter mellan de två initiativen, åtminstone en tydlig skillnad mellan UniTune och Imagic – den senare använder "okomprimerade" naturliga språkprompter för att vägleda bildredigeringsoperationer, medan UniTune tränar i unika DreamBooth-stiltokens.

Därför, om du redigerade med Imagic och ville åstadkomma en transformation av denna karaktär...

Från UniTune-artikeln – UniTune jämför sig med Googles favoritrivaliserande ramverk för neural redigering, SDEdit. UniTunes resultat visas längst till höger, medan den uppskattade masken ses i den andra bilden från vänster.

.. i Imagic skulle du skriva in "den tredje personen, sittande i bakgrunden, som ett sött lurvigt monster".

Motsvarande UniTune-kommando skulle vara 'Killen längst bak som [x]'Där x är vilket konstigt och unikt ord som än var bundet till det fintränade konceptet som förknippas med den lurviga monsterkaraktären.

Medan ett antal bilder matas in i antingen DreamBooth eller Textual Inversion med avsikten att skapa en abstraktion i djupfalsk stil som kan styras in i många poser, matar både UniTune och Imagic istället in en enda bild i systemet – den ursprungliga, orörda bilden.

Detta liknar hur många av de GAN-baserade redigeringsverktygen under de senaste åren har fungerat – genom att konvertera en ingångsbild till latenta koder i GAN:s latenta utrymme och sedan adressera dessa koder och skicka dem till andra delar av det latenta utrymmet för modifiering (dvs. mata in en bild av en ung mörkhårig person och projicera den genom latenta koder associerade med "gammal" eller "blond", etc.).

Men resultaten, i en diffusionsmodell, och med denna metod, är ganska häpnadsväckande exakta i jämförelse, och mycket mindre tvetydiga:

Finjusteringsprocessen

UniTune-metoden skickar i huvudsak originalbilden genom en diffusionsmodell med en uppsättning instruktioner om hur den ska modifieras, med hjälp av de stora databaser av tillgänglig data som tränats in i modellen. I praktiken kan du göra detta just nu med Stable Diffusions img2img funktionalitet – men inte utan förvrängning eller på något sätt ändra de delar av bilden som du föredrar att behålla.

Under UniTune-processen är systemet finjusterad, vilket vill säga att UniTune tvingar modellen att återuppta träningen, med de flesta av dess lager ofrusta (se nedan). I de flesta fall kommer finjustering att tanka overallen allmänna förlustvärden för en svårvunnen högpresterande modell till förmån för att injicera eller förfina någon annan aspekt som man önskar skapa eller förbättra.

Med UniTune verkar det dock som att den modellkopia som åtgärdas, även om den kan väga flera gigabyte eller mer, kommer att behandlas som ett engångsmaterial och kasseras i slutet av processen, eftersom den bara tjänar ett enda syfte. Denna typ av tillfälligt datamängd håller på att bli en vardaglig lagringskris för DreamBooth-fans, vars egna modeller, även när de beskärs, är minst 2 GB stora per subjekt.

Precis som med Imagic sker huvudinställningen i UniTune vid de två nedre av de tre lagren i Imagen (bas 64px, 64px>256px och 256px>1024px). Till skillnad från Imagic ser forskarna ett visst potentiellt värde i att optimera justeringen även för detta sista och största superupplösningslager (även om de inte har försökt det ännu).

För det lägsta 64px-lagret är modellen förspänd mot basbilden under träning, med flera dubbletter av bild/text matas in i systemet för 128 iterationer vid en batchstorlek på 4, och med Adafaktor som förlustfunktion, som arbetar med en inlärningshastighet på 0.0001. Även om T5-kodare enbart fryses under denna finjustering, den fryses även under primär träning av Imagen

Ovanstående operation upprepas sedan för 64>256px-skiktet, med samma brusförstärkningsprocedur som användes i den ursprungliga utbildningen av Imagen.

provtagning

Det finns många möjliga provtagningsmetoder genom vilka ändringarna som gjorts kan framkallas från den finjusterade modellen, inklusive Classifier Free Guidance (CFG), en grundpelare också inom stabil diffusion. CFG definierar i grunden i vilken utsträckning modellen är fri att "följa sin fantasi" och utforska renderingsmöjligheterna – eller, vid lägre inställningar, i vilken utsträckning den ska följa indatakällan och göra mindre omfattande eller dramatiska förändringar.

Liksom Textual Inversion (lite mindre med DreamBooth), är UniTune mottaglig för att tillämpa distinkta grafiska stilar på originalbilder, såväl som mer fotorealistiska redigeringar.

Forskarna experimenterade också med SDEdits teknik för "sen start", där systemet uppmuntras att bevara ursprungliga detaljer genom att bara delvis vara "brusfritt" från början, men snarare bibehålla sina väsentliga egenskaper. Även om forskarna bara använde detta på det lägsta lagret (64px), tror de att det kan vara en användbar kompletterande samplingsteknik i framtiden.

Forskarna utnyttjade också prompt-to-prompt som en ytterligare textbaserad teknik för att konditionera modellen:

"I inställningen "prompt to prompt" fann vi att en teknik som vi kallar prompt guidning är särskilt användbar för att stämma trohet och uttrycksfullhet.

"Promptvägledning liknar klassificeringsfri vägledning förutom att baslinjen är en annan prompt istället för den ovillkorade modellen. Detta styr modellen mot deltat mellan de två prompterna."

Men snabb vägledning, uppger författarna, behövdes endast ibland i de fall där CFG inte lyckades uppnå det önskade resultatet.

En annan ny samplingsmetod som man stötte på under utvecklingen av UniTune var interpole, där områden i bilden är tillräckligt distinkta för att både den ursprungliga och den ändrade bilden ska ha mycket lika komposition, vilket möjliggör en mer "naiv" interpolering.

Interpolering kan göra de mer ansträngda processerna i UniTune överflödiga i fall där områden som ska transformeras är diskreta och välavgränsade.

Författarna föreslår att interpolering potentiellt skulle kunna fungera så bra, för ett stort antal målkällbilder, att det skulle kunna användas som standardinställning, och observerar också att det har kraften att åstadkomma extraordinära transformationer i fall där komplexa ocklusioner inte behöver hanteras med mer intensiva metoder.

UniTune kan utföra lokala redigeringar med eller utan redigeringsmasker, men kan också ensidigt bestämma var redigeringar ska placeras, med en ovanlig kombination av tolkningskraft och robust essentialisering av källdata:

I den översta bilden i den andra kolumnen har UniTune, som har till uppgift att infoga ett "rött tåg i bakgrunden", placerat det på en lämplig och autentisk plats. Lägg märke till i de andra exemplen hur semantisk integritet till källbilden bibehålls även mitt i extraordinära förändringar i pixelinnehållet och bildernas kärnstilar.

Latens

Även om den första iterationen av ett nytt system kommer att vara långsam, och även om det är möjligt att antingen samhällsengagemang eller företagsengagemang (det är vanligtvis inte båda) så småningom kommer att snabba upp och optimera en resurskrävande rutin, utför både UniTune och Imagic några ganska stora maskininlärningsmanövrar för att skapa dessa fantastiska redigeringar, och det är tveksamt i vilken utsträckning en sådan resurskrävande process någonsin skulle kunna skalas ner till hushållsbruk, snarare än API-driven åtkomst (även om det senare kan vara mer önskvärt för Google).

För närvarande är resan från inmatning till resultat cirka 3 minuter på en T4 GPU, med cirka 30 sekunder extra för inferens (enligt vilken inferensrutin som helst). Författarna medger att detta är hög latens och knappast kvalificerar som "interaktiv", men de noterar också att modellen förblir tillgänglig för ytterligare redigeringar när den initialt har finjusterats, tills användaren är klar med processen, vilket minskar tiden per redigering.

Första gången publicerad 21 oktober 2022.