Угол Андерсона

На пути к полному контролю над генерацией видео с помощью ИИ

Видеомодели фундаментов, такие как Хуньюань и Ван 2.1, хотя и являются мощными, не предоставляют пользователям тот уровень детального управления, который требуется при производстве фильмов и телепередач (особенно при производстве визуальных эффектов).

В профессиональных студиях визуальных эффектов такие модели с открытым исходным кодом, как и более ранние модели на основе изображений (а не видео), такие как Стабильная диффузия, Кандинский и Поток, как правило, используются вместе с рядом вспомогательных инструментов, которые адаптируют их сырой вывод для удовлетворения конкретных творческих потребностей. Когда режиссер говорит, «Выглядит здорово, но можно ли сделать его немного более [n]?» вы не можете ответить, сказав, что модель недостаточно точна для обработки таких запросов.

Вместо этого команда AI VFX будет использовать ряд традиционных CGI и композиционные методы в сочетании с индивидуальными процедурами и рабочими процессами, разработанными с течением времени, с целью попытаться немного расширить границы видеосинтеза.

Таким образом, по аналогии, базовая видеомодель во многом похожа на установку по умолчанию в веб-браузере, например, Chrome: она многое умеет сразу из коробки, но если вы хотите, чтобы она адаптировалась к вашим потребностям, а не наоборот, вам понадобятся некоторые плагины.

Управление Freaks

В мире диффузионного синтеза изображений наиболее важной сторонней системой является сеть управления.

ControlNet — это метод добавления структурированного управления к генеративным моделям на основе диффузии, позволяющий пользователям управлять генерацией изображений или видео с помощью дополнительных входных данных, таких как карты краёв, карты глубины или поза информация.

Различные методы ControlNet позволяют создавать изображения по глубине (верхний ряд), семантическую сегментацию изображений (внизу слева) и изображения людей и животных с учетом их позы (внизу слева).

Вместо того чтобы полагаться исключительно на текстовые подсказки, ControlNet вводит отдельные ветви нейронной сети, или адаптеры, которые обрабатывают эти сигналы обусловливания, сохраняя при этом генеративные возможности базовой модели.

Это позволяет получать точно настроенные выходные данные, которые более точно соответствуют пользовательским спецификациям, что делает их особенно полезными в приложениях, где требуется точный состав, структура или управление движением:

Используя направляющую позу, через ControlNet можно получить различные типы точных выходных данных. Источник: https://arxiv.org/pdf/2302.05543

Однако, основанные на адаптерах фреймворки такого рода работают извне на наборе нейронных процессов, которые очень внутренне сфокусированы. Эти подходы имеют несколько недостатков.

Во-первых, адаптеры обучаются независимо, что приводит к конфликты ветвей при объединении нескольких адаптеров может ухудшиться качество генерации.

Во-вторых, они вводят избыточность параметров, требуя дополнительных вычислений и памяти для каждого адаптера, что делает масштабирование неэффективным.

В-третьих, несмотря на свою гибкость, адаптеры часто производят неоптимальной Результаты по сравнению с моделями, которые полностью доработаны для генерации многоусловий. Эти проблемы делают методы на основе адаптеров менее эффективными для задач, требующих бесшовной интеграции нескольких сигналов управления.

В идеале возможности ControlNet должны быть обучены изначально в модель, модульным способом, который мог бы включать в себя более поздние и долгожданные очевидные инновации, такие как одновременная генерация видео/аудио или собственные возможности синхронизации губ (для внешнего звука).

На сегодняшний день каждая дополнительная часть функциональности представляет собой либо задачу постпроизводства, либо нестандартную процедуру, которая должна ориентироваться в жестко связанных и чувствительных весах любой базовой модели, на основе которой она работает.

FullDiT

В этом противостоянии появляется новое предложение из Китая, в котором предлагается система, в которой показатели в стиле ControlNet внедряются непосредственно в генеративную видеомодель во время обучения, а не откладываются на потом.

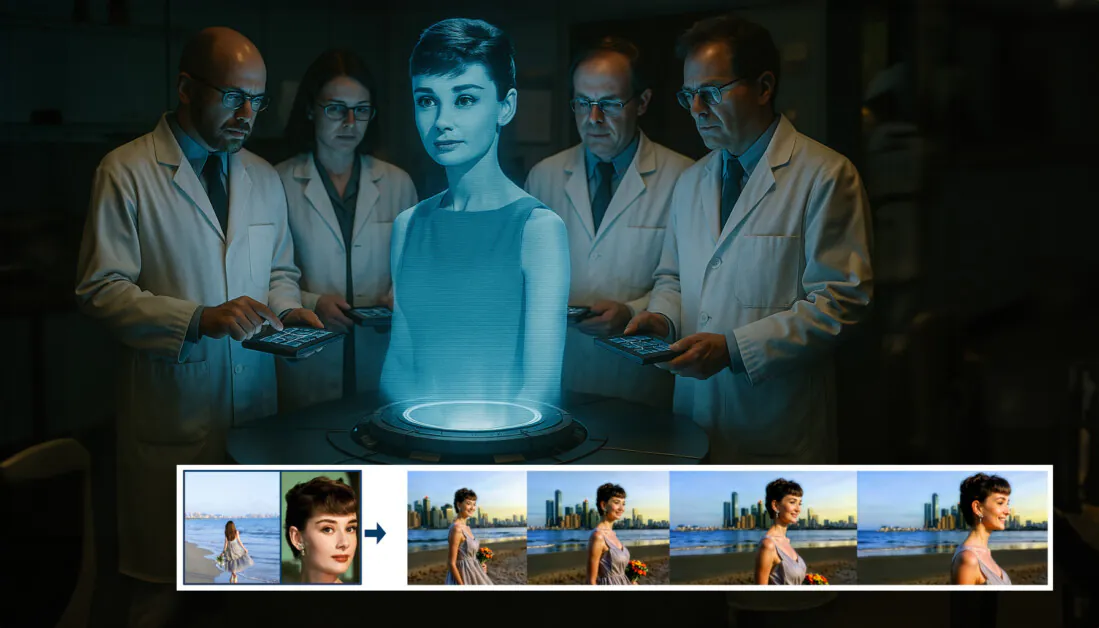

Из новой статьи: подход FullDiT может включать наложение идентичности, глубину и движение камеры в нативную генерацию и может вызывать любую комбинацию из них одновременно. Источник: https://arxiv.org/pdf/2503.19907

Титулованный FullDiT, новый подход объединяет многозадачные условия, такие как передача идентичности, картирование глубины и движение камеры, в интегрированную часть обученной генеративной видеомодели, для которой авторы создали прототип обученной модели и сопровождающие видеоклипы на Сайт проекта.

В примере ниже мы видим генерации, которые включают движение камеры, идентификационную информацию и текстовую информацию (т. е. направляющие текстовые подсказки пользователя):

Нажмите, чтобы играть. Примеры наложения пользователя в стиле ControlNet с использованием только собственной обученной базовой модели. Источник: https://fulldit.github.io/

Следует отметить, что авторы предлагают свою экспериментально обученную модель не в качестве функциональной базовой модели, а скорее как доказательство концепции для собственных моделей преобразования текста в видео (T2V) и изображения в видео (I2V), которые предлагают пользователям больше контроля, чем просто подсказка в виде изображения или текстовая подсказка.

Поскольку подобных моделей пока нет, исследователи создали новый эталон под названием FullBench, для оценки многозадачных видео, и заявляют о передовой производительности в тестах like-for-like, которые они разработали по сравнению с предыдущими подходами. Однако, поскольку FullBench был разработан самими авторами, его объективность не проверена, а его набор данных из 1,400 случаев может быть слишком ограничен для более широких выводов.

Возможно, наиболее интересным аспектом архитектуры, выдвинутой в статье, является ее потенциал для включения новых типов управления. Авторы заявляют:

«В этой работе мы исследуем только условия управления камерой, идентификационные данные и информацию о глубине. Мы не изучали другие условия и модальности, такие как аудио, речь, облако точек, ограничивающие рамки объектов, оптический поток и т. д. Хотя конструкция FullDiT позволяет легко интегрировать другие модальности с минимальными изменениями архитектуры, вопрос о том, как быстро и экономично адаптировать существующие модели к новым условиям и модальности, по-прежнему остаётся важным и требует дальнейшего изучения».

Хотя исследователи представляют FullDiT как шаг вперед в многозадачной генерации видео, следует учитывать, что эта новая работа основывается на существующих архитектурах, а не представляет собой принципиально новую парадигму.

Тем не менее, FullDiT в настоящее время существует отдельно (насколько мне известно) как базовая модель видео с «жестко закодированными» функциями в стиле ControlNet, и приятно видеть, что предлагаемая архитектура может также учитывать и более поздние инновации.

Нажмите, чтобы играть. Примеры управляемых пользователем движений камеры с сайта проекта.

Радиус корня Новый документ называется FullDiT: многозадачная видеогенеративная фундаментальная модель с полным вниманием, и исходит от девяти исследователей из Kuaishou Technology и Китайского университета Гонконга. Страница проекта здесь и новые контрольные данные в Hugging Face.

Способ доставки

Авторы утверждают, что единый механизм внимания FullDiT обеспечивает более эффективное кросс-модальное репрезентативное обучение, фиксируя как пространственные, так и временные отношения в различных условиях:

Согласно новой статье, FullDiT интегрирует множественные условия ввода посредством полного внутреннего внимания, преобразуя их в единую последовательность. Напротив, модели на основе адаптеров (самые левые выше) используют отдельные модули для каждого ввода, что приводит к избыточности, конфликтам и более слабой производительности.

В отличие от адаптерных установок, которые обрабатывают каждый входной поток отдельно, эта общая структура внимания избегает конфликтов ветвей и снижает накладные расходы параметров. Они также утверждают, что архитектура может масштабироваться на новые типы входных данных без серьезной переработки — и что схема модели показывает признаки обобщения для комбинаций условий, не наблюдавшихся во время обучения, таких как связывание движения камеры с идентичностью персонажа.

Нажмите, чтобы играть. Примеры генерации идентичности с сайта проекта.

В архитектуре FullDiT все входные данные обусловливания, такие как текст, движение камеры, идентичность и глубина, сначала преобразуются в единый формат токена. Затем эти токены объединяются в одну длинную последовательность, которая обрабатывается стеком трансформатор слои, использующие полное самовнимание. Этот подход следует предыдущим работам, таким как План Open-Sora и Кинопоколение.

Такая конструкция позволяет модели изучать временные и пространственные отношения совместно во всех условиях. Каждый блок трансформатора работает во всей последовательности, обеспечивая динамическое взаимодействие между модальностями без опоры на отдельные модули для каждого входа – и, как мы уже отметили, архитектура спроектирована так, чтобы быть расширяемой, что значительно упрощает включение дополнительных сигналов управления в будущем без серьезных структурных изменений.

Сила трех

FullDiT преобразует каждый сигнал управления в стандартизированный формат токена, чтобы все условия могли обрабатываться вместе в единой структуре внимания. Для движения камеры модель кодирует последовательность внешних параметров, таких как положение и ориентация, для каждого кадра. Эти параметры имеют временные метки и проецируются в векторы внедрения, которые отражают временную природу сигнала.

Информация об идентичности обрабатывается по-разному, поскольку она по своей сути пространственная, а не временная. Модель использует карты идентичности, которые указывают, какие символы присутствуют в каких частях каждого кадра. Эти карты делятся на патчи, с каждым патчем, проецируемым в вложения который фиксирует пространственные признаки идентичности, позволяя модели связывать определенные области кадра с определенными сущностями.

Глубина — это пространственно-временной сигнал, и модель обрабатывает его, разделяя видео глубины на 3D-патчи, которые охватывают как пространство, так и время. Затем эти патчи встраиваются таким образом, чтобы сохранять свою структуру в кадрах.

После внедрения все эти токены условий (камера, идентификация и глубина) объединяются в одну длинную последовательность, что позволяет FullDiT обрабатывать их вместе, используя полный самостоятельно внимание. Это общее представление позволяет модели изучать взаимодействия между модальностями и во времени, не полагаясь на изолированные потоки обработки.

Данные и тесты

Подход FullDiT к обучению основывался на выборочно аннотированных наборах данных, адаптированных к каждому типу обусловливания, а не на требовании одновременного присутствия всех условий.

Для текстовых условий инициатива следует подходу структурированных субтитров, изложенному в MiraData проект.

Сбор видео и конвейер аннотаций из проекта MiraData. Источник: https://arxiv.org/pdf/2407.06358

Для движения камеры, Недвижимость10 тыс. Основным источником данных был набор данных, поскольку он содержал высококачественные аннотации параметров камеры, соответствующие реальным данным.

Однако авторы заметили, что обучение исключительно на наборах данных камер со статичными сценами, таких как RealEstate10K, имело тенденцию к снижению динамических движений объектов и людей в сгенерированных видео. Чтобы противостоять этому, они провели дополнительную тонкую настройку с использованием внутренних наборов данных, которые включали более динамичные движения камеры.

Аннотации идентификации были созданы с использованием конвейера, разработанного для КонцептМастер проект, который позволил эффективно фильтровать и извлекать подробную идентификационную информацию.

Фреймворк ConceptMaster предназначен для решения проблем разделения идентичности, сохраняя при этом верность концепции в индивидуальных видеороликах. Источник: https://arxiv.org/pdf/2501.04698

Аннотации глубины были получены из Панда-70М набор данных с использованием Глубина Что угодно.

Оптимизация посредством упорядочивания данных

Авторы также внедрили прогрессивную схему обучения, введя более сложные условия. ранее в обучении чтобы гарантировать, что модель приобрела надежные представления, прежде чем будут добавлены более простые задачи. Порядок обучения исходил из текст в камера условия, то тождества, и наконец глубина, причем более легкие задания обычно вводятся позже и с меньшим количеством примеров.

Авторы подчеркивают ценность упорядочивания рабочей нагрузки следующим образом:

«Во время фазы предварительного обучения мы отметили, что более сложные задачи требуют более длительного времени обучения и должны быть введены на более ранних этапах процесса обучения. Эти сложные задачи включают в себя сложные распределения данных, которые значительно отличаются от выходного видео, требуя от модели достаточной мощности для их точного захвата и представления.

«И наоборот, слишком раннее введение более простых задач может привести к тому, что модель отдаст приоритет их изучению в первую очередь, поскольку они обеспечивают более быструю обратную связь по оптимизации, что препятствует решению более сложных задач».

Иллюстрация порядка обучения данных, принятого исследователями, где красный цвет обозначает больший объем данных.

После первоначального предварительного обучения, заключительный этап тонкой настройки еще больше усовершенствовал модель для улучшения визуального качества и динамики движения. После этого обучение следовало стандартному фреймворку диффузии*: шум добавлялся к латентным сигналам видео, и модель научиться предсказывать и устранять его, используя встроенные токены условий в качестве руководства.

Для эффективной оценки FullDiT и обеспечения справедливого сравнения с существующими методами, а также в отсутствие какого-либо другого подходящего эталона, авторы ввели FullBench, тщательно отобранный набор тестов, состоящий из 1,400 различных тестовых случаев.

Экземпляр обозревателя данных для нового бенчмарка FullBench. Источник: https://huggingface.co/datasets/KwaiVGI/FullBench

Каждая точка данных содержала аннотации истинности для различных сигналов обусловливания, включая движение камеры, личность и глубина.

Метрика

Авторы оценили FullDiT, используя десять показателей, охватывающих пять основных аспектов производительности: выравнивание текста, управление камерой, сходство идентичности, точность глубины и общее качество видео.

Выравнивание текста измерялось с помощью сходство CLIP, в то время как управление камерой оценивалось посредством ошибка вращения (РотЭрр), ошибка перевода (ТрансЭрр), а также расширение согласованность движения камеры (CamMC), следуя подходу CamI2V (в КамераCtrl проект).

Сходство идентичности оценивалось с использованием ДИНО-I и КЛИП-I, и точность контроля глубины была количественно определена с использованием Средняя абсолютная ошибка (МАЭ).

Качество видео оценивалось по трем показателям от MiraData: сходство CLIP на уровне кадров для плавности; расстояние движения на основе оптического потока для динамики; и LAION-Эстетические оценки для визуальной привлекательности.

Обучение

Авторы обучили FullDiT, используя внутреннюю (нераскрытую) модель диффузии текста в видео, содержащую около миллиарда параметров. Они намеренно выбрали скромный размер параметра, чтобы сохранить справедливость в сравнении с предыдущими методами и обеспечить воспроизводимость.

Поскольку обучающие видео различались по длине и разрешению, авторы стандартизировали каждое партия путем изменения размера и подгонки видео под общее разрешение, выборки 77 кадров на последовательность и использования прикладного внимания и маски потери для оптимизации эффективности обучения.

Радиус корня Адам оптимизатор был использован в скорость обучения 1 × 10-5 в кластере из 64 графических процессоров NVIDIA H800, что в совокупности составляет 5,120 ГБ видеопамяти (учитывайте, что в сообществах энтузиастов, занимающихся синтезом, 24GB на RTX 3090 по-прежнему считается роскошным стандартом).

Модель обучалась примерно 32,000 20 шагов, включая до трех идентификаторов на видео, а также 21 кадров условий камеры и 77 кадр условий глубины, которые равномерно выбирались из XNUMX кадров.

Для вывода модель генерировала видео с разрешением 384×672 пикселей (примерно пять секунд при 15 кадрах в секунду) с 50 шагами диффузионного вывода и шкалой руководства без классификатора, равной пяти.

Предшествующие методы

Для оценки передачи данных с камеры на видео авторы сравнили FullDiT с ДвижениеCtrl, CameraCtrl и CamI2V, причем все модели были обучены с использованием набора данных RealEstate10k для обеспечения согласованности и справедливости.

При генерации с учетом идентичности, поскольку сопоставимых моделей множественной идентичности с открытым исходным кодом не было, модель сравнивалась с 1B-параметрической моделью ConceptMaster с использованием тех же обучающих данных и архитектуры.

Для задач глубины видео сравнения проводились с Ctrl-Адаптер и УправлениеВидео.

Количественные результаты для однозадачной генерации видео. FullDiT сравнивался с MotionCtrl, CameraCtrl и CamI2V для генерации с камеры на видео; ConceptMaster (версия параметра 1B) для идентичности на видео; и Ctrl-Adapter и ControlVideo для глубины на видео. Все модели оценивались с использованием их настроек по умолчанию. Для согласованности из каждого метода равномерно выбиралось 16 кадров, что соответствовало выходной длине предыдущих моделей.

Результаты показывают, что FullDiT, несмотря на одновременную обработку нескольких сигналов кондиционирования, достигла высочайшей производительности по показателям, связанным с текстом, движением камеры, идентификацией и контролем глубины.

По общим показателям качества система в целом превзошла другие методы, хотя её плавность была несколько ниже, чем у ConceptMaster. Авторы отмечают:

«Гладкость FullDiT немного ниже, чем у ConceptMaster, поскольку расчет плавности основан на сходстве CLIP между соседними кадрами. Поскольку FullDiT демонстрирует значительно большую динамику по сравнению с ConceptMaster, на метрику плавности влияют большие различия между соседними кадрами.

«Что касается эстетической оценки, то, поскольку рейтинговая модель отдает предпочтение изображениям в стиле живописи, а ControlVideo обычно генерирует видеоролики в этом стиле, она получает высокую оценку по эстетике».

Что касается качественного сравнения, то, возможно, предпочтительнее будет обратиться к примерам видео на сайте проекта FullDiT, поскольку примеры в формате PDF неизбежно статичны (и слишком велики, чтобы полностью воспроизвести их здесь).

Первый раздел качественных результатов в PDF. Пожалуйста, обратитесь к исходной статье за дополнительными примерами, которые слишком обширны, чтобы воспроизвести их здесь.

Авторы комментируют:

«FullDiT демонстрирует превосходное сохранение идентичности и генерирует видео с лучшей динамикой и визуальным качеством по сравнению с [ConceptMaster]. Поскольку ConceptMaster и FullDiT обучаются на одной и той же основе, это подчеркивает эффективность инъекции условий с полным вниманием.

«…[Другие] результаты демонстрируют превосходную управляемость и качество генерации FullDiT по сравнению с существующими методами преобразования глубины в видео и передачи данных с камеры на видео».

Фрагмент PDF-файла с примерами вывода FullDiT с несколькими сигналами. Дополнительные примеры см. в исходной статье и на сайте проекта.

Заключение

Хотя FullDiT — это захватывающий шаг в сторону более полнофункциональной модели видеоосновы, возникает вопрос, оправдает ли спрос на инструменты в стиле ControlNet когда-либо реализацию таких функций в больших масштабах, по крайней мере, для проектов FOSS, которым было бы сложно получить необходимую огромную вычислительную мощность GPU без коммерческой поддержки.

Основная проблема заключается в том, что использование таких систем, как Depth and Pose, обычно требует нетривиального знакомства с относительно сложными пользовательскими интерфейсами, такими как ComfyUI. Поэтому кажется, что функциональная модель FOSS такого рода, скорее всего, будет разработана группой небольших компаний VFX, у которых нет денег (или желания, учитывая, что такие системы быстро устаревают из-за обновлений моделей) для курирования и обучения такой модели за закрытыми дверями.

С другой стороны, системы «аренды ИИ» на основе API могут быть хорошо мотивированы на разработку более простых и удобных для пользователя методов интерпретации для моделей, которым вспомогательные системы управления были напрямую обучены.

Нажмите, чтобы играть. Элементы управления «Глубина+Текст», наложенные на генерацию видео с использованием FullDiT.

* Авторы не указывают какую-либо известную базовую модель (например, SDXL и т. д.)

Впервые опубликовано Четверг, 27 марта 2025 г.