Artificial Intelligence

Разделение «слитых» людей в компьютерном зрении

В новой статье Инновационного центра Hyundai Motor Group в Сингапуре предлагается метод разделения «слитых» людей с помощью компьютерного зрения – тех случаев, когда система распознавания объектов обнаруживает человека, который в каком-то смысле «слишком близок» к другому человеку (например, как действия «обнимания» или позы «стояния позади») и не может распутать двух изображенных людей, путая их с одним человеком или сущностью.

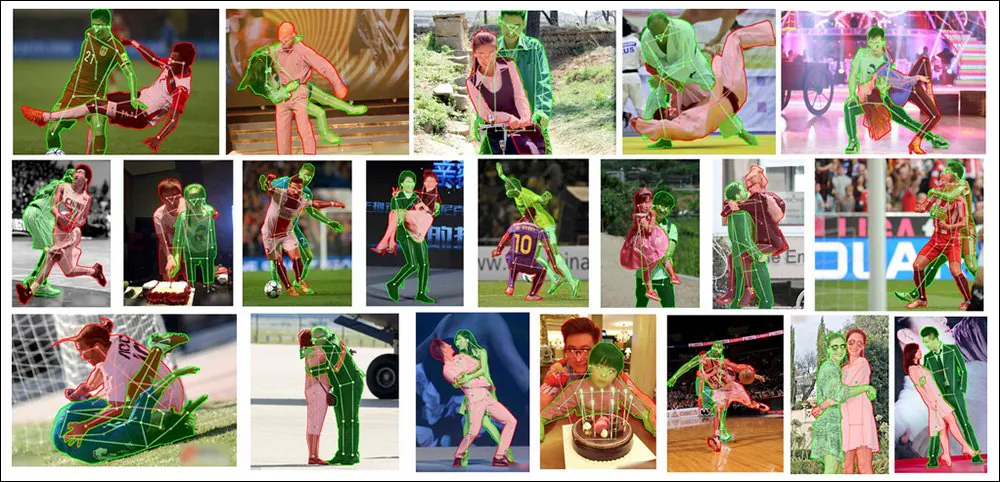

Два становятся одним, но в семантической сегментации это не очень хорошо. Здесь мы видим, как новая система статьи достигает передовых результатов в индивидуализации переплетенных людей в сложных и вызывающих образах. Источник: https://arxiv.org/pdf/2210.03686.pdf

Это серьезная проблема, которой в последние годы уделяется большое внимание в научном сообществе. Решение этой проблемы без очевидных, но обычно неподъемных затрат на гипермасштабируемую пользовательскую маркировку под руководством человека может в конечном итоге позволить улучшить человеческую индивидуализацию в системах преобразования текста в изображение, таких как Стабильная диффузия, которые часто «сливают» людей вместе, когда поза с подсказкой требует, чтобы несколько человек находились в непосредственной близости друг от друга.

Примите ужас — модели преобразования текста в изображение, такие как DALL-E 2 и Stable Diffusion (оба представлены выше), изо всех сил пытаются представить людей, находящихся в непосредственной близости друг от друга.

Хотя генеративные модели, такие как DALL-E 2 и Stable Diffusion, в настоящее время не используют семантическую сегментацию или распознавание объектов (насколько известно, в случае DALL-E 2 с закрытым исходным кодом), эти гротескные человеческие чемоданы не могут в настоящее время можно вылечить, применяя такие восходящие методы, потому что современные библиотеки и ресурсы распознавания объектов не намного лучше распутывают людей, чем CLIPна основе рабочих процессов моделей скрытой диффузии.

Для решения этой проблемы был Новый документ - под названием Людям не нужно маркировать больше людей: копирование и вставка окклюзии для сегментации экземпляра окклюзии человека– адаптирует и совершенствует недавний подход «вырезать и вставить» к полусинтетическим данным, чтобы добиться нового лидерства SOTA в решении задачи, даже при работе с самым сложным исходным материалом:

Новая методология копирования и вставки окклюзии в настоящее время лидирует даже по сравнению с предыдущими фреймворками и подходами, которые решают проблему более сложными и специализированными способами, такими как специальное моделирование окклюзии.

Вырежьте это!

Измененный метод под названием Окклюзия Копировать и вставить – получено из 2021 г. Простое копирование-вставка документ, подготовленный Google Research, в котором предполагалось, что наложение извлеченных объектов и людей на различные исходные обучающие изображения может улучшить способность системы распознавания изображений дискретизировать каждый экземпляр, найденный на изображении:

Из статьи 2021 года под руководством Google Research «Простое копирование-вставка — надежный метод увеличения данных для сегментации экземпляров» мы видим, что элементы с одной фотографии «мигрируют» на другие фотографии с целью обучения лучшей модели распознавания изображений. Источник: https://arxiv.org/pdf/2012.07177.pdf

Новая версия добавляет ограничения и параметры в эту автоматическую и алгоритмическую «повторную вставку», превращая процесс в «корзину» изображений, полную потенциальных кандидатов для «переноса» в другие изображения на основе нескольких ключевых факторов.

Концептуальный рабочий процесс для OC&P.

Управление элементами

Эти ограничивающие факторы включают вероятность происходящего вырезания и вставки, что гарантирует, что процесс не происходит постоянно, что привело бы к эффекту «насыщения», который подорвал бы увеличение данных; в количество изображений что корзина будет иметь в любой момент времени, где большее количество «сегментов» может улучшить разнообразие экземпляров, но увеличить время предварительной обработки; и ассортимент, который определяет количество изображений, которые будут вставлены в «основное» изображение.

Что касается последнего, в документе отмечается «Нам нужно достаточно окклюзии, но не слишком много, поскольку они могут чрезмерно загромождать изображение, что может нанести ущерб обучению».

Две другие инновации для OC&P: целенаправленная вставка и расширенная вставка экземпляров.

Целевая вставка гарантирует, что подходящее изображение окажется рядом с существующим экземпляром в целевом изображении. В предыдущем подходе из предыдущей работы новый элемент ограничивался только границами изображения без учета контекста.

Хотя эта «вставка» с целенаправленной вставкой очевидна для человеческого глаза, как OC&P, так и ее предшественник обнаружили, что повышенная визуальная достоверность не обязательно важна и даже может быть помехой (см. «Укусы реальности» ниже).

Расширенная вставка экземпляров, с другой стороны, гарантирует, что вставленные экземпляры не будут демонстрировать «отличительный вид», который может в конечном итоге классифицироваться системой каким-либо образом, что может привести к исключению или «специальному обращению», что может затруднить обобщение и применимость. . Расширенная вставка модулирует визуальные факторы, такие как яркость и резкость, масштабирование и поворот, а также насыщенность — среди прочих факторов.

Из дополнительных материалов к новой статье: добавление OC&P к существующим системам распознавания довольно тривиально и приводит к превосходной индивидуализации людей в очень тесном контакте. Источник: https://arxiv.org/src/2210.03686v1/anc/OcclusionCopyPaste_Supplementary.pdf

Кроме того, OC&P регулирует минимальный размер для любого вставленного экземпляра. Например, можно извлечь изображение одного человека из массовой сцены, которое можно вставить в другое изображение, но в таком случае малое количество задействованных пикселей вряд ли поможет распознаванию. Поэтому система применяет минимальный масштаб, основанный на соотношении выровненной длины стороны для целевого изображения.

Кроме того, OC&P вводит вставку с учетом масштаба, при которой помимо поиска объектов, похожих на объект вставки, учитывается размер ограничительных рамок в целевом изображении. Однако это не приводит к составным изображениям, которые люди сочтут правдоподобными или реалистичными (см. изображение ниже), а скорее собирает семантически соответствующие элементы рядом друг с другом способами, которые полезны во время обучения.

Реальность кусается

Как предыдущая работа, на которой основан OC&P, так и текущая реализация придают низкое значение подлинности или «фотореалистичности» любого окончательного «смонтированного» изображения. Хотя важно, чтобы окончательная сборка не сводилась полностью к Дадаизм (иначе реальные развертывания обученных систем никогда не могли бы надеяться встретить элементы в таких сценах, на которых они были обучены), обе инициативы обнаружили, что заметное увеличение «визуальной достоверности» не только увеличивает время предварительной обработки, но и что такие «улучшения реализма», вероятно, на самом деле будут контрпродуктивными.

Из дополнительного материала к новой статье: примеры дополненных изображений со «случайным смешиванием». Хотя эти сцены могут показаться человеку галлюциногенными, они, тем не менее, имеют сходные сюжеты; хотя окклюзии фантастичны для человеческого глаза, природа потенциальной окклюзии не может быть известна заранее и не поддается обучению, поэтому таких причудливых «отсечений» формы достаточно, чтобы заставить обученную систему искать и распознавать частичные целевые объекты без необходимости разработки сложных методологий в стиле Photoshop, чтобы сделать сцены более правдоподобными.

Данные и тесты

На этапе тестирования система была обучена на человек класс МС КОКО набор данных, включающий 262,465 64,115 примеров людей на XNUMX XNUMX изображениях. Однако для получения более качественных масок, чем у MS COCO, изображения также получали ЛВИС маскировать аннотации.

Выпущенный в 2019 году LVIS, основанный на исследовании Facebook, представляет собой объемный набор данных для сегментации экземпляров большого словаря. Источник: https://arxiv.org/pdf/1908.03195.pdf

Чтобы оценить, насколько хорошо дополненная система сможет противостоять большому количеству скрытых человеческих изображений, исследователи сравнили OC&P с OCЧеловек (Окклюдированный человек) эталон.

Примеры из набора данных OCHuman, представленного в поддержку проекта обнаружения Pose2Seg в 2018 году. Эта инициатива была направлена на улучшение семантической сегментации людей с использованием их положения и позы в качестве семантического ограничителя для пикселей, представляющих их тела. Источник: https://github.com/liruilong940607/OCHumanApi

Поскольку эталонный тест OCHuman не имеет исчерпывающих аннотаций, исследователи новой статьи создали подмножество только тех примеров, которые были полностью помечены, под названием OCHuman.FL. Это уменьшило количество человек экземпляров до 2,240 на 1,113 изображениях для проверки и 1,923 экземпляров на 951 фактических изображениях, используемых для тестирования. Как исходные, так и новые наборы были протестированы с использованием средней средней точности (mAP) в качестве основного показателя.

Для согласованности архитектура была сформирована из Маска R-CNN с магистралью ResNet-50 и пирамида признаков сети, причем последний обеспечивает приемлемый компромисс между точностью и скоростью обучения.

Поскольку исследователи отметили пагубное влияние восходящего потока IMAGEnet влияние в подобных ситуациях, вся система была обучена с нуля на 4 графических процессорах NVIDIA V100, в течение 75 эпох, в соответствии с параметрами инициализации выпуска Facebook 2021 года. Дететрон 2.

Итоги

В дополнение к вышеупомянутым результатам, исходные результаты против ММобнаружение (и три связанные с ним модели) для тестов показали явное лидерство OC&P в его способности выбирать людей из замысловатых поз.

Помимо превосходства PoSeg и Поза2Сег, возможно, одним из самых выдающихся достижений статьи является то, что систему можно довольно широко применять к существующим платформам, в том числе к тем, которые противопоставлялись ей в ходе испытаний (см. статья).

В статье делается вывод:

«Ключевым преимуществом нашего подхода является то, что его легко применять с любыми моделями или другими улучшениями, ориентированными на модели. Учитывая скорость, с которой развивается область глубокого обучения, всем выгодно иметь подходы, которые хорошо совместимы со всеми остальными аспектами обучения. Мы оставляем в качестве будущей работы интеграцию этого с улучшениями, ориентированными на модель, для эффективного решения проблемы сегментации закрытых экземпляров человека».

Потенциал улучшения синтеза текста в изображение

Ведущий автор Эван Линг заметил в электронном письме к нам*, что главное преимущество OC&P заключается в том, что он может сохранять исходные метки масок и получать от них новое значение «бесплатно» в новом контексте, т. е. изображения, которые они вклеил в.

Хотя семантическая сегментация людей, по-видимому, тесно связана с трудностями, с которыми сталкиваются такие модели, как Stable Diffusion, при индивидуализации людей (вместо того, чтобы «смешивать их вместе», как это часто бывает), любое влияние, которое культура семантических ярлыков может оказать на кошмарное человеческое визуализирует, что SD и DALL-E 2 часто выводят очень и очень далеко вверх по течению.

Миллиарды ЛАИОН 5Б изображения подмножества, которые заполняют генеративную мощность Stable Diffusion, не содержат меток на уровне объектов, таких как ограничивающие рамки и маски экземпляров, даже если архитектура CLIP, которая составляет рендеры из изображений и содержимого базы данных, могла в какой-то момент выиграть от такого создания экземпляров; скорее, изображения LAION помечены как «бесплатные», поскольку их метки были получены из метаданных и подписей к окружающей среде и т. д., которые были связаны с изображениями, когда они были извлечены из Интернета в набор данных.

— Но это в сторону, — сказал нам Линг. «Во время обучения генеративной модели преобразования текста в изображение можно использовать своего рода дополнение, похожее на наш OC&P. Но я думаю, что реализм расширенного тренировочного изображения может стать проблемой.

«В нашей работе мы показываем, что «идеальный» реализм, как правило, не требуется для контролируемой сегментации экземпляров, но я не слишком уверен, можно ли сделать такой же вывод для обучения генеративной модели преобразования текста в изображение (особенно когда их выходные данные ожидаются весьма реалистичными). В этом случае может потребоваться дополнительная работа с точки зрения «улучшения» реализма дополненных изображений».

КЛИП уже используется как возможный мультимодальный инструмент для семантической сегментации, предполагая, что улучшенные системы распознавания людей и индивидуации, такие как OC&P, в конечном итоге могут быть преобразованы во внутрисистемные фильтры или классификаторы, которые будут произвольно отвергать «слитные» и искаженные человеческие представления - задача, которую трудно решить. в настоящее время со стабильной диффузией, потому что у него ограниченная способность понять, где он ошибся (если бы у него была такая способность, он, вероятно, не допустил бы ошибки в первую очередь).

Это всего лишь один из множества проектов, в настоящее время использующих инфраструктуру OpenAI CLIP — основу DALL-E 2 и Stable Diffusion — для семантической сегментации. Источник: https://openaccess.thecvf.com/content/CVPR2022/papers/Wang_CRIS_CLIP-Driven_Referring_Image_Segmentation_CVPR_2022_paper.pdf

— Другой вопрос, — предлагает Линг. «Будет ли просто кормить эти генеративные модели изображениями закрытых людей во время тренировочной работы без дополнительного проектирования архитектуры модели, чтобы смягчить проблему «слияния людей»? Вероятно, это вопрос, на который трудно ответить небрежно. Определенно будет интересно посмотреть, как мы можем внедрить какое-то руководство на уровне экземпляра (через метки уровня экземпляра, такие как маска экземпляра) во время обучения генеративной модели преобразования текста в изображение ».

* 10 октября 2022 г.

Впервые опубликовано 10 октября 2022 г.