Искусственный интеллект

Повышение производительности машинного обучения за счет изменения размера изображения на основе CNN

Компания Google Research предложила новый метод повышения эффективности и точности рабочих процессов обучения компьютерному зрению на основе изображений за счет улучшения способа сжатия изображений в наборе данных на этапе предварительной обработки.

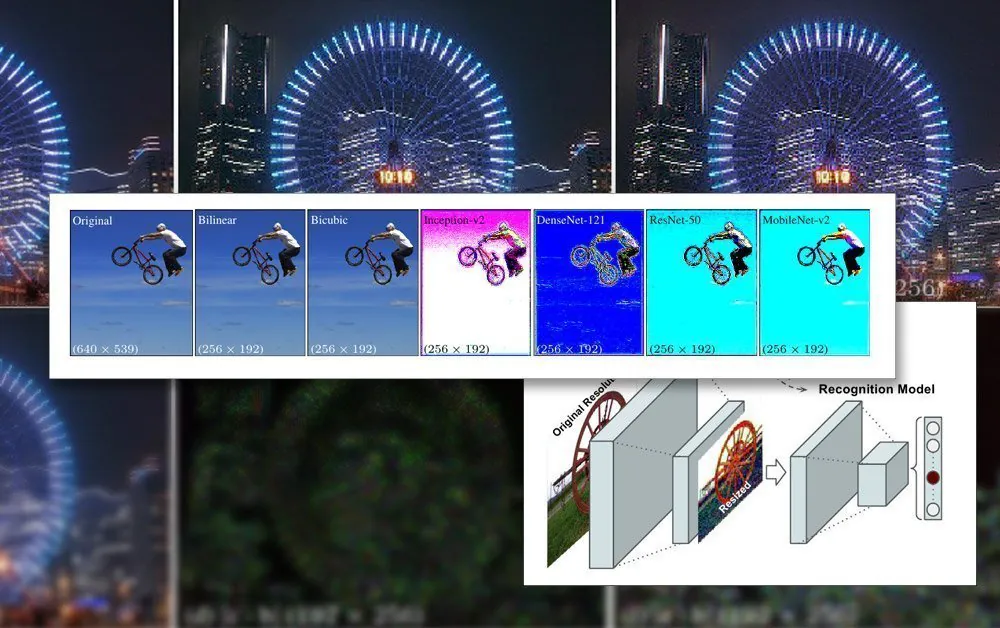

В статье Обучение изменению размера изображений для задач компьютерного зрения, исследователи Хоссейн Талеби и Пейман Миланфар используют CNN для создания новой гибридной архитектуры изменения размера изображения, которая обеспечивает заметное улучшение результатов распознавания, полученных по четырем популярным наборам данных компьютерного зрения.

Предлагаемая совместная структура для распознавания и изменения размера. Источник: https://arxiv.org/pdf/2103.09950.pdf

В документе отмечается, что методы масштабирования/изменения размера, которые в настоящее время используются в конвейерах автоматизированного машинного обучения, устарели на десятилетия и часто используют только базовые билинейные, бикубические методы и методы ближайшего соседа. изменение размера – методы, обрабатывающие все пиксели без разбора.

В противоположность этому предлагаемый метод дополняет данные изображения с помощью сверточной нейронной сети и включает эти данные в измененные изображения, которые в конечном итоге пройдут через архитектуру модели.

Ограничения изображения в обучении ИИ

Чтобы обучить модель, работающую с изображениями, система машинного обучения будет включать в себя этап предварительной обработки, на котором разрозненные изображения разных размеров, цветовых пространств и разрешений (которые будут способствовать набору обучающих данных) систематически обрезаются и изменен размер до согласованных размеров и стабильного единого формата.

Как правило, это потребует некоторого компромисса, основанного на формате PNG, где будет установлен компромисс между временем/ресурсами обработки, размером файла и качеством изображения.

В большинстве случаев конечные размеры обработанного изображения очень малы. Ниже мы видим пример изображения с разрешением 80×80, на котором изображены некоторые из самых ранних наборов данных дипфейков. были созданы:

Поскольку лица (и другие возможные объекты) редко соответствуют требуемому квадратному соотношению, возможно, потребуется добавить черные полосы (или оставить пустое пространство) для гомогенизации изображений, что еще больше сократит фактические используемые данные изображения:

Здесь лицо было извлечено из большей области изображения, пока оно не обрезано максимально экономно, чтобы включить всю область лица. Однако, как видно справа, большая часть оставшейся области не будет использоваться во время обучения, что придает больший вес важности качества изображения данных с измененным размером.

Поскольку возможности графического процессора в последние годы улучшились, с новым поколением карт NVIDIA, оснащенных увеличивающиеся суммы видеопамяти (VRAM), средний размер изображения начинает увеличиваться, хотя 224×224 пикселя все еще довольно стандартны (например, это размер видеопамяти). RESNET-50 набор данных).

Изображение без размера 224×244 пикселей.

Размещение пакетов в VRAM

Причина, по которой все изображения должны быть одинакового размера, заключается в том, что градиентный спуск, метод, с помощью которого модель улучшается с течением времени, требует единообразных обучающих данных.

Причина, по которой изображения должны быть такими маленькими, заключается в том, что они должны загружаться (полностью распаковываться) в VRAM во время обучения небольшими партиями, обычно от 6 до 24 изображений в партии. Слишком мало изображений в партии и недостаточно группового материала для хорошего обобщения, кроме того, это увеличивает время обучения; слишком много, и модель может не получить необходимых характеристик и деталей (см. ниже).

Этот раздел «живой загрузки» архитектуры обучения называется скрытое пространство. Здесь признаки многократно извлекаются из одних и тех же данных (т. е. одних и тех же изображений) до тех пор, пока модель не сойдется в состояние, в котором у нее есть все обобщенные знания, необходимые для выполнения преобразований более поздних, невидимых данных аналогичного типа.

Этот процесс обычно занимает несколько дней, хотя для достижения полезного обобщения может потребоваться даже месяц или больше постоянных и неустанных размышлений в большом объеме в режиме 24/7. Увеличение размера видеопамяти полезно только до определенного момента, так как даже незначительное увеличение разрешения изображения может иметь эффект порядка величины на производительность обработки и связанное с этим влияние на точность, которое не всегда может быть благоприятным.

Использование большей емкости видеопамяти для размещения пакетов большего размера также является неоднозначным благом, так как более высокие скорости обучения, полученные при этом, вероятно, будет компенсировано по менее точным результатам.

Поэтому, поскольку архитектура обучения настолько ограничена, все, что может привести к улучшению в рамках существующих ограничений конвейера, является заметным достижением.

Как превосходное сокращение помогает

Было доказано, что максимальное качество изображения, которое будет включено в набор данных для обучения, улучшает результат обучения, особенно в задачах распознавания объектов. В 2018 году исследователи из Института интеллектуальных систем Макса Планка утверждало что выбор метода повторной выборки заметно влияет на эффективность и результаты обучения.

Кроме того, предыдущая работа Google (в соавторстве с авторами новой статьи) показала, что точность классификации можно улучшить, поддержание контроля артефакты сжатия в изображениях набора данных.

Модель CNN, встроенная в новый ресэмплер, сочетает в себе билинейное изменение размера с функцией «пропуска соединения», которая позволяет включать выходные данные обученной сети в измененное изображение.

В отличие от типичной архитектуры кодера/декодера, новое решение может выступать не только в качестве узкого места прямой связи, но и в качестве обратного узкого места для масштабирования до любого целевого размера и/или соотношения сторон. Кроме того, «стандартный» метод ресемплинга можно заменить любым другим подходящим традиционным методом, например, методом Ланцоша.

Детали высоких частот

Новый метод создаёт изображения, которые, по сути, «впечатывают» ключевые особенности (которые в конечном итоге будут распознаны в процессе обучения) непосредственно в исходное изображение. С эстетической точки зрения результаты нетрадиционны:

Новый метод применялся в четырех сетях — Inception V2; Денсенет-121; Реснет-50; и Мобайлнет-V2. В результате применения метода понижения дискретизации/изменения размера изображения Google Research получаются изображения с очевидным агрегированием пикселей, предвосхищая ключевые особенности, которые будут обнаружены в процессе обучения.

Исследователи отмечают, что эти первоначальные эксперименты оптимизированы исключительно для задач распознавания изображений, и что в ходе испытаний их метод «обученного изменения размера» на основе сверточных нейронных сетей (CNN) смог добиться снижения уровня ошибок в таких задачах. В будущем исследователи планируют применить этот метод к другим типам приложений компьютерного зрения, основанных на обработке изображений.