Inteligência artificial

O teto de 75%: os modelos de IA atingiram o desempenho máximo com os métodos atuais?

Antrópico e OpenAI revelou modelos de IA de ponta com dois dias de diferença, com ambos alcançando precisão praticamente idêntica de 74-75% em benchmarks de codificação do setor, sinalizando um teto de desempenho potencial para arquiteturas de IA atuais, ao mesmo tempo em que adotam abordagens drasticamente diferentes para distribuição e implementação.

Os lançamentos quase simultâneos levantam questões fundamentais sobre se o desenvolvimento de IA atingiu um patamar com os métodos de treinamento atuais, mesmo que as empresas divergem drasticamente sobre como fornecer esses recursos aos usuários e desenvolvedores no mundo todo.

Pontos de convergência de referência para marco técnico

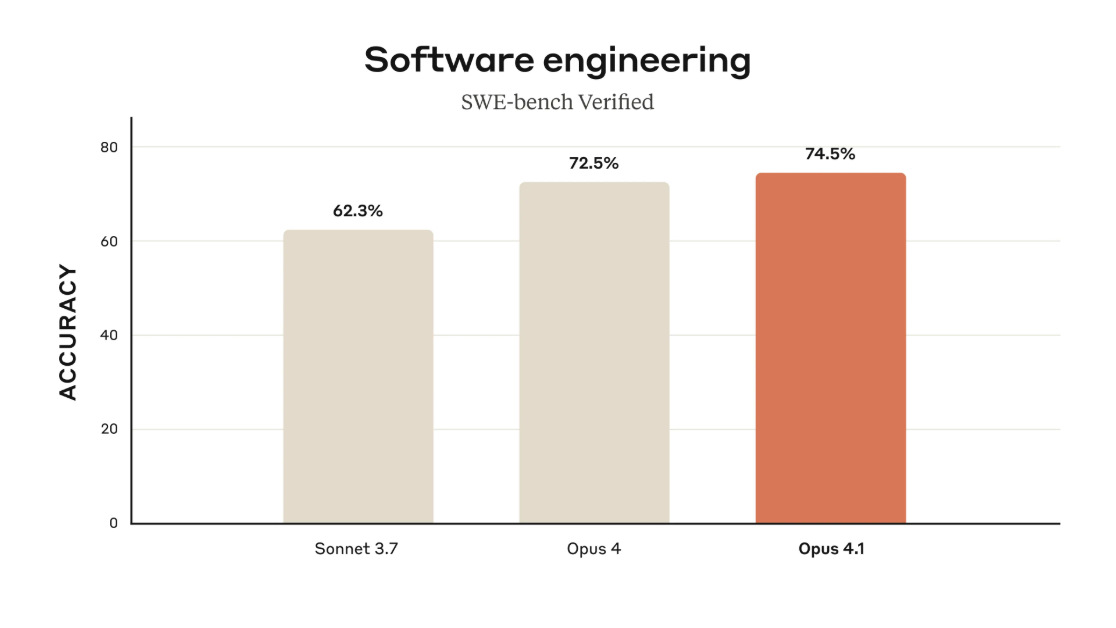

Claude Opus 4.1, lançado em 5 de agosto pela Anthropic, obteve 74.5% no SWE-bench Verified, o benchmark de codificação padrão do setor. GPA-5 do OpenAI, anunciado em 7 de agosto, alcançou 74.9% no mesmo teste — um empate estatístico que sugere que ambas as empresas levaram as arquiteturas atuais a limites semelhantes, apesar de trabalharem de forma independente.

A diferença de 0.4% entre os modelos está dentro da margem de ruído estatístico para tais benchmarks.

As abordagens arquitetônicas, no entanto, divergem significativamente. OpenAI construiu GPT-5 Como um sistema multimodelo com roteamento inteligente — as consultas são direcionadas a respondedores rápidos para tarefas simples, modelos de raciocínio para problemas complexos ou miniversões quando os limites de computação são atingidos. A Anthropic manteve uma abordagem de modelo único com o Opus 4.1, priorizando a consistência em vez da otimização especializada.

Fonte: Anthropic

Estratégias de distribuição revelam filosofias concorrentes

A OpenAI disponibilizou o GPT-5 imediatamente para todos os usuários do ChatGPT, incluindo aqueles na versão gratuita, alcançando aproximadamente 700 milhões de usuários ativos semanais sem custo algum. A Microsoft integrou o modelo simultaneamente nas plataformas GitHub Copilot, Visual Studio Code, M365 Copilot e Azure.

A Anthropic mantém restrições de acesso mais tradicionais, oferecendo Opus 4.1 para usuários pagos do Claude, por meio do Claude Code para desenvolvedores e via acesso à API. A empresa parece focada em atender desenvolvedores e empresas que exigem desempenho confiável e consistente, em vez de maximizar o alcance da distribuição.

O preço do GPT-5 é agressivo, com desenvolvedores observando taxas favoráveis de custo-capacidade que podem pressionar os concorrentes a ajustar suas estratégias de preços.

As demandas de infraestrutura remodelam a economia da indústria

Os requisitos computacionais revelam a escala massiva do desenvolvimento da IA de fronteira. A OpenAI supostamente mantém uma Contrato anual de US$ 30 bilhões com a Oracle para capacidade, tendo treinado GPT-5 no Microsoft Azure usando GPUs NVIDIA H200. A Meta anunciou planos de gastar US$ 72 bilhões em infraestrutura de IA somente em 2025.

Ambas as empresas relatam melhorias significativas em aplicações práticas, além dos benchmarks brutos. A OpenAI afirma que o GPT-5 demonstra "aproximadamente 45% menos erros do que o GPT-4o" quando a pesquisa na web está habilitada, com o modo de raciocínio alcançando resultados semelhantes ao seu modelo o3, utilizando de 50% a 80% menos tokens — um ganho substancial de eficiência.

Relatórios do GitHub Opus 4.1 mostra “ganhos de desempenho notáveis na refatoração de código de vários arquivos”, enquanto o Cursor, um popular assistente de codificação de IA, descreve o GPT-5 como “notavelmente inteligente e fácil de controlar”, de acordo com a documentação do desenvolvedor do OpenAI.

Fonte: OpenAI

Teto técnico sugere mudança de paradigma à frente

A convergência de métricas de desempenho semelhantes entre as empresas sugere que os paradigmas atuais de treinamento podem estar se aproximando de seus limites. Vários modelos agrupam-se em torno de 74-75% de precisão em benchmarks de codificação indica que as próximas grandes melhorias podem exigir inovações fundamentais em vez de escalonamento incremental.

As compensações arquitetônicas entre o complexo sistema de roteamento da OpenAI e Abordagem unificada da Anthropic refletem filosofias diferentes sem um vencedor claro. O sistema multimodelo do GPT-5 oferece flexibilidade, mas apresenta potenciais pontos de falha, enquanto a consistência de Claude pode sacrificar o desempenho especializado em prol da confiabilidade.

A democratização dos recursos de ponta da IA — com recursos que custavam milhares de dólares por ano há dois anos, agora disponíveis gratuitamente — acelera a adoção em todos os setores. Essa transição da IA como serviço premium para infraestrutura de utilidade pública pode possibilitar categorias inteiramente novas de aplicações.

Implicações de mercado e próximos passos

Observadores da indústria esperam que a Anthropic responda à estratégia de preços da OpenAI, embora provavelmente não por meio de correspondência direta de preços. DeepMind do Google e a Meta, relativamente quieta durante esses anúncios, deve fazer movimentos nos próximos meses.

O intervalo de 48 horas entre os lançamentos revelou a transição da IA de tecnologia experimental para infraestrutura confiável. Quando várias empresas alcançam pontuações de referência quase idênticas com diferenças percentuais fracionárias, a competição se volta para eficiência de implantação, qualidade de integração e confiabilidade do serviço.

As melhorias práticas são mais importantes do que a supremacia do benchmark. O SWE-bench Verified mede a capacidade de uma IA de identificar e corrigir bugs reais em software de código aberto, e as pontuações de ambos os modelos representam avanços significativos nas capacidades de codificação autônoma.

À medida que os modelos de IA se tornam cada vez mais sofisticados em suas capacidades de raciocínio e codificação, a competição está mudando de métricas brutas de desempenho para implementação prática e confiabilidade em ambientes de produção. A verdade surpreendente? Essa estabilidade pode permitir mudanças mais transformadoras do que qualquer outro avanço.