Artificial Intelligence

YOLOv7: Najbardziej zaawansowany algorytm wykrywania obiektów?

6 lipca 2022 r. zostanie zapisany jako punkt zwrotny w historii sztucznej inteligencji, ponieważ przypadał na ten dzień, kiedy wypuszczono YOLOv7. Od chwili premiery YOLOv7 jest najgorętszym tematem w społeczności programistów Computer Vision i nie bez powodu. YOLOv7 jest już uważany za kamień milowy w branży wykrywania obiektów.

Krótko po Opublikowano artykuł YOLOv7, okazał się najszybszym i najdokładniejszym modelem wykrywania zastrzeżeń w czasie rzeczywistym. Ale w jaki sposób YOLOv7 przewyższa swoich poprzedników? Co sprawia, że YOLOv7 jest tak skuteczny w wykonywaniu zadań związanych z wizją komputerową?

W tym artykule postaramy się przeanalizować model YOLOv7 i znaleźć odpowiedź na pytanie, dlaczego YOLOv7 staje się obecnie standardem branżowym? Zanim jednak będziemy mogli odpowiedzieć na to pytanie, będziemy musieli rzucić okiem na krótką historię wykrywania obiektów.

Co to jest wykrywanie obiektów?

Wykrywanie obiektów jest gałęzią wizji komputerowej który identyfikuje i lokalizuje obiekty na obrazie lub pliku wideo. Wykrywanie obiektów to podstawa wielu zastosowań, w tym samochodów autonomicznych, monitoringu monitorowanego, a nawet robotyki.

Model wykrywania obiektów można podzielić na dwie różne kategorie: detektory jednostrzałowe, i detektory wielostrzałowe.

Wykrywanie obiektów w czasie rzeczywistym

Aby naprawdę zrozumieć, jak działa YOLOv7, ważne jest, abyśmy zrozumieli główny cel YOLOv7, „Wykrywanie obiektów w czasie rzeczywistym”. Wykrywanie obiektów w czasie rzeczywistym jest kluczowym elementem nowoczesnej wizji komputerowej. Modele wykrywania obiektów w czasie rzeczywistym próbują identyfikować i lokalizować interesujące obiekty w czasie rzeczywistym. Modele wykrywania obiektów w czasie rzeczywistym sprawiły, że programiści mogli naprawdę efektywnie śledzić interesujące obiekty w ruchomej klatce, np. na wideo lub na żywo z monitoringu.

Modele wykrywania obiektów w czasie rzeczywistym są zasadniczo o krok dalej od konwencjonalnych modeli wykrywania obrazu. Podczas gdy ten pierwszy służy do śledzenia obiektów w plikach wideo, drugi lokalizuje i identyfikuje obiekty w nieruchomej ramce, podobnie jak obraz.

W rezultacie modele wykrywania obiektów w czasie rzeczywistym są naprawdę skuteczne w analizie wideo, pojazdach autonomicznych, liczeniu obiektów, śledzeniu wielu obiektów i wielu innych.

Co to jest YOLO?

YOLO lub „Patrzysz tylko raz” to rodzina modeli wykrywania obiektów w czasie rzeczywistym. Koncepcja YOLO została po raz pierwszy wprowadzona w 2016 roku przez Josepha Redmona i niemal natychmiast zrobiło się o niej głośno w całym mieście, ponieważ była znacznie szybsza i znacznie dokładniejsza niż istniejące algorytmy wykrywania obiektów. Nie trwało długo, zanim algorytm YOLO stał się standardem w branży systemów wizyjnych.

Podstawową koncepcją zaproponowaną przez algorytm YOLO jest wykorzystanie kompleksowej sieci neuronowej wykorzystującej ramki ograniczające i prawdopodobieństwa klas do przewidywania w czasie rzeczywistym. YOLO różni się od poprzedniego modelu wykrywania obiektów w tym sensie, że proponuje inne podejście do wykrywania obiektów poprzez zmianę przeznaczenia klasyfikatorów.

Zmiana podejścia zadziałała, ponieważ YOLO szybko stało się standardem branżowym, ponieważ różnica w wydajności między nim a innymi algorytmami wykrywania obiektów w czasie rzeczywistym była znacząca. Ale jaki był powód, dla którego YOLO było tak skuteczne?

W porównaniu do YOLO, algorytmy wykrywania obiektów wykorzystywały wówczas sieci propozycji regionów do wykrywania możliwych obszarów zainteresowania. Następnie proces rozpoznawania przeprowadzono oddzielnie dla każdego regionu. W rezultacie modele te często wykonywały wielokrotne iteracje na tym samym obrazie, a co za tym idzie, brak dokładności i dłuższy czas wykonania. Z drugiej strony algorytm YOLO wykorzystuje pojedynczą, w pełni połączoną warstwę, aby wykonać prognozę jednocześnie.

Jak działa YOLO?

Istnieją trzy kroki wyjaśniające działanie algorytmu YOLO.

Przeformułowanie wykrywania obiektów jako pojedynczego problemu regresji

Połączenia Algorytm YOLO próbuje przeformułować wykrywanie obiektów w pojedynczy problem regresji, łącznie z pikselami obrazu, na prawdopodobieństwa klas i współrzędne ramki ograniczającej. Dlatego algorytm musi spojrzeć na obraz tylko raz, aby przewidzieć i zlokalizować obiekty docelowe na obrazach.

Uzasadnia obraz globalnie

Ponadto, kiedy algorytm YOLO dokonuje przewidywań, analizuje obraz globalnie. Różni się od technik opartych na propozycji regionu i technik przesuwania, ponieważ algorytm YOLO widzi pełny obraz podczas uczenia i testowania zbioru danych oraz jest w stanie zakodować informacje kontekstowe na temat klas i ich wyglądu.

Przed YOLO Fast R-CNN był jednym z najpopularniejszych algorytmów wykrywania obiektów, który nie widział szerszego kontekstu na obrazie, ponieważ mylił plamy tła na obrazie z obiektem. W porównaniu do algorytmu Fast R-CNN, YOLO jest o 50% dokładniejszy jeśli chodzi o błędy w tle.

Uogólnia reprezentację obiektów

Wreszcie algorytm YOLO ma również na celu uogólnienie reprezentacji obiektów na obrazie. W rezultacie, gdy algorytm YOLO został uruchomiony na zbiorze danych zawierającym naturalne obrazy i przetestowany pod kątem wyników, YOLO znacznie przewyższył istniejące modele R-CNN. Dzieje się tak dlatego, że YOLO można w dużym stopniu uogólnić, a ryzyko jego awarii w przypadku wdrożenia na nieoczekiwanych danych wejściowych lub w nowych domenach było niewielkie.

YOLOv7: Co nowego?

Teraz, gdy mamy już podstawową wiedzę na temat modeli wykrywania obiektów w czasie rzeczywistym i czym jest algorytm YOLO, czas omówić algorytm YOLOv7.

Optymalizacja procesu szkoleniowego

Algorytm YOLOv7 nie tylko stara się optymalizować architekturę modelu, ale ma także na celu optymalizację procesu uczenia. Ma na celu wykorzystanie modułów i metod optymalizacyjnych w celu poprawy dokładności wykrywania obiektów, zwiększenia kosztów szkolenia, przy jednoczesnym utrzymaniu kosztów zakłóceń. Te moduły optymalizacyjne można nazwać: wyszkoloną torbę gratisów.

Przypisywanie etykiet ze wskazówkami od ołowiu od grubego do drobnego

Algorytm YOLOv7 planuje zastosować nowe przypisywanie etykiet ze wskazówkami od zgrubnej do drobnej ołowiu zamiast konwencjonalnego Dynamiczne przypisywanie etykiet. Dzieje się tak, ponieważ w przypadku dynamicznego przypisywania etykiet uczenie modelu z wieloma warstwami wyjściowymi powoduje pewne problemy, z których najczęstszym jest przypisywanie dynamicznych celów dla różnych gałęzi i ich wyników.

Ponowna parametryzacja modelu

Ponowna parametryzacja modelu jest ważną koncepcją w wykrywaniu obiektów, a jej użycie wiąże się z pewnymi problemami podczas szkolenia. Algorytm YOLOv7 planuje wykorzystać koncepcję ścieżka propagacji gradientu w celu analizy zasad ponownej parametryzacji modelu zastosowanie do różnych warstw sieci.

Rozszerzanie i skalowanie złożone

Algorytm YOLOv7 wprowadza również rozszerzone i złożone metody skalowania wykorzystywać i efektywnie wykorzystywać parametry i obliczenia do wykrywania obiektów w czasie rzeczywistym.

YOLOv7: Powiązane prace

Wykrywanie obiektów w czasie rzeczywistym

YOLO jest obecnie standardem branżowym, a większość detektorów obiektów działających w czasie rzeczywistym wykorzystuje algorytmy YOLO i FCOS (Fully Convolutional One-Stage Object-Detection). Najnowocześniejszy detektor obiektów działający w czasie rzeczywistym ma zwykle następujące cechy

- Silniejsza i szybsza architektura sieci.

- Skuteczna metoda integracji funkcji.

- Dokładna metoda wykrywania obiektów.

- Solidna funkcja straty.

- Efektywna metoda przypisywania etykiet.

- Skuteczna metoda treningowa.

Algorytm YOLOv7 nie wykorzystuje metod samonadzorowanego uczenia się i destylacji, które często wymagają dużych ilości danych. Z drugiej strony algorytm YOLOv7 wykorzystuje metodę worka gratisów, którą można wytrenować.

Ponowna parametryzacja modelu

Techniki reparametryzacji modelu są uważane za technikę zespołową, która łączy wiele modułów obliczeniowych w etapie interferencyjnym. Technikę tę można dalej podzielić na dwie kategorie, zespół na poziomie modelki, i zespół na poziomie modułu.

Aby uzyskać ostateczny model interferencji, technika reparametryzacji na poziomie modelu wykorzystuje dwie praktyki. Pierwsza praktyka wykorzystuje różne dane szkoleniowe do uczenia wielu identycznych modeli, a następnie uśrednia wagi wyszkolonych modeli. Alternatywnie, druga praktyka uśrednia wagi modeli podczas różnych iteracji.

Ponowna parametryzacja na poziomie modułu zyskuje ostatnio ogromną popularność, ponieważ dzieli moduł na różne gałęzie modułów lub różne identyczne gałęzie podczas fazy szkolenia, a następnie podczas interferencji przechodzi do integracji tych różnych gałęzi w równoważny moduł.

Jednakże technik ponownej parametryzacji nie można zastosować do wszystkich rodzajów architektury. To jest powód, dla którego Algorytm YOLOv7 wykorzystuje nowe techniki ponownej parametryzacji modelu do projektowania powiązanych strategii dostosowane do różnych architektur.

Skalowanie modelu

Skalowanie modelu to proces zwiększania lub zmniejszania istniejącego modelu, tak aby pasował do różnych urządzeń komputerowych. Skalowanie modelu zazwyczaj wykorzystuje różne czynniki, takie jak liczba warstw (głębokość), rozmiar obrazów wejściowych (rozkład), liczba piramid obiektowych (etap) i liczbę kanałów (szerokość). Czynniki te odgrywają kluczową rolę w zapewnieniu zrównoważonego kompromisu w zakresie parametrów sieci, szybkości zakłóceń, obliczeń i dokładności modelu.

Jedną z najczęściej stosowanych metod skalowania jest Wyszukiwanie architektury NAS lub sieci który automatycznie wyszukuje odpowiednie współczynniki skalujące z wyszukiwarek bez żadnych skomplikowanych reguł. Główną wadą korzystania z serwera NAS jest to, że jest to kosztowne podejście do wyszukiwania odpowiednich współczynników skalowania.

Prawie każdy model ponownej parametryzacji modelu niezależnie analizuje indywidualne i unikalne współczynniki skalowania, a co więcej, nawet niezależnie optymalizuje te czynniki. Dzieje się tak dlatego, że architektura NAS działa z nieskorelowanymi współczynnikami skalowania.

Warto zauważyć, że modele oparte na konkatenacji, takie jak VoVNet or Gęstość zmienić szerokość wejściową kilku warstw, gdy głębokość modeli jest skalowana. YOLOv7 działa na proponowanej architekturze opartej na konkatenacji i dlatego wykorzystuje złożoną metodę skalowania.

Powyższy rysunek porównuje rozbudowane, wydajne sieci agregacji warstw (E-ELAN) różnych modeli. Proponowana metoda E-ELAN zachowuje gradientową ścieżkę transmisji oryginalnej architektury, ale ma na celu zwiększenie liczności dodanych funkcji za pomocą splotu grupowego. Proces ten może ulepszyć funkcje wyuczone przez różne mapy i może jeszcze bardziej zwiększyć efektywność wykorzystania obliczeń i parametrów.

Architektura YOLov7

Model YOLOv7 wykorzystuje jako podstawę modele YOLOv4, YOLO-R i Scaled YOLOv4. YOLOv7 jest wynikiem eksperymentów przeprowadzonych na tych modelach w celu poprawy wyników i zwiększenia dokładności modelu.

Rozszerzona, wydajna sieć agregacji warstw lub E-ELAN

E-ELAN jest podstawowym elementem modelu YOLOv7 i wywodzi się z już istniejących modeli wydajności sieci, głównie ROZMACH.

Projektując wydajną architekturę, należy wziąć pod uwagę głównie liczbę parametrów, gęstość obliczeniową i ilość obliczeń. Inne modele uwzględniają również takie czynniki, jak wpływ stosunku kanałów wejściowych do wyjściowych, rozgałęzienia w architekturze sieci, prędkość zakłóceń sieci, liczba elementów w tensorach sieci splotowej i inne.

Połączenia CSPVoNet model nie tylko uwzględnia powyższe parametry, ale także analizuje ścieżkę gradientu, aby poznać bardziej zróżnicowane cechy, umożliwiając wagi różnych warstw. Takie podejście pozwala, aby zakłócenia były znacznie szybsze i dokładniejsze. The ROZMACH Architektura ma na celu zaprojektowanie wydajnej sieci sterującej najkrótszą i najdłuższą ścieżką gradientu, tak aby sieć mogła być bardziej skuteczna w uczeniu się i konwergencji.

ELAN osiągnął już stabilny etap, niezależnie od liczby bloków obliczeniowych i długości ścieżki gradientu. Stan stabilny może zostać zniszczony, jeśli bloki obliczeniowe będą układane w nieograniczone stosy, a stopień wykorzystania parametrów spadnie. The proponowana architektura E-ELAN może rozwiązać ten problem, ponieważ wykorzystuje kardynalność rozszerzania, tasowania i łączenia ciągłe zwiększanie zdolności uczenia się sieci przy jednoczesnym zachowaniu oryginalnej ścieżki gradientu.

Co więcej, porównując architekturę E-ELAN z ELAN, jedyna różnica dotyczy bloku obliczeniowego, natomiast architektura warstwy przejściowej pozostaje niezmieniona.

E-ELAN proponuje poszerzenie liczności bloków obliczeniowych i poszerzenie kanału poprzez wykorzystanie splot grupowy. Mapa obiektów zostanie następnie obliczona i podzielona na grupy zgodnie z parametrem grupy, a następnie połączona ze sobą. Liczba kanałów w każdej grupie pozostanie taka sama jak w oryginalnej architekturze. Na koniec zostaną dodane grupy map obiektów, aby zapewnić liczność.

Skalowanie modelu dla modeli opartych na konkatenacji

Skalowanie modelu pomaga dopasowywanie atrybutów modeli pomaga to w generowaniu modeli zgodnie z wymaganiami i w różnych skalach, aby spełnić różne prędkości zakłóceń.

Rysunek mówi o skalowaniu modelu dla różnych modeli opartych na konkatenacji. Jak widać na rysunkach (a) i (b), szerokość wyjściowa bloku obliczeniowego rośnie wraz ze wzrostem głębokości skalowania modeli. W rezultacie zwiększa się szerokość wejściowa warstw transmisyjnych. Jeśli te metody są zaimplementowane w architekturze opartej na konkatenacji, proces skalowania jest przeprowadzany dogłębnie, co przedstawiono na rysunku (c).

Można zatem stwierdzić, że w przypadku modeli opartych na konkatenacji nie jest możliwe samodzielne analizowanie czynników skalujących, należy je rozpatrywać lub analizować łącznie. Dlatego w przypadku modelu opartego na konkatenacji wskazane jest użycie odpowiedniej metody skalowania modelu złożonego. Dodatkowo, gdy skalowany jest współczynnik głębokości, skalowany musi być również kanał wyjściowy bloku.

Torba z gratisami do trenowania

Torba gratisów to termin, którego używają programiści do opisania zestaw metod lub technik, które mogą zmienić strategię lub koszt szkolenia próbując zwiększyć dokładność modelu. Czym więc są te torby z gratisami, które można wytrenować w YOLOv7? Spójrzmy.

Planowany, ponownie sparametryzowany splot

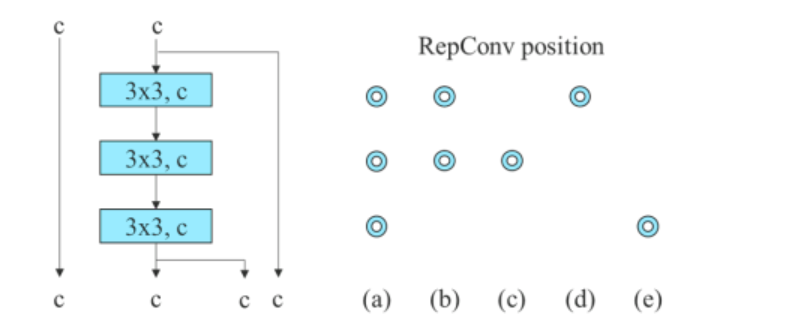

Algorytm YOLOv7 wykorzystuje do określenia ścieżki propagacji przepływu gradientowego jak idealnie połączyć sieć z ponownie sparametryzowanym splotem. To podejście YOLov7 jest próbą przeciwdziałania Algorytm RepConv który chociaż działał spokojnie w modelu VGG, działa słabo po zastosowaniu bezpośrednio do modeli DenseNet i ResNet.

Aby zidentyfikować połączenia w warstwie splotowej, Algorytm RepConv łączy splot 3×3 i splot 1×1. Jeśli przeanalizujemy algorytm, jego wydajność i architekturę, zaobserwujemy, że RepConv niszczy konkatenacja w DenseNet, a reszta w ResNet.

Powyższy obrazek przedstawia planowany, ponownie sparametryzowany model. Można zauważyć, że algorytm YOLov7 stwierdził, że warstwa w sieci z połączeniami konkatenacyjnymi lub resztkowymi nie powinna mieć połączenia tożsamościowego w algorytmie RepConv. W rezultacie dopuszczalne jest przełączanie za pomocą RepConvN bez połączeń tożsamości.

Gruba za pomocnicza i drobna za utratę ołowiu

Głęboki nadzór to dziedzina informatyki, która często znajduje zastosowanie w procesie uczenia głębokich sieci. Podstawową zasadą głębokiego nadzoru jest to, że tak dodaje dodatkową głowicę pomocniczą w środkowych warstwach sieci wraz z płytkimi ciężarami sieci, których przewodnikiem jest utrata asystenta. Algorytm YOLOv7 określa głowę odpowiedzialną za efekt końcowy jako głowę prowadzącą, a głowę pomocniczą jako głowę pomagającą w treningu.

Idąc dalej, YOLOv7 używa innej metody przypisywania etykiet. Konwencjonalnie przypisywanie etykiet stosowano do generowania etykiet poprzez bezpośrednie odniesienie do podstawowej prawdy i w oparciu o zadany zbiór reguł. Jednak w ostatnich latach dystrybucja i jakość danych wejściowych do prognoz odgrywa ważną rolę w tworzeniu wiarygodnej etykiety. YOLOv7 generuje miękką etykietę obiektu za pomocą przewidywań ramki ograniczającej i prawdy podstawowej.

Co więcej, nowa metoda przypisywania etykiet w algorytmie YOLOv7 wykorzystuje przewidywania głowicy prowadzącej do prowadzenia zarówno elektrody, jak i głowicy pomocniczej. Metoda przypisywania etykiet ma dwie proponowane strategie.

Głowa główna, osoba przypisująca etykiety z przewodnikiem

Strategia dokonuje obliczeń w oparciu o wyniki przewidywań głównego lidera i podstawową prawdę, a następnie wykorzystuje optymalizację do generowania miękkich etykiet. Te miękkie etykiety są następnie wykorzystywane jako model szkoleniowy zarówno dla głowicy prowadzącej, jak i głowicy pomocniczej.

Strategia opiera się na założeniu, że ponieważ główny lider ma większą zdolność uczenia się, generowane przez niego etykiety powinny być bardziej reprezentatywne i korelować między źródłem a celem.

Urządzenie do przypisywania etykiet z głowicą prowadzącą od grubej do drobnej

Strategia ta wykonuje również obliczenia na podstawie wyników przewidywań głównego lidera i podstawowej prawdy, a następnie wykorzystuje optymalizację do generowania miękkich etykiet. Istnieje jednak kluczowa różnica. W tej strategii istnieją dwa zestawy miękkich etykiet, gruby poziom, i dobra etykieta.

Zgrubna etykieta jest generowana poprzez rozluźnienie ograniczeń próbki dodatniej

proces przypisywania, który traktuje więcej siatek jako pozytywne cele. Ma to na celu uniknięcie ryzyka utraty informacji z powodu słabszej siły uczenia się głowicy pomocniczej.

Powyższy rysunek wyjaśnia użycie wytrenowanej torby gratisów w algorytmie YOLOv7. Przedstawia grubo dla głowicy pomocniczej i drobno dla głowicy prowadzącej. Kiedy porównamy Model z głowicą pomocniczą (b) z modelem normalnym (a), zaobserwujemy, że schemat w (b) ma głowicę pomocniczą, podczas gdy nie ma jej w (a).

Rysunek (c) przedstawia wspólnego niezależnego moduł przypisywania etykiet, podczas gdy rysunek (d) i rysunek (e) przedstawiają odpowiednio moduł przypisania z przewodnikiem i moduł przypisania z przewodnikiem od zgrubnego do dokładnego używane przez YOLOv7.

Inna torba z gratisami, którą można wyszkolić

Oprócz wspomnianych powyżej, algorytm YOLOv7 wykorzystuje dodatkowe torby gratisów, choć nie były one pierwotnie przez nich proponowane. Oni są

- Normalizacja wsadowa w technologii aktywacji Conv-Bn: Strategia ta służy do łączenia warstwy splotowej bezpośrednio z warstwą normalizacji wsadowej.

- Wiedza ukryta w YOLOR: YOLOv7 łączy strategię z mapą funkcji splotowych.

- Model EMA: Model EMA jest używany jako ostateczny model odniesienia w YOLOv7, chociaż jego głównym zastosowaniem jest metoda średniego nauczyciela.

YOLOv7: Eksperymenty

Zestaw doświadczalny

Algorytm YOLOv7 wykorzystuje Zestaw danych Microsoft COCO do szkolenia i walidacji ich model wykrywania obiektów i nie we wszystkich tych eksperymentach wykorzystuje się wstępnie wytrenowany model. Twórcy wykorzystali zestaw danych pociągu z 2017 r. do szkolenia, a zestaw danych walidacyjnych z 2017 r. wykorzystali do wybrania hiperparametrów. Na koniec wydajność wykrywania obiektów YOLOv7 jest porównywana z najnowocześniejszymi algorytmami wykrywania obiektów.

Twórcy zaprojektowali podstawowy model dla Edge GPU (YOLOv7-tiny), normalny procesor graficzny (YOLOv7) i procesor graficzny w chmurze (YOLOv7-W6). Co więcej, algorytm YOLOv7 wykorzystuje również podstawowy model do skalowania modelu zgodnie z różnymi wymaganiami usług i otrzymuje różne modele. W przypadku algorytmu YOLOv7 skalowanie stosu odbywa się na szyi, a proponowane związki służą do zwiększania głębokości i szerokości modelu.

Wartości bazowe

Algorytm YOLOv7 wykorzystuje poprzednie modele YOLO, a jako podstawę wykorzystuje algorytm wykrywania obiektów YOLOR.

Powyższy rysunek porównuje linię bazową modelu YOLOv7 z innymi modelami wykrywania obiektów, a wyniki są dość oczywiste. W porównaniu z Algorytm YOLOv4, YOLOv7 nie tylko wykorzystuje 75% mniej parametrów, ale także 15% mniej obliczeń i ma o 0.4% większą dokładność.

Porównanie z najnowocześniejszymi modelami detektorów obiektów

Powyższy rysunek przedstawia wyniki porównania YOLOv7 z najnowocześniejszymi modelami wykrywania obiektów dla mobilnych i ogólnych procesorów graficznych. Można zaobserwować, że metoda zaproponowana przez algorytm YOLOv7 ma najlepszy wynik kompromisu między szybkością a dokładnością.

Badanie ablacji: proponowana metoda skalowania złożonego

Na powyższym rysunku porównano wyniki zastosowania różnych strategii skalowania modelu. Strategia skalowania w modelu YOLOv7 zwiększa głębokość bloku obliczeniowego 1.5 razy, a szerokość 1.25 razy.

W porównaniu z modelem, który skaluje jedynie głębokość, model YOLOv7 działa lepiej o 0.5% przy użyciu mniejszych parametrów i mocy obliczeniowej. Z drugiej strony, w porównaniu z modelami, które skalują jedynie głębokość, dokładność YOLOv7 jest lepsza o 0.2%, ale liczba parametrów wymaga skalowania o 2.9%, a obliczeń o 1.2%.

Proponowany planowany model ponownie sparametryzowany

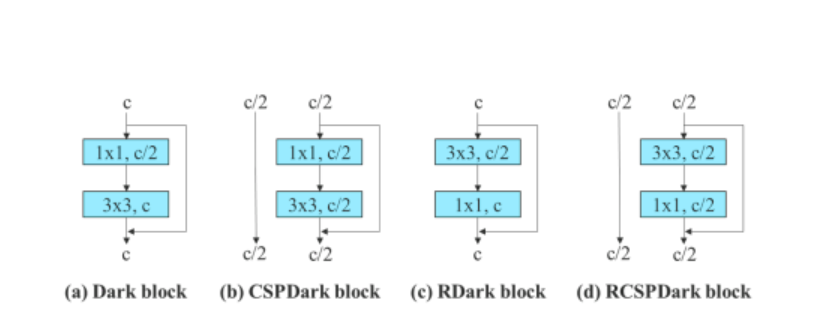

Aby zweryfikować ogólność proponowanego, ponownie sparametryzowanego modelu, Algorytm YOLOv7 wykorzystuje go do weryfikacji w modelach opartych na resztach i konkatenacjach. Do procesu weryfikacji wykorzystuje algorytm YOLOv7 3-piętrowy ELAN dla modelu opartego na konkatenacji i CSPDarknet dla modelu opartego na resztach.

W przypadku modelu opartego na konkatenacji algorytm zastępuje warstwy splotowe 3 × 3 w 3-stosowej sieci ELAN za pomocą RepConv. Poniższy rysunek przedstawia szczegółową konfigurację Planned RepConv i 3-warstwowej sieci ELAN.

Co więcej, w przypadku modelu opartego na resztach algorytm YOLOv7 wykorzystuje odwrócony ciemny blok, ponieważ oryginalny ciemny blok nie ma bloku splotu 3 × 3. Poniższy rysunek przedstawia architekturę Reversed CSPDarknet, która odwraca położenie warstwy splotowej 3×3 i 1×1.

Proponowana strata asystenta dla szefa pomocniczego

W przypadku utraty asystenta dla głowicy pomocniczej model YOLOv7 porównuje niezależne przypisanie etykiet dla metod głowicy pomocniczej i głowicy prowadzącej.

Na powyższym rysunku przedstawiono wyniki badań proponowanej głowicy pomocniczej. Można zauważyć, że ogólna wydajność modelu wzrasta wraz ze wzrostem straty asystenta. Co więcej, przypisywanie etykiet z przewodnikiem zaproponowane przez model YOLOv7 działa lepiej niż niezależne strategie przydzielania leadów.

Wyniki YOLOv7

W oparciu o powyższe eksperymenty, oto wynik wydajności YOLov7 w porównaniu z innymi algorytmami wykrywania obiektów.

Powyższy rysunek porównuje model YOLOv7 z innymi algorytmami wykrywania obiektów i można wyraźnie zauważyć, że YOLOv7 przewyższa inne modele wykrywania zastrzeżeń pod względem Średnia precyzja (AP) v/s zakłócenia wsadowe.

Co więcej, poniższy rysunek porównuje wydajność YOLOv7 z innymi algorytmami wykrywania zastrzeżeń w czasie rzeczywistym. Po raz kolejny YOLOv7 jest następcą innych modeli pod względem ogólnej wydajności, dokładności i wydajności.

Oto kilka dodatkowych obserwacji z wyników i występów YOLOv7.

- YOLOv7-Tiny to najmniejszy model w rodzinie YOLO, posiadający ponad 6 milionów parametrów. YOLOv7-Tiny ma średnią precyzję na poziomie 35.2% i przewyższa modele YOLOv4-Tiny o porównywalnych parametrach.

- Model YOLOv7 ma ponad 37 milionów parametrów i przewyższa modele o wyższych parametrach, takie jak YOLov4.

- Model YOLOv7 charakteryzuje się najwyższym wskaźnikiem mAP i FPS w przedziale od 5 do 160 FPS.

Wnioski

YOLO lub You Only Look Once to najnowocześniejszy model wykrywania obiektów we współczesnej wizji komputerowej. Algorytm YOLO znany jest ze swojej wysokiej dokładności i wydajności, dzięki czemu znajduje szerokie zastosowanie w branży wykrywania obiektów w czasie rzeczywistym. Od czasu wprowadzenia pierwszego algorytmu YOLO w 2016 roku eksperymenty pozwalają programistom na ciągłe ulepszanie modelu.

Model YOLOv7 to najnowszy dodatek do rodziny YOLO i jest to najpotężniejszy jak dotąd algorytm YOLo. W tym artykule omówiliśmy podstawy YOLOv7 i próbowaliśmy wyjaśnić, co sprawia, że YOLOv7 jest tak wydajny.