Wykresy to struktury danych przedstawiające złożone relacje w szerokim zakresie dziedzin, w tym sieci społecznościowych, baz wiedzy, systemów biologicznych i wielu innych. Na tych wykresach elementy są reprezentowane jako węzły, a ich relacje są przedstawiane jako krawędzie.

Zdolność do skutecznego przedstawiania i uzasadniania tych skomplikowanych struktur relacyjnych ma kluczowe znaczenie dla umożliwienia postępu w takich dziedzinach, jak nauka o sieciach, chemiainformatyka i systemy rekomendacyjne.

Grafowe sieci neuronowe (GNN) stały się potężną platformą głębokiego uczenia się do zadań uczenia maszynowego wykorzystującego grafy. Włączając topologię grafów do architektury sieci neuronowej poprzez agregację sąsiedztwa lub sploty grafów, sieci GNN mogą uczyć się niskowymiarowych reprezentacji wektorowych, które kodują zarówno cechy węzłów, jak i ich role strukturalne. Dzięki temu sieci GNN mogą osiągnąć najnowocześniejszą wydajność w zadaniach takich jak klasyfikacja węzłów, przewidywanie połączeń i klasyfikacja grafów w różnych obszarach zastosowań.

Chociaż sieci GNN przyczyniły się do znacznego postępu, pewne kluczowe wyzwania pozostają nadal. Uzyskanie wysokiej jakości oznakowanych danych do celów uczenia nadzorowanych modeli GNN może być kosztowne i czasochłonne. Dodatkowo sieci GNN mogą borykać się z heterogenicznymi strukturami wykresów i sytuacjami, w których rozkład wykresów w czasie testu znacznie różni się od danych uczących (uogólnienie poza dystrybucją).

Równolegle modele wielkojęzyczne (LLM), takie jak GPT-4 i Lama podbiły świat swoimi niesamowitymi możliwościami rozumienia i generowania języka naturalnego. Wyszkoleni na ogromnych korpusach tekstowych z miliardami parametrów, LLM wykazują niezwykłe zdolności uczenia się w kilku strzałach, uogólniania zadań i umiejętności zdroworozsądkowego rozumowania, które kiedyś uważano za niezwykle trudne dla systemów AI.

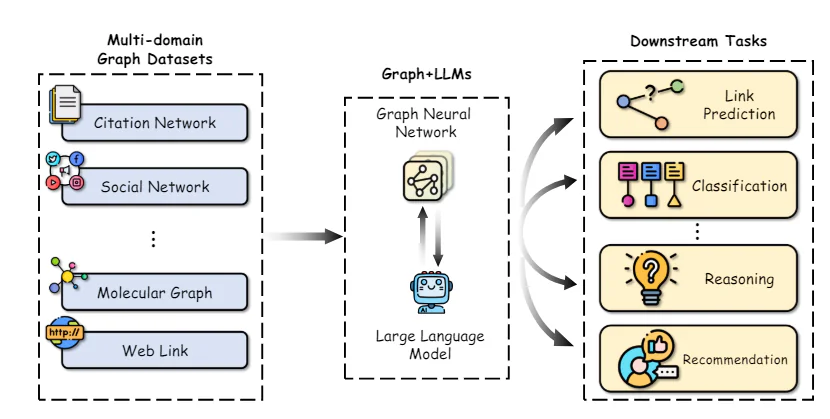

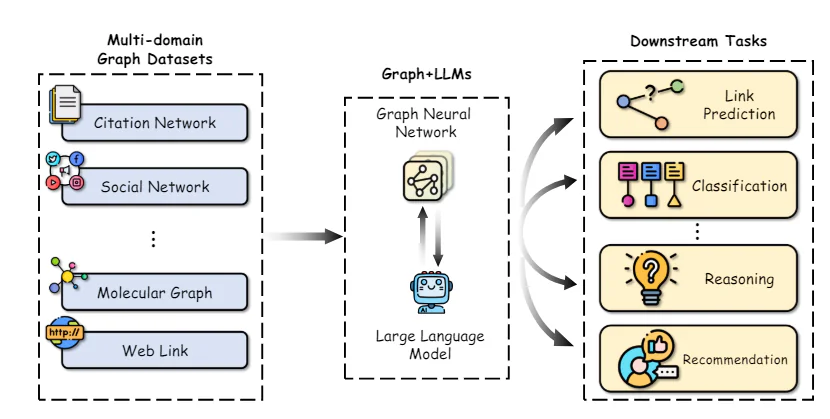

Ogromny sukces LLM stał się katalizatorem badań nad wykorzystaniem ich mocy do zadań związanych z grafowym uczeniem maszynowym. Z jednej strony wiedza i możliwości rozumowania LLM stwarzają możliwości ulepszenia tradycyjnych modeli GNN. I odwrotnie, ustrukturyzowane reprezentacje i wiedza faktograficzna zawarta w wykresach mogą odegrać zasadniczą rolę w rozwiązaniu niektórych kluczowych ograniczeń LLM, takich jak halucynacje i brak możliwości interpretacji.

W tym artykule zagłębimy się w najnowsze badania na styku grafowego uczenia maszynowego i dużych modeli językowych. Zbadamy, w jaki sposób LLM można wykorzystać do ulepszenia różnych aspektów grafowego uczenia maszynowego, dokonamy przeglądu podejść umożliwiających włączenie wiedzy o grafach do LLM oraz omówimy pojawiające się zastosowania i przyszłe kierunki w tej ekscytującej dziedzinie.

Graficzne sieci neuronowe i uczenie się samonadzorowane

Aby zapewnić niezbędny kontekst, najpierw dokonamy krótkiego przeglądu podstawowych koncepcji i metod grafowych sieci neuronowych i samonadzorowanego uczenia się reprezentacji grafów.

Wykres architektury sieci neuronowych

Wykres architektury sieci neuronowej – źródło

Kluczowa różnica między tradycyjnymi głębokimi sieciami neuronowymi a sieciami GNN polega na ich zdolności do bezpośredniego działania na danych o strukturze graficznej. Sieci GNN działają według schematu agregacji sąsiedztwa, w którym każdy węzeł agreguje wektory cech od swoich sąsiadów w celu obliczenia własnej reprezentacji.

Zaproponowano wiele architektur GNN z różnymi instancjami funkcji komunikatów i aktualizacji, np Wykres sieci splotowych (GCN), WykresSAGE, Wykres sieci uwagi (GAT) i Wykresy sieci izomorfizmu (GIN), między innymi.

Niedawno transformatory grafowe zyskały popularność poprzez adaptację mechanizmu samouwagi z transformatorów języka naturalnego do działania na danych o strukturze grafowej. Niektóre przykłady obejmują GraphormerTransformator, Twórcy wykresów. Modele te są w stanie lepiej uchwycić zależności dalekiego zasięgu na wykresie niż sieci GNN oparte wyłącznie na sąsiedztwach.

Samonadzorowane uczenie się na wykresach

Chociaż sieci GNN są potężnymi modelami reprezentacyjnymi, ich działanie jest często ograniczane przez brak dużych, oznakowanych zbiorów danych wymaganych do nadzorowanego szkolenia. Samonadzorowane uczenie się okazało się obiecującym paradygmatem wstępnego uczenia sieci GNN na nieoznaczonych danych grafowych poprzez wykorzystanie zadań pretekstowych, które wymagają jedynie wewnętrznej struktury wykresu i cech węzłów.

Niektóre typowe zadania pretekstowe wykorzystywane w samonadzorowanym szkoleniu wstępnym GNN obejmują:

- Przewidywanie właściwości węzła: Losowe maskowanie lub uszkadzanie części atrybutów/cech węzła i zlecanie GNN ich rekonstrukcji.

- Przewidywanie krawędzi/połączenia: Uczenie się przewidywania, czy pomiędzy parą węzłów istnieje krawędź, często w oparciu o losowe maskowanie krawędzi.

- Kontrastowe uczenie się: Maksymalizacja podobieństw między widokami wykresu tej samej próbki wykresu przy jednoczesnym oddzielaniu widoków z różnych wykresów.

- Maksymalizacja wzajemnej informacji: Maksymalizacja wzajemnych informacji pomiędzy reprezentacjami lokalnych węzłów i reprezentacją docelową, np. osadzanie wykresu globalnego.

Tego typu zadania pretekstowe umożliwiają GNN wyodrębnienie znaczących wzorców strukturalnych i semantycznych z nieoznaczonych danych graficznych podczas szkolenia wstępnego. Wstępnie wyszkoloną sieć GNN można następnie dostroić na stosunkowo małych, oznakowanych podzbiorach, aby doskonale radziła sobie z różnymi zadaniami końcowymi, takimi jak klasyfikacja węzłów, przewidywanie połączeń i klasyfikacja grafów.

Dzięki wykorzystaniu samonadzoru sieci GNN przeszkolone na dużych, nieoznakowanych zbiorach danych wykazują lepszą generalizację, odporność na zmiany w dystrybucji i wydajność w porównaniu do szkolenia od zera. Jednakże pozostają pewne kluczowe ograniczenia tradycyjnych metod samonadzoru opartych na GNN, którymi w następnej kolejności zajmiemy się wykorzystując LLM.

Ulepszanie Graph ML za pomocą modeli z dużym językiem

Integracja wykresów i LLM – źródło

Niezwykłe możliwości LLM w zakresie rozumienia języka naturalnego, rozumowania i uczenia się metodą kilku uderzeń stwarzają możliwości ulepszenia wielu aspektów potoków uczenia maszynowego grafów. Badamy kilka kluczowych kierunków badań w tej przestrzeni:

Kluczowym wyzwaniem w stosowaniu sieci GNN jest uzyskanie wysokiej jakości reprezentacji cech węzłów i krawędzi, szczególnie gdy zawierają one bogate atrybuty tekstowe, takie jak opisy, tytuły lub streszczenia. Tradycyjnie używano prostych zestawów słów lub wstępnie wytrenowanych modeli osadzania słów, które często nie oddawały zniuansowanej semantyki.

Ostatnie prace wykazały siłę wykorzystania dużych modeli językowych jako koderów tekstu do konstruowania lepszych reprezentacji cech węzłów/krawędzi przed przekazaniem ich do GNN. Na przykład, Chen i in. wykorzystują LLM, takie jak GPT-3, do kodowania tekstowych atrybutów węzłów, wykazując znaczny wzrost wydajności w porównaniu z tradycyjnym osadzaniem słów w zadaniach klasyfikacji węzłów.

Oprócz lepszych koderów tekstu, LLM można wykorzystać do generowania rozszerzonych informacji na podstawie oryginalnych atrybutów tekstu w sposób częściowo nadzorowany. TAŚMA generuje potencjalne etykiety/objaśnienia dla węzłów za pomocą LLM i wykorzystuje je jako dodatkowe rozszerzone funkcje. KEA wyodrębnia terminy z atrybutów tekstowych za pomocą LLM i uzyskuje szczegółowe opisy tych terminów w celu rozszerzenia funkcji.

Poprawiając jakość i wyrazistość funkcji wejściowych, LLM mogą przekazać sieciom GNN swoje doskonałe możliwości rozumienia języka naturalnego, zwiększając wydajność dalszych zadań.

Łagodzenie polegania na oznaczonych danych

Kluczową zaletą LLM jest ich zdolność do stosunkowo dobrego wykonywania nowych zadań z niewielką ilością oznakowanych danych lub bez nich, dzięki wstępnemu przeszkoleniu na obszernych korpusach tekstowych. Tę zdolność uczenia się w kilku krokach można wykorzystać, aby zmniejszyć zależność sieci GNN od dużych, oznakowanych zbiorów danych.

Jednym z podejść jest wykorzystanie LLM do bezpośredniego przewidywania zadań grafowych poprzez opisanie struktury wykresu i informacji o węzłach w podpowiedziach języka naturalnego. Metody takie jak PoinstruujGLM i Wykres GPT4 dostrajać LLM, takie jak LLaMA i GPT-4, za pomocą starannie zaprojektowanych podpowiedzi, które uwzględniają szczegóły topologii wykresu, takie jak połączenia węzłów, sąsiedztwo itp. Dostrojone LLM mogą następnie generować przewidywania dla zadań, takich jak klasyfikacja węzłów i przewidywanie połączeń, w sposób zerowy podczas wnioskowania.

Chociaż wykorzystanie LLM jako predyktorów czarnej skrzynki okazało się obiecujące, ich wydajność pogarsza się w przypadku bardziej złożonych zadań graficznych, w których korzystne jest jawne modelowanie struktury. Niektóre podejścia wykorzystują zatem LLM w połączeniu z GNN – GNN koduje strukturę wykresu, podczas gdy LLM zapewnia lepsze zrozumienie semantyczne węzłów na podstawie ich opisów tekstowych.

Zrozumienie wykresów w ramach LLM Framework – Źródło

GraphLLM bada dwie strategie: 1) LLM-jako wzmacniacze, w których LLM kodują atrybuty węzłów tekstowych przed przekazaniem do GNN, oraz 2) LLM-jako-predyktory, w których LLM wykorzystuje pośrednie reprezentacje GNN jako dane wejściowe do tworzenia ostatecznych przewidywań.

GLEM idzie dalej, proponując wariacyjny algorytm EM, który na przemian aktualizuje komponenty LLM i GNN w celu wzajemnego udoskonalenia.

Zmniejszając zależność od oznaczonych danych poprzez możliwości kilkukrotnego użycia i częściowo nadzorowane rozszerzanie, metody uczenia się grafów wspomagane przez LLM mogą odblokować nowe aplikacje i poprawić wydajność danych.

Wzbogacanie LLM za pomocą wykresów

Chociaż LLM odniosły ogromny sukces, nadal borykają się z kluczowymi ograniczeniami, takimi jak halucynacje (generowanie stwierdzeń nieopartych na faktach), brak możliwości interpretacji w procesie rozumowania i niezdolność do utrzymania spójnej wiedzy opartej na faktach.

Wykresy, zwłaszcza wykresy wiedzy, które przedstawiają ustrukturyzowane informacje oparte na faktach z wiarygodnych źródeł, przedstawiają obiecujące możliwości usunięcia tych niedociągnięć. Badamy kilka pojawiających się podejść w tym kierunku:

Graf wiedzy Ulepszone szkolenie wstępne LLM

Podobnie jak LLM są wstępnie szkoleni na korpusach z dużymi tekstami, ostatnie prace zbadali możliwość wstępnego szkolenia ich na wykresach wiedzy, aby zaszczepić im lepszą świadomość faktów i zdolności rozumowania.

Niektóre podejścia modyfikują dane wejściowe poprzez proste łączenie lub wyrównywanie faktycznych trójek KG z tekstem w języku naturalnym podczas szkolenia wstępnego. E-BERT wyrównuje wektory encji KG z osadzonymi słowami BERT, podczas gdy K-BERT konstruuje drzewa zawierające oryginalne zdanie i odpowiednie trójki KG.

Rola LLM w grafowym uczeniu maszynowym:

Badacze zbadali kilka sposobów integracji LLM z procesem uczenia się grafów, każdy z nich ma swoje unikalne zalety i zastosowania. Oto niektóre z najważniejszych ról, jakie mogą odegrać LLM:

- LLM jako wzmacniacz: W tym podejściu LLM są wykorzystywane do wzbogacania atrybutów tekstowych powiązanych z węzłami TAG-u. Zdolność LLM do generowania wyjaśnień, jednostek wiedzy lub pseudoetykiet może poszerzyć informacje semantyczne dostępne dla GNN, prowadząc do lepszej reprezentacji węzłów i wydajności dalszych zadań.

Na przykład model TAPE (Text Augmented Pre-trained Encoders) wykorzystuje ChatGPT do generowania wyjaśnień i pseudoetykiet dla artykułów sieci cytowań, które są następnie wykorzystywane do dostrojenia modelu językowego. Powstałe osady są wprowadzane do sieci GNN w celu wykonywania zadań związanych z klasyfikacją węzłów i przewidywaniem połączeń, co pozwala uzyskać najnowocześniejsze wyniki.

- LLM jako predyktor: Zamiast ulepszać funkcje wejściowe, niektóre podejścia bezpośrednio wykorzystują LLM jako komponent predykcyjny dla zadań związanych z wykresami. Wiąże się to z konwersją struktury wykresu na reprezentację tekstową, która może zostać przetworzona przez LLM, który następnie generuje żądane dane wyjściowe, takie jak etykiety węzłów lub przewidywania na poziomie wykresu.

Godnym uwagi przykładem jest model GPT4Graph, który reprezentuje wykresy przy użyciu języka Graph Modeling Language (GML) i wykorzystuje potężny GPT-4 LLM do zadań wnioskowania zerowego.

- Wyrównanie GNN-LLM: Inny kierunek badań skupia się na dostosowaniu przestrzeni osadzania sieci GNN i LLM, umożliwiając płynną integrację informacji strukturalnych i semantycznych. Podejścia te traktują GNN i LLM jako odrębne modalności i wykorzystują techniki takie jak uczenie się kontrastowe lub destylacja w celu dostosowania ich reprezentacji.

Połączenia CząsteczkaSTM model wykorzystuje na przykład cel kontrastowy, aby dopasować osadzenie GNN i LLM, umożliwiając LLM włączenie informacji strukturalnych z GNN, podczas gdy GNN korzysta z wiedzy semantycznej LLM.

Wyzwania i rozwiązania

Chociaż integracja LLM i uczenia się za pomocą grafów jest niezwykle obiecująca, należy stawić czoła kilku wyzwaniom:

- Wydajność i skalowalność: LLM notorycznie wymagają dużej ilości zasobów, często wymagają miliardów parametrów i ogromnej mocy obliczeniowej do uczenia i wnioskowania. Może to stanowić znaczące wąskie gardło we wdrażaniu modeli uczenia się grafów ulepszonych za pomocą LLM w rzeczywistych aplikacjach, szczególnie na urządzeniach o ograniczonych zasobach.

Jednym z obiecujących rozwiązań jest destylacja wiedzy, w którym wiedza z dużego LLM (model nauczyciela) jest przenoszona do mniejszego, bardziej wydajnego GNN (model ucznia).

- Wyciek danych i ocena: Linie LLM są wstępnie szkolone na ogromnych ilościach publicznie dostępnych danych, które mogą obejmować zestawy testowe ze wspólnych zestawów danych porównawczych, co prowadzi do potencjalnego wycieku danych i przeszacowania wydajności. Aby złagodzić ten problem, badacze rozpoczęli gromadzenie nowych zbiorów danych lub pobieranie próbek danych testowych z okresów po zakończeniu szkolenia LLM.

Ponadto ustanowienie uczciwych i kompleksowych standardów oceny modeli uczenia się grafów wzmocnionych LLM ma kluczowe znaczenie dla pomiaru ich prawdziwych możliwości i umożliwienia znaczących porównań.

- Przenośność i wyjaśnialność: Chociaż studia LLM przodują w uczeniu się od zera do kilku strzałów, ich zdolność do transferu wiedzy pomiędzy różnymi domenami i strukturami grafów pozostaje otwartym wyzwaniem. Poprawa możliwości przenoszenia tych modeli jest kluczowym kierunkiem badań.

Co więcej, zwiększenie wyjaśnialności modeli uczenia się grafów opartych na LLM jest niezbędne do budowania zaufania i umożliwienia ich przyjęcia w zastosowaniach o wysokiej stawce. Wykorzystywanie nieodłącznych możliwości rozumowania LLM za pomocą technik takich jak podpowiadanie łańcucha myśli może przyczynić się do poprawy wyjaśnialności.

- Integracja multimodalna: Wykresy często zawierają więcej niż tylko informacje tekstowe, z węzłami i krawędziami potencjalnie powiązanymi z różnymi modalnościami, takimi jak obrazy, dźwięk lub dane liczbowe. Rozszerzenie integracji LLM na te ustawienia wykresów multimodalnych stanowi ekscytującą szansę dla przyszłych badań.

Zastosowania w świecie rzeczywistym i studia przypadków

Integracja LLM i grafowego uczenia maszynowego przyniosła już obiecujące wyniki w różnych zastosowaniach w świecie rzeczywistym:

- Przewidywanie właściwości molekularnych: W dziedzinie chemii obliczeniowej i odkrywania leków LLM zastosowano w celu usprawnienia przewidywania właściwości molekularnych poprzez włączenie informacji strukturalnych z wykresów molekularnych. The Model LLM4Molna przykład wykorzystuje ChatGPT do generowania wyjaśnień dla reprezentacji cząsteczek SMILES (uproszczony system wprowadzania linii wejściowych molekularnych), które są następnie wykorzystywane do poprawy dokładności zadań przewidywania właściwości.

- Wypełnianie i rozumowanie Grafu Wiedzy: Wykresy wiedzy to specjalny typ struktury grafów, który reprezentuje byty ze świata rzeczywistego i ich relacje. LLM badano pod kątem zadań takich jak uzupełnianie wykresów wiedzy i wnioskowanie, gdzie strukturę wykresu i informacje tekstowe (np. opisy jednostek) należy rozpatrywać łącznie.

- Systemy rekomendujące: W dziedzinie systemów rekomendacyjnych struktury grafów są często używane do reprezentowania interakcji użytkownik-element, przy czym węzły reprezentują użytkowników i elementy, a krawędzie oznaczają interakcje lub podobieństwa. LLM można wykorzystać do ulepszenia tych wykresów, generując informacje po stronie użytkownika/przedmiotu lub wzmacniając krawędzie interakcji.

Wnioski

Synergia między modelami wielkojęzykowymi i grafowym uczeniem maszynowym stanowi ekscytującą granicę w badaniach nad sztuczną inteligencją. Łącząc strukturalne odchylenie indukcyjne GNN z potężnymi możliwościami rozumienia semantycznego LLM, możemy odblokować nowe możliwości w zadaniach uczenia się grafów, szczególnie w przypadku wykresów z atrybutami tekstowymi.

Chociaż poczyniono znaczne postępy, nadal istnieją wyzwania w takich obszarach, jak wydajność, skalowalność, możliwość przenoszenia i wyjaśnialność. Techniki takie jak destylacja wiedzy, uczciwe testy porównawcze i integracja multimodalna torują drogę do praktycznego wdrożenia modeli uczenia się grafów wspomaganych przez LLM w rzeczywistych zastosowaniach.