L'angolo di Anderson

Verso il controllo totale nella generazione di video AI

Modelli di fondazioni video come Hunyuan e 2.1 anni, pur essendo potenti, non offrono agli utenti il tipo di controllo granulare richiesto dalla produzione cinematografica e televisiva (in particolare dalla produzione di effetti visivi).

Negli studi di effetti visivi professionali, modelli open source come questi, insieme a modelli precedenti basati su immagini (piuttosto che video) come Diffusione stabile, Kandinsky e Flusso, sono solitamente utilizzati insieme a una serie di strumenti di supporto che adattano il loro output grezzo per soddisfare specifiche esigenze creative. Quando un regista dice, "Sembra fantastico, ma possiamo renderlo un po' più [n]?" non puoi rispondere dicendo che il modello non è sufficientemente preciso per gestire tali richieste.

Invece un team AI VFX utilizzerà una gamma di tradizionali CGI e tecniche compositive, unite a procedure e flussi di lavoro personalizzati sviluppati nel tempo, nel tentativo di spingere un po' più in là i limiti della sintesi video.

Quindi, per analogia, un modello video di base è molto simile all'installazione predefinita di un browser web come Chrome; fa molte cose di default, ma se vuoi che si adatti alle tue esigenze, e non viceversa, avrai bisogno di alcuni plugin.

Freak del controllo

Nel mondo della sintesi di immagini basata sulla diffusione, il sistema di terze parti più importante è Rete di controllo.

ControlNet è una tecnica per aggiungere un controllo strutturato ai modelli generativi basati sulla diffusione, consentendo agli utenti di guidare la generazione di immagini o video con input aggiuntivi come mappe dei bordi, mappe di profondità, o informazioni sulla posa.

I vari metodi di ControlNet consentono la generazione di immagini di esseri umani e animali tramite profondità>immagine (riga superiore), segmentazione semantica>immagine (in basso a sinistra) e posa guidata (in basso a sinistra).

Invece di basarsi esclusivamente su prompt di testo, ControlNet introduce rami separati della rete neurale, o adattatori, che elaborano questi segnali di condizionamento preservando le capacità generative del modello base.

Ciò consente di ottenere output ottimizzati che aderiscono più fedelmente alle specifiche dell'utente, rendendolo particolarmente utile nelle applicazioni in cui è richiesta una composizione, una struttura o un controllo del movimento precisi:

Grazie a una posa guida, è possibile ottenere diversi tipi di output precisi tramite ControlNet. Fonte: https://arxiv.org/pdf/2302.05543

Tuttavia, i framework basati su adattatori di questo tipo operano esternamente su un set di processi neurali che sono fortemente focalizzati internamente. Questi approcci presentano diversi svantaggi.

In primo luogo, gli adattatori vengono addestrati in modo indipendente, il che porta a conflitti di ramo quando vengono combinati più adattatori, ciò può comportare un degrado della qualità della generazione.

In secondo luogo, introducono ridondanza dei parametri, richiedendo elaborazione e memoria aggiuntive per ciascun adattatore, rendendo il ridimensionamento inefficiente.

In terzo luogo, nonostante la loro flessibilità, gli adattatori spesso producono sub-ottimale sul risultato rispetto ai modelli completamente messo a punto per la generazione di più condizioni. Questi problemi rendono i metodi basati su adattatori meno efficaci per le attività che richiedono un'integrazione fluida di più segnali di controllo.

L'ideale sarebbe che le capacità di ControlNet venissero allenate nativamente nel modello, in modo modulare, in grado di accogliere innovazioni future, molto attese e ovvie, come la generazione simultanea di video/audio o le capacità native di sincronizzazione labiale (per l'audio esterno).

Allo stato attuale, ogni funzionalità aggiuntiva rappresenta un'attività di post-produzione o una procedura non nativa che deve gestire i pesi strettamente legati e sensibili del modello di base su cui opera.

DiT completo

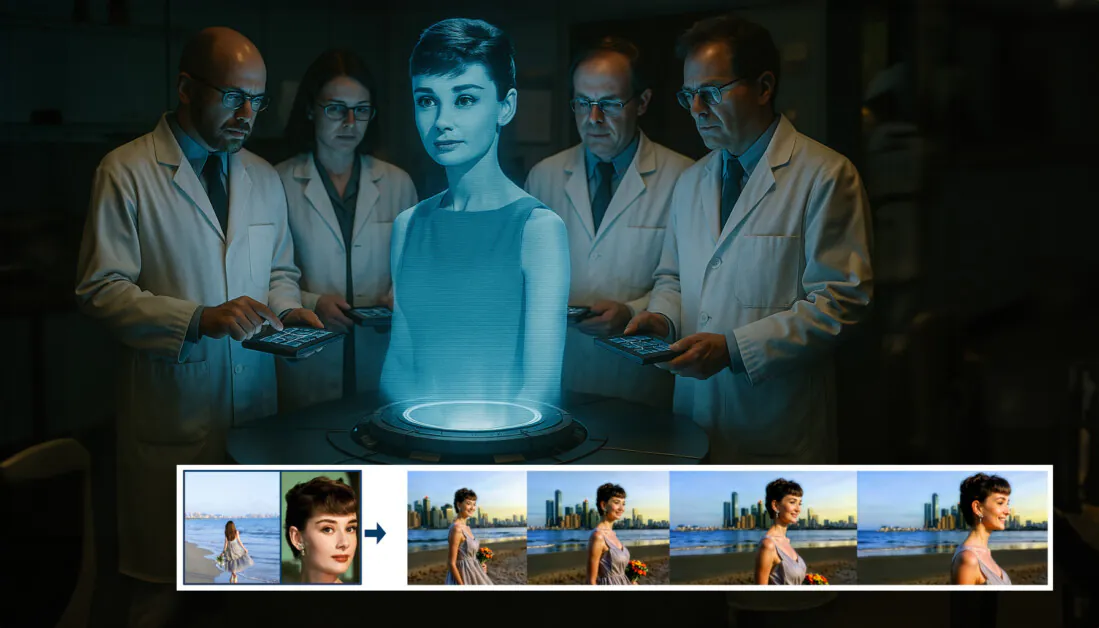

In questa situazione di stallo arriva una nuova proposta dalla Cina, che propone un sistema in cui le misure in stile ControlNet vengono integrate direttamente in un modello video generativo al momento della formazione, anziché essere relegate a un ripensamento.

Dal nuovo documento: l'approccio FullDiT può incorporare l'imposizione dell'identità, la profondità e il movimento della telecamera in una generazione nativa e può evocare qualsiasi combinazione di questi contemporaneamenteFonte: https://arxiv.org/pdf/2503.19907

Titolato DiT completo, il nuovo approccio fonde condizioni multi-task come il trasferimento di identità, la mappatura della profondità e il movimento della telecamera in una parte integrata di un modello video generativo addestrato, per il quale gli autori hanno prodotto un prototipo di modello addestrato e videoclip di accompagnamento a un sito del progetto.

Nell'esempio seguente, vediamo generazioni che incorporano il movimento della telecamera, informazioni sull'identità e informazioni di testo (ad esempio, suggerimenti di testo guida per l'utente):

Clicca per giocare. Esempi di imposizione utente in stile ControlNet con solo un modello di base addestrato in modo nativo. Fonte: https://fulldit.github.io/

È opportuno notare che gli autori non propongono il loro modello sperimentale addestrato come modello di base funzionale, ma piuttosto come prova di concetto per modelli nativi testo-video (T2V) e immagine-video (I2V) che offrono agli utenti un controllo maggiore rispetto a un semplice prompt di immagini o di testo.

Poiché non esistono ancora modelli simili di questo tipo, i ricercatori hanno creato un nuovo benchmark denominato Panca completa, per la valutazione di video multi-task, e affermano prestazioni all'avanguardia nei test like-for-like da loro ideati rispetto ad approcci precedenti. Tuttavia, poiché FullBench è stato progettato dagli stessi autori, la sua obiettività non è stata testata e il suo set di dati di 1,400 casi potrebbe essere troppo limitato per conclusioni più ampie.

Forse l'aspetto più interessante dell'architettura proposta dal documento è il suo potenziale di incorporare nuovi tipi di controllo. Gli autori affermano:

"In questo lavoro, esploriamo solo le condizioni di controllo della telecamera, le identità e le informazioni di profondità. Non abbiamo approfondito altre condizioni e modalità come audio, parlato, nuvola di punti, riquadri di delimitazione degli oggetti, flusso ottico, ecc. Sebbene il design di FullDiT possa integrare perfettamente altre modalità con modifiche minime all'architettura, come adattare rapidamente ed economicamente i modelli esistenti a nuove condizioni e modalità è ancora una questione importante che merita ulteriori approfondimenti."

Sebbene i ricercatori presentino FullDiT come un passo avanti nella generazione di video multi-task, bisogna considerare che questo nuovo lavoro si basa su architetture esistenti piuttosto che introdurre un paradigma fondamentalmente nuovo.

Tuttavia, per quanto ne so, FullDiT è attualmente l'unico modello di base video con funzionalità "hard-coded" in stile ControlNet, ed è positivo vedere che l'architettura proposta può accogliere anche innovazioni future.

Clicca per giocare. Esempi di movimenti della telecamera controllati dall'utente, dal sito del progetto.

. nuovo documento è intitolato FullDiT: modello di base generativo video multi-task con attenzione completa, e proviene da nove ricercatori di Kuaishou Technology e della Chinese University of Hong Kong. La pagina del progetto è qui e i nuovi dati di riferimento sono a Faccia Abbracciante.

Metodo

Gli autori sostengono che il meccanismo di attenzione unificata di FullDiT consente un apprendimento più forte della rappresentazione multimodale, catturando sia le relazioni spaziali che temporali nelle diverse condizioni:

Secondo il nuovo documento, FullDiT integra più condizioni di input tramite la piena auto-attenzione, convertendole in una sequenza unificata. Al contrario, i modelli basati su adattatori (quelli più a sinistra in alto) utilizzano moduli separati per ogni input, il che porta a ridondanza, conflitti e prestazioni più deboli.

A differenza delle configurazioni basate su adattatori che elaborano ogni flusso di input separatamente, questa struttura di attenzione condivisa evita conflitti di diramazione e riduce il sovraccarico dei parametri. Affermano inoltre che l'architettura può essere scalata a nuovi tipi di input senza una riprogettazione importante e che lo schema del modello mostra segni di generalizzazione a combinazioni di condizioni non viste durante l'addestramento, come il collegamento del movimento della telecamera con l'identità del personaggio.

Clicca per giocare. Esempi di generazione di identità dal sito del progetto.

Nell'architettura di FullDiT, tutti gli input di condizionamento, come testo, movimento della telecamera, identità e profondità, vengono prima convertiti in un formato token unificato. Questi token vengono poi concatenati in un'unica lunga sequenza, che viene elaborata tramite una pila di trasformatore strati usando la piena auto-attenzione. Questo approccio segue lavori precedenti come Piano Open-Sora e Generazione di film.

Questa progettazione consente al modello di apprendere relazioni temporali e spaziali congiuntamente in tutte le condizioni. Ogni blocco trasformatore opera sull'intera sequenza, consentendo interazioni dinamiche tra modalità senza fare affidamento su moduli separati per ogni input e, come abbiamo notato, l'architettura è progettata per essere estensibile, rendendo molto più facile incorporare segnali di controllo aggiuntivi in futuro, senza grandi cambiamenti strutturali.

Il potere del tre

FullDiT converte ogni segnale di controllo in un formato token standardizzato in modo che tutte le condizioni possano essere elaborate insieme in un framework di attenzione unificato. Per il movimento della telecamera, il modello codifica una sequenza di parametri estrinseci, come posizione e orientamento, per ogni fotogramma. Questi parametri sono marcati con timestamp e proiettati in vettori di incorporamento che riflettono la natura temporale del segnale.

Le informazioni di identità sono trattate in modo diverso, poiché sono intrinsecamente spaziali piuttosto che temporali. Il modello utilizza mappe di identità che indicano quali caratteri sono presenti in quali parti di ogni frame. Queste mappe sono divise in patch, con ogni patch proiettata in un incorporamento che cattura indizi di identità spaziale, consentendo al modello di associare regioni specifiche del frame a entità specifiche.

La profondità è un segnale spaziotemporale e il modello lo gestisce dividendo i video di profondità in patch 3D che abbracciano sia lo spazio che il tempo. Queste patch vengono quindi incorporate in un modo che ne preserva la struttura nei frame.

Una volta incorporati, tutti questi token di condizione (telecamera, identità e profondità) vengono concatenati in un'unica lunga sequenza, consentendo a FullDiT di elaborarli insieme utilizzando l'intero auto-attenzioneQuesta rappresentazione condivisa consente al modello di apprendere interazioni tra modalità e nel tempo senza basarsi su flussi di elaborazione isolati.

Dati e test

L'approccio formativo di FullDiT si basava su set di dati annotati in modo selettivo e personalizzati per ogni tipo di condizionamento, anziché richiedere che tutte le condizioni fossero presenti simultaneamente.

Per le condizioni testuali, l'iniziativa segue l'approccio di sottotitolazione strutturata delineato nel MiraData progetto.

Pipeline di raccolta e annotazione video dal progetto MiraData. Fonte: https://arxiv.org/pdf/2407.06358

Per il movimento della telecamera, il Immobiliare10K Il set di dati è stata la principale fonte di dati, grazie alle sue annotazioni di elevata qualità basate sulla verità sul campo dei parametri della telecamera.

Tuttavia, gli autori hanno osservato che l'addestramento esclusivamente su dataset di telecamere con scene statiche come RealEstate10K tendeva a ridurre i movimenti dinamici degli oggetti e degli esseri umani nei video generati. Per contrastare questo fenomeno, hanno condotto un'ulteriore messa a punto utilizzando dataset interni che includevano movimenti della telecamera più dinamici.

Le annotazioni di identità sono state generate utilizzando la pipeline sviluppata per Concetto Master progetto, che ha consentito un filtraggio e un'estrazione efficienti di informazioni identitarie dettagliate.

Il framework ConceptMaster è progettato per risolvere i problemi di disaccoppiamento dell'identità, preservando al contempo la fedeltà concettuale nei video personalizzati. Fonte: https://arxiv.org/pdf/2501.04698

Le annotazioni di profondità sono state ottenute da Panda-70M set di dati utilizzando Profondità Qualsiasi.

Ottimizzazione tramite l'ordinamento dei dati

Gli autori hanno inoltre implementato un programma di allenamento progressivo, introducendo condizioni più impegnative prima nell'allenamento per garantire che il modello acquisisse rappresentazioni robuste prima che venissero aggiunte attività più semplici. L'ordine di addestramento procedeva da testo a stanza condizioni, quindi identità, e infine profondità, con compiti più semplici generalmente introdotti in seguito e con meno esempi.

Gli autori sottolineano l'importanza di ordinare il carico di lavoro in questo modo:

"Durante la fase di pre-formazione, abbiamo notato che le attività più impegnative richiedono tempi di formazione più lunghi e dovrebbero essere introdotte prima nel processo di apprendimento. Queste attività impegnative implicano distribuzioni di dati complesse che differiscono in modo significativo dal video di output, richiedendo al modello di possedere una capacità sufficiente per catturarle e rappresentarle in modo accurato.

'Al contrario, introdurre troppo presto compiti più semplici può indurre il modello a dare priorità al loro apprendimento, poiché forniscono un feedback di ottimizzazione più immediato, che ostacola la convergenza di compiti più impegnativi.'

Un'illustrazione dell'ordine di addestramento dei dati adottato dai ricercatori, con il rosso che indica un volume di dati maggiore.

Dopo il pre-training iniziale, una fase finale di messa a punto ha ulteriormente perfezionato il modello per migliorare la qualità visiva e la dinamica del movimento. In seguito, il training ha seguito quello di un framework di diffusione standard*: rumore aggiunto alle latenti video e il modello imparare a prevederlo e rimuoverlo, utilizzando i token di condizione incorporati come guida.

Per valutare efficacemente FullDiT e fornire un confronto equo con i metodi esistenti, e in assenza della disponibilità di qualsiasi altro benchmark appropriato, gli autori hanno introdotto Panca completa, una suite di benchmark curata composta da 1,400 casi di test distinti.

Un'istanza di esplorazione dati per il nuovo benchmark FullBench. Fonte: https://huggingface.co/datasets/KwaiVGI/FullBench

Ogni punto dati ha fornito annotazioni di verità di base per vari segnali di condizionamento, inclusi movimento della telecamera, identitàe profondità.

Metrica

Gli autori hanno valutato FullDiT utilizzando dieci parametri che coprono cinque aspetti principali delle prestazioni: allineamento del testo, controllo della telecamera, somiglianza dell'identità, accuratezza della profondità e qualità video generale.

L'allineamento del testo è stato misurato utilizzando Somiglianza CLIP, mentre il controllo della telecamera è stato valutato attraverso errore di rotazione (RotErr), errore di traduzione (Errore di trasmissione), E coerenza del movimento della telecamera (CamMC), seguendo l'approccio di CammaI2V (nel FotocameraCtrl progetto).

La somiglianza dell'identità è stata valutata utilizzando DINO-I e CLIP-Ie la precisione del controllo della profondità è stata quantificata utilizzando Errore assoluto medio (MAE).

La qualità video è stata giudicata con tre parametri di MiraData: similarità CLIP a livello di frame per la fluidità; distanza di movimento basata sul flusso ottico per la dinamica; e LAION-Punteggi estetici per un impatto visivo gradevole.

Formazione

Gli autori hanno addestrato FullDiT utilizzando un modello di diffusione testo-video interno (non divulgato) contenente circa un miliardo di parametri. Hanno scelto intenzionalmente una dimensione modesta del parametro per mantenere l'equità nei confronti con i metodi precedenti e garantire la riproducibilità.

Poiché i video di formazione differivano per lunghezza e risoluzione, gli autori li hanno standardizzati ciascuno partita ridimensionando e riempiendo i video a una risoluzione comune, campionando 77 fotogrammi per sequenza e utilizzando l'attenzione applicata e maschere di perdita per ottimizzare l'efficacia della formazione.

. Adam l'ottimizzatore è stato utilizzato a tasso di apprendimento di 1 × 10-5 su un cluster di 64 GPU NVIDIA H800, per un totale combinato di 5,120 GB di VRAM (si consideri che nelle comunità di sintesi degli appassionati, 24GB su una RTX 3090 è ancora considerato uno standard di lusso).

Il modello è stato addestrato per circa 32,000 passaggi, incorporando fino a tre identità per video, insieme a 20 fotogrammi di condizioni della telecamera e 21 fotogrammi di condizioni di profondità, entrambi campionati uniformemente dai 77 fotogrammi totali.

Per l'inferenza, il modello ha generato video con una risoluzione di 384×672 pixel (circa cinque secondi a 15 fotogrammi al secondo) con 50 passaggi di inferenza di diffusione e una scala di guida senza classificatore di cinque.

Metodi precedenti

Per la valutazione telecamera-video, gli autori hanno confrontato FullDiT con Controllo movimento, CameraCtrl e CamI2V, con tutti i modelli addestrati utilizzando il set di dati RealEstate10k per garantire coerenza ed equità.

Nella generazione condizionata dall'identità, poiché non erano disponibili modelli multi-identità open source comparabili, il modello è stato confrontato con il modello ConceptMaster a 1B parametri, utilizzando gli stessi dati di formazione e la stessa architettura.

Per le attività di profondità-video, sono stati effettuati confronti con Adattatore Ctrl e ControlloVideo.

Risultati quantitativi per la generazione di video single-task. FullDiT è stato confrontato con MotionCtrl, CameraCtrl e CamI2V per la generazione camera-to-video; ConceptMaster (versione parametro 1B) per identity-to-video; e Ctrl-Adapter e ControlVideo per depth-to-video. Tutti i modelli sono stati valutati utilizzando le loro impostazioni predefinite. Per coerenza, 16 frame sono stati campionati uniformemente da ciascun metodo, corrispondenti alla lunghezza di output dei modelli precedenti.

I risultati indicano che FullDiT, nonostante la gestione simultanea di più segnali di condizionamento, ha raggiunto prestazioni all'avanguardia nelle metriche relative ai controlli di testo, movimento della telecamera, identità e profondità.

In termini di qualità complessiva, il sistema ha generalmente superato altri metodi, sebbene la sua fluidità sia risultata leggermente inferiore a quella di ConceptMaster. Ecco il commento degli autori:

'La fluidità di FullDiT è leggermente inferiore a quella di ConceptMaster poiché il calcolo della fluidità si basa sulla similarità CLIP tra frame adiacenti. Poiché FullDiT mostra una dinamica significativamente maggiore rispetto a ConceptMaster, la metrica della fluidità è influenzata dalle grandi variazioni tra frame adiacenti.

'Per quanto riguarda il punteggio estetico, poiché il modello di valutazione privilegia le immagini in stile pittura e ControlVideo genera solitamente video in questo stile, ottiene un punteggio elevato in termini di estetica.'

Per quanto riguarda il confronto qualitativo, potrebbe essere preferibile fare riferimento ai video di esempio sul sito del progetto FullDiT, poiché gli esempi in PDF sono inevitabilmente statici (e anche troppo grandi per essere riprodotti integralmente qui).

La prima sezione dei risultati qualitativi nel PDF. Si prega di fare riferimento al documento di origine per gli esempi aggiuntivi, che sono troppo estesi per essere riprodotti qui.

Gli autori commentano:

'FullDiT dimostra una conservazione dell'identità superiore e genera video con dinamiche e qualità visiva migliori rispetto a [ConceptMaster]. Poiché ConceptMaster e FullDiT sono addestrati sullo stesso backbone, ciò evidenzia l'efficacia dell'iniezione di condizioni con la massima attenzione.

"...Gli [altri] risultati dimostrano la superiore controllabilità e qualità di generazione di FullDiT rispetto ai metodi esistenti depth-to-video e camera-to-video."

Una sezione degli esempi in PDF dell'output di FullDiT con segnali multipli. Per ulteriori esempi, consultare il documento originale e il sito del progetto.

Conclusione

Sebbene FullDiT rappresenti un'entusiasmante incursione in un tipo di modello di base video più completo, bisogna chiedersi se la domanda di strumenti in stile ControlNet giustificherà mai l'implementazione di tali funzionalità su larga scala, almeno per i progetti FOSS, che farebbero fatica a ottenere l'enorme quantità di potenza di elaborazione GPU necessaria, senza supporto commerciale.

La sfida principale è che l'utilizzo di sistemi come Depth e Pose richiede generalmente una familiarità non banale con interfacce utente relativamente complesse come ComfyUI. Pertanto, sembra che un modello FOSS funzionale di questo tipo sia molto probabilmente sviluppato da un gruppo di piccole aziende VFX che non hanno i soldi (o la volontà, dato che tali sistemi vengono rapidamente resi obsoleti dagli aggiornamenti del modello) per curare e addestrare un tale modello a porte chiuse.

D'altro canto, i sistemi "rent-an-AI" basati su API potrebbero essere ben motivati a sviluppare metodi interpretativi più semplici e intuitivi per i modelli in cui i sistemi di controllo ausiliari sono stati addestrati direttamente.

Clicca per giocare. Controlli Depth+Text imposti su una generazione video tramite FullDiT.

* Gli autori non specificano alcun modello base noto (ad esempio, SDXL, ecc.)

Prima pubblicazione giovedì 27 marzo 2025