Inteligencia artificial

Difusión de vídeo estable: modelos de difusión de vídeo latente para grandes conjuntos de datos

IA generativa ha sido una fuerza impulsora en la comunidad de IA desde hace algún tiempo, y los avances realizados en el campo del modelado de imágenes generativas, especialmente con el uso de modelos de difusión, han ayudado a que los modelos de video generativos progresen significativamente no solo en la investigación, sino también en términos de Aplicaciones del mundo real. Convencionalmente, los modelos de video generativo se entrenan desde cero o se ajustan parcial o completamente a partir de modelos de imágenes previamente entrenados con capas extra temporales, en una combinación de conjuntos de datos de imágenes y videos.

Avanzando en los avances en los modelos de vídeo generativo, en este artículo hablaremos sobre los Modelo de difusión de vídeo estable, un modelo de difusión de vídeo latente capaz de generar contenido de imagen a vídeo y de texto a vídeo de última generación y de alta resolución. Hablaremos sobre cómo los modelos de difusión latente entrenados para sintetizar imágenes 2D han mejorado las capacidades y la eficiencia de los modelos de video generativos al agregar capas temporales y ajustar los modelos en pequeños conjuntos de datos que consisten en videos de alta calidad. Profundizaremos en la arquitectura y el funcionamiento del modelo de difusión de vídeo estable, evaluaremos su rendimiento en varias métricas y lo compararemos con los marcos de última generación actuales para la generación de vídeo. Entonces empecemos.

Modelo de difusión de vídeo estable y modelos de vídeo generativo: introducción

Gracias a su potencial casi ilimitado, la IA generativa ha sido el principal tema de investigación para los profesionales de la IA y el ML desde hace algún tiempo, y en los últimos años se han visto rápidos avances tanto en términos de eficiencia como de rendimiento de los modelos de imágenes generativas. Lo aprendido a partir de modelos de imágenes generativas ha permitido a investigadores y desarrolladores avanzar en modelos de vídeo generativos, lo que ha dado como resultado una mayor practicidad y aplicaciones en el mundo real. Sin embargo, la mayoría de las investigaciones que intentan mejorar las capacidades de los modelos de vídeo generativos se centran principalmente en la disposición exacta de las capas temporales y espaciales, y se presta poca atención a investigar la influencia de la selección de los datos correctos en el resultado de estos modelos generativos.

Gracias al progreso realizado por los modelos de imágenes generativas, los investigadores han observado que el impacto de la distribución de datos de entrenamiento en el rendimiento de los modelos generativos es realmente significativo e indiscutible. Además, los investigadores también han observado que el entrenamiento previo de un modelo de imagen generativa en un conjunto de datos grande y diverso seguido de su ajuste en un conjunto de datos más pequeño con mejor calidad a menudo da como resultado una mejora significativa del rendimiento. Tradicionalmente, los modelos de video generativo implementan los aprendizajes obtenidos de modelos de imágenes generativos exitosos, y los investigadores aún deben estudiar el efecto de los datos y las estrategias de capacitación aún deben estudiarse. El modelo de difusión de video estable es un intento de mejorar las capacidades de los modelos de video generativo al aventurarse en territorios previamente inexplorados con especial énfasis en la selección de datos.

Los modelos de video generativo recientes se basan en modelos de difusión y enfoques de acondicionamiento de texto o de imagen para sintetizar múltiples cuadros de video o imagen consistentes. Los modelos de difusión son conocidos por su capacidad para aprender cómo eliminar gradualmente el ruido de una muestra de la distribución normal mediante la implementación de un proceso de refinamiento iterativo, y han brindado resultados deseables en video de alta resolución y síntesis de texto a imagen. Utilizando el mismo principio en esencia, el modelo de difusión de video estable entrena un modelo de difusión de video latente en su conjunto de datos de video junto con el uso de redes generativas adversas o GAN, e incluso modelos autorregresivos hasta cierto punto.

El modelo de difusión de video estable sigue una estrategia única nunca implementada por ningún modelo de video generativo, ya que se basa en líneas base de difusión de video latente con una arquitectura fija y una estrategia de entrenamiento fija seguida de la evaluación del efecto de curar los datos. El Modelo de Difusión de Vídeo Estable pretende realizar las siguientes aportaciones en el campo del modelado de vídeo generativo.

- Presentar un flujo de trabajo de curación de datos sistemático y eficaz en un intento de convertir una gran colección de muestras de vídeo no seleccionadas en un conjunto de datos de alta calidad que luego utilizan los modelos de vídeo generativos.

- Entrenar modelos de imagen a video y de texto a video de última generación que superen los marcos existentes.

- Realización de experimentos de dominios específicos para probar la comprensión 3D y un fuerte previo al movimiento del modelo.

Ahora, el modelo de difusión de video estable implementa los aprendizajes de los modelos de difusión de video latente y las técnicas de curación de datos en el centro de su base.

Modelos de difusión de vídeo latente

Los modelos de difusión de video latente o Video-LDM siguen el enfoque de entrenar el modelo generativo primario en un espacio latente con complejidad computacional reducida, y la mayoría de los Video-LDM implementan un modelo de texto a imagen previamente entrenado junto con la adición de capas de mezcla temporal en el entrenamiento previo. arquitectura. Como resultado, la mayoría de los modelos de difusión latente de vídeo solo entrenan capas temporales o se saltan el proceso de entrenamiento por completo, a diferencia del modelo de difusión de vídeo estable que afina todo el marco. Además, para sintetizar datos de texto a video, el modelo de difusión de video estable se condiciona directamente a un mensaje de texto, y los resultados indican que el marco resultante se puede ajustar fácilmente en una síntesis de múltiples vistas o un modelo de imagen a video.

Curación de datos

La curación de datos es un componente esencial no solo del modelo de difusión de video estable, sino también para los modelos generativos en su conjunto, porque es esencial entrenar previamente modelos grandes en conjuntos de datos de gran escala para mejorar el rendimiento en diferentes tareas, incluido el modelado de lenguaje o la generación discriminativa de texto a imagen. , y mucho más. La curación de datos se ha implementado con éxito en modelos de imágenes generativas aprovechando las capacidades de representaciones eficientes de lenguaje-imagen, aunque tales discusiones nunca se han centrado en el desarrollo de modelos de video generativos. Hay varios obstáculos que enfrentan los desarrolladores al seleccionar datos para modelos de video generativo y, para abordar estos desafíos, el modelo de difusión de video estable implementa una estrategia de capacitación de tres etapas, lo que da como resultado mejores resultados y un aumento significativo en el rendimiento.

Curación de datos para síntesis de vídeo de alta calidad

Como se analizó en la sección anterior, el modelo de difusión de video estable implementa una estrategia de capacitación de tres etapas, lo que da como resultado mejores resultados y un aumento significativo en el rendimiento. La etapa I es una preentrenamiento de imagen etapa que hace uso de un modelo de difusión de texto a imagen 2D. La etapa II es para vídeo de preentrenamiento en el que el marco se entrena con una gran cantidad de datos de vídeo. Finalmente, tenemos la Etapa III para ajuste de vídeo en el que el modelo se refina en un pequeño subconjunto de vídeos de alta calidad y alta resolución.

Sin embargo, antes de que el modelo de difusión de video estable implemente estas tres etapas, es vital procesar y anotar los datos, ya que sirven como base para la etapa II o etapa de preentrenamiento de video, y desempeñan un papel fundamental para garantizar el resultado óptimo. Para garantizar la máxima eficiencia, el marco primero implementa un canal de detección de cortes en cascada a 3 niveles diferentes de FPS o fotogramas por segundo, y la necesidad de este canal se demuestra en la siguiente imagen.

A continuación, el modelo de difusión de vídeo estable anota cada clip de vídeo utilizando tres métodos diferentes de subtítulos sintéticos. La siguiente tabla compara los conjuntos de datos utilizados en Stable Diffusion Framework antes y después del proceso de filtración.

Etapa I: Preentrenamiento de imágenes

La primera etapa del proceso de tres etapas implementado en el modelo de difusión de video estable es el entrenamiento previo de imágenes y, para lograrlo, el marco inicial del modelo de difusión de video estable se basa en un modelo de difusión de imágenes previamente entrenado, a saber, el Difusión estable 2.1 modelo que lo equipa con representaciones visuales más fuertes.

Etapa II: Vídeo de preentrenamiento

La segunda etapa es la etapa de preentrenamiento de video y se basa en los hallazgos de que el uso de la curación de datos en modelos de imágenes generativas multimodales a menudo produce mejores resultados y una mayor eficiencia junto con una potente generación de imágenes discriminativas. Sin embargo, debido a la falta de representaciones potentes similares disponibles para filtrar muestras no deseadas para modelos de video generativo, el modelo de difusión de video estable se basa en las preferencias humanas como señales de entrada para la creación de un conjunto de datos apropiado utilizado para el entrenamiento previo del marco. La siguiente figura demuestra el efecto positivo del entrenamiento previo del marco en un conjunto de datos seleccionado que ayuda a mejorar el rendimiento general del entrenamiento previo de video en conjuntos de datos más pequeños.

Para ser más específico, el marco utiliza diferentes métodos para seleccionar subconjuntos de difusión de video latente y considera la clasificación de los modelos LVD entrenados en estos conjuntos de datos. Además, el marco Stable Video Diffusion también descubre que el uso de conjuntos de datos seleccionados para entrenar los marcos ayuda a mejorar el rendimiento del marco y de los modelos de difusión en general. Además, la estrategia de curación de datos también funciona en conjuntos de datos más grandes, más relevantes y muy prácticos. La siguiente figura demuestra el efecto positivo del entrenamiento previo del marco en un conjunto de datos seleccionado que ayuda a mejorar el rendimiento general del entrenamiento previo de video en conjuntos de datos más pequeños.

Etapa III: Ajuste de alta calidad

Hasta la etapa II, el marco Stable Video Diffusion se enfoca en mejorar el rendimiento antes del preentrenamiento del video, y en la tercera etapa, el marco pone énfasis en optimizar o aumentar aún más el rendimiento del marco después del ajuste fino del video de alta calidad, y cómo la transición de la Etapa II a la Etapa III se logra en el marco. En la Etapa III, el marco se basa en técnicas de entrenamiento tomadas de modelos de difusión de imágenes latentes y aumenta la resolución de los ejemplos de entrenamiento. Para analizar la efectividad de este enfoque, el marco lo compara con tres modelos idénticos que difieren sólo en términos de su inicialización. El primer modelo idéntico tiene sus pesos inicializados y el proceso de entrenamiento de video se omite, mientras que los dos modelos idénticos restantes se inicializan con los pesos tomados de otros modelos de video latentes.

Resultados y Hallazgos

Es hora de echar un vistazo a cómo se desempeña el marco Stable Video Diffusion en tareas del mundo real y cómo se compara con los marcos de última generación actuales. El marco Stable Video Diffusion primero utiliza el enfoque de datos óptimo para entrenar un modelo base y luego realiza ajustes para generar varios modelos de última generación, donde cada modelo realiza una tarea específica.

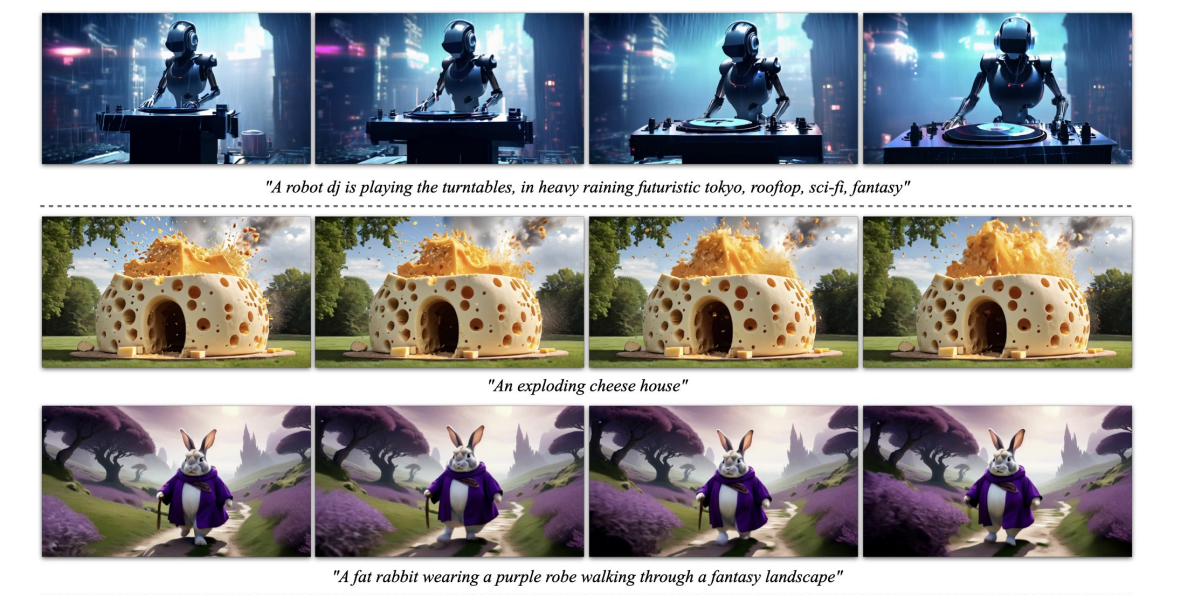

La imagen de arriba representa la imagen de alta resolución a muestras de video generadas por el marco, mientras que la siguiente figura demuestra la capacidad del marco para generar texto de alta calidad a muestras de video.

Base M preentrenadaOdel

Como se mencionó anteriormente, el modelo Stable Video Diffusion se basa en el marco Stable Diffusion 2.1 y, según hallazgos recientes, fue crucial que los desarrolladores adoptaran el programa de ruido y aumentaran el ruido para obtener imágenes con mejor resolución al entrenar la difusión de imágenes. modelos. Gracias a este enfoque, el modelo base de Stable Video Diffusion aprende potentes representaciones de movimiento y, en el proceso, supera a los modelos de referencia para Texto a generación de vídeo en una configuración de disparo cero y los resultados se muestran en la siguiente tabla.

Interpolación de fotogramas y generación de vistas múltiples

El marco Stable Video Diffusion ajusta el modelo de imagen a video en conjuntos de datos de múltiples vistas para obtener múltiples vistas novedosas de un objeto, y este modelo se conoce como SVD-MV o modelo Stable Video Diffusion-Multi View. El modelo SVD original se ajusta con la ayuda de dos conjuntos de datos de manera que el marco ingresa una sola imagen y devuelve una secuencia de imágenes de múltiples vistas como salida.

Como se puede ver en las siguientes imágenes, el marco Stable Video Diffusion Multi View ofrece un alto rendimiento comparable al marco de última generación Scratch Multi View, y los resultados son una clara demostración de la capacidad de SVD-MV para aprovechar los aprendizajes obtenidos. del marco SVD original para la generación de imágenes de múltiples vistas. Además, los resultados también indican que ejecutar el modelo durante un número relativamente menor de iteraciones ayuda a obtener resultados óptimos, como es el caso con la mayoría de los modelos ajustados desde el marco SVD.

En la figura anterior, las métricas se indican en el lado izquierdo y, como se puede ver, el marco Stable Video Diffusion Multi View supera a Scratch-MV y SD2.1 Multi-View por un margen decente. La segunda imagen demuestra el efecto del número de iteraciones de capacitación en el rendimiento general del marco en términos de Clip Score, y los marcos SVD-MV ofrecen resultados sostenibles.

Consideraciones Finales:

En este artículo, hemos hablado de Stable Video Diffusion, un modelo de difusión de vídeo latente capaz de generar contenido de imagen a vídeo y de texto a vídeo de última generación y de alta resolución. El modelo de difusión de video estable sigue una estrategia única nunca implementada por ningún modelo de video generativo, ya que se basa en líneas base de difusión de video latente con una arquitectura fija y una estrategia de entrenamiento fija seguida de la evaluación del efecto de curar los datos.

Hemos hablado sobre cómo los modelos de difusión latente entrenados para sintetizar imágenes 2D han mejorado las capacidades y la eficiencia de modelos de video generativo agregando capas temporales y ajustando los modelos en pequeños conjuntos de datos que consisten en videos de alta calidad. Para recopilar los datos previos al entrenamiento, el marco realiza un estudio de escala y sigue prácticas sistemáticas de recopilación de datos y, en última instancia, propone un método para seleccionar una gran cantidad de datos de video y convierte videos ruidosos en datos de entrada adecuados para modelos de video generativos.

Además, el marco Stable Video Diffusion emplea tres etapas distintas de entrenamiento de modelos de video que se analizan de forma independiente para evaluar su impacto en el rendimiento del marco. En última instancia, el marco genera una representación de video lo suficientemente potente como para ajustar los modelos para una síntesis de video óptima, y los resultados son comparables a los modelos de generación de video de última generación que ya están en uso.