Inteligencia artificial

La IA multimodal evoluciona a medida que ChatGPT gana visibilidad con GPT-4V (ision)

En el esfuerzo continuo por hacer que la IA se parezca más a los humanos, los modelos GPT de OpenAI han superado continuamente los límites. GPT-4 ahora puede aceptar indicaciones tanto de texto como de imágenes.

La multimodalidad en la IA generativa denota la capacidad de un modelo para producir resultados variados como texto, imágenes o audio en función de la entrada. Estos modelos, entrenados con datos específicos, aprenden patrones subyacentes para generar datos nuevos similares, enriqueciendo las aplicaciones de IA.

Avances recientes en la IA multimodal

Un reciente salto notable en este campo se ve con la integración de DALL-E 3 en ChatGPT, una actualización significativa en la tecnología de texto a imagen de OpenAI. Esta combinación permite una interacción más fluida en la que ChatGPT ayuda a crear indicaciones precisas para DALL-E 3, convirtiendo las ideas de los usuarios en arte vívido generado por IA. Entonces, si bien los usuarios pueden interactuar directamente con DALL-E 3, tener ChatGPT en la mezcla hace que el proceso de creación de arte con IA sea mucho más fácil de usar.

Vea más sobre DALL-E 3 y su integración con ChatGPT esta página. Esta colaboración no solo muestra el avance de la IA multimodal, sino que también hace que la creación de arte con IA sea muy sencilla para los usuarios.

La salud de Google, por otro lado, presentada Med-PaLM M en junio de este año. Es un modelo generativo multimodal experto en codificar e interpretar diversos datos biomédicos. Esto se logró ajustando PaLM-E, un modelo de lenguaje, para atender a los dominios médicos utilizando un punto de referencia de código abierto, MultiMedBench. Este punto de referencia consta de más de 1 millón de muestras en 7 tipos de datos biomédicos y 14 tareas como respuesta a preguntas médicas y generación de informes radiológicos.

Varias industrias están adoptando innovadoras herramientas de inteligencia artificial multimodal para impulsar la expansión comercial, optimizar las operaciones y elevar la participación del cliente. El progreso en las capacidades de IA de voz, video y texto está impulsando el crecimiento de la IA multimodal.

Las empresas buscan aplicaciones de IA multimodal capaces de renovar los modelos y procesos de negocio, abriendo vías de crecimiento en todo el ecosistema de IA generativa, desde herramientas de datos hasta aplicaciones de IA emergentes.

Después del lanzamiento de GPT-4 en marzo, algunos usuarios observaron una disminución en la calidad de su respuesta con el tiempo, una preocupación de la que se hicieron eco desarrolladores notables y en los foros de OpenAI. Inicialmente descartado por OpenAI, un posterior estudio confirmó el problema. Reveló una caída en la precisión de GPT-4 del 97.6% al 2.4% entre marzo y junio, lo que indica una disminución en la calidad de las respuestas con las actualizaciones posteriores del modelo.

El bombo alrededor IA abierta ChatGPT ha vuelto ahora. Ahora viene con una función de visión. GPT-4V, lo que permite a los usuarios hacer que GPT-4 analice las imágenes proporcionadas por ellos. Esta es la característica más nueva que se ha abierto a los usuarios.

Algunos consideran que agregar análisis de imágenes a grandes modelos de lenguaje (LLM) como GPT-4 es un gran paso adelante en la investigación y el desarrollo de la IA. Este tipo de LLM multimodal abre nuevas posibilidades, llevando los modelos lingüísticos más allá del texto para ofrecer nuevas interfaces y resolver nuevos tipos de tareas, creando nuevas experiencias para los usuarios.

El entrenamiento de GPT-4V finalizó en 2022 y el acceso temprano se implementó en marzo de 2023. La función visual de GPT-4V funciona con tecnología GPT-4. El proceso de formación siguió siendo el mismo. Inicialmente, el modelo fue entrenado para predecir la siguiente palabra en un texto utilizando un conjunto de datos masivo de texto e imágenes de diversas fuentes, incluido Internet.

Posteriormente, se perfeccionó con más datos, empleando un método llamado aprendizaje reforzado a partir de retroalimentación humana (RLHF), para generar resultados que los humanos preferían.

Mecánica de visión GPT-4

Las notables capacidades del lenguaje de visión de GPT-4, aunque impresionantes, tienen métodos subyacentes que permanecen en la superficie.

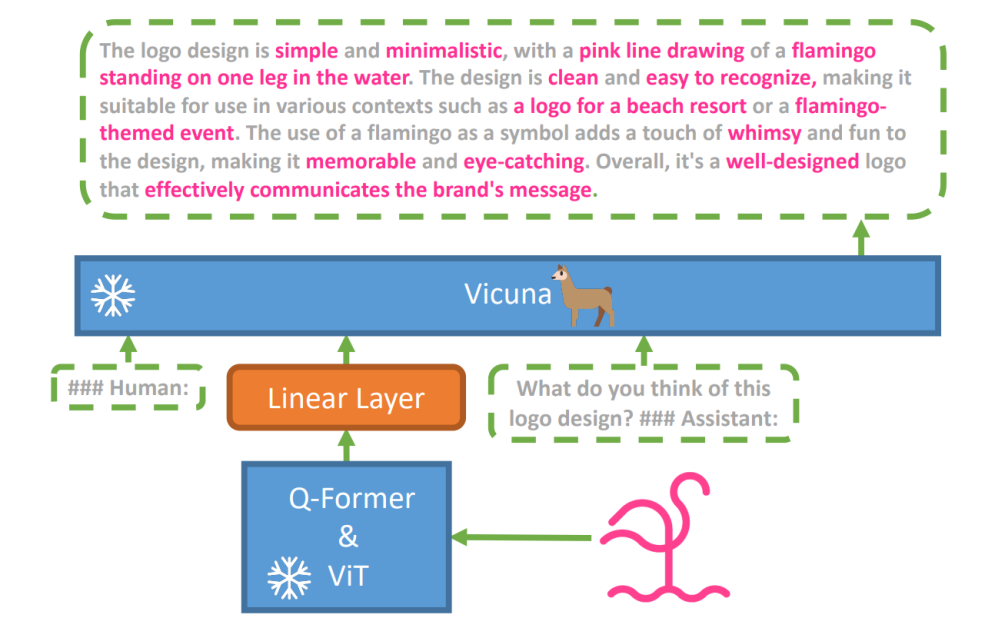

Para explorar esta hipótesis, se utilizó un nuevo modelo de visión-lenguaje, MiniGPT-4 se introdujo, utilizando un LLM avanzado llamado Vicuña. Este modelo utiliza un codificador de visión con componentes previamente entrenados para la percepción visual, alineando características visuales codificadas con el modelo de lenguaje Vicuña a través de una única capa de proyección. La arquitectura de MiniGPT-4 es simple pero efectiva, y se centra en alinear las características visuales y lingüísticas para mejorar las capacidades de conversación visual.

La arquitectura de MiniGPT-4 incluye un codificador de visión con ViT y Q-Former previamente entrenados, una única capa de proyección lineal y un modelo avanzado de lenguaje grande Vicuña.

La tendencia de modelos de lenguaje autorregresivos en tareas de visión-lenguaje también ha crecido, aprovechando la transferencia intermodal para compartir conocimientos entre dominios lingüísticos y multimodales.

MiniGPT-4 une los dominios visual y lingüístico al alinear la información visual de un codificador de visión previamente entrenado con un LLM avanzado. El modelo utiliza Vicuña como decodificador del lenguaje y sigue un enfoque de entrenamiento en dos etapas. Inicialmente, se entrena en un gran conjunto de datos de pares de imagen y texto para captar el conocimiento de la visión y el lenguaje, seguido de un ajuste fino en un conjunto de datos más pequeño y de alta calidad para mejorar la confiabilidad y usabilidad de la generación.

Para mejorar la naturalidad y usabilidad del lenguaje generado en MiniGPT-4, los investigadores desarrollaron un proceso de alineación de dos etapas, abordando la falta de conjuntos de datos de alineación visión-lenguaje adecuados. Seleccionaron un conjunto de datos especializado para este propósito.

Inicialmente, el modelo generó descripciones detalladas de las imágenes de entrada, mejorando el detalle mediante el uso de un mensaje conversacional alineado con el formato del modelo de lenguaje Vicuña. Esta etapa tenía como objetivo generar descripciones de imágenes más completas.

Mensaje de descripción de la imagen inicial:

###Humano: Describe esta imagen en detalle. Da tantos detalles como sea posible. Di todo lo que veas. ###Asistente:

Para el posprocesamiento de datos, cualquier inconsistencia o error en las descripciones generadas se corrigió mediante ChatGPT, seguido de una verificación manual para garantizar una alta calidad.

Mensaje de ajuste fino de la segunda etapa:

###Humano: ###Asistente:

Esta exploración abre una ventana para comprender la mecánica de la IA generativa multimodal como GPT-4, arrojando luz sobre cómo las modalidades de visión y lenguaje se pueden integrar de manera efectiva para generar resultados coherentes y contextualmente ricos.

Explorando la visión GPT-4

Determinar los orígenes de las imágenes con ChatGPT

GPT-4 Vision mejora la capacidad de ChatGPT para analizar imágenes y señalar sus orígenes geográficos. Esta característica hace que las interacciones del usuario pasen de ser solo texto a una combinación de texto y elementos visuales, convirtiéndose en una herramienta útil para quienes tienen curiosidad sobre diferentes lugares a través de datos de imágenes.

Conceptos matemáticos complejos

GPT-4 Vision destaca por profundizar en ideas matemáticas complejas mediante el análisis de expresiones gráficas o escritas a mano. Esta característica actúa como una herramienta útil para personas que buscan resolver problemas matemáticos complejos, lo que convierte a GPT-4 Vision en una ayuda notable en los campos educativo y académico.

Conversión de entradas manuscritas a códigos LaTeX

Una de las capacidades notables de GPT-4V es su capacidad para traducir entradas escritas a mano en códigos LaTeX. Esta característica es de gran ayuda para investigadores, académicos y estudiantes que a menudo necesitan convertir expresiones matemáticas escritas a mano u otra información técnica a un formato digital. La transformación de escrito a mano a LaTeX amplía el horizonte de la digitalización de documentos y simplifica el proceso de redacción técnica.

Extraer detalles de la tabla

GPT-4V demuestra habilidad para extraer detalles de tablas y abordar consultas relacionadas, un activo vital en el análisis de datos. Los usuarios pueden utilizar GPT-4V para examinar tablas, recopilar información clave y resolver preguntas basadas en datos, lo que la convierte en una herramienta sólida para analistas de datos y otros profesionales.

Comprender el señalar visual

La capacidad única de GPT-4V para comprender el señalamiento visual agrega una nueva dimensión a la interacción del usuario. Al comprender las señales visuales, GPT-4V puede responder a consultas con una mayor comprensión contextual.

Creación de sitios web de maquetas simples utilizando un dibujo

Motivado por esto TweetIntenté crear una maqueta para el sitio web unite.ai.

Si bien el resultado no coincidió del todo con mi visión inicial, este es el resultado que logré.

Limitaciones y defectos de GPT-4V (ision)

Para analizar GPT-4V, el equipo de Open AI realizó evaluaciones cualitativas y cuantitativas. Los cualitativos incluyeron pruebas internas y revisiones de expertos externos, mientras que los cuantitativos midieron los rechazos y la precisión del modelo en diversos escenarios, como la identificación de contenido dañino, el reconocimiento demográfico, las preocupaciones sobre la privacidad, la geolocalización, la ciberseguridad y las fugas multimodales.

Aún así el modelo no es perfecto.

El destaca las limitaciones de GPT-4V, como inferencias incorrectas y texto o caracteres faltantes en las imágenes. Puede alucinar o inventar hechos. En particular, no es adecuado para identificar sustancias peligrosas en imágenes, ya que a menudo las identifica erróneamente.

En imágenes médicas, GPT-4V puede proporcionar respuestas inconsistentes y carece de conocimiento de las prácticas estándar, lo que lleva a posibles diagnósticos erróneos.

Rendimiento poco fiable para fines médicos (Fuente)

Tampoco capta los matices de ciertos símbolos de odio y puede generar contenido inapropiado basado en información visual. OpenAI desaconseja el uso de GPT-4V para interpretaciones críticas, especialmente en contextos médicos o sensibles.

Resumen

Creado con Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

La llegada de GPT-4 Vision (GPT-4V) trae consigo un montón de posibilidades interesantes y nuevos obstáculos que superar. Antes de implementarlo, se han realizado muchos esfuerzos para garantizar que los riesgos, especialmente cuando se trata de fotografías de personas, se analicen bien y se reduzcan. Es impresionante ver cómo GPT-4V ha avanzado y se muestra muy prometedor en áreas difíciles como la medicina y la ciencia.

Ahora hay algunas preguntas importantes sobre la mesa. Por ejemplo, ¿deberían estos modelos poder identificar a personajes famosos a partir de fotografías? ¿Deberían adivinar el género, la raza o los sentimientos de una persona a partir de una imagen? ¿Y debería haber ajustes especiales para ayudar a las personas con discapacidad visual? Estas preguntas abren una lata de gusanos sobre la privacidad, la justicia y cómo la IA debería encajar en nuestras vidas, algo en lo que todos deberían opinar.