Líderes del pensamiento

Decodificando oportunidades y desafíos para agentes de LLM en IA generativa

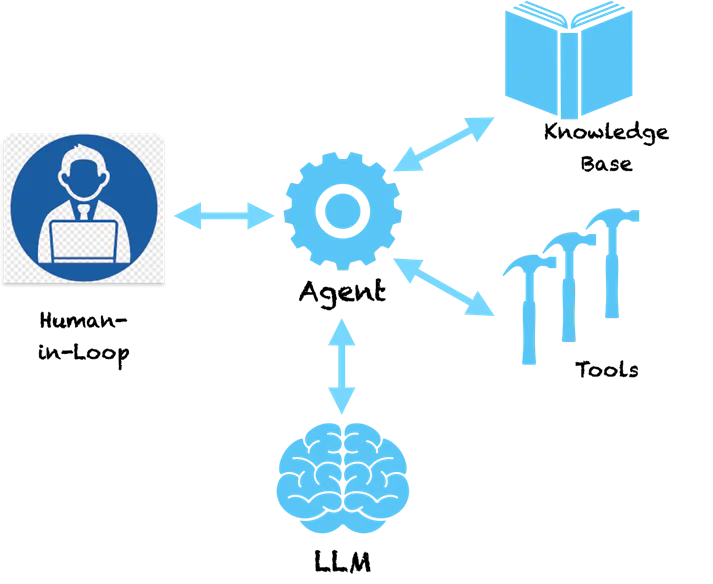

Estamos viendo una progresión de aplicaciones de IA generativa impulsadas por grandes modelos de lenguaje (LLM), desde indicaciones hasta generación aumentada de recuperación (RAG) y agentes. Se habla mucho de los agentes en los círculos industriales y de investigación, principalmente por el poder que proporciona esta tecnología para transformar las aplicaciones empresariales y brindar experiencias superiores a los clientes. Existen patrones comunes para la construcción de agentes que permiten los primeros pasos hacia la inteligencia artificial general (AGI).

En mi anterior artículo, vimos una escalera de inteligencia de patrones para crear aplicaciones impulsadas por LLM. Comenzando con indicaciones que capturan el dominio del problema y utilizan la memoria interna LLM para generar resultados. Con RAG, aumentamos el mensaje con conocimiento externo buscado en una base de datos vectorial para controlar las salidas. Luego, al encadenar llamadas de LLM, podemos crear flujos de trabajo para realizar aplicaciones complejas. Los agentes llevan esto al siguiente nivel al determinar automáticamente cómo se formarán estas cadenas de LLM. Miremos en detalle.

Agentes – Debajo del capó

Un patrón clave con los agentes es que utilizan el poder de comprensión del lenguaje de LLM para hacer un plan sobre cómo resolver un problema determinado. El LLM comprende el problema y nos brinda una secuencia de pasos para resolverlo. Sin embargo, la cosa no se detiene ahí. Los agentes no son un sistema de soporte puro que le brindará recomendaciones sobre cómo resolver el problema y luego le pasará el testigo para que siga los pasos recomendados. Los agentes cuentan con herramientas para seguir adelante y tomar medidas. Asustadizo ¿verdad?

Si le hacemos a un agente una pregunta básica como esta:

Personas: ¿Qué empresa fundó el inventor del teléfono?

A continuación se muestra un ejemplo de los pasos de pensamiento que puede seguir un agente.

Agente (PENSANDO):

- Pensamiento: necesito buscar al inventor del teléfono.

- la columna Acción: Buscar [inventor del teléfono]

- Observación: Alexander Graham Bell

- Pensamiento: Necesito buscar una empresa fundada por Alexander Graham Bell

- la columna Acción: Buscar [empresa fundada por Alexander Graham Bell]

- Observación: Alexander Graham Bell cofundó la American Telephone and Telegraph Company (AT&T) en 1885

- Pensamiento: He encontrado la respuesta. Voy a volver.

Agente (RESPUESTA): Alexander Graham Bell cofundó AT&T en 1885

Puede ver que el agente sigue una forma metódica de dividir el problema en subproblemas que pueden resolverse tomando acciones específicas. Las acciones aquí son recomendadas por el LLM y podemos asignarlas a herramientas específicas para implementar estas acciones. Podríamos habilitar una herramienta de búsqueda para el agente de modo que cuando se dé cuenta de que LLM ha proporcionado la búsqueda como acción, llame a esta herramienta con los parámetros proporcionados por el LLM. La búsqueda aquí se realiza en Internet, pero también se puede redirigir para buscar en una base de conocimientos interna, como una base de datos vectorial. El sistema ahora se vuelve autosuficiente y puede descubrir cómo resolver problemas complejos siguiendo una serie de pasos. Marcos como LangChain y LLaMAIndex le brindan una manera fácil de crear estos agentes y conectarse a herramientas y API. Amazon lanzó recientemente su marco Bedrock Agents que proporciona una interfaz visual para diseñar agentes.

En el fondo, los agentes siguen un estilo especial de envío de indicaciones al LLM que les hace generar un plan de acción. El patrón Pensamiento-Acción-Observación anterior es popular en un tipo de agente llamado ReAct (Razonamiento y Actuación). Otros tipos de agentes incluyen MRKL y Plan & Execute, que difieren principalmente en su estilo de indicaciones.

Para agentes más complejos, las acciones pueden estar vinculadas a herramientas que provocan cambios en los sistemas fuente. Por ejemplo, podríamos conectar al agente a una herramienta que verifique el saldo de vacaciones y solicite licencia en un sistema ERP para un empleado. Ahora podríamos construir un buen chatbot que interactuaría con los usuarios y, mediante un comando de chat, solicitaría permiso para ingresar al sistema. No más pantallas complejas para solicitar permisos, una sencilla interfaz de chat unificada. ¿¡Suena emocionante!?

Advertencias y necesidad de una IA responsable

Ahora, ¿qué pasa si tenemos una herramienta que invoca transacciones en el comercio de acciones utilizando una API previamente autorizada? Usted crea una aplicación donde el agente estudia los cambios de acciones (usando herramientas) y toma decisiones por usted sobre la compra y venta de acciones. ¿Qué pasa si el agente vende las acciones equivocadas porque tuvo alucinaciones y tomó una decisión equivocada? Dado que los LLM son modelos enormes, es difícil determinar por qué toman algunas decisiones, por lo que las alucinaciones son comunes en ausencia de barreras de seguridad adecuadas.

Si bien todos los agentes son fascinantes, probablemente habrías adivinado lo peligrosos que pueden ser. Si alucinan y toman una acción equivocada, eso podría causar enormes pérdidas financieras o problemas importantes en los sistemas empresariales. Por lo tanto, la IA responsable se está volviendo de suma importancia en la era de las aplicaciones impulsadas por LLM. Los principios de la IA responsable en torno a la reproducibilidad, la transparencia y la rendición de cuentas intentan poner barreras a las decisiones tomadas por los agentes y sugieren análisis de riesgos para decidir qué acciones necesitan un ser humano en el circuito. A medida que se diseñan agentes más complejos, se necesita más escrutinio, transparencia y rendición de cuentas para asegurarnos de que sabemos lo que están haciendo.

Pensamientos de cierre

La capacidad de los agentes para generar un camino de pasos lógicos con acciones los acerca mucho al razonamiento humano. Dotarlos de herramientas más poderosas puede otorgarles superpoderes. Patrones como ReAct intentan emular cómo los humanos resuelven el problema y veremos mejores patrones de agentes que serán relevantes para contextos y dominios específicos (banca, seguros, atención médica, industria, etc.). El futuro está aquí y la tecnología detrás de los agentes está lista para que la utilicemos. Al mismo tiempo, debemos prestar mucha atención a las barreras de seguridad de la IA responsable para asegurarnos de que no estamos construyendo Skynet.