Inteligencia Artificial

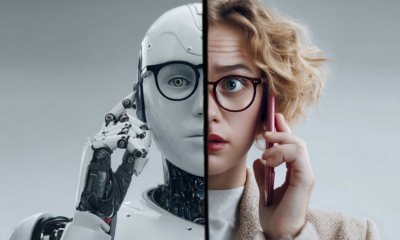

IA engañosa: explotación de modelos generativos en esquemas criminales

Los proyectos piloto de IA generativa, un subconjunto de Inteligencia Artificial, ha ganado rápidamente prominencia debido a su notable capacidad para generar diversas formas de contenido, incluido texto similar a un humano, imágenes realistas y audio, a partir de vastos conjuntos de datos. Modelos como GPT-3, DALL-E y Redes Adversarias Generativas (GAN) han demostrado capacidades excepcionales en este sentido.

A Informe deloitte destaca la naturaleza dual de la IA generativa y destaca la necesidad de estar alerta contra la IA engañosa. Si bien los avances de la IA ayudan en la prevención del delito, también empoderan a los actores malintencionados. A pesar de las aplicaciones legítimas, estas potentes herramientas son cada vez más explotadas por ciberdelincuentes, estafadores y actores afiliados al Estado, lo que genera un aumento de esquemas complejos y engañosos.

El auge de la IA generativa en las actividades delictivas

El auge de la IA generativa ha provocado un aumento de las actividades engañosas que afectan tanto al ciberespacio como a la vida cotidiana. Phishing, una técnica para engañar a las personas para que revelen información confidencial, ahora utiliza IA generativa para hacer que los correos electrónicos de phishing sean muy convincentes. A medida que ChatGPT se vuelve más popular, los correos electrónicos de phishing han aumentado y los delincuentes lo utilizan para crear mensajes personalizados que parecen comunicaciones legítimas.

Estos correos electrónicos, como alertas bancarias falsas u ofertas atractivas, aprovechan la psicología humana para engañar a los destinatarios para que revelen datos confidenciales. A pesar de OpenAI prohíbe el uso ilegal de sus modelos, hacer cumplir esto no es fácil. Las indicaciones inocentes pueden convertirse fácilmente en esquemas maliciosos, que requieren tanto revisores humanos como sistemas automatizados para detectar y prevenir el uso indebido.

De manera similar, el fraude financiero también ha aumentado con los avances en IA. La IA generativa alimenta las estafas, crea contenido que engaña a los inversores y manipula el sentimiento del mercado. Imagínese encontrarse con un chatterbot, aparentemente humano pero diseñado únicamente para engañar. La IA generativa impulsa estos robots, involucrando a los usuarios en conversaciones aparentemente genuinas mientras extraen información confidencial. Los modelos generativos también mejoran ataques de ingeniería social elaborando mensajes personalizados que exploten la confianza, la empatía y la urgencia. Las víctimas son víctimas de solicitudes de dinero, datos confidenciales o credenciales de acceso.

Doxxing, que implica revelar información personal sobre individuos, es otra área en la que la IA generativa ayuda a los delincuentes. Ya sea desenmascarando personas anónimas en línea o exponiendo detalles privados, la IA amplifica el impacto, lo que lleva a consecuencias en el mundo real como el robo de identidad y el acoso.

Y luego estan deepfakes, vídeos, clips de audio o imágenes realistas generados por IA. Estos dobles digitales desdibujan la realidad, planteando riesgos que van desde la manipulación política hasta la difamación.

Incidentes notables de deepfake con impactos críticos

El mal uso de la IA generativa ha dado lugar a una serie de incidentes inusuales, lo que pone de relieve los profundos riesgos y desafíos que plantea esta tecnología cuando cae en las manos equivocadas. La tecnología deepfake, en particular, desdibuja la línea entre realidad y ficción. Como resultado de una unión de GAN y malevolencia creativa, los deepfakes combinan elementos reales e inventados. Las GAN constan de dos redes neuronales: el generador y discriminador. El generador crea contenidos cada vez más realistas, como rostros, mientras que el discriminador intenta detectar las falsificaciones.

Ya han ocurrido incidentes notables relacionados con deepfakes. Por ejemplo, estos utilizó un modelo de IA para crear un clon de voz convincente de Joe Rogan, demostrando la capacidad de la IA para producir voces falsas realistas. Los deepfakes también han tenido un impacto significativo en la política, como se ve en varios ejemplos. Por ejemplo, un robocall hacerse pasar por el presidente estadounidense Joe Biden engañó a los votantes de New Hampshire, mientras Grabaciones de audio generadas por IA en Eslovaquia Se hizo pasar por un candidato liberal para influir en los resultados de las elecciones. Se han reportado varios incidentes similares que impactaron la política de muchos países.

Las estafas financieras también han utilizado deepfakes. A Ingenieria británica La empresa Arup fue víctima de una estafa deepfake de 20 millones de libras. Un empleado del sector financiero fue engañado para que transfiriera fondos durante una videollamada con estafadores que usaron voces e imágenes generadas por IA para hacerse pasar por ejecutivos de la empresa. Esto pone de manifiesto el potencial de la IA para el fraude financiero.

Los ciberdelincuentes han explotado cada vez más las herramientas de IA generativa como WormGPT y FraudeGPT para mejorar sus ataques, creando una importante amenaza a la ciberseguridad. WormGPT, basado en el modelo GPT-J, facilita actividades maliciosas sin restricciones éticas. Los investigadores de SlashNext lo utilizaron para elaborar un correo electrónico de factura fraudulenta muy persuasivo. FraudGPT, que circula en los canales de Telegram, está diseñado para ataques complejos y puede generar código malicioso, crear páginas de phishing convincentes e identificar vulnerabilidades del sistema. El auge de estas herramientas pone de relieve la creciente sofisticación de las ciberamenazas y la urgente necesidad de mejorar las medidas de seguridad.

Implicaciones legales y éticas

Las implicaciones legales y éticas del engaño impulsado por la IA presentan una tarea formidable en medio de rápidos avances en los modelos generativos. Actualmente, la IA opera dentro de una zona regulatoria gris, y los responsables políticos necesitan ayuda para seguir el ritmo de los avances tecnológicos. Se necesitan urgentemente marcos sólidos para limitar el uso indebido y proteger al público de estafas y actividades fraudulentas impulsadas por la IA.

Además, los creadores de IA tienen una responsabilidad ética. La transparencia, la divulgación y el cumplimiento de las directrices son aspectos esenciales del desarrollo responsable de la IA. Los desarrolladores deben anticipar posibles usos indebidos e idear medidas para que sus modelos de IA mitiguen los riesgos de forma eficaz.

Mantener un equilibrio entre innovación y seguridad es importante para abordar los desafíos que plantea el fraude impulsado por la IA. La regulación excesiva puede frenar el progreso, mientras que una supervisión relajada invita al caos. Por lo tanto, las regulaciones que promuevan la innovación sin comprometer la seguridad son imperativas para el desarrollo sostenible.

Además, los modelos de IA deben diseñarse teniendo en cuenta la seguridad y la ética. La incorporación de funciones como la detección de sesgos, las pruebas de solidez y la capacitación adversaria puede mejorar la resiliencia contra la explotación maliciosa. Esto es particularmente importante dada la creciente sofisticación de las estafas impulsadas por la IA, lo que enfatiza la necesidad de previsión ética y agilidad regulatoria para protegerse contra el potencial engañoso de los modelos generativos de IA.

Estrategias de mitigación

Las estrategias de mitigación para abordar el uso engañoso de modelos generativos impulsados por IA requieren un enfoque multifacético que implique mejores medidas de seguridad y colaboración entre las partes interesadas. Las organizaciones deben emplear revisores humanos para evaluar el contenido generado por IA, utilizando su experiencia para identificar patrones de uso indebido y perfeccionar modelos. Los sistemas automatizados equipados con algoritmos avanzados pueden buscar señales de alerta asociadas con estafas, actividades maliciosas o información errónea, sirviendo como sistemas de alerta temprana contra acciones fraudulentas.

Además, la colaboración entre las empresas de tecnología, los organismos encargados de hacer cumplir la ley y los formuladores de políticas es vital para detectar y prevenir los engaños impulsados por la IA. Los gigantes tecnológicos deben compartir conocimientos, mejores prácticas e inteligencia sobre amenazas, mientras que los organismos encargados de hacer cumplir la ley trabajan en estrecha colaboración con expertos en inteligencia artificial para adelantarse a los delincuentes. Los formuladores de políticas deben colaborar con las empresas de tecnología, los investigadores y la sociedad civil para crear regulaciones efectivas, enfatizando la importancia de la cooperación internacional para combatir los engaños impulsados por la IA.

De cara al futuro, el futuro de la IA generativa y la prevención del delito se caracteriza tanto por desafíos como por oportunidades. A medida que la IA generativa evolucione, también lo harán las tácticas criminales, con avances en IA cuántica, informática de punta y modelos descentralizados que dan forma al campo. Por lo tanto, la educación sobre el desarrollo ético de la IA se está volviendo cada vez más fundamental, y se insta a las escuelas y universidades a que hagan obligatorios los cursos de ética para los profesionales de la IA.

Lo más importante es...

La IA generativa presenta inmensos beneficios y riesgos significativos, lo que destaca la necesidad urgente de marcos regulatorios sólidos y un desarrollo ético de la IA. A medida que los ciberdelincuentes explotan herramientas avanzadas, son esenciales estrategias de mitigación eficaces, como la supervisión humana, los algoritmos de detección avanzados y la cooperación internacional.

Al equilibrar la innovación con la seguridad, promover la transparencia y diseñar modelos de IA con salvaguardias integradas, podemos combatir eficazmente la creciente amenaza del engaño impulsado por la IA y garantizar un entorno tecnológico más seguro para el futuro.