Inteligencia Artificial

Mejor rendimiento de aprendizaje automático a través del cambio de tamaño de imagen basado en CNN

Google Research ha propuesto un nuevo método para mejorar la eficiencia y precisión de los flujos de trabajo de entrenamiento de visión por computadora basados en imágenes mejorando la forma en que las imágenes de un conjunto de datos se reducen en la etapa de preprocesamiento.

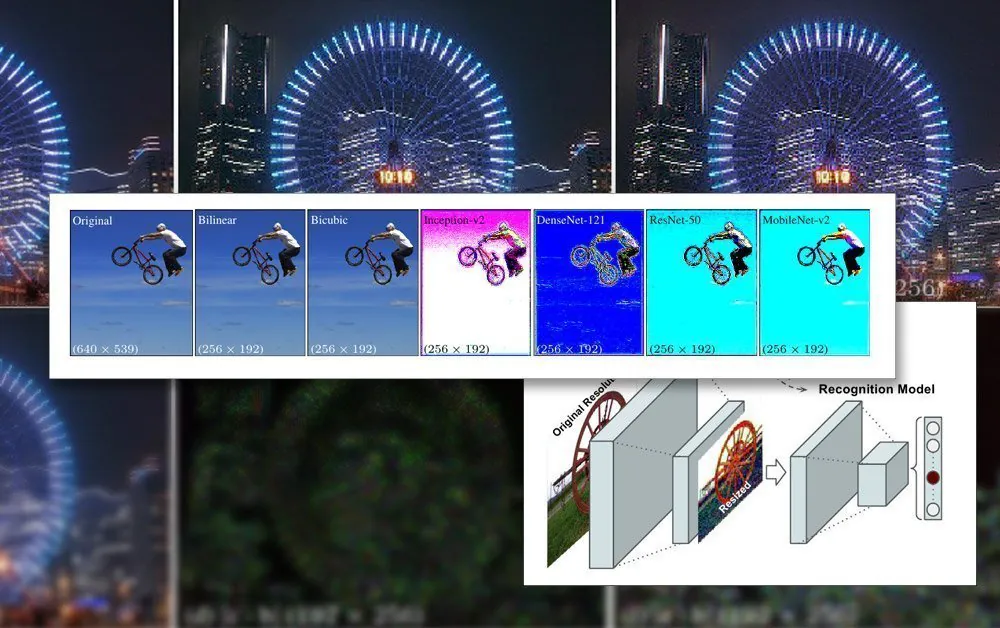

En el Aprendiendo a cambiar el tamaño de las imágenes para tareas de visión artificial, los investigadores Hossein Talebi y Peyman Milanfar utilizan una CNN para crear una nueva arquitectura de cambio de tamaño de imagen híbrida que produce una mejora notable en los resultados de reconocimiento obtenidos en cuatro conjuntos de datos de visión artificial populares.

La propuesta de marco conjunto para el reconocimiento y redimensionamiento. Fuente: https://arxiv.org/pdf/2103.09950.pdf

El documento observa que los métodos de cambio de escala/cambio de tamaño que se utilizan actualmente en los procesos automatizados de aprendizaje automático están desactualizados desde hace décadas y con frecuencia utilizan solo bilineal, bicúbico y vecino más cercano. cambio de tamaño – métodos que tratan todos los píxeles indiscriminadamente.

Por el contrario, el método propuesto aumenta los datos de la imagen a través de una CNN e incorpora esa entrada en las imágenes redimensionadas que finalmente pasarán por la arquitectura del modelo.

Restricciones de imagen en el entrenamiento de IA

Para entrenar un modelo que trate con imágenes, un marco de aprendizaje automático incluirá una etapa de preprocesamiento, donde una variedad dispar de imágenes de varios tamaños, espacios de color y resoluciones (que contribuirán al conjunto de datos de entrenamiento) se recortan y redimensionado en dimensiones consistentes y un formato único y estable.

En general, esto supondrá cierto compromiso basado en el formato PNG, en el que se establecerá un equilibrio entre el tiempo de procesamiento/recursos, el tamaño del archivo y la calidad de la imagen.

En la mayoría de los casos, las dimensiones finales de la imagen procesada son muy pequeñas. A continuación vemos un ejemplo de la imagen con resolución de 80 × 80 en la que se muestran algunos de los primeros conjuntos de datos de deepfakes. fueron generados:

Dado que las caras (y otros sujetos posibles) rara vez encajan en la proporción cuadrada requerida, es posible que sea necesario agregar barras negras (o permitir el desperdicio de espacio) para homogeneizar las imágenes, reduciendo aún más los datos de imagen utilizables reales:

Aquí, la cara se ha extraído de un área de imagen más grande hasta que se recorta de la forma más económica posible para incluir toda el área de la cara. Sin embargo, como se ve a la derecha, una gran parte del área restante no se utilizará durante el entrenamiento, lo que agrega mayor peso a la importancia de la calidad de imagen de los datos redimensionados.

Dado que las capacidades de GPU han mejorado en los últimos años, con la nueva generación de tarjetas NVIDIA equipadas con cantidades crecientes de video-RAM (VRAM), el tamaño promedio de las imágenes que contribuyen está comenzando a aumentar, aunque 224 × 224 píxeles sigue siendo bastante estándar (por ejemplo, es el tamaño de la ResNet-50 conjunto de datos).

Una imagen sin cambiar de tamaño de 224 × 244 píxeles.

Colocación de lotes en VRAM

La razón por la que todas las imágenes deben tener el mismo tamaño es que descenso de gradiente, el método por el cual el modelo mejora con el tiempo, requiere datos de entrenamiento uniformes.

La razón por la que las imágenes tienen que ser tan pequeñas es que deben cargarse (totalmente descomprimidas) en VRAM durante el entrenamiento en lotes pequeños, generalmente entre 6 y 24 imágenes por lote. Muy pocas imágenes por lote, y no hay suficiente material grupal para generalizar bien, además de extender el tiempo de entrenamiento; demasiados, y el modelo puede no obtener las características y detalles necesarios (ver más abajo).

Esta sección de 'carga en vivo' de la arquitectura de entrenamiento se llama espacio latente. Aquí es donde las características se extraen repetidamente de los mismos datos (es decir, las mismas imágenes) hasta que el modelo ha convergido a un estado en el que tiene todo el conocimiento generalizado que necesita para realizar transformaciones en datos posteriores no vistos de un tipo similar.

Este proceso generalmente toma días, aunque puede tomar incluso un mes o más de reflexión constante e inflexible de alto volumen las 24 horas del día, los 7 días de la semana para lograr una generalización útil. Los aumentos en el tamaño de VRAM solo son útiles hasta cierto punto, ya que incluso los incrementos menores en la resolución de la imagen pueden tener un efecto de orden de magnitud en la capacidad de procesamiento y efectos relacionados en la precisión que pueden no ser siempre favorables.

Usar una mayor capacidad de VRAM para acomodar lotes más grandes también es una bendición, ya que las mayores velocidades de entrenamiento obtenidas por esto son probable que sea compensado por resultados menos precisos.

Por lo tanto, dado que la arquitectura de capacitación está tan restringida, cualquier cosa que pueda lograr una mejora dentro de las limitaciones existentes de la canalización es un logro notable.

Cómo ayuda la reducción de personal superior

Se ha demostrado que la calidad final de una imagen que se incluirá en un conjunto de datos de entrenamiento tiene un efecto de mejora en el resultado del entrenamiento, particularmente en tareas de reconocimiento de objetos. En 2018 investigadores del Instituto Max Planck de Sistemas Inteligentes contendió que la elección del método de remuestreo impacta notablemente en el rendimiento y los resultados del entrenamiento.

Además, un trabajo previo de Google (coescrito por los autores del nuevo artículo) ha descubierto que la precisión de la clasificación se puede mejorar manteniendo el control sobre artefactos de compresión en imágenes de conjuntos de datos.

El modelo CNN integrado en el nuevo remuestreador combina el cambio de tamaño bilineal con una función de "omitir conexión" que puede incorporar la salida de la red entrenada en la imagen redimensionada.

A diferencia de una arquitectura típica de codificador/decodificador, la nueva propuesta puede actuar no solo como un cuello de botella de avance, sino también como un cuello de botella inverso para el escalado a cualquier tamaño de destino o relación de aspecto. Además, el método de remuestreo estándar puede sustituirse por cualquier otro método tradicional adecuado, como Lanczos.

Detalles de alta frecuencia

El nuevo método produce imágenes que, en efecto, parecen integrar características clave (que finalmente serán reconocidas por el proceso de entrenamiento) directamente en la imagen original. En términos estéticos, los resultados son poco convencionales:

El nuevo método se aplicó en cuatro redes: Inception V2; DenseNet-121; ResNet-50; y MobileNet-V2. Los resultados del método de reducción de resolución/redimensionamiento de imágenes de Google Research producen imágenes con una agregación de píxeles obvia, anticipando las características clave que se identificarán durante el proceso de capacitación.

Los investigadores señalan que estos experimentos iniciales están optimizados exclusivamente para tareas de reconocimiento de imágenes, y que en las pruebas, su «resizer aprendido» basado en CNN logró mejorar las tasas de error en dichas tareas. En el futuro, los investigadores pretenden aplicar el método a otras aplicaciones de visión artificial basadas en imágenes.